今天的資安日報新聞幾乎都與AI有關,這些包含了鎖定人工智慧專家的攻擊行動,針對人工智慧開發工具的漏洞揭露,以及相關資安框架的發表。

其中最值得留意的部分,是關於人工智慧開發工具的漏洞公布,其中用於開發相關系統的Python套件llama_cpp_python漏洞CVE-2024-34359相當值得留意,因為有可能引發供應鏈攻擊。資安業者Checkmarx指出,在AI技術與資料共享平臺Hugging Face有超過6千個模型以此套件打造而曝險。

【攻擊與威脅】

半導體業者逸昌遭駭客網路攻擊,部分資訊系統受影響,仍在復原中

5月17日傍晚17時23分,上櫃半導體業者逸昌科技發布資安事件重大訊息,說明公司內有部分資訊系統遭受駭客攻擊。

該公司表示,他們發現網路傳輸異常,以及部分伺服器遭受駭客攻擊的情況,公司的資安單位已立即啟動防禦復原機制,並與外部資安公司技術專家合作處理。

值得留意的是,他們表示目前資訊系統陸續恢復中,意味著公告當下的周五傍晚,這些受影響的資訊系統尚未完全復原。目前我們也正詢問該公司後續復原的狀況。

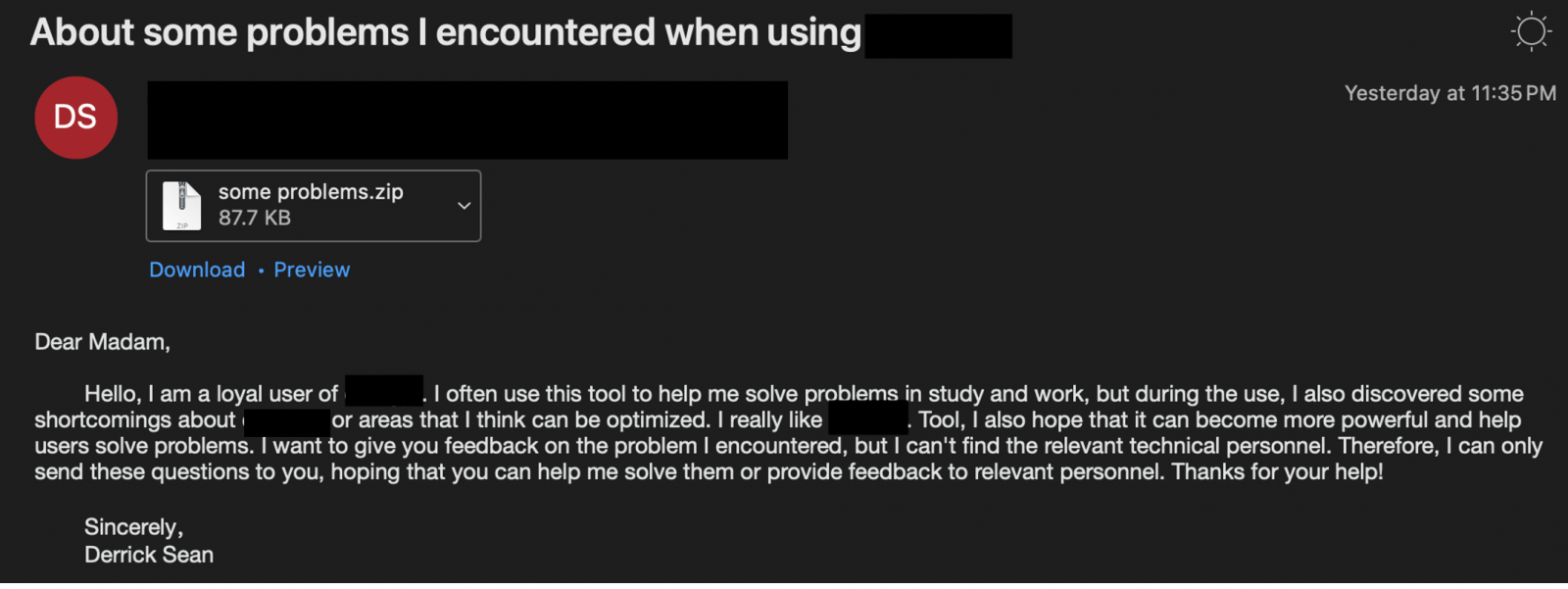

美國人工智慧專家遭到鎖定,攻擊者對其散布惡意程式SugarGh0st RAT

資安業者Proofpoint揭露鎖定美國人工智慧專家而來的攻擊行動UNK_SweetSpecter,對方於今年5月,針對當地參與人工智慧工作的學術機構、政府服務、企業組織而來,意圖對其散布SugarGh0st RAT。

資安業者Proofpoint揭露鎖定美國人工智慧專家而來的攻擊行動UNK_SweetSpecter,對方於今年5月,針對當地參與人工智慧工作的學術機構、政府服務、企業組織而來,意圖對其散布SugarGh0st RAT。

值得留意的是,研究人員指出,這起攻擊行動極具針對性,駭客的目標不到10人,且皆與一家具領先地位的美國人工智慧組織有直接關係。

由於5月初傳出美國政府有意限制中國存取生成式AI服務,若是中國企業組織使用相關技術受限,很有可能尋求駭客來取得相關資訊,進一步達成中國發展的目標。從這樣的情勢來看,發動攻擊的駭客,很有可能與中國之間有所關連。

其他攻擊與威脅

◆醫療保健計畫暨保險管理服務業者WebTPA資料外洩,逾240萬人受到影響

◆勒索軟體駭客透過惡意廣告聲稱提供PuTTY、WinSCP,意圖對企業組織的網路管理員下手

◆遭跨國執法單位圍勦的金融木馬Grandoreiro傳出東山再起,駭客鎖定超過60個國家、1,500家銀行客戶發動攻擊

◆韓國Linux主機遭到北韓駭客kimsuky鎖定,被植入後門程式Gomir

【漏洞與修補】

用於人工智慧系統的Python開發套件存在重大漏洞,恐導致系統資料外流

資安研究人員Patrick Peng揭露名為Llama Drama的漏洞,該漏洞存在於Python套件llama_cpp_python,攻擊者可藉此濫用其搭載的範本引擎Jinja2執行任意程式碼,CVSS風險評分達到9.7,開發者接獲通報發布0.2.72版llama_cpp_python予以修補,此漏洞被登記為CVE-2024-34359列管。值得留意的是,由於此套件的功能,主要是讓開發者能在Python環境整合AI模型,因此很有可能導致供應鏈攻擊。

針對這項漏洞,資安業者Checkmarx藉由部落格文章,進一步說明可能帶來的影響範圍。他們指出漏洞的核心問題在於,此套件在處理範本資料的過程中,並未使用沙箱或是其他適當的防護措施。研究人員指出,雖然Jinja2支援在沙箱中運作,但套件開發者並未導入這類機制而曝險。

值得留意的是,他們在AI技術與資料共享平臺Hugging Face上,發現超過6千個模型採用帶有範本的gguf格式,而有可能曝露於上述漏洞的風險。

Intel發布5月例新更新,修補人工智慧模型壓縮工具重大漏洞

上週二(5月14日)Intel發布5月份例行更新,總共公告41項漏洞,但特別的是,有別於過往公告主要都與處理器有關,這次最為危險的漏洞,存在於人工智慧模型壓縮工具Neural Compressor,被登記為CVE-2024-22476列管,該公司發布2.5.0版進行修補。

根據該公司的資安公告,這項漏洞與輸入驗證不當有關,未經身分驗證的攻擊者有可能遠端利用漏洞,進而提升權限,CVSS風險評分為10。

值得留意的是,這項漏洞可被遠端利用,且操作複雜度並不高,並對於資料的機密性、完整性、可用性有很大的影響。此外,攻擊者也不需要特殊權限,利用漏洞的過程,同樣無需使用者互動就能進行。

【資安產業動態】

響應政府推動零信任架構,多家廠商於臺灣資安大會展示信任推斷技術

這幾年來,零信任成為當紅的資安概念,政府在2022年開始積極推動以「身分鑑別」、「設備鑑別」,以及「信任推斷」這3大核心機制組成的零信任架構。其中,今年的重點,聚焦在信任推斷的部分,因此相關的解決方案備受關注。

在2024臺灣資安大會期間,我們看到具備這類功能的解決方案出現,曜祥網技(e-Soft)、奧義智慧、中華電信這3家資安公司,皆在會場上介紹具備相關功能的資安解決方案。未來將會有更多資安業者投入、提供這類零信任防護機制。

DeepMind發表AI安全框架Frontier Safety Framework

5月17日Alphabet 旗下的AI技術研究公司DeepMind發表AI安全框架Frontier Safety Framework,同時闡述該公司分析與減輕AI模型招致未來風險的方法。

此框架可用來主動識別未來可能造成嚴重傷害的AI能力,也可建立檢測及緩解相關傷害的機制。此框架著重於模型層面的強大能力可能導致的重大風險,像是特殊代理或複雜網路能力,將補充現有的對齊(Alignment)研究,以及Google既有的AI責任及安全實踐套件。

近期資安日報

【5月17日】研究人員公布GE超音波醫療設備一系列漏洞,並用來植入勒索軟體進行驗證

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-02

2026-03-05