高達80%的開發人員承認,為了使用人工智慧程式開發輔助工具而繞過組織安全政策。

人工智慧程式開發輔助工具已經大量參與開發人員的日常工作,Jetbrains的2023開發者大調查佐證了這個現況,77%受訪者都使用ChatGPT,GitHub Copilot也有46%的開發者使用。雖然人工智慧程式開發輔助工具可以幫助開發人員更有效率地編寫程式碼,不過,也對組織帶來了一些安全挑戰。

資安公司Snyk對537名軟體工程和安全團隊成員進行調查,並在其2023年人工智慧程式碼安全報告中指出,企業過於忽視人工智慧程式開發輔助工具所帶來的安全問題。

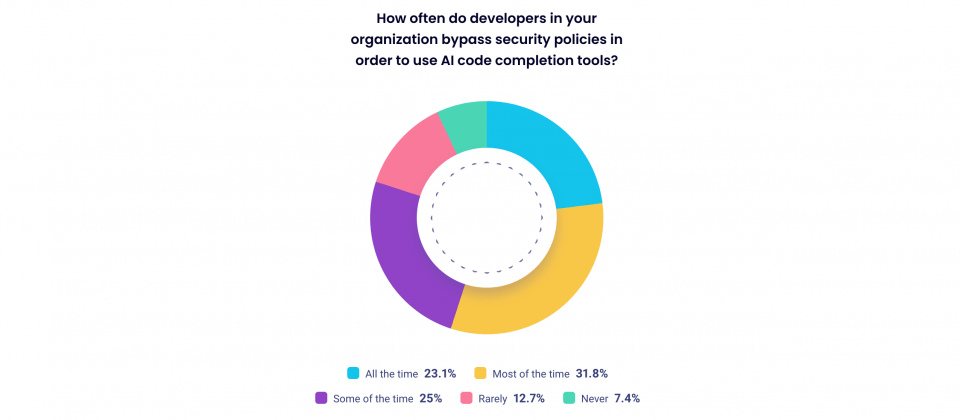

96%的受訪者團隊已使用人工智慧程式開發輔助工具,但有56.4%的受訪者表示經常從人工智慧程式碼建議中發現安全問題,也有高達80%的開發人員承認,為了使用人工智慧程式開發輔助工具而繞過組織安全政策。即便開發人員已大量應用人工智慧編寫程式碼,但是Snyk表示,少有團隊相對應調整安全流程,只有不到10%的組織,對大部分程式碼執行自動化安全掃描。

人工智慧程式開發輔助工具所產生的安全問題不只存在於組織內,也正影響著開源工具鏈的安全,73.2%的受訪者曾對開源專案貢獻程式碼,代表即便他們皆具備開源專案的知識,也理解人工智慧可能提供不安全的程式碼,但是只有24.6%的組織,使用軟體組成分析(Software composition analysis,SCA)工具驗證人工智慧的程式碼建議。Snyk解釋,更快的開發速度可能使得組織更容易接受不安全的開源元件,而人工智慧工具使用開源程式碼作為訓練資料集,可能因此學習不安全的程式碼寫法,導致惡性循環產生更多不安全的建議。

高達55.1%的受訪者都表示組織已經將人工智慧工具,視為軟體供應鏈的一部分,不過,Snyk認為大多數組織並未對這種情況採取足夠應對,最常採取的行動是增加安全掃描,但實行的組織也只有18.4%。針對這樣的現象,Snyk猜測,可能來自於人們錯誤認為人工智慧生成的程式碼建議,比人類編寫的程式碼更安全。有75%的受訪者認為人工智慧生成的程式碼較人類安全。

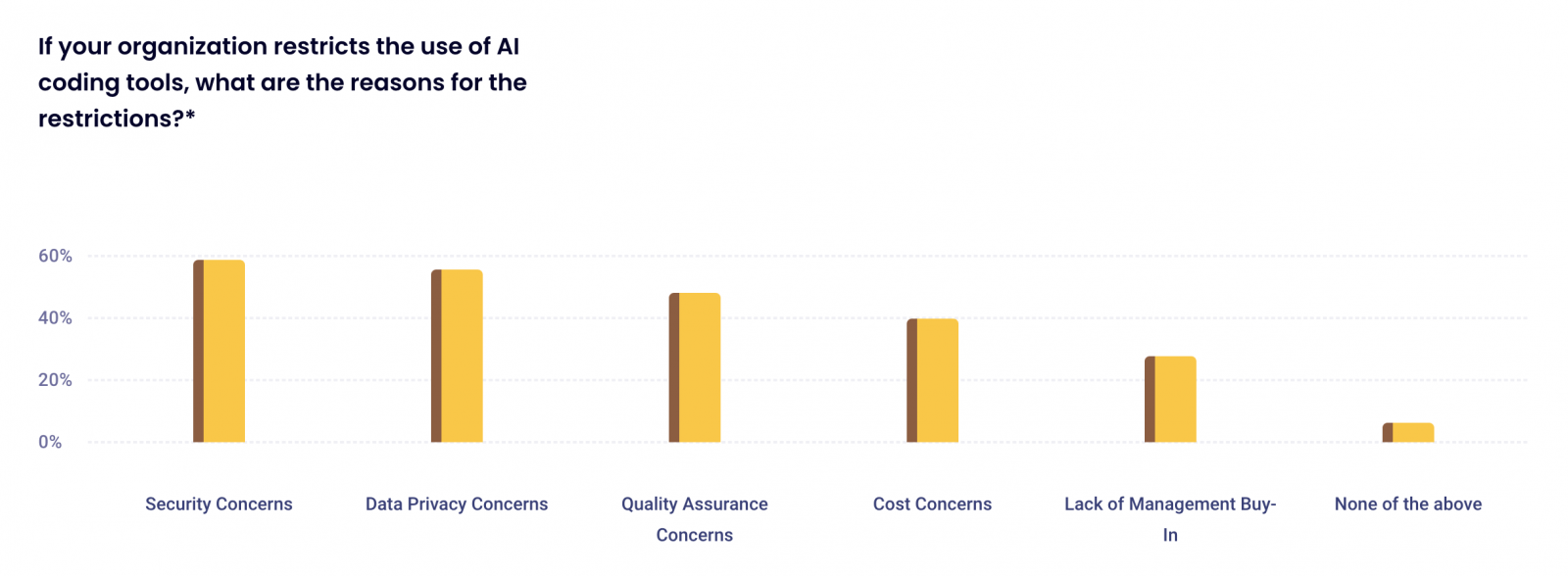

有趣的是,大多數受訪者不信任人工智慧,有86%的受訪者對人工智慧程式開發輔助工具的安全性存在顧慮,Snyk提到,之所以有這種認知失調的狀況出現,可能來自於從眾心理,開發人員說服自己其他人也在使用人工智慧工具,則這些工具勢必值得信任。小部分的組織限制人工智慧程式開發輔助工具的使用,主要原因包括57%擔憂程式碼的安全性,其次有53.8%的組織顧慮資料隱私,還有46.4%的組織在意程式品質(下圖)。

開發人員因為人工智慧程式開發輔助工具的協助,使得生產力增加,因而加快了程式碼編寫速度,而這也對應用程式安全團隊帶來更多的壓力,有五分之一的團隊在跟上軟體開發的腳步存在挑戰。

雖然已有研究顯示人工智慧生成的程式碼建議並沒有比較安全,Snyk提到,但人們現在普遍相信人工智慧程式開發輔助工具出錯機率比人類更低,因此組織應該透過教育糾正這樣的錯誤觀念,並且採用安全工具保護人工智慧所生成的程式碼。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02