Gemini可以一邊解讀影片中,展示人員用手即時畫圖每一個動作的意義,如這是隻鴨子,現在在水上游泳,有藍色外觀。當展示人員拿出實體玩具鴨子按壓發生聲音時,AI甚至打趣的說,真的拿出了呱呱叫的鴨子,AI還能糾正展示人員對於「鴨子」中文發音的重音位置錯誤。

Google正式推出了原生多模態的大型語言模型Gemini,可以同時支援文字、圖片和聲音的輸入。在32項AI測試中,有30項的評分超越了OpenAI的GPT-4V。Google執行長Sundar Pichai強調,Gemini是Google有史以來最強大也是最通用的模型。Gemini預計推出三種版本,包括了模型最大的Ultra版、通用性最廣的Pro版,以及可以在手機裝置上運作的Nano版。

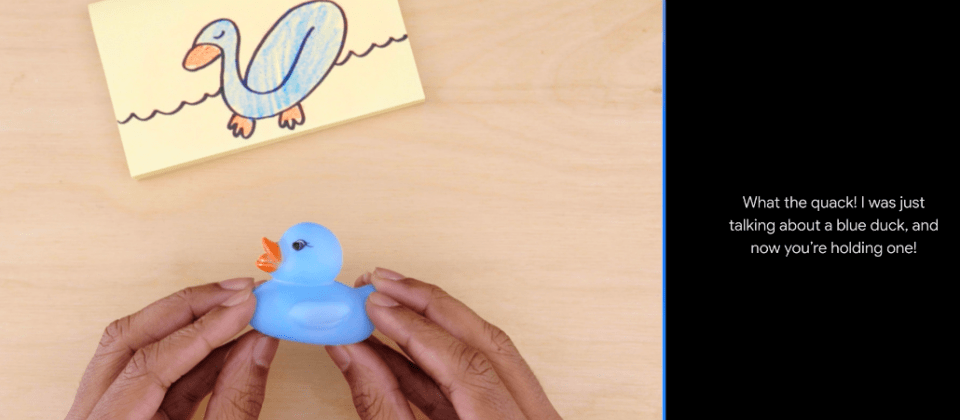

Google展示了一段讓人驚訝的實測影片,來呈現Gemini多模態的回答能力,讓Gemini一邊看著(輸入)影片來解讀影片中畫面的內容。例如Gemini可以一邊解讀影片中,展示人員用手即時畫圖過程,每一個動作所對應的意義,這是隻鴨子,現在在水上游泳,有藍色外觀。當展示人員拿出實體玩具鴨子按壓發生聲音時,AI甚至打趣的說,真的拿出了呱呱叫的鴨子,AI還能糾正展示人員對於「鴨子」中文發音的重音位置錯誤。 AI能分辨人手勢代表的意義,也能分辨不同物體的異同,例如都是食物,或都是圓體。看影片還能推理出哪個杯子藏了硬幣,彷彿就像人邊看影片邊解說的行為。

Gemini可以同時分辨和理解文字、圖片和聲音,也可以用來分辨和解釋幾種熱門開發語言,包括Python、Java、C++和Go語言,可以理解跨開發語言來推論複雜訊息。Google也用了Gemini打造了新版的程式碼生成系統AlphaCode 2,比2年前的第一代改進很多,可以解決兩倍的問題。

Gemini使用了Google自行開發的晶片TPU訓練而成,而且使中了v4和v5e版TPU。Google同時宣布了新版TPU v5p,可用來加速Gemini模型的開發,供企業用來客製化訓練自己的LLM模型。TPU v5p單一叢集可支援到8,960顆TPU,和TPU v4相比,能夠提供2倍FLOPS的算力,記憶體頻寬也提高了3倍。

Google目前先在Bard中使用一個微調過的Gemini Pro版本,可提供推理和計畫的回答能力。目前先釋出英語版,可再全球170個國家和地區使用,預計近期會支援更多語言。

Gemini另一個新特色是推出了一款可以在手機上執行的Nano版Gemini模型,Google表示,甚至不需要連上網路,單靠手機上的TPU晶片也能運作,目前先支援Pixel系列手機,Pixel 8 Pro手機會是第一款。不需要連上網路,也能在手機上用Gemini來整理會議錄音檔的開會摘要內容。Nano版Gemini另外也會先用來強化Gboard的自動語音回覆輸入能力,將率先支援WhatsApp的輸入,明年計畫支援更多App。

Google透露,目前Gemini Nano只能支援TPU晶片,未來希望能進一步跨大支援到其他手機上的AI晶片,來擴大可支援的手機類型,但Google沒有透露時間表。

Bard從今天(12/6)已經開始使用Gemini Pro來提供回答,而Google預計從12月13日開始,在GCP Vertex AI或Google AI Studio上,開放企業透過APi存取Gemini Pro模型。

Google目前正在進行Ultra版的信任和安全測試,包括採取外部紅隊演練,與使用RLHF進行模型優化。目前將挑選特定企業用戶或開發者進行Ultra版試用,預計明年初可以正式推出Ultra版,也會同步推出採用Ultra版的Bard進階版。不過,Google沒有透露Ultra版更明確的釋出時間。

雖然Nano版可以離線在手機上執行,目前,企業只能透過API存取雲端Gemini模型來使用,Google沒有透露,是否未來會提供落地在企業內部部署執行的Gemini版本。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02