Meta

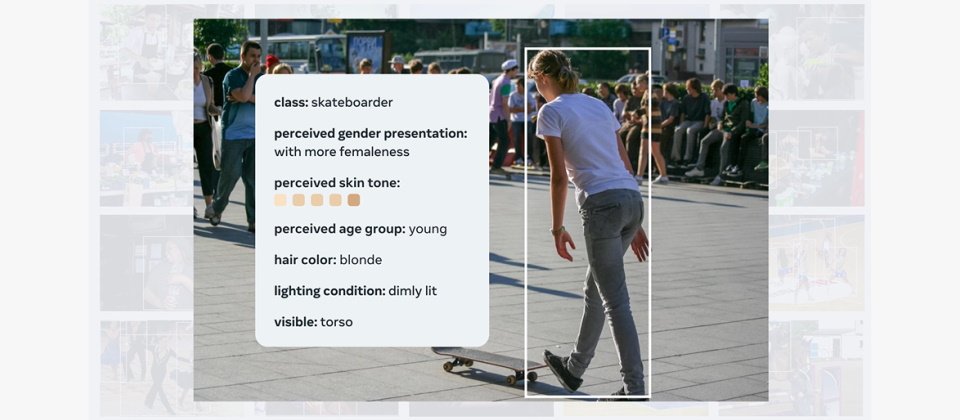

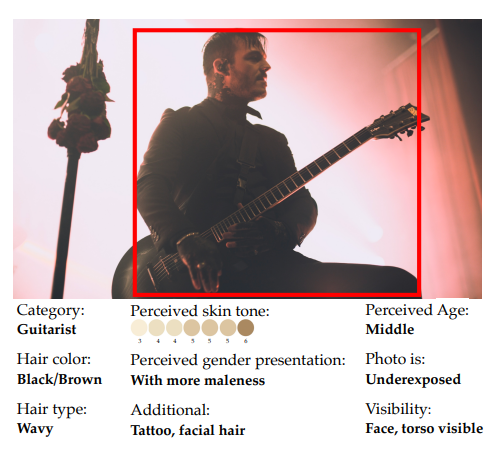

Meta於本周開源了FACET(FAirness in Computer Vision EvaluaTion)資料集,以供不同的電腦視覺模型來評估它們在分類、偵測、實例分割與視覺定位等任務中,可能出現的偏差或歧視,以協助模型進行改善。

FACET是由3.2萬張照片所組成,內含5萬個人,每一張照片都由人類專家依照與人類相關的屬性手動進行標記,由專門的人類註譯員負責標記人口屬性,包括性別與年齡等族群特徵,膚色及髮型等生理特徵,以及諸如棒球選手或醫生等分類,也包含了來自SA-1B資料集中6.9萬名戴口罩民眾的人口屬性標記。

圖片來源_Meta

此一資料集可用來協助回答某些問題,像是當某些表現的刻板印象多為男性屬性時,AI模型是否能提供更好的辨別;開放辭彙檢測模型能否夠更好地偵測到那些被認為應該更年輕一些的背包客;標準檢測模型是否難以偵測或分割膚色較深的人口;以及倘若上述牽涉到的是一名捲髮人口,各種問題是否會被放大。

Meta以FACET來評測該公司所開發的DINOv2模型與SEERv2模型,以及OpenAI的OpenCLIP模型,整體而言,OpenCLIP在性別上的表現優於其它模型,而DINOv2則在年齡與膚色上有較佳的判斷力。

Meta AI團隊指出,FACET得以更深入地發現模型於類別等級上的潛在偏差,舉例來說,以性別偏見最嚴重的「護士」類別來說,SEERv2與OpenCLIP的偏差比DINOv2更為明顯,原因可能是SEERv2主要針對未經策畫的社交媒體內容進行預訓練,使得資料缺乏多樣性,而OpenCLIP則採用經過CLIP模型過濾的網頁爬梳資料,而放大了原本即存在的職業與性別的關聯性。

FACET的開源將有助於研究人員執行類似的標竿測試,以理解自己的模型中所存在的偏差,亦可用來監控為了解決公平問題而採取的緩解措施所造成的影響。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-05

2026-03-02