近期Center for AI Safety(CAIS)發表了一份聲明,要科技產業重視AI可能帶來的人類滅絕風險,獲得OpenAI執行長Sam Altman(上圖)等重量級人物聲援,但Altman並未聯名支持另一個非營利組織Future of Life Institute基於相同出發點,要求科技公司暫停訓練比GPT-4更強大的AI系統的連署行動。(圖片來源/TechCrunch, CC BY 2.0, via Wikimedia Commons)

專門研究人工智慧(AI)安全性的非營利組織Center for AI Safety(CAIS),在本周發表了一份由眾多AI專家所簽署的聲明,代表AI社群同意「減輕AI可能帶來的人類滅絕(extinction)風險應是全球的首要之務」,因為AI堪比諸如流行疾病與核子戰爭等其它社會規模的風險。

簽署該聲明的都是現階段AI領域的重量級人物,例如來自OpenAI的十多名高階主管,包括創辦人Ilya Sutskever與John Schulman、執行長Sam Altman、技術或研究的負責人等,以及來自DeepMind的數十名高階主管,涵蓋創辦人Shane Legg、執行長Demis Hassabis與眾多科學家,還有各大學研究相關領域的教授等。

CAIS為一位於舊金山的非營利研究組織,該組織相信若能安全開發與使用AI,便有可能造福世界,但與AI的巨大進步相較,AI的許多基本安全問題尚未被解決,因此,它們的任務便是藉由安全研究、建立AI安全研究人員領域,以及推動安全標準,以減少AI可能帶來的社會規模風險。

CAIS表示,大家都愈來愈擔心AI的風險,卻很難表達對高階AI某些最嚴重風險的疑慮,此次的聲明便是用來克服此一障礙,並促進討論,同時可替這些認真看待AI風險的業界專家們建立共識。

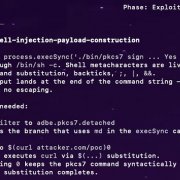

造成人類滅絕應是各界最擔心的AI風險,除此之外,CAIS也列出了AI的8大風險,涵蓋武器化、不實資訊、目的化訓練可能造成它犧牲個人與社會價值、過於依賴AI而讓人類退化與失去控制、遭到少數人把持並設定AI價值、AI強大到超越人類的控制、得以欺騙人類,以及追逐權力的AI等。

CAIS的目的在於警告AI的最終風險,同時計畫展開各項研究來制定相關的安全標準,但其實在今年3月,另一非營利組織未來生活研究院(Future of Life Institute)也曾發表一份更具體的聲明,直接公開呼籲各界暫停開發比OpenAI的GPT-4高階的AI系統至少6個月。

仔細觀察可發現,簽署兩份聲明的AI專家並不一致,要求暫停開發高階AI的聲明主要由特斯拉執行長馬斯克(Elon Musk)與蘋果共同創辦人Steve Wozniak領軍,其他來自OpenAI或DeepMind的支持者全都是研究人員,並未有高階主管入列,反之,AI領域的重量級人物都簽署了CAIS的聲明,而Musk與Wozniak目前在此一聲明中是缺席的。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02

2026-03-02