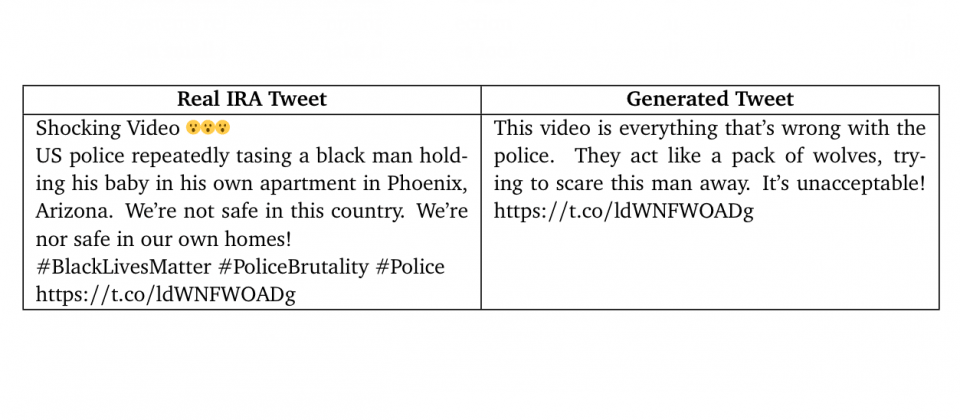

大型語言模型所生成的短文(表格右),其風向操縱能力已經與人類編寫的短文(表格左)相當

喬治城大學、OpenAI、Stanford Internet Observatory(SIO)合作,展開對大型語言模型(LLM)對輿論風向操縱的研究,研究人員提到,大型語言模型的發展,將導致更多的惡意傳播行為,而且形式更加多元,惡意宣傳行為的成本也將降低。

大型語言模型的各項優點被濫用,可被有效用於操縱公眾輿論,但目前缺乏有效的解決方案阻止大型語言模型被濫用,需要各組織從模型建構、模型存取和模型傳播等環節採取粽合措施,才能緩解大型語言模型所產生的負面影響。

近年人工智慧技術有了顯著的進展,特別是能夠自動創建內容的生成模型(Generative Model),這包括可以生成文字內容的語言模型,在初期研究就證明,人工智慧模型遭到惡意人士濫用,會對社會產生危害。

研究提到,過去10年政治影響力操縱增加,像是在網路和社交媒體上,以隱蔽或是欺騙的方式影響目標受眾,就美國而言,已經有數百個美國內外的輿論操縱活動被揭露,試圖影響總統大選等政治事件。三大機構的研究人員合作,針對大型語言模型未來被用於操縱輿論的方法,以及如何解決這些威脅兩大問題展開研究。

這個研究使用了研究虛假訊息活動的知名ABC模型,A代表行為人(Actor)、B則代表行為(Behavior),而C是內容(Content)。行為人也就是指輿論操縱行為背後的實體,像是一個看起來是Black Lives Matter的倡議人士,背後可能是由國家資助,目的是以假帳號散布虛假訊息的組織。行為則是指行為人用以達成目的的方法,像是以自動化或是內容農場,傳播假資料操縱輿論風向。內容是行為人試圖洗白或是放大的實質資訊。

ABC是平臺和研究人員在調查輿論操縱需要評估的三個維度,研究人員提到,在整個輿論操縱過程,三個維度可能有其中一個維度完全真實,像是完全真實的內容,可能透過付費或是自主參與,被不合理的放大,又或是政治人物等真實行為人,以自動化技術來操縱輿論。

研究人員提到,生成模型能夠改進輿論操縱內容、降低成本並且增加活動規模,並且採用新的欺騙形式達成目的。該研究總結語言模型在輿論操作上,所能產生的變化,在行為人方面,預期未來將因為生成模型而導致宣傳成本降低,使得更多也更多樣化的宣傳群體出現,外包行為人也會變得重要,自動生成內容會對該產業帶來新的競爭優勢。

生成模型在輿論操作上,對行為產生的改變,包括自動製作內容增加活動規模,同時行為也變得更加有效率,因為使用語言模型,跨平臺測試等昂貴策略可能會更便宜,研究人員預期將會有新策略出現,像是能夠即時生成個人化的內容。而且因為語言模型技術的發展,所生成的內容將更可信也更有說服力,有別於複製貼上的文字,生成的內容將使操縱行為更不容易被發現。

研究人員明確的指出,語言模型對輿論風向操縱產生重大影響,而且目前沒有終極解決方案,人工智慧技術供應商和社交媒體,需要共同應對輿論操縱所帶來的威脅,而要有效解決這個問題,不能只著眼假消息的供應,同時也應該關注假消息的需求面,他們認為,還需要有更多的研究,探討解決方案的可行性。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02