人工智慧研究組織OpenAI今年1月底宣布,更換語言服務API背後所使用的模型,從過去所搭配的GPT-3,改成預設使用InstructGPT,根據研究證明,在遵循英文指示的處理上,InstructGPT的表現更好,而且生成更少的有毒(Toxic)內容,這也是OpenAI第一次將多年來的比對(Alignment)研究,用於產品之上,其概念是透過由人類示範的小型資料集,訓練模型減少有害的輸出。

過去,OpenAI API是以GPT-3語言模型為基礎,藉由人工文字提示,來執行自然語言任務,但GPT-3模型可能產生不真實、有毒,甚至有害情緒的輸出,官方解釋,這是因為GPT-3的目標,是利用大型網際網路的文字資料集,來預測下一個單詞,而不是安全地執行用戶想要的語言任務,也就是說,該模型的目標與用戶的預期並不一致。

因此OpenAI為了要改進模型,使其更安全,並且提供用戶更有用的輸出,研究人員使用了來自人類回饋的增強學習技術(Reinforcement Learning from Human Feedback,RLHF),根據用戶向API提交的提示,由OpenAI的標記員向模型提供示範行為,並對模型的輸出進行排名,藉此來微調GPT-3。

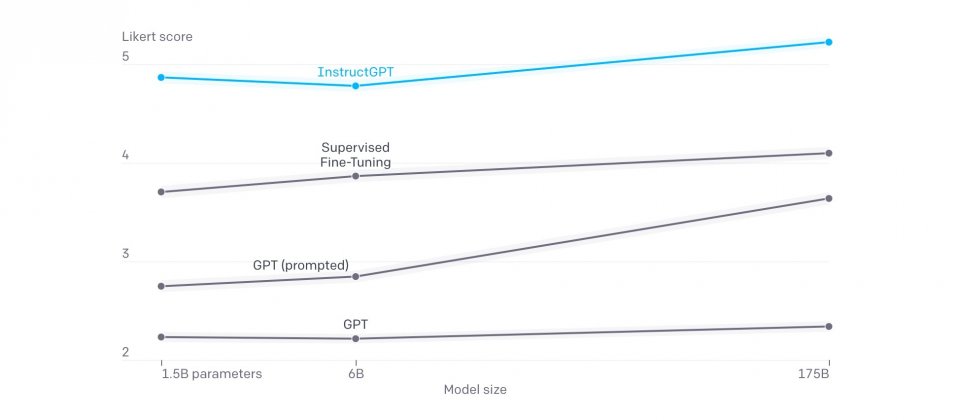

經過改進的GPT-3模型稱為InstructGPT,可以更好地遵循人類指示,有毒內容輸出也大幅降低。InstructGPT僅具有13億個參數,比起1,750億個參數的GPT-3模型小上許多,但研究人員提到,他們使用NLP效能評估方法來衡量InstructGPT的能力,發現InstructGPT並沒有輸給GPT-3,整體來說,標記員更認可InstructGPT的輸出結果。

InstructGPT已經以Beta測試的形式,在API上提供超過1年的服務,而現在官方使用InstructGPT作為預設模型,他們認為,在妥善調校的語言模型訓練循環中有人類一起參與,是改善安全性的強大方法,因此他們會繼續採行這樣的改進模式。

透過讓標記員選擇,來評估InstructGPT和GPT-3模型遵循用戶指令的表現來進行實驗,結果顯示,InstructGPT模型的輸出明顯較受青睞,而且在利用公開的資料集,來評估模型的安全性之後,OpenAI也發現InstructGPT產生的模仿錯誤更少,毒性也更小,而且經過人工評估,InstructGPT編造事實的狀況相對較少出現,也就是產生幻覺的頻率更低,更適合用於生成輸出。

但OpenAI也提醒,儘管InstructGPT已經比GPT-3模型安全不少,但在部分情況仍會產出有毒具偏見的輸出,甚至是編造事實,在沒有明確提示的情況下,產生性和暴力內容,但研究人員提到,機器學習系統的安全性,不只關乎底層的模型行為,也取決於模型部署的方式,因此OpenAI會繼續審查使用API的應用程式,並且提供內容過濾器以偵測不安全的輸出,同時監控API被濫用的情況。

由於InstructGPT是以英文說明接受訓練,所以輸出的內容,更偏向英文使用者的文化價值觀,OpenAI現在正在進行研究以了解標記員偏好間的差異和分歧,根據更具體的人群價值觀來調整模型。他們認為,要讓模型的輸出符合特定人群的價值觀有其困難度,但仍會負起責任,以具包容的流程來做出這些決定。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-25

2026-02-23