不同於晶片龍頭英特爾正在為重返晶圓代工戰場而備戰,無獨有偶,另一家GPU大廠Nvidia也正在為了擴大資料中心戰地而積極布局,除了自己的GPU、DPU(資料處理器)產品之外,甚至接下來還將推出自己的伺服器CPU產品,來與老大哥互別瞄頭。在13日舉行春季線上GTC大會上,Nvidia首度公開展示Arm架構一款全新伺服器CPU,強調可以提供TB級資料量吞吐的加速運算,也是該公司第一款資料中心等級的CPU。這顆伺服器CPU的問世,也將是繼GPU、DPU後,Nvidia所推出的第3種運算基礎技術,用以重新架構資料中心推進AI的能力,更將替該公司搶進AI資料中心補足最後一塊拼圖。甚至Nvidia執行長黃仁勳自己都說:「我們現在是一家3種晶片產品的公司。」

在GTC大會第一天主題演講,黃仁勳一開場就回顧,作為一家全方位運算平臺公司至今推動的成果,包括在全球賣超過10億顆內含CUDA核心的GPU,推出2千支GPU App,更有超過7,500家AI新創和250萬名開發者採用,針對GPU加速運算打造上千種應用。至今累積CUDA下載量更達到2,400萬次,以及釋出多達150個SDK。更可支援高達250 exaFLOPS的全球雲端運算能力。

在整場主題演講中,黃仁勳的話題始終圍繞在如何重新架構資料中心提升推進AI的能力,他認為,這需要3種晶片的能力,分別是GPU、DPU,以及CPU。其中,GPU向來是Nvidia的強項,去年該公司也開始加入DPU產品線,但唯獨缺少了CPU,Nvidia至今並沒有屬於自己的CPU產品。一直以來,在AI伺服器當中,GPU雖然扮演重要關鍵,讓AI能更進一步延伸應用,但僅靠GPU仍無法獨自存在系統中,仍需要CPU的配合,因此,Nvidia一有新系統或運算平臺推出,如DGX等,仍需搭配其他家的CPU產品,主要是英特爾x86處理器。

黃仁勳就指出,x86伺服器架構的優勢在於,能在CPU、記憶體、PCIe和周邊設備上使用不同配置來執行工作任務滿足各種應用需求,然而在遇到大量資料處理時,現有x86處理器就容易遇到瓶頸,特別是像使用Transformer架構或個人化推薦系統的AI模型,因為需要在CPU與GPU之間往反處理大量資料,現有CPU架構很難滿足這樣的需求,例如目前x86架構CPU並不支援Nvidia的NVLink高速互連,用的還是傳統的PCIe,無法提供CPU至GPU的高速連接。這正是Nvidia為何決定自己推出CPU的主因。

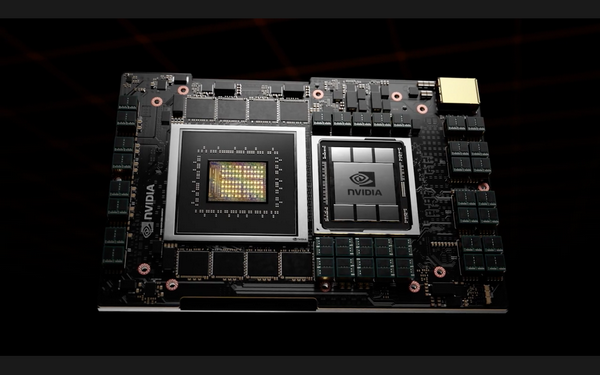

而Nvidia第一款CPU產品Project Grace,就是基於這樣設計理念而推出。這也是繼去年併購Arm後,Nvidia第二款推出的Arm架構產品,更是該公司第一款資料中心等級CPU,黃仁勳也強調,Grace處理器使用的Arm核心是下一代主要商用伺服器晶片IP,儘管,官方並未透露這款CPU配置多少核心以及採用何種Arm架構及製程技術,但根據Nvidia說明,它是專為超大規模AI與高效能運算而設計,可以滿足TB級的資料量處理,效能可達目前最快伺服器的10倍。官方另一項數據顯示,與現今DGX相比,配備Grace CPU的DGX,其運算效能至少提高5倍以上。

這顆Grace處理器本身也能提供比現有CPU還要更快的記憶體速度、加入更多通道可供CPU互連,以及提供專用GPU通道。Nvidia表示,Grace採用第4代NVLink互連技術,讓CPU連接至Nvidia GPU可以實現每秒900 GB頻寬速度,是現代最快伺服器的30倍,此外,這款CPU也支援最新的LPDDR5X 記憶體,不僅記憶體容量翻倍,與DDR4相比,也將帶來更高的頻寬和10倍的能源效率。

瑞士國家超級運算中心下一代超級電腦Alps,將是第一個搭載Nvidia Grace處理器與新款GPU的超級電腦,其運算效能可達到20 exaFLOPS,比現今最快超級電腦高出10倍,預計2年後正式上線。除此之外,美國能源部的Los Alamos國家實驗室也宣布要利用Grace來打造超級電腦以支援國家級的科學研究計畫。

.jpg)

黃仁勳也揭露未來4年資料中心產品藍圖,將由3種晶片組成,分別是CPU、GPU以及DPU,並且以每2年翻新一代架構的頻率,各別針對x86平臺、Arm平臺進行產品迭代更新,比如第一年會先聚焦在x86平臺,隔年則會以Arm平臺產品更新為主。

根據Nvidia產品規畫,未來4年,旗下將有多款GPU、CPU及DPU產品推出,其中CPU部分,Nvidia第一款伺服器CPU產品Grace預計將在2023到2024年間推出,另外在2025年還有一款全新的CPU產品將亮相。至於DPU部分,除了去年推出的第2代DPU產品BlueField之外,2022與2024年分別有第3代和第4代DPU產品發表。至於GPU部分,在2022年、2024年同樣將各有一款採用下一代Ampere架構GPU產品推出。

儘管Bluefield-2才剛推出沒久,Nvidia同一天也提前公布第三代DPU產品Bluefield-3部分規格,擁有高達220 億個電晶體,具備更強大加速運算處理能力,性能是前一代產品的10倍,在加密運算加速方面也有獲得4倍提升,並支援400GbE高速乙太網路連接。同時也針對DPU推出DOCA 1.0,可作為資料中心基礎架構SDK使用。

在DGX產品方面,Nvidia發表了新的DGX系統,除了有新一代DGX Station 320G以及新的DGX SuperPOD系統,還推出可用於如GPT-3等Transformer架構的DGX產品Megatron,可大幅縮短超大型自然語言AI模型訓練的時間,不僅如此,還有一臺推論專用的DGX版本Megatron Triton,可以支援分散儲存、以及多節點、多GPU推論能力。另外還釋出可用於藥物開發的加速函式庫套件Clara全新模型,包括MegaMolBART、ATAC-Seq、AlphaFold 1、GatorTron等。

值得一提的是,Nvidia首度把量子運算加速開發工具帶進Nvidia GPU而釋出一個cuQuantum加速函式庫,它是一個可用於模擬量子電路的加速函式庫,通過使用Nvidia GPU Tensor Cores加快量子模擬器在量子電腦算法設計及驗證的速度,包含Tensor Network和狀態向量(State Vector)等,以便研究人員可以更好地設計量子電腦並驗證結果。

cuQuantum本身亦可支援多種量子電路模擬框架,包括Qiskit、 Cirq、ProjectQ、 Q#等。Nvidia表示,在執行cuQuantum效能測試時,狀態向量模擬在雙CPU伺服器上需要10天,但在DGX A100上只需2小時,DGX上的cuQuantum可以用比原本模擬高出10倍的量子位元來幫助研究人員加快新一代量子電腦的研發。甚至以DGX在Tensor Network模擬測試所花費時間更短,從9年縮短到只須4天。

在資料中心以外,Nvidia今年在其他應用領域也有新產品推出,例如在5G系統方面,Nvidia就發表一臺具備AI能力的5G基地臺,內建整合新GPU與DPU的Aerial A100運算加速卡,可提供高達20Gbps網路存取速度。另在Nvidia Drive 自駕車平臺,也推出了新一代自駕車SoC晶片Altan ,其運算能力可達到1,000 TOPS(每秒兆次運算),較前一代Orin提高4倍之多,預計將搭載於2025年新款自駕車上。此外,在3D模擬與協同作業平臺Omniverse採用方面,近來也有更多企業用戶案例,使用它來打造數位分身的基礎設施,如BMW、Bentley等。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-02

2026-03-03