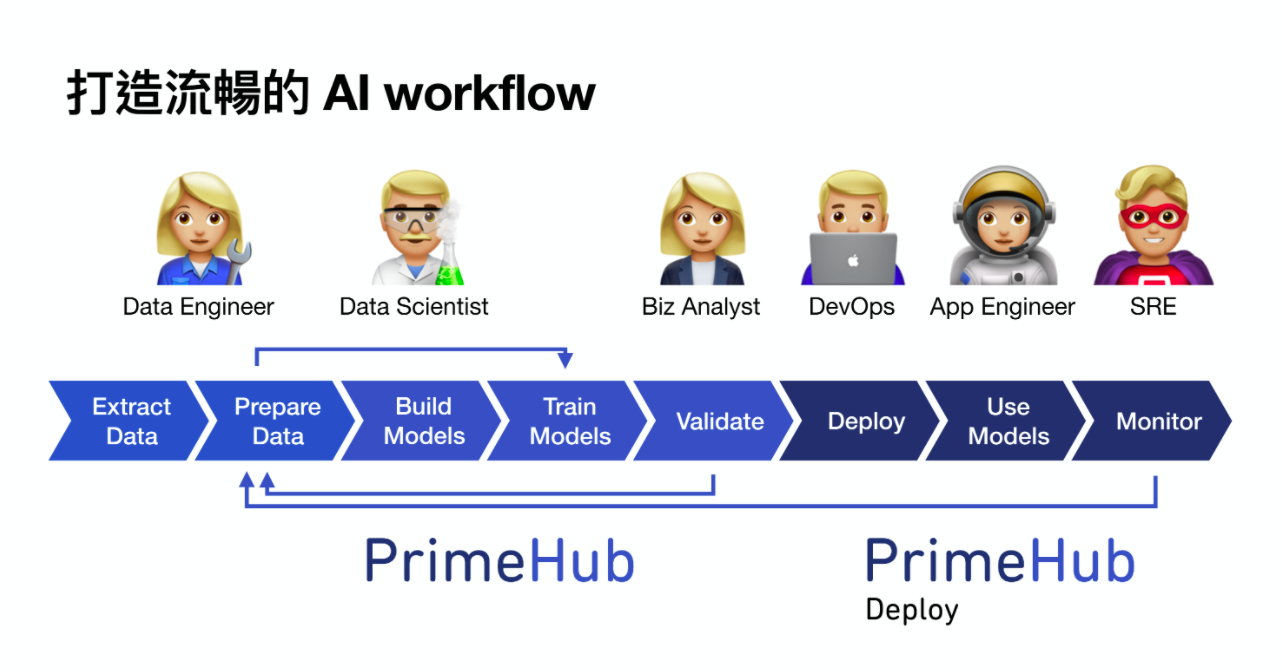

InfuseAI去年上線了MLOps維運端解決方案PrimeHub Deploy,要透過提供更簡易的部署、監控機制,在平臺中串起從AI開發到維運的全生命週期循環。

圖/InfuseAI

全球興起MLOps協作文化,強調透過更緊密的AI協作,來加速AI規模化落地。除了企業著手實踐MLOps,建立起自家的系統性AI開發流程,廠商也看重MLOps市場的潛力,試圖加入戰局。臺灣就有家2018年成立的AI新創InfuseAI,在本月6號以MLOps解決方案獲得430萬美金的A輪募資,成為臺灣首家挺進MLOps市場的本土新創,目前正在加速MLOps產品功能的開發,更要向國際拓展市場。

InfuseAI在2018年創立,由發起g0v零時政府的國內開源軟體領袖高嘉良,以及活躍於開源界的KKTIX創辦人薛良斌共同創立,主要產品是AI開發與管理平臺PrimeHub,這是一項PaaS服務,主張替企業降低AI開發的環境配置與管理成本,讓企業可以更快投入AI開發,比如透過PrimeHub軟體,可以快速建立起資料來源、運算資源、或帳號權限的管理機制。

不過,薛良斌指出,隨著企業AI發展腳步加快,企業在開發完AI模型後,面臨了模型部署、監控與維運的問題,這與近兩年從國外興起的MLOps概念不謀而合,因為MLOps正是認為AI開發也要擁抱DevOps,才能將模型持續整合、持續交付與部署落地。

觀察到這個現象,InfuseAI從2020年初,投入MLOps維運端解決方案的開發,發展出另一條產品線PrimeHub Deploy,要透過提供更簡易的部署、監控機制,在平臺中串起從AI開發到維運的全生命週期循環。這套產品也已經在去年上線。

從PrimeHub到PrimeHub Deploy,InfuseAI要透過兩套產品串起從開發到維運的AI全生命週期循環。

PrimeHub Deploy功能聚焦模型部署與監控管理,可單獨採購

去年上線的MLOps產品PrimeHub Deploy,聚焦模型部署與監控階段。在產品的設計上,相較於PrimeHub要滿足開發團隊的需求,PrimeHub Deploy更傾向滿足工程團隊的需求,來進一步提升如運算資源的使用效率或資料讀取速度,更要維持預測服務不中斷。

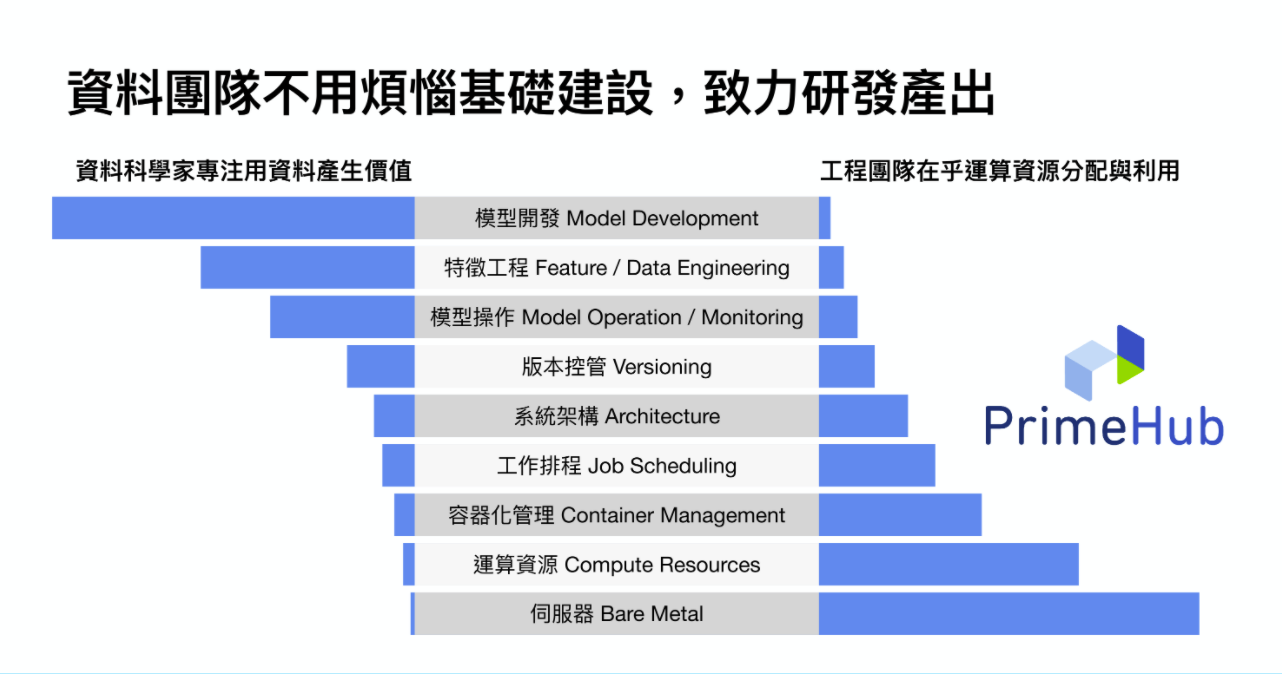

InfuseAI希望透過PrimeHub平臺,讓資料科學家與工程團隊可以根據各自需求來運用PrimeHub平臺,同時透過平臺來加強兩者之間的協作。

PrimeHub Deploy提供了多種功能,分別針對資料科學團隊與系統管理者所設計。針對資料科學團隊,平臺提供了模型部署的介面,目前系統支援以Tensorflow、PyTorch、SKLearn三種框架訓練的模型,讓資料科學家訓練完模型,不需額外開發程式,就能在數分鐘內將模型打包成API來部署。「與過去需要1~2個工作天相比,能減少部署上線的時間。」薛良斌說。

資料科學家也能自己撰寫Dockerfile與程式,為API加入前處理與後處理的機制,再透過PrimeHub Deploy進行部署。平臺也提供系統日誌查看API的部署情況,還提供運算資源的即時監控機制,讓使用者能進一步決定合適的運算資源配置。

針對系統管理者,平臺則提供了各種專案的API部署概況綜覽、預測服務的即時監控、運算資源的用量監控、認證授權機制、API部署更新的記錄查閱等功能。

預測服務的即時監控機制,包括模型每秒查詢率(QPS,Queries Per Second)監控、延遲(Latency)監控等功能。

PrimeHub Deploy也新增了版本管理的功能,來滿足模型部署、監控、回歸重新訓練等階段的版本管理需求。

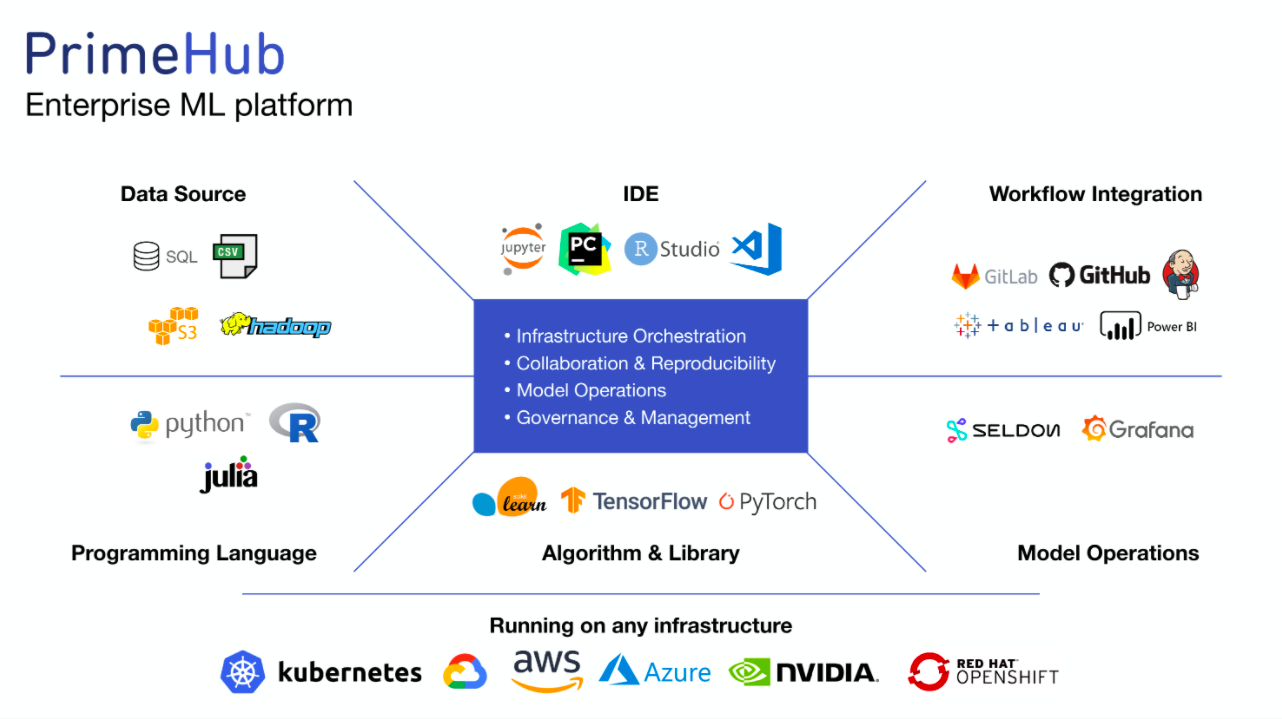

除了平臺介面功能之外,InfuseAI也整合了多種AI開發與部署的常用工具到平臺中,讓使用者能結合這些工具來加速落地AI。薛良斌指出,在原本的PrimeHub產品中,平臺整合了AI開發的常用IDE、程式語言、演算法與函式庫,以及常見的資料儲存來源如Hadoop、CSV、S3、SQL;而在PrimeHub Deploy產品中,則是整合了GitHub、Jenkins等CI/CD工具,Tableau、Power BI等BI工具,以及Seldon、Grafana等部署監控工具。

同時,PrimeHub系列產品也能支援Kubernetes、GCP、AWS、Nvidia、OpenShift等平臺,能部署其中進行運算資源管理與調度,提供PaaS服務。

在產品銷售方面,PrimeHub與PrimeHub Deploy均為年授權方式銷售。薛良斌表示,PrimeHub Deploy類似於PrimeHub平臺的外掛,兩者共用同樣的介面,僅左邊列表功能不相同,多買PrimeHub Deploy的企業左側列表欄位會新增Models模型部署的功能,「讓使用者不用學新軟體就能使用。」

左側Models欄位中,設置了模型部署的關鍵介面功能。

PrimeHub Deploy也可獨立銷售。薛良斌舉兩個場景為例,一是金融業通常受監管單位要求,軟體開發與維運環境需切割開來,就會有拆開購買的需求:二是部分規模較小的AI開發團隊,可能較無AI開發環境的建置與管理需求,但開發出的模型仍然需部署與監控,這類企業也可以選擇只購買PrimeHub Deploy。

今年加速開發模型表現監控機制,更預計Q2要上線外掛工具平臺

除了PrimeHub Deploy已經上線的功能,InfuseAI今年正在加速開發的新功能,聚焦模型表現的監控機制,也要建立起模型表現劣化觸發重新訓練的自動化維運機制。薛良斌指出,比如預測服務的健康程度、資料品質、資料漂移(Model Drift)、模型表現、訓練資料偏誤(bias)、預測結果是否違背常理(outliner)等機制,可能是未來PrimeHub Deploy功能的發展方向。

另一項正在開發中的功能,是預計Q2要上線的外掛工具平臺,InfuseAI要讓各種常用的開源或商用AI開發工具,能透過介面功能簡單點選,就能加入平臺中使用。

由於PrimeHub為核心開源的軟體平臺(Open Core),也就是說,當InfuseAI將串接用的標準技術文件公開釋出到GitHub上之後,InfuseAI不需逐一與工具提供者洽談合作,才能介接工具供PrimeHub用戶使用,這些用戶自己就能透過標準的串接格式,將所需的工具自己串接到平臺中,需要時再點選加入使用,還能設定這項工具是內部群組專用,還是也同步提供給所有PrimeHub用戶都能使用。

「讓其他工具很容易掛到平臺上,我們就不用自己開發所有包括模型漂移、可解釋性AI、資料標註等工具,這是我們做法與他人的差異之處。」薛良斌說。

薛良斌也特別指出,不只是讓使用者可以自行串接開源或商用工具,InfuseAI也在跟國內廠商談合作,將發展成熟的AI開發工具外掛進來,這些工具類型可以包括雲端工具、SaaS服務或是開源專案。這項功能預計在Q2就會上線初始版本,屆時也會提供幾個示範案例,讓使用者選用或參考。

以Open Core形式提供產品服務另一個優勢,薛良斌表示,則是不擔心程式碼被抄襲,「因為如果是抄襲,六個月以後對方的技術就過期了,所以沒有用。」也因為產品是Open Core,一般非商用的學校、研究單位、個人都可以免費使用這套PrimeHub軟體,只有開發商用AI的企業,才需要購買商用授權。這種商業模式國外也早有先例,比如知名的GitLab、在美國上市的MongoDB以及荷蘭的Elastic NV即是採取這個做法。

薛良斌也指出,當前PrimeHub的主要開發者仍是InfuseAI的員工為主,但在未來,也希望有更多非員工的開發者可以共同完善平臺功能,從提出Bug Report開始,進一步協助外掛其他的開發工具,「所以我們要提供可外掛的環境,希望開發者能協助將兩個開源專案合併在一起,這是今年要發展的一大目標。」

PrimeHub的開源文件。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-06

2026-03-09