Google推出了機器學習群眾外包不良測試集CATS4ML(Crowdsourcing Adverse Test Sets for Machine Learning)挑戰,要挑戰者以創新方法,找出機器學習模型未知的未知物(Unknown Unknowns)範例。

CATS4ML將能挑戰機器學習辨識物體的能力,該測試集包含許多對演算法難以處理的範例,而這將可發現機器學習以極高的信心程度,卻分類錯誤的情況。CATS4ML的目的是提供資料集,供開發人員探索演算法的弱點,同時也讓研究人員,可以更好地創建基準測試資料集,使資料集更加平衡多樣化。

Google提到,機器學習模型的效能,取決於演算法,以及訓練和評估的資料,雖然過去研究人員對改善演算法和訓練資料下了很多功夫,但是用來專門評估模型的資料和挑戰並不普遍,而且現有的評估資料集都過於簡單,辨識上不容易發生歧異,當缺乏模稜兩可的範例,也就無法真正測試機器學習模型的效能,而使得模型可能產生弱點。

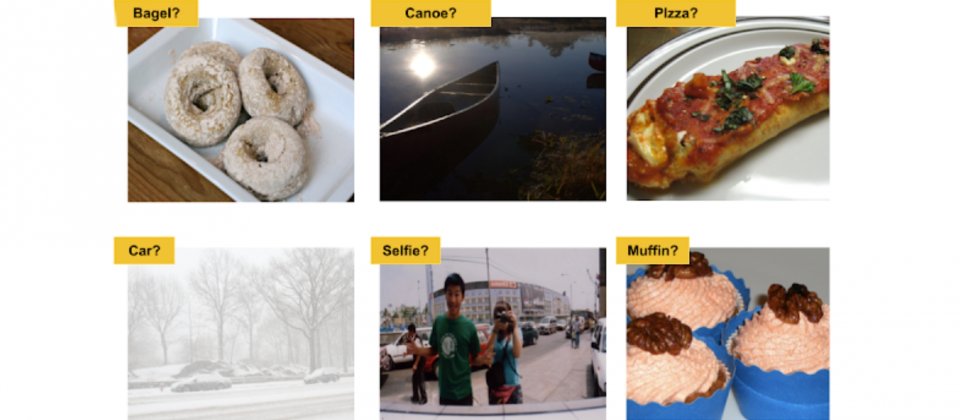

所謂的弱點,是模型難以準確評估範例分類的情況,因為評估資料集缺乏該類範例,而弱點有兩種,分為已知的未知物(Known Unknowns)以及未知的未知物,所謂已知的未知物是指模型無法確定分類正確性的範例,像是無法確定照片中的物體是不是貓,而未知的未知物則是那些,模型對答案很有把握,但是實際上卻是錯誤分類的例子。

模型在處理已知的未知物,由於信心程度不足,系統通常會要求人員驗證,因此即便判斷錯誤,人們仍可以看到模型所不知道的東西,但是未知的未知物情況不同,人們通常需要主動發現錯誤,找出意料之外的機器行為。

而CATS4ML便是要廣泛地收集未知的未知物,藉由收集人類能夠可靠地解釋,但是模型處理困難的範例,以評估機器學習模型的能力。Google目前推出CATS4ML資料挑戰第一版本,主要針對視覺辨識任務,因此使用開發圖像資料集的圖像以及標籤,挑戰者可以使用全新且有創造力的方式,來進一步探索這個既存的公用資料集,找出機器學習模型未知的未知物範例。

前些時候,臉書人工智慧研究院所推出了DynaBench動態基準測試平臺,目的是要提供比當前基準測試更具挑戰性的方法,愚弄人工智慧模型,進而更好地評估模型品質,Google提到,CATS4ML是DynaBench的補充,DynaBench透過在測試循環中加入人類參與,解決靜態基準測試的問題,而CATS4ML則是鼓勵探索現有機器學習基準,找出未知的未知物,以避免模型未來可能發生的錯誤,也能強化模型的可解釋性。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09