工研院協助矽品導入了參數最佳化的技術,運用一套自動化且標準化的快速調光軟體來找合適的參數,能將整體調光時間從20分鐘縮短到1分鐘之內。

圖/中科管理局

重點新聞(1120~1126)

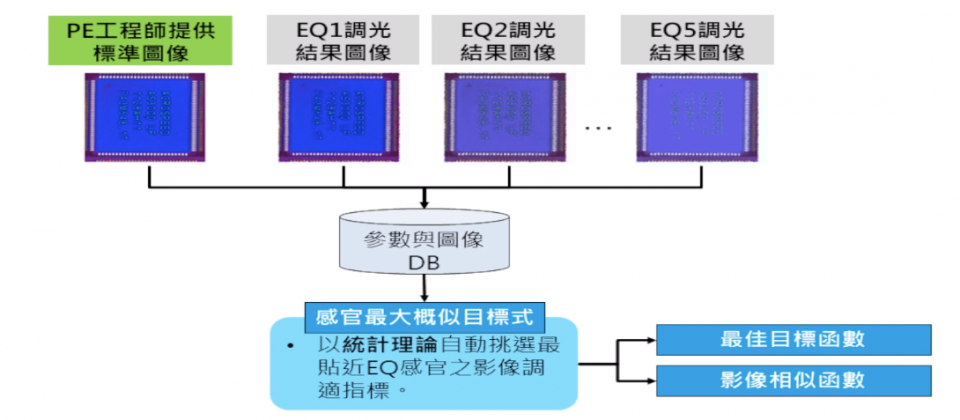

矽品 AI應用實例 參數最佳化

矽品導入兩大AI應用:AOI自動最佳化調光、靠軌跡辨識揪出違反門禁者

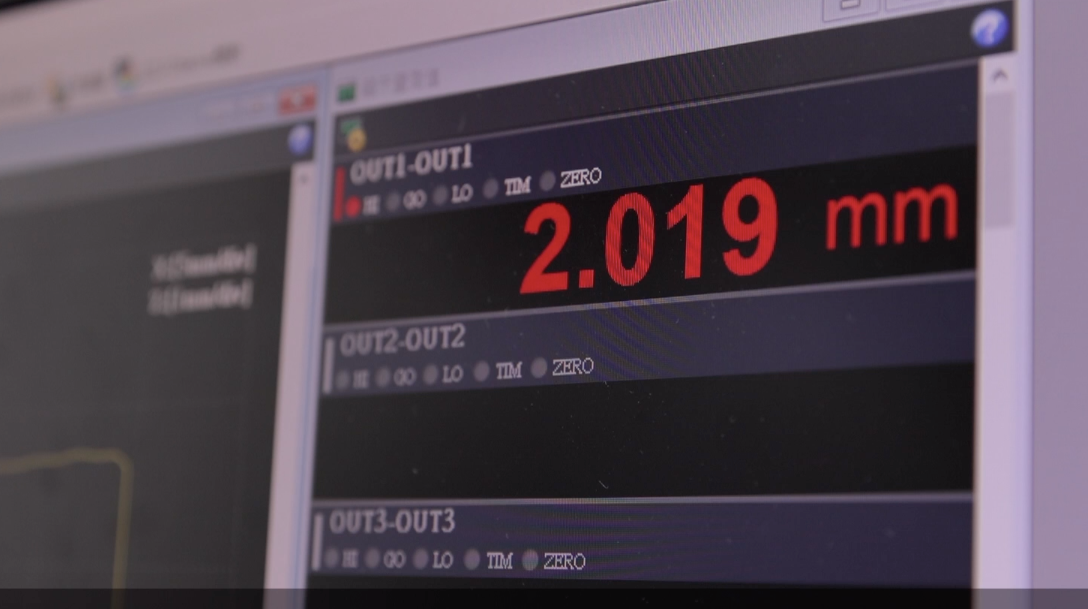

IC封測大廠矽品,近期在自家產線上的兩個場景中導入AI。一是在運用光學檢測設備(AOI)來檢查產品時,由於AOI光源在壽命期內還是會衰退,為了維持良好的檢測效果,就需要有經驗的工程師重新調整光源設定,每次調整時間約20~30分鐘。為此,工研院協助矽品導入了參數最佳化的技術,運用一套自動化且標準化的快速調光軟體來找合適的參數,減少錯誤嘗試的機會,能將整體調光時間縮短到1分鐘之內。

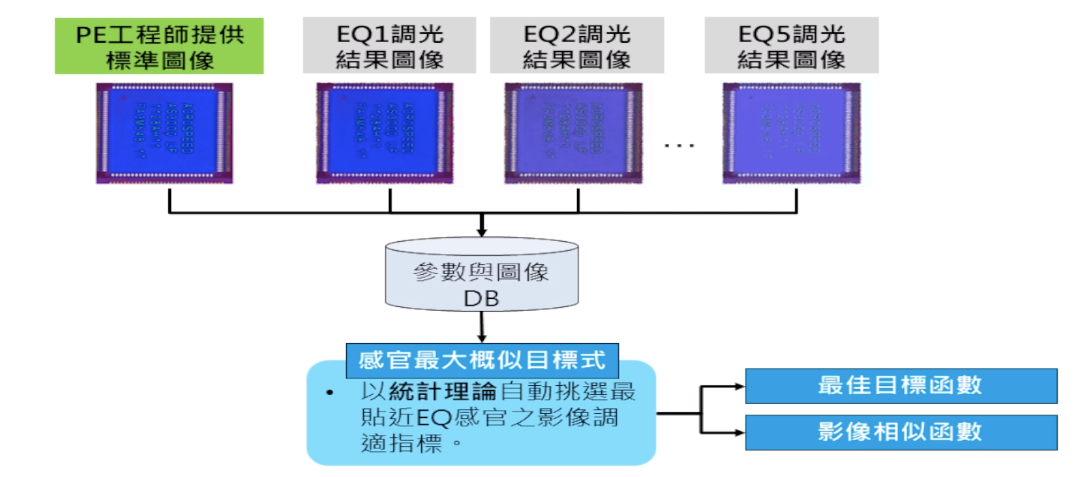

二則是在半導體產線的從業人員執行生產作業之前,需要先依規定去除靜電,才能通過三叉門進入廠區,否則可能會影響產品良率。為了防止少數人員會尾隨其他人直接通過門禁,矽品每天要花費8小時抽查20臺24小時錄製的監控影片,來揪出違規者,耗費許多人力與時間。針對這個痛點,工研院建立了物件偵測模型,先追蹤影片中穿越三叉門的人員,再以複合物件移動軌跡模型,自動分析從業人員在連續時間中的移動路徑,透過異常的軌跡來抓出違規者,POC測試時已經可以準確偵測出異常行為,未來若建置成即時偵測系統,更能直接告警來通報異常,進一步確保產品良率。

矽品智慧製造處處長徐翊指出,矽品是由作業端的人員提案,找出能提升品質、增加效率、降低成本、減少庫存的場景,再由中央統籌的單位來規劃AI導入的優先順序,並推動專案的執行,同時將各類AI導入作法標準化。矽品約從5年前就開始單點式的導入Rule-based的AI技術,近年來也更進階的導入ML、DL技術,由自家具有領域知識的專家先識別訓練資料的特性、進行資料清整,再與外部技術成熟的資料科學團隊合作,建立起AI模型,透過雙方的配合來加速AI落地。

和盈光電 AI應用實例 瑕疵辨識

合盈光電PCB瑕疵檢測改用AI辨識,TNR準確率可達99.96%

光學元件設計製造廠合盈光電,每月生產約3~4萬套相機模組,但在設置的四個檢查站中,原先只有6位檢查員來人工目檢外觀瑕疵,由於目檢人員流動率高、不易找到新人,因而成為廠商生產作業中的一大痛點。為此,工研院針對相機模組中印刷電路板(PCB)的人工焊點,訓練出瑕疵辨識模型,來取代原先人工目檢的方法,目前已經可以達到漏檢率(FNR)0.25%、篩除率(TNR)99.96%的高準確率,不只能大幅降低查驗人員的檢測數量,更能提升檢測效率。

工研院開發的瑕疵辨識模型,是運用了自主研發的多重特徵影像檢測技術(Deeply-Fused Branchy Networks,DFBN),這個技術的深度學習網路架構,包含了有多個較小但結構完整的分支神經網路,結合了多層數神經網路與少層數神經網路能辨識不同類瑕疵的優勢,來對瑕疵影像進行協同決策,提供最佳化的分析結果,能更進一步提升瑕疵檢測的準確率。

永勝光學 AI應用實例 印刷品校稿

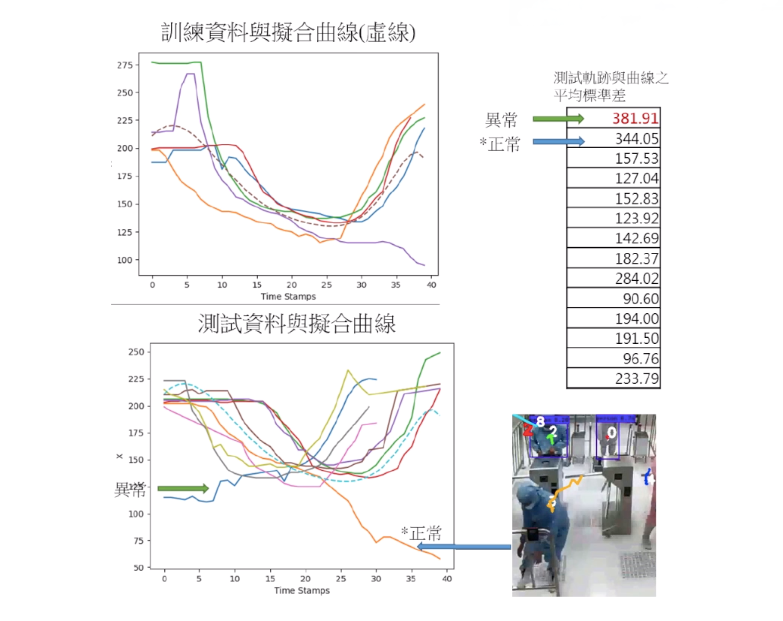

永勝光學導入AI來取代人工校稿作業,縮短5倍作業時間更能適用多國語言

光學設備製造商永勝光學,同樣運用了工研院研發的多重特徵影像檢測技術(DFBN)來進行瑕疵檢測,但,應用場景是在說明書、包裝盒等印刷品文字及圖案的校稿檢測上。比如在設計端,需要將原稿與美工編輯後的圖檔進行比對,來檢查在美編過程或轉檔時是否產生錯誤,或是在產線端印刷完成後,也需確認印刷成品與原檔資訊一致。過去,由人工來檢核一件印刷品,需要花5分鐘的時間,為了加速檢測作業,永勝光學導入AI自動擷取特徵資訊來進行比對,能將校稿時間降至1分鐘以下,縮短5倍以上的檢測時間。

這項技術的另一個優勢,則是能適用於各國語言的檢測,比如英文、阿拉伯文、德文均適用,能防止語言文字不通,人工檢測疲勞而導致的疏漏問題。

曜凌光電 AI應用實例 製程參數最佳化

曜凌光電透過2種AI模型,找出製程參數與產品品質的交互關聯來加速研發

製造業製造產品時,會需要設定大量製程參數,比如顯示器製造廠曜凌光電在蒸鍍製程與投料上,需要設定如燃燒溫度、功率、使用前預熱、靶材消耗等參數,這些參數的不同會影響產品品質。為了提升良率,曜凌光電希望找出一個能透過製程參數預測產品品質的模型,再藉由模型提供的關鍵參數,來進行最佳化的製程參數調校、分析大量製程參數的交互影響,或是在品質檢驗前就先預測產品品質,並在產品發生不良快速找出不良原因。

也因為過去的參數優化模型只能針對單一產品製程來分析,難以進行大規模的擴散,曜凌光電也希望建立一個泛用模型,來預測多種產品的製程品質,由於各產品製程受到各項變數的影響程度不同,透過剖析製程中各變數對結果值的影響程度,就能找出影響製程的關鍵參數,進而將參數最佳化,在實際應用場景中,甚至能用於新品的開發,來減少實驗次數、降低開發的時間與成本。

曜凌光電透過工研院的點子創新平臺AIdea提供製程資料,來徵求產品品質預測AI以及多樣態產品製程參數優化AI的解方,目前點子徵求競賽已經結束,也已經徵得好點子,將AI模型實際導入應用場景中。

元翎精密 AI應用實例 疊料偵測

元翎精密在金屬製程中運用AI,來排除疊料異常減少設備故障

金屬製造業元翎精密也在製程中導入AI。這項AI應用在疊料的排除上,也就是在金屬圓片完成沖壓之後,會進入連續引伸(鍛造工序之一)的製程,但在沖壓製程中產生的毛邊,可能導致圓片疊料,若沒有及時發現就進入引伸段,可能會造成設備故障,屆時就需耗費1天的時間重新調整參數才能排除故障情形,更可能因此損壞模具。因此,元翎精密在金屬圓片進入引伸段之前,運用工研院的技術,在圓片移載料臺加裝了一個高度感測設備,透過量測圓片厚度來找疊料情形,一旦發現就停止機器運行,等到排除疊料狀況再繼續生產。

開源CNN架構 HarDNet 邊緣運算

國產開源CNN架構HarDNet部署邊緣運算裝置,獲全球影像辨識評比前五強

去年開源CNN架構HarDNet的清大林永隆教授團隊,今年將HarDNet實際部署在算力較低的邊緣運算裝置上,並參加全球低運算電腦視覺競賽(Low-Power Computer Vision Challenge,LPCV)來驗證HarDNet的表現。

其中在FPGA類別的評比中,由於評分標準取決於模型精準度與速度,團隊運用HarDNet68及HarDNet39分別訓練了兩個影像分類模型,來針對ImageNet的1,000種物件類別進行辨識,HarDNet68因網路層數更多,辨識率相對較高、達到86.9%,但辨識速度較慢,HarDNet39則相反,儘管辨識速度能快上三倍,但辨識率降至73.5%。經過評比後,得獎的為HarDNet68的模型,獲得LPCV全球第二名的佳績。(詳全文)

.jpg)

左邊為HarDNet68模型的辨識成果,右邊為HarDNet39的辨識成果。後方更搭載了FPGA晶片來實際進行演算。

Google AI 樹冠實驗室 樹木分佈地圖

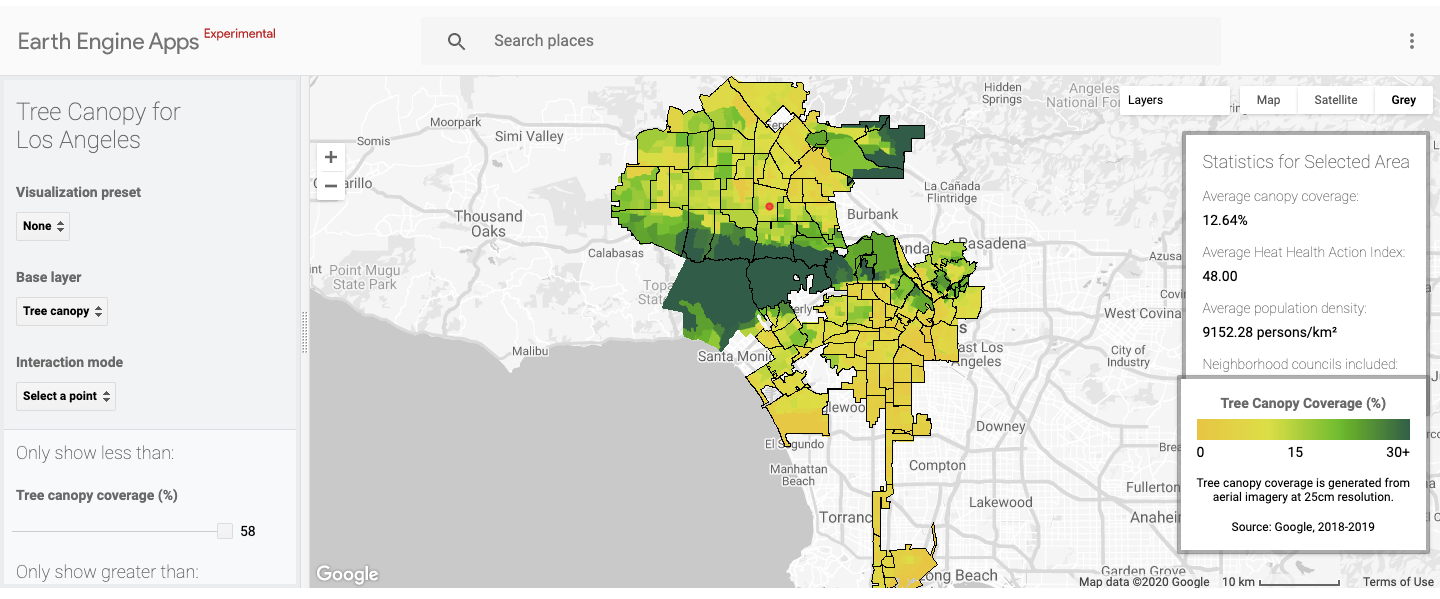

Google成立樹冠實驗室,將航空照片結合AI來規劃樹蔭

過去當城市要規畫植栽時,通常必須曠日費時地進行田野調查,或者只能仰賴過時的紀錄、不完整的研究資料等。但Google成立的樹冠實驗室(Tree Canopy Lab),先利用飛機拍攝的航拍照片,並輔以Google AI與Google Earth Engine的資料分析能力,找出城市中的樹木分布與其密度,再以近紅外線(near-infrared)照片來偵測人眼看不到的顏色與細節,並比較不同的角度來建立高度圖;接著,還利用專門偵測樹木的AI自動掃描這些照片,找出樹木的位置,建立一個能夠展現樹木覆蓋區域(樹冠)的地圖。如此一來,就能進一步辨識出具高植樹潛力的住宅區,或是找出因樹冠覆蓋率太低而可能曝露在高溫下的人行道,來規劃植樹區域。(詳全文)

AI趨勢近期新聞

1、Apple釋出專為Mac最佳化的TensorFlow版本

2、結合快閃記憶體與FPGA,三星與賽靈思合推運算固態硬碟

圖片來源/中科管理局、Google

攝影/翁芊儒

責任編輯/翁芊儒

資料來源:iThome整理,2020年11月

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-09