Nvidia發表GameGAN由三大部分組成,分別是動態引擎、記憶模組和渲染引擎,可透過視覺學習產生如假包換的小精靈遊戲。

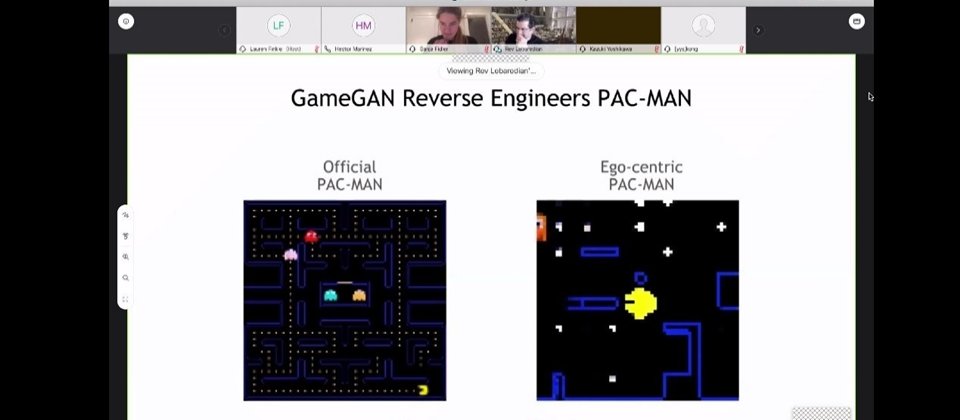

Nvidia線上會議螢幕截圖

近日正逢懷舊電玩小精靈(Pac-man)問世40周年,Nvidia也發表了最新的對抗生成網路(GAN)研究成果GameGAN,可利用經典遊戲小精靈的玩家影片,在四天內就產出一套栩栩如生的小精靈遊戲(如下圖),不僅能讓使用者動手玩,遊戲中的規則、畫面等細節更不需任何程式碼來撰寫設計,等於不需要傳統的遊戲引擎支援,憑著GameGAN視覺學習就能完成。

近年來,Nvidia深耕GAN,在去年先後發表了如假包換的臉部生成網路StyleGAN,以及能將隨手塗鴉轉換成藝術大作的GauGAN。今年,Nvidia再度秀出新成果GameGAN,能靠視覺學習產生遊戲環境,比如小精靈遊戲的場景、規則等。

打造能視覺學習的模擬器

這款GameGAN由Nvidia、多倫多大學、加拿大AI研究院和麻省理工學院(MIT)聯手打造,他們在論文中指出,模擬(Simulation)是機器人系統的核心,但要打造出好用的模擬器,還需撰寫複雜的環境規則,比如,動態代理人該如何表現、代理人行為如何影響其他代理等。

為解決撰寫複雜規則的問題,團隊想出一個方法,要透過觀察代理與環境的互動,來打造模擬器。團隊首先從遊戲下手,利用8個月時間,開發出一套生成式模型GameGAN;這套模擬器,將動畫遊戲視為現實世界的環境,可透過玩遊戲的影片和鍵盤操作,來訓練、模擬出一套遊戲,甚至產生新的關卡。

進一步來說,GameGAN由三大部分組成,首先是一個動態引擎,來維持內部更新的變數,再來是一個外部記憶模組,來記住模型所產生的畫面,保持一致性。也就是說,當遊戲中代理人按一個按鍵,GameGAN就會渲染(Render)、產生下一個螢幕畫面,而記憶模組可建立環境內部地圖,因此當代理人回到之前經過的地方時,畫面就能保持一致。最後一部分則是渲染引擎,可在每個時間實體(Instance)中,對輸出的影像進行解碼。

用4天4個GPU來學習5萬支影片

接著,團隊利用5萬支小精靈的遊戲影片,以及Nvidia DGX系統來訓練GameGAN。這些影片共有上百萬個畫面,內容包括了玩家操控小精靈的畫面,而GameGAN就觀看這些影片,從中學習遊戲規則,比如精靈吃到大力丸時,幽靈會變色、反向逃跑等。這個方法,不需要傳統的遊戲引擎支援,也能建立一套完整的遊戲。

此外,在訓練過程中,GameGAN的渲染引擎還會學習從動態元件中(如吐火的幽靈),拆分出靜態元件(如背景或藍色的牆)。這個作法,還可讓開發者替換背景,比如和馬力歐玩小精靈,或是在自己喜歡的場景中玩遊戲。

Nvidia多倫多研究實驗室主任Sanja Fidler提到,團隊開發完GameGAN後,只用了4天和4個GPU,就成功訓練出小精靈遊戲,還能讓使用者動手玩。此外,她也分享了開發過程中的趣事,「一些訓練影片來自很厲害的亞洲玩家,所以最初GameGAN產生的小精靈,幾乎都不會輸。」

但她也坦言,GameGAN產生的小精靈,還沒辦法模擬原版小精靈的音效。

下一步:開發機器人模擬系統,加速自動化發展

「模擬器是訓練機器人系統的核心,但開發模擬器非常耗時。」Sanja Fidler解釋,模擬器可用來開發夾取物件的倉庫機器人、自駕車、送貨機器人等,讓機器人在其中學習現實世界的物理定律。但也因為這樣,開發者要寫許多規則來打造模擬器,比如物體如何互動、光線如何表現等。

她認為,GameGAN可望解決這個問題,透過觀察代理人與環境的互動,來模仿代理人行為,開發者不必再撰寫複雜的規則,來開發模擬器。文◎王若樸

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-09