維吉尼亞理工學院開發了一個深度學習圖像修復模型,可以將單個RGB-D輸入圖像,轉換成3D照片,該模型能感測空間背景,迭代地合成出被前景遮擋位置的顏色和深度內容,研究人員提到,他們使用標準圖像引擎就能渲染出3D照片,比起目前最新的技術,生成的結果有較少的偽影。

3D圖片指得是以相機以及基於圖像的合成技術,呈現出具新穎視角的合成照片,讓觀看者能夠小角度移動鏡頭,看到部分被前景遮蔽的景物,這種新的圖像呈現方式,與舊的2D照片比起來,提供更豐富的沈浸體驗,可讓圖片內容在虛擬實境中栩栩如生,而且即便是以視差的方式在平面顯示器呈現,視覺效果也十分良好。

研究人員在發表的論文中提到,過去以圖像為基礎的重建與渲染技術,都需要多張的照片,或是特殊的硬體配合,但他們所應用的方法,可以只用一張RGB-D圖片當作輸入,就能產出3D照片,深度資訊可以來自手機的雙鏡頭立體視覺,也能夠來自於單一RGB的估計。

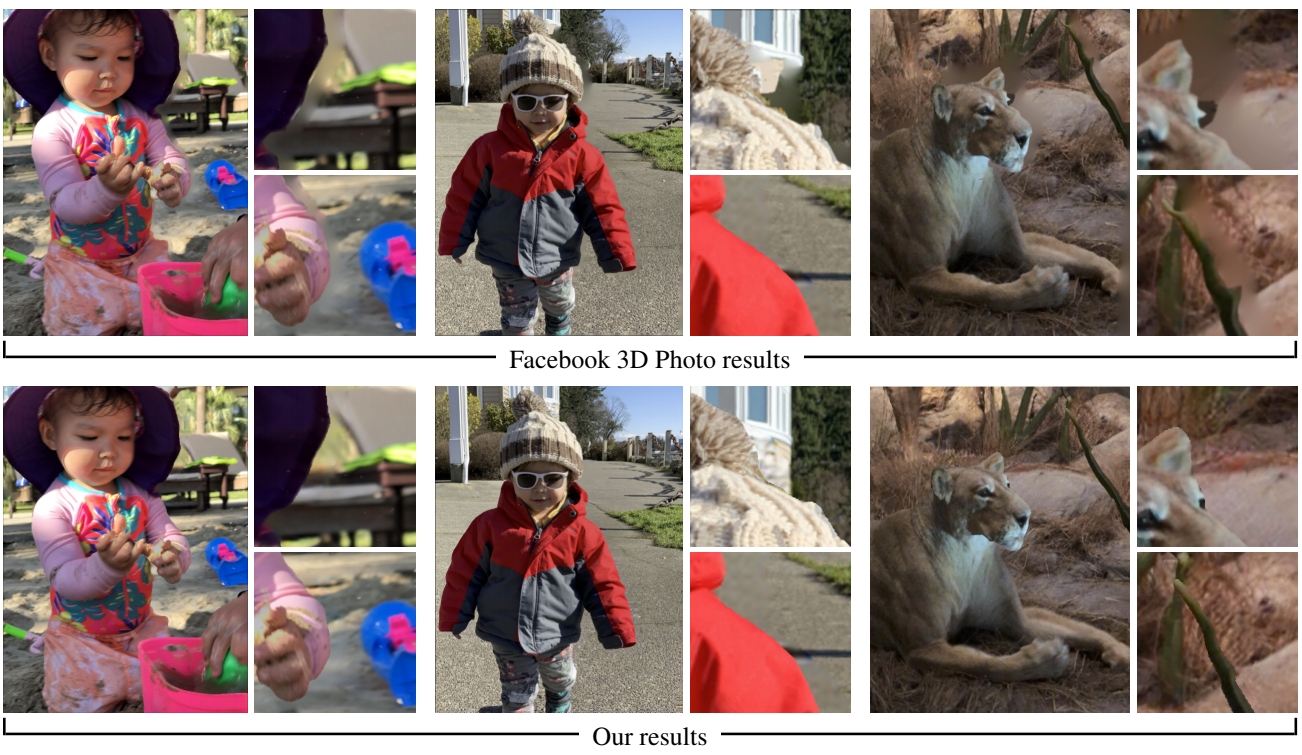

這個方式與臉書所提供3D Photos功能的原理類似,目的都是要利用手機鏡頭,降低生成3D照片的障礙,臉書3D Photos只要使用手機的雙鏡頭拍攝一張包含顏色與深度資訊照片,就能產生出3D圖片,而研究人員提到,臉書使用分層深度圖像(Layered Depth Image,LDI),雖可在行動裝置上快速執行,但是其使用各項同性擴散(Isotropy Diffusion)演算法修補空隙,導致結果過於平滑,無法分辨出材質與結構。

研究人員提出的方法以CNN為基礎,可以在圖像轉換過程中顯示更少的偽影,但是要應用一個全域CNN解決一整個問題有其困難度,因此研究人員將問題拆分成許多局部修復子問題,每個子問題相當於處理一張圖片,因此就能夠應用標準的CNN演算法,而且與以往其他方法不同的是,這個新方法不預先固定圖像層數,而是能適應輸入圖片的局部深度資訊複雜度,產生不同數量的圖層。

研究人員評估新方法處理野外拍攝照片的能力,使用來自於雙攝影鏡頭iPhone X所拍攝的彩色圖片以及深度圖,研究人員提到,臉書的3D Photos雖然可以在遮蔽區域較細小的圖片表現良好,但是在較大的遮蔽區域,偽影變得清晰可見,而研究人員提出的新方法,可以在大多數時候填充視覺合理的內容以及結構。

研究人員將新方法應用在以不同條件拍攝的照片,以驗證其效能,在大部分情況下,他們的方法都能表現良好,不過,在欄杆和柵欄等複雜的場景仍會失誤。

熱門新聞

2026-03-02

2026-02-26

2026-02-27

2026-03-02

2026-02-27

2026-02-27

2026-02-27