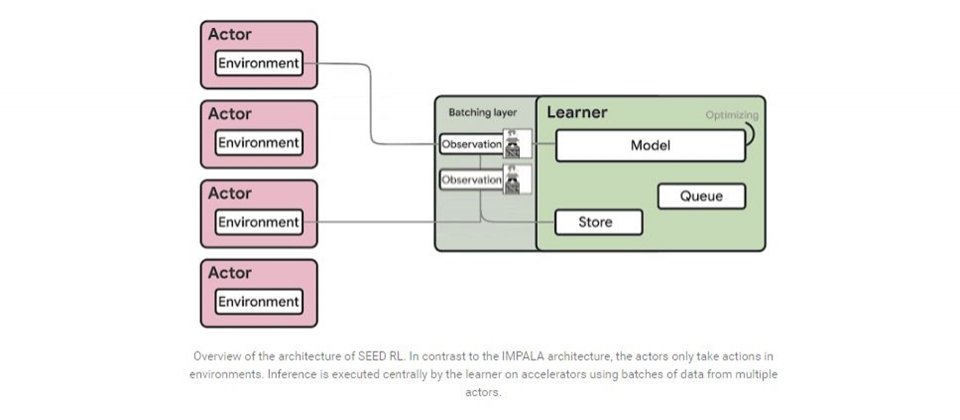

Google釋出的增強學習代理SEED RL由數個Acotr和一個Learner組成,透過集中式推論來有效利用GPU或TPU資源。

重點新聞(0320~0326)

Google 增強學習 大規模訓練

Google釋出超強RL代理,1秒訓練百萬幀影像還能省下80%訓練成本

Google日前開源一套增強學習(RL)代理SEED RL,不僅能將訓練規模擴大到幾千臺機器、每秒達到百萬幀影像,還能省下80%運算資源。Google解釋,SEED RL以自家TensorFlow 2.0框架開發,透過集中式推論和快速通訊層,來有效利用運算資源。

相較於傳統RL代理只能利用CPU來推論,SEED RL架構由數個Actor和一個Learner組成,Learner可在GPU或TPU上集中進行類神經網路推論,既可加速,也能確保模型參數和狀態都在地端,免除資料轉移的困擾。為了讓SEED RL架構成功運作,團隊也整合兩套SOTA等級的演算法V-trace和R2D2,來解決Actor和Learner不同步的問題,並將演算法擴大規模來執行。

最後,團隊利用熱門的RL基準測試來驗證SEED RL,結果顯示大型模型能提高資料效率。團隊已在GitHub上釋出程式碼,以及使用Google雲端和GPU的範例。(詳全文)

健保署 廣達 醫療大數據

健保署聯手廣達,要打造獨家AI平臺來分析數十億筆醫療大數據

健保署日前與廣達電腦簽署合作備忘錄,要透過廣達捐贈的AI醫療雲運算整合平臺系統,來客製化打造健保資料加值環境,加速AI健保大數據應用。自1995年健保開辦以來,健保資料庫每年累積了8.5億筆就醫結構化資料,健保署也在2年前加入國發會亞洲矽谷計畫,建置健保署AI技術發展環境,目前也完成了16億筆健保醫療影像去識別化作業,更在去年開放外界申請AI應用試辦計畫。

現在,健保署希望以健保大數據為基礎,由廣達提供客製化的AI智慧醫療雲端運算整合平臺,來推進AI健保研究。該平臺整合了廣達研究院的軟體、高效能AI伺服器,以及大數據儲存硬體設備等,可讓研究員透過簡易的視覺化操作,來執行資料工程、分析和機器學習建模等工作,來開發健保大數據加值應用。(詳全文)

武漢肺炎 超級電腦 雲端巨頭

美國動員雲端巨頭和產官學,以超強算力加速武漢肺炎解藥研發

武漢肺炎(COVID-19)發展至今,全球各地深陷疫情泥淖,美國政府日前號召科技巨頭和學術機構,藉助超強算力來找出解藥。比如,美國能源局和IBM組成COVID-19高效能運算聯盟,成員包括多個國家實驗室、NASA、IBM、Google、AWS、麻省理工學院等,集結了16臺超級電腦算力,共可提供330 petaflops、77.5萬個CPU核心、3.4萬個GPU,目前已模擬運算八千多種化合物,也從中找出77種可能治療武漢肺炎的物質。

另一方面,AWS也推出診斷開發計畫,挹注資金來協助研究機構理解武漢肺炎病毒、開發即時診療服務等。

cGAN 模型壓縮 影像生成

cGAN可在邊緣裝置輕鬆執行!MIT發表新壓縮架構最高可壓縮33倍

MIT聯手Adobe研究院和上海交大團隊,一起開發一套壓縮架構,可將條件式生成網路(cGAN)縮小5至33倍,讓cGAN更容易在邊緣裝置執行。一般來說,比起傳統生成對抗網路,條件式生成對抗網路(cGAN)不僅能產生栩栩如生的影像,也更可控。但它有個最大的缺點,也就是非常耗費運算資源,因此難以應用於手機、平板或VR頭戴式裝置等。

為解決這個問題,團隊設計一套GAN Compression壓縮架構,其中使用了神經架構搜索(NAS)方法,來自動尋找較不耗費運算資源、參數較少的高效能網路,然後再訓練一個通用型網路,同時將模型訓練和架構搜尋分離。後來,團隊利用SOTA等級的cGAN,來測試自家架構,發現在不影響生成圖片的精準度下,運算量最多可減少20倍以上(CycleGAN),模型大小可縮減5至33倍。(詳全文)

增強學習 DeepMind Google

憑想像力學習新行為!Google聯手DeepMind釋出增強學習代理Dreamer

Google和DeepMind團隊開發一套增強學習代理Dreamer,可利用圖片來建立一個世界模型,再利用這個模型來學習未來(Long-sighted)行為。Dreamer可透過這個方法來執行連續性任務,還能掌握Atari遊戲的技巧,應付不同的空間感知、場景理解等任務。

進一步來說,Dreamer可預測模型狀態的序列,透過三個過程學習長遠的行為,首先是學習世界模型,再來是從世界模型的預測中,學習新行為;也就是說,代理可從中習得一個價值網路,來預測未來獎勵,此外代理也會習得一個行動網路,來選擇接下來的行動。最後,行動網路會與環境互動、執行學習到的行為,來收集新經驗。(詳全文)

PyTorch Amazon Elastic Inference 運算資源

跑ML模型更省GPU成本,Amazon Elastic Inference開始支援PyTorch

AWS日前宣布,用戶可在自家的機器學習服務SageMaker或運算服務EC2中,透過Amazon Elastic Inference服務來進行PyTorch模型推論,省下GPU成本。PyTorch是熱門的深度學習框架,但對於使用PyTorch類型的應用程式來說,光是推論就可耗費9成GPU資源。此外,選擇恰當的實體(Instance)來推論,也是個挑戰,因為深度學習模型需要不同量的GPU、CPU和記憶體。

瞄準資源分配的痛點,AWS推出Amazon Elastic Inference服務。當用戶在SageMaker或EC2執行實體推論時,Elastic Inference可調配適當的GPU資源,而非使用完整單獨的GPU來加速推論。(詳全文)

Uber 程式碼 自動清除

清除過時程式碼小幫手,Uber開源程式碼自動清除工具Piranha

為了讓工程師更專注於開發新功能,Uber打造一款工具Piranha,可自動清除過時的程式碼。Uber指出,內部工程師習慣用特徵旗幟(Feature flag)來自定義App的執行動作,可讓團隊了解不同區域的用戶體驗,方便推出新功能。

但新功能上線後,就不需要這些特徵旗幟了。為降低工程師手動清除旗幟的困擾,Uber研發Piranha,可自動掃描來源程式碼,目前也已刪除2千多個過時的特徵旗幟和程式碼。Uber指出,只要用戶的程式碼庫中,廣泛使用特徵旗幟,並以特定API控制旗幟行為,且以Java、Swift或Objective-C程式語言實作,就可使用Piranha。(詳全文)

新光人壽 關聯網路分析 業務員詐欺

新光人壽押寶關聯網路分析AI,快速揪出詐欺業務員和共犯

新光人壽數位服務發展部資深協理廖晨旭日前揭露自家業務員防詐欺作法,今年初正式啟動AI關聯網路分析(SNA)調查平臺,透過警示風險評分,篩選出可疑的業務員。

為訓練模型,雙方首先梳理了新光人壽過去10年的資料,包括在職和已離職的業務員資料、客戶資料、保單、電子郵件、電話等。在訓練的同時,團隊也訂定了系統警示風險分數;另一方面,團隊也透過隨機森林、梯度提升等機器學習模型,來加強系統預測能力。之後,系統一旦偵測到可疑特徵,就會根據風險分數高低,產生警示儀表板。儀表板中還包括了警示評分卡,詳列可疑行為,並按照風險高低排序。目前,新光人壽已找出數十件個案,相關單位也正深入調查中。(詳全文)

圖片來源/Google、MIT、Uber、SAS

AI趨勢近期新聞

1. MIT用少量真實資料開發自駕車模擬系統,以現實情境教自駕車系統開車

2. Uber發表強化演算法POET,可提高AI代理解決環境問題的能力

3. 強化RL代理解讀圖片的能力!Google日本發表Neuroevolution

4. 桃園醫院聯手華碩,要用AIoT智慧手錶來追蹤疑似個案生理動態

資料來源:iThome整理,2020年3月

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02