Google自家的智慧型手機Pixel系列,其最新的Pixel 4和Pixel 4 XL使用了Motion Sense技術,讓用戶不需要觸碰裝置,就能透過手勢,控制音樂播放軟體或是靜音來電,而Motion Sense背後使用一種稱為Soli的短程雷達感測器,Google還設計特別的機器學習演算法,以解讀Soli雷達資料中的訊號,了解用戶的動作意義。Google提到,Pixel 4為目前消費型手機中,第一個整合短程雷達的裝置。

雷達的基本功能,便是使用無線電波偵測和量測遠程物體的屬性。傳統的雷達系統包含了發射器和接收器兩部分,由發射器發射無線電波,無線電波碰到路徑上的物體便會散射,部分反彈的無線電波會被接收器攔截,根據收到的波型,雷達系統便能偵測到物體的存在,並且估計物體的大小與距離等屬性。

不過這種傳統雷達並不能用在行動裝置上,因為傳統雷達的設計,僅可用於檢測大型、剛性且遠距的物體,消費型裝置需要更高的靈敏度和解析度來感測複雜的動作,因此Google團隊重新打造了新型的雷達系統,以符合人機互動需要的精準度。

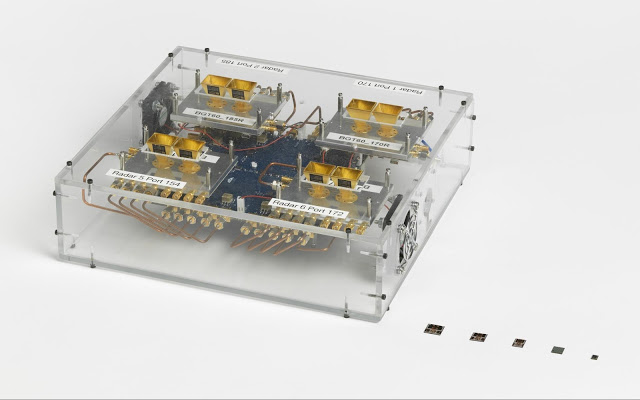

與傳統雷達區分空間結構的想法不同,Soli主要的目的是要感測動作,Soli的天線可封裝進5 mm x 6.5 mm x 0.873 mm無線射頻整合電路(RFIC)中,並且被整合安裝在手機頂部。Google提到,相對於以光學影像為基礎的偵測器,他們開發出不需要對目標空間產生清晰影像的演算法,不會有可辨識的身體或是臉部的圖像。

Soli處理隨時間變化的訊號來偵測和解析細微的動作,Soli雷達發送60 GHz的調頻訊號,並且接收附近物體的反射疊加,由於目標的位置移動,會在訊號產生明顯的定時偏移,透過分析多次的雷達訊號,訊號處理工作管線便能以不同的運動模式區分物體移動。

Google給出了幾張動畫範例,來表示Soli訊號的特徵,圖像垂直軸代表從感測器出發的徑向距(Radial Distance),由上而下數值增加,而水平軸則為朝向或是離開感測器的速度,中心為零,左側是接近目標速度為負,右側反之,另外,雷達所接收到的能量,也會被映射到徑向距與速度維度中,會以每個畫素的強度表示,強反射目標的像素,比弱反射目標的像素更亮。

下圖3張雷達動態圖由左至右分別是人走靠近裝置、人碰觸裝置,最右則是人的手在裝置上滑動。

Soli雷達原始訊號在經過過濾和增強之後,便會輸入Soli機器學習模型進行手勢分類。Google提到,運動感測技術都存在兩個主要的挑戰,首先,每個用戶的動作都是獨特的,即便是簡單的動作都是獨一無二的,另一個挑戰則是,感測器可能會接收到許多看起來跟手勢類似,但實際上是不重要的訊號,特別是當手機在移動時,以Soli雷達的角度來看,整個世界都在移動。

為了解決這些問題,Google並需要特製機器學習演算法,他們找來了數千名志願者,記錄下數百萬個手勢,並且配對側錄的雷達訊號,訓練Soli的神經網路。Soli機器學習模型使用TensorFlow進行訓練,並為Pixel裝置的低功耗數位訊號處理器最佳化,使其在裝置低電量的情況下仍然可以執行。

Google早從2014年就開始研發Soli系統,經過大幅縮小整個雷達系統之後(下圖),才得以放進消費性智慧手機中,除了尺寸縮小之外,Google還必須最佳化Soli的計算周期,才能讓Motion Sense適應智慧手機的功率。Google也發展出特殊的訊號處理技術,解決聲音震動對於Soli系統的影響,使其能與周圍的電話元件共存。

熱門新聞

2026-02-20

2026-02-16

2026-02-17

2026-02-16

2026-02-16