史丹佛大學開源號稱是機器界ImageNet的大型影片資料集RoboTurk,收錄了來自54個業餘者的111.25小時示範影片。

史丹佛大學

重點新聞(0229~0305)

RoboTurk 機器人 資料集

機器界ImageNet!史丹佛開源最大機器人操作影片資料集RoboTurk

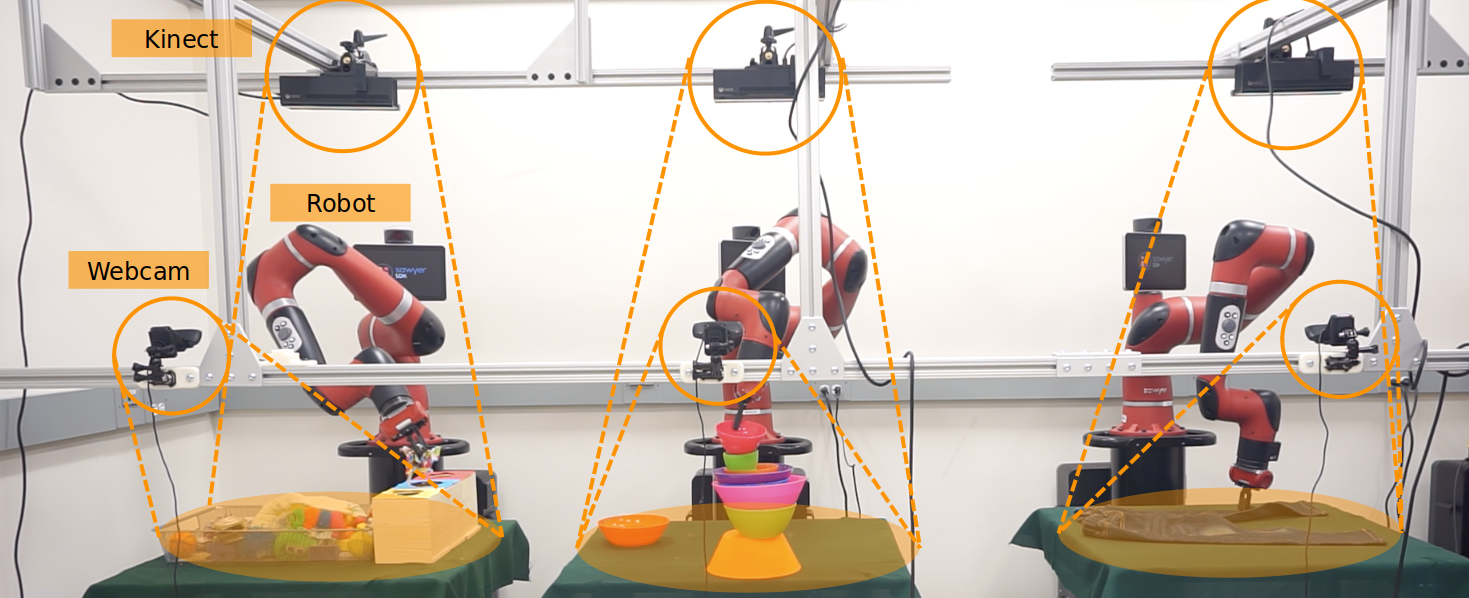

史丹佛大學日前釋出號稱最大、最豐富且多樣的機器人操作影片資料集RoboTurk Real Robot Dataset,要推進機器人決策等相關研究。2年前,史丹佛大學AI實驗室負責人李飛飛與團隊展開一項專案,建立了RoboTurk和Surreal兩大平臺,以群眾外包方式來收集高品質的機器手臂任務示範資料。

首先,透過RoboTurk平臺,使用者可用手機或瀏覽器,在遠端即時操控模擬的機器手臂,來抓取物件。後來,史丹佛大學團隊利用3支實體的Sawyer機器手臂,讓使用者透過該平臺,在遠端操作實體機器手臂,並同時收集操作數據。操作的使用者有三個任務要解決,包括物件搜尋分類、物件堆塔、衣物摺疊等。而Surreal則是開源的強化學習框架,可加速機器手臂的學習。

經過兩年運作,近日,團隊宣布任務完成,免費釋出RoboTurk資料集,包括來自54個業餘者的111.25小時示範影片。團隊表示,這些資料可用於策略學習和多種應用,如多模態密度預估、影片預測、獎勵功能學習,以及階層任務計畫等。(詳全文)

Amazon ReStGAN 影像生成

望文生景!Amazon發表ReStGAN輸入文字就能產生商品圖片

Amazon發表一套ReStGAN模型,能根據商品文字描述,產生相應的服裝範例,目的是要消費者透過視覺導引,一步步找出自己想要的產品。比如,使用者輸入黑褲女,再輸入小號和七分,一旁的服裝圖片就會隨之調整。

團隊指出,該模型的特別之處,在於新文字輸入時,服裝範例依然保有舊的特徵,再隨之調整。ReStGAN是以StackGAN為基礎,StackGAN專門處理文字轉圖片的任務,可分為兩部分,首先是根據文字,直接產生一張低解析度的圖片,接著再從這張圖片上採樣,產生一張紋理和顏色更清晰的圖片。不過,Amazon團隊額外加入了一個遞迴歸網路LSTM,可處理序列型任務,讓模型可隨文字的新增順序,來調整產出的圖片。經測試,團隊的改良版StackGAN模型,皆比目前四款常見的GAN基準模型表現要好。(詳全文)

英特爾 潛在客戶搜尋 行銷

英特爾用AI過濾百萬家企業網頁,尋覓潛在客戶更有效率

英特爾日前公開自家尋找潛在客戶的方法,由分析團隊打造一款客戶分類AI系統,可挖掘數百萬個公開的企業網頁,並從現有和潛在客戶中網頁中,抽取可分析的部分。該系統可針對兩層面來分類,一是產業領域,另一是職能角色,像是製造業者或零售商等。

而這套AI系統由兩部分組成,首先是負責採集大規模資料的引擎,要從公開來源收集企業網頁資訊,並將這些資訊結合內部數據,形成知識圖譜,並即時更新。再來是一組細分潛在客戶的機器學習和NLP模型,網頁資訊會先輸入至用來分類文字的多重標籤CNN,接著,團隊再用BERT來優化文字分析,並用維基百科上的文字資料,來擴展模型的認知。

英特爾表示,以往,業務單位都得手動或透過其他工具,來尋找潛在的產業領頭羊,但這些工具不符合英特爾內部使用的語言,因此難以制訂行銷計畫。英特爾指出,透過新的AI系統,比傳統方法更精準也更快速。(詳全文)

Google 二階梯度優化 模型訓練

Google發表超強深度學習二階梯度優化法,機器翻譯模型實測能讓訓練時間少4成

深度學習訓練資料越多,模型預測力越高,但運算資源就越龐大,如何優化訓練效率是熱門的AI議題,一階梯度優化是目前主流作法,例如Adam、AdaGrad等,儘管也出現了不少優化效果更好的二階梯度作法,但因需要龐大的運算力和記憶體,而難以實用。Google Brain、普林斯頓大學和以色列特拉維夫大學團隊發表一個可以減少運算成本的二階梯度優化法,甚至官方宣稱,比所有一階梯度優化器要快。

這個團隊以兩年前發表的優化器Shampoo為基礎,以節約型的迭代演算法Schur-Newton來取代原本耗費運算資源的SVD,並利用閒置的CPU進行自動雙精度演算法,來降低運算成本。此外,團隊也分離步長(Step)大小、方向,並跳過大維度的預處理。團隊也實際應用到英法機器翻譯的應用上,利用Transformer模型來測試,發現二階梯度優化法可達到一階優化器一樣的成效,但所需步驟的長度少了一半,且收斂速度在迭代數上快了1.95倍,整體時間減少40%。(詳全文)

Google Mesh-TensorFlow 醫療影像

AI分析超高解析度影像有解,Google釋出Mesh-TensorFlow框架

Google日前發表空間資料分區技術,可在保有解析度的前提下,來分析超高解析度圖像,如醫療上常見的3D斷層掃描等。首先,團隊用Halo Exchange演算法,來跨空間分區處理卷積運算,保留相鄰分區的關係。過程中,Google以分散式深度學習架構Mesh-TensorFlow為基礎,可根據用戶定義的影像布局(Layout),分割張量到裝置Mesh網路中,來執行高效能資料與模型平行運算。

現在,團隊也將這個框架用於肝腫瘤斷層掃瞄上,證明可行性。同時Google也釋出Mesh-TensorFlow框架,供研究社群使用。(詳全文)

Gmail 惡意文件偵測 深度學習

Gmail強化惡意文件偵測能力,用深度學習掃Office惡意文件

Google在Gmail中部署了深度學習加持的文件掃描器,可改善惡意文件偵測率。Google指出,團隊利用惡意程式掃描軟體來把關Gmail安全,每周處理3千多億個附件,其中每天被攔截到的惡意程式,63%都與前一天不同。

為此,團隊導入新的文件掃描器,由兩部分組成,首先是用TensorFlow Extended訓練出來的TensorFlow深度學習模型,以及為每種檔案類型客製的文件分析器。文件分析器的功能包括解析文件、辨識一般的攻擊模式,並進行特徵擷取等工作,提高了Gmail對惡意文件的偵測率,達150%。不過,目前這項新技術仍僅用在掃描Office文件。新的掃描程式與原有的偵測功能會平行運作。(詳全文)

fastMRI 對抗學習 臉書

影像品質不只高且更清楚,fastMRI用對抗學習消除偽影

臉書和紐約大學2年前展開fastMRI專案,最新成果不只能將磁共振成像(MRI)掃描的速度提升10倍,還能以深度學習解決MRI偽影問題。團隊指出,深度學習從少量原始資料產生高精準MRI時,容易產生帶狀或條紋狀的偽影,會影響放射科醫師判讀。

為此,團隊利用定向對抗訓練來產生深度學習模型,要從加速過的MRI中獲取原始資料,來產生無偽影的MRI。定向對抗學習的原理是,訓練目標會新增額外的損失函數,來鼓勵模型騙過對抗網路。而團隊採用這個方法,藉由在影像重建前後,隨機轉換輸入值,來產生水平和垂直的帶狀條紋,並同時訓練對抗網路和重建模型,隨著重建結果越來越好,對抗網路也會逐漸適應,直到最後沒有條紋產生為止。(詳全文)

Open Images 資料集 局部敘述

Google釋出Open Images資料集第六版,新增局部敘述註解

Google日前發布新版大型影像資料集Open Images V6,特別新增局部敘述(Localized Narrative),可隨著鼠標在圖像上的移動,同步顯示該物件的文字描述,並以語音讀出。局部敘述由註釋者提供,包含了註釋者以滑鼠在圖片上移動時,一邊說出的語音描述。Google表示,局部敘述打破了過去圖說的限制,讓圖片中的物件也有相對應的敘述。

此外,Google也在這次新版資料集中,增加了視覺關係註解,像是男人踩著滑板、狗接住飛盤等範例,另外還新增了2,350萬個人工驗證的影像等級標籤。(詳全文)

圖片來源/史丹佛大學、Google、Amazon、英特爾、臉書

AI趨勢近期新聞

1. Kubeflow 1.0正式發布

2. 論文投稿數創新高!IEEE頂級電腦視覺會議CVPR 2020如期舉辦

3. 微軟Power Automate的RPA功能將於4月正式發表

4. Postgres.ai推SQL查詢最佳化機器人Joe

資料來源:iThome整理,2020年3月

熱門新聞

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23

2026-02-23

.JPG)