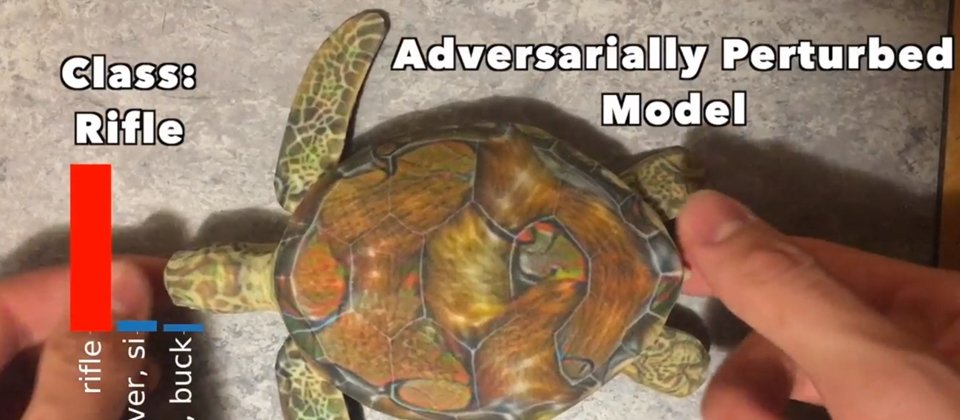

麻省理工學院(MIT)的AI實驗室LabSix上周發表一研究報告,以合成的3D對抗物件(adversarial objects)來愚弄受過訓練的神經網路,顯示基於人工智慧的神經網路存有弱點,把人類可輕易辨識的烏龜當成是槍枝。

在人們愈來愈信任人工智慧(AI)的當下,除了AI可能延襲人們的偏見而引發討論之外,研究人員也發現AI仍有可遭受攻擊的安全漏洞。

研究人員說明,基於神經網路的分類器在許多任務上可達到近似人類的效能,也被應用在高風險的實體系統上,不過,這些神經網路在遇見對抗物件時特別虛弱,當透過某些輸入值來困擾它們時,就會造成神經網路在分類上的錯亂。

過去的對抗物件演算法並不成熟,物件可能轉個角度就能讓AI成功辨識,相關的攻擊行動也只是理論上的。然而,LabSix採用了一個全新的演算去,可用來產生可靠的2D或3D的對抗範例,它完全愚弄了Google的InceptionV3影像分類引擎,不管從哪個角度,InceptionV3都會將烏龜辨識成槍枝,或是把棒球當成咖啡,就算是加入背景,InceptionV3也會以為在水裡的烏龜是槍枝,而手套中的棒球是咖啡。

研究人員認為,若對抗物件被證實是個針對AI的可靠攻擊指標,那麼就應該發展防禦它的能力。它可能被用來攻擊自動駕駛車,透過混淆的道路指標來愚弄AI系統,像是竄改道路速限,或是精心打造一個可矇騙機場掃描系統的行李箱。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02

Advertisement