圖片來源:

MIT

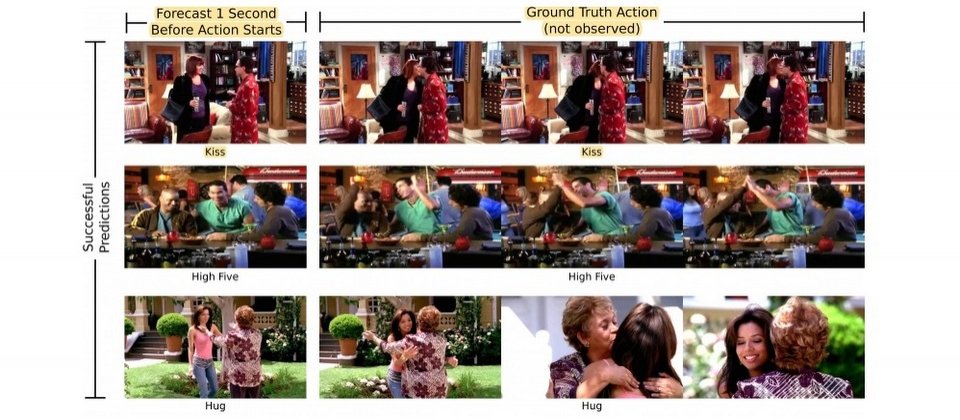

日前,MIT電腦科學與人工智慧實驗室(CSAIL)的研究人員研發出一套動作預測機器學習演算法,能夠預測人類的互動,研究人員用YouTube影片或電視節目來訓練這套機器學習系統,以分析並預測人類互動的動作,例如,擁抱、親吻、握手、擊掌等。

CSAIL研究團隊使用神經網路技術以及影片中一個動作、多種版本的靜止畫面來訓練演算法,讓演算法的神經網路能透過大量資料找到預測分析的模式,且這套機器學習模型同時有多個神經網路,每個神經網路各自預測一個動作,最後由機器學習系統整合這些神經網路的預測作為最終預測結果。MIT表示,靜止畫面可以揭露影像中更多的資訊,例如,某些像素的組合就表示是一張人臉。

另外,這套機器學習演算法在經過600個小時的影片訓練後,CSAIL研究團隊開始用新的影片進行第二階段的測試,讓這套演算法除了能夠預測人類互動的動作外,還可以預測影片中5秒後會出現的物品,例如,演算法看到影片中的人打開微波爐,就會猜測接下來會拿出咖啡杯。

MIT表示,這套機器學習演算法的預測還不夠精準,不過期望未來能夠應用在機器人、安全攝影機等,如具備動作預測演算法的安全攝影機在預測有人要從高處墜落或受傷時,能夠緊急通知救援人員。

MIT動作預測驗算法介紹影片:

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02

Advertisement