隨著ChatGPT帶動生成式AI風潮席捲全球,Nvidia在2022年上半發表的頂級資料中心GPU產品H100,目前已成為各大雲端服務業者、伺服器廠商、企業與組織爭相取得的重要AI軍火,而搭配這款GPU的伺服器與雲端服務的推出與上市時機,也受到前所未有的關注。

先前我們曾報導的伺服器Dell PowerEdge XE9680,以及公有雲運算服務AWS Amazon EC2 P5,幾乎都在今年第二季之後陸續登場,而到了年中,又有一波GPU伺服器與GPU執行個體服務正式推出,例如,我們現在所要介紹的雲達QuantaGrid D74H-7U,在8月中終於公布詳細的技術規格,Google Cloud在8月底的年度用戶大會期間宣布,搭載Nvidia H100的執行個體服務A3將於9月正式上線。

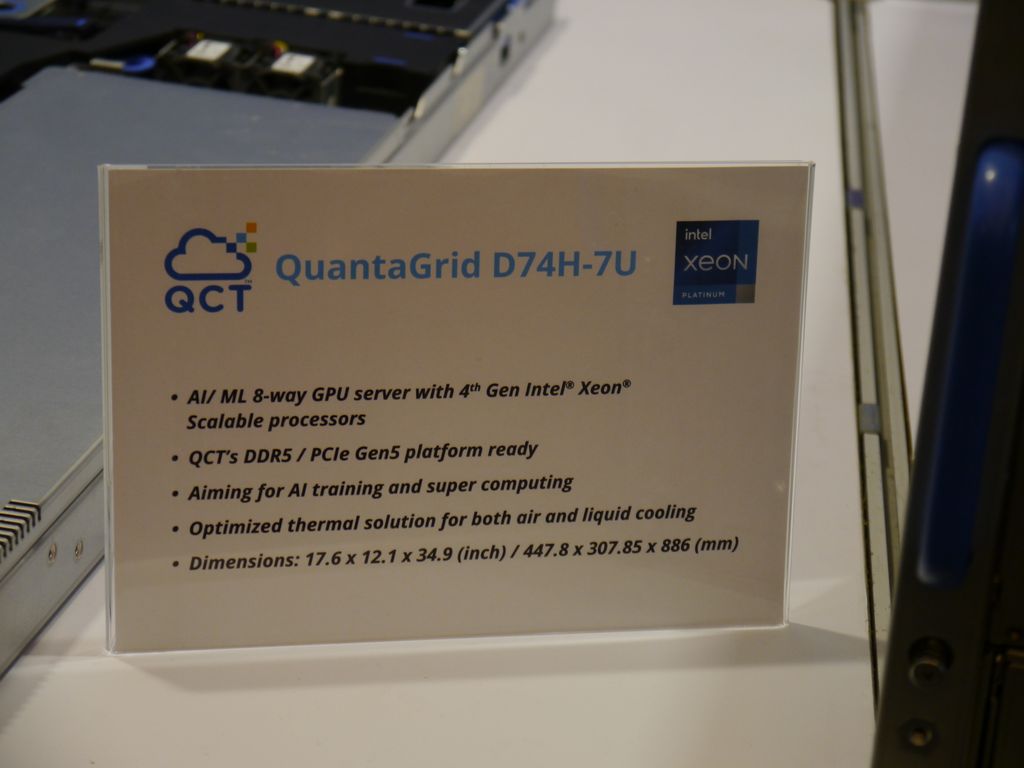

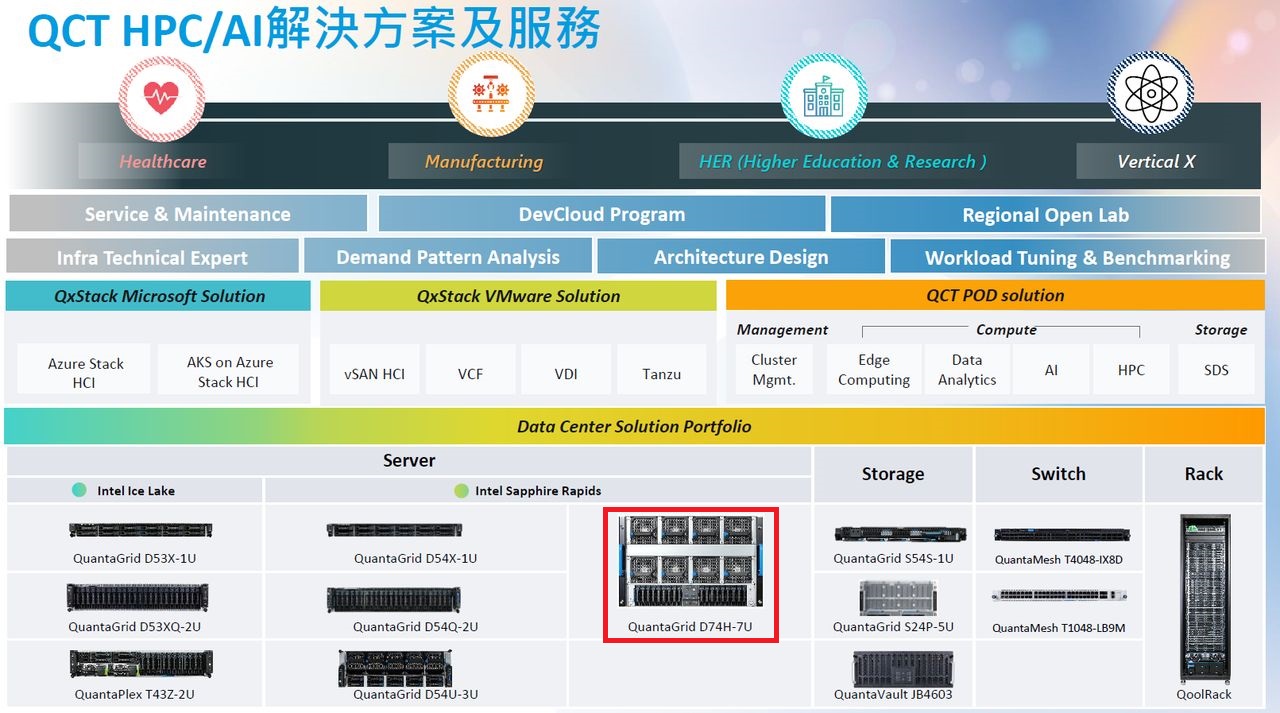

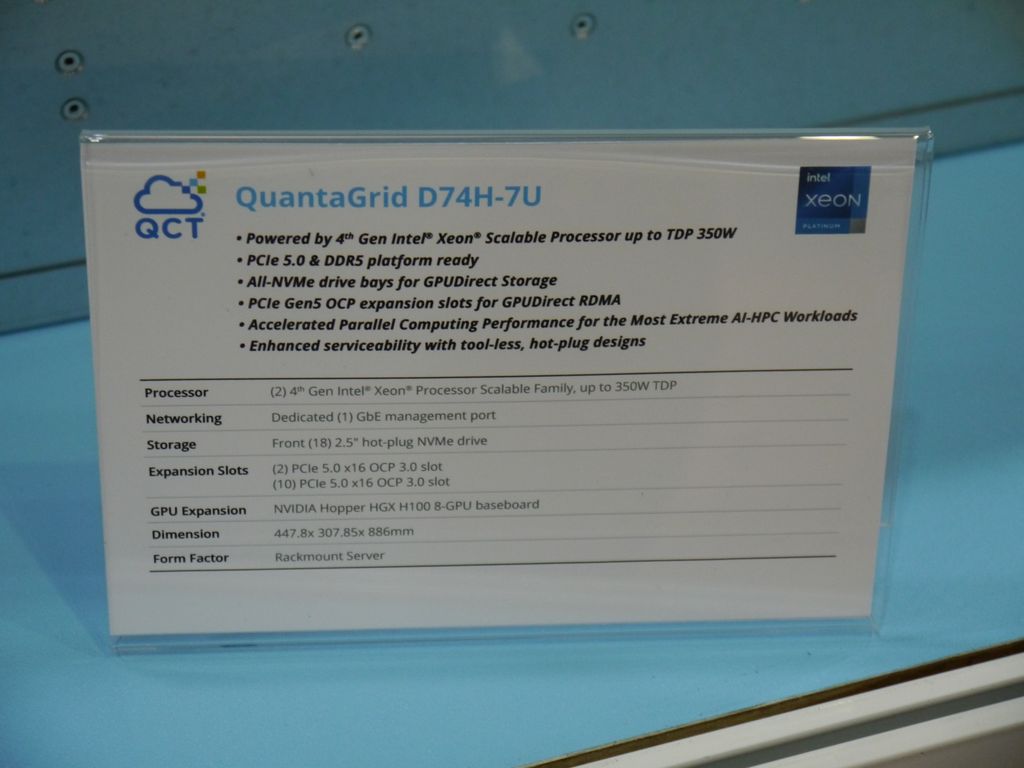

事實上,雲達打算推出這款GPU伺服器的消息,並非今年才透露,早在去年11月舉行的美國超級電腦大會,它就已經公開亮相,因為我們看到當時參觀活動展覽的一些科技媒體,如StorageReview,恰巧在他們的社群網站Instagram與多媒體影音網站YouTube頻道發布D74H-7U的照片與影片;12月14日雲達在臺灣舉行的Q.Synergy年度大會,我們看到他們展示隔年即將上市的多款伺服器當中,機箱尺寸高達7U的D74H-7U非常顯眼,是現場重點展示產品之一,但當時雲達僅公布簡要規格,例如,採用英特爾第四代Xeon Scalable處理器、配備8個GPU加速器、支援DDR5記憶體與PCIe 5.0介面,可針對氣冷與液冷提供最佳化解決方案,用途鎖定AI訓練與超級電腦運算,洽詢現場解說人員之後,我們得知當中搭配的GPU是Nvidia H100。

到了2023年1月上半,英特爾正式推出第四代Xeon Scalable處理器,雲達也發布新聞稿,揭露採用這批處理器的7款機型,D74H-7U也名列其中,預計是第二波上市的產品,而在3月底的英特爾邊緣到雲端技術產業論壇,以及5月底的台北國際電腦展等多個活動場合,我們再度看到雲達展出這款機型,但當時仍未公開詳細規格。

最近我們再到雲達的網站查看他們的伺服器產品近況時,赫然發現當中已公布這款GPU伺服器的細部資訊,這裡陳列更多角度的產品外觀與更完整的技術規格。

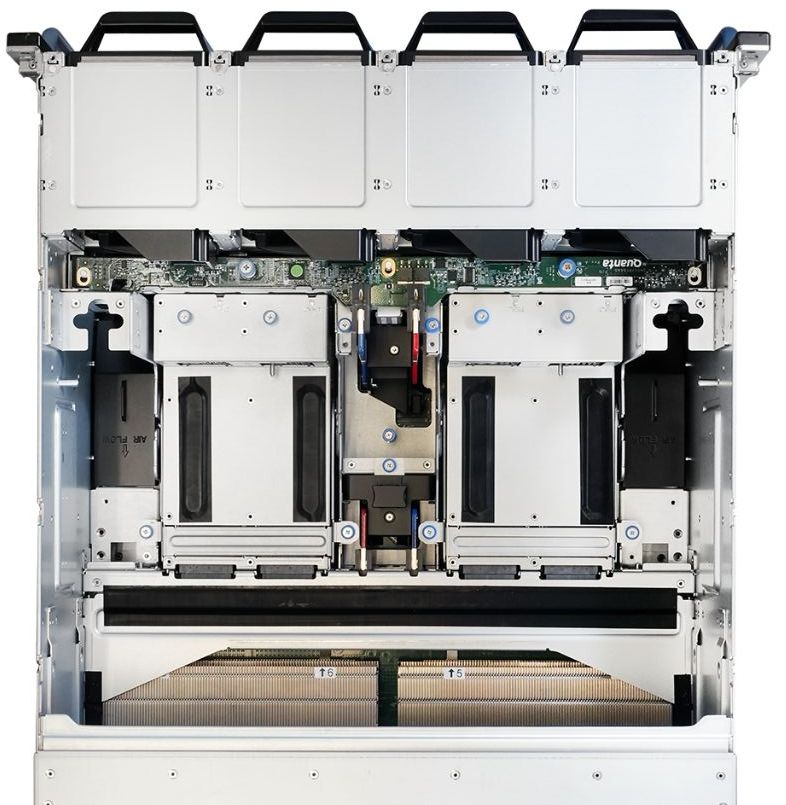

以GPU而言,雲達D74H-7U的確如我們預期,採用Nvidia HGX H100 8-GPU,相較之下,我們先前介紹的另一款類似定位的產品Dell XE9680可額外選擇Nvidia HGX A100 8-GPU,多了一些搭配彈性;CPU的部分,這兩款伺服器搭配2顆英特爾第四代Xeon Scalable處理器,Dell XE9680最高可搭配56顆核心、熱設計功耗為350瓦、L3快取為105 MB的款式,雲達D74H-7U同樣可搭配熱設計功耗為350瓦的款式,但最高可支援L3快取112.5 MB的款式,換言之,可採用60顆核心的Xeon處理器,略居上風。

記憶體方面,兩款伺服器均提供32個DDR5-4800規格的插槽,Dell XE9680最大可擴充至4 TB(支援單支128 GB),雲達D74H-7U可擴充到8 TB(支援單支256 GB)。

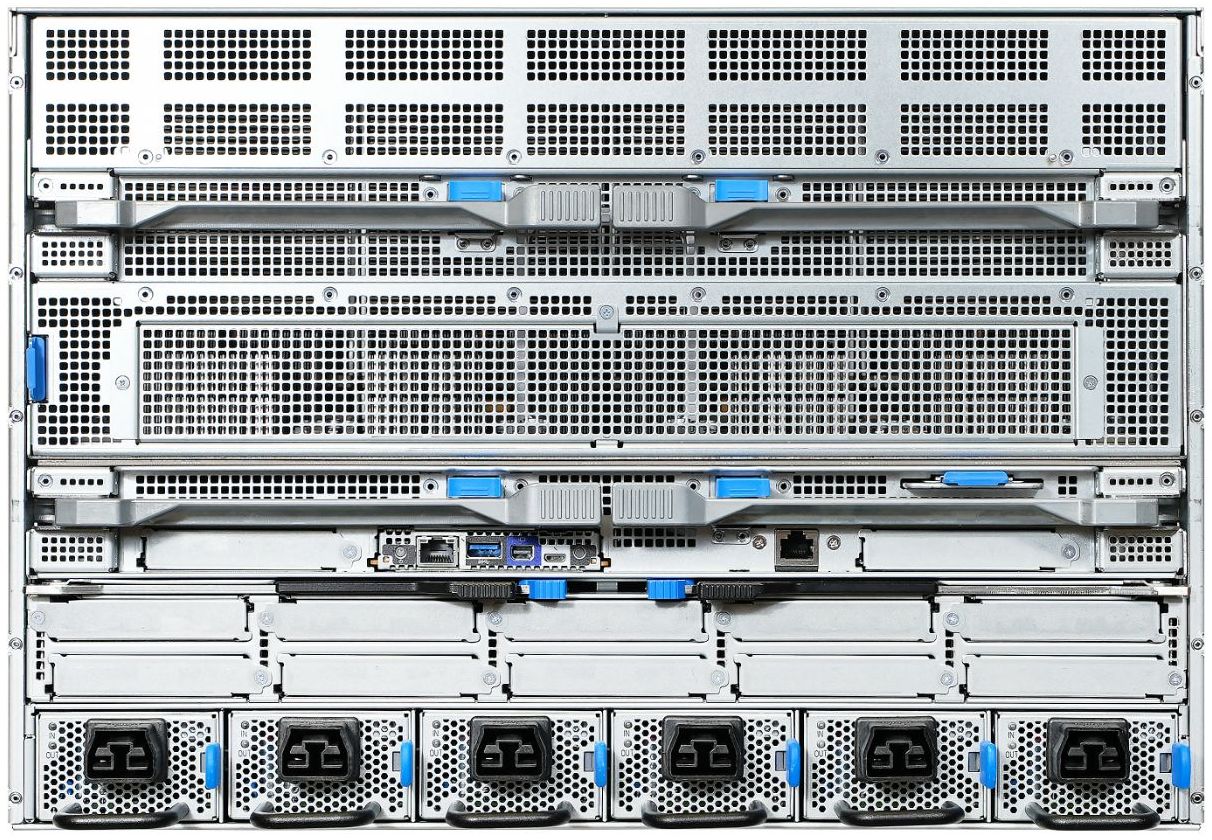

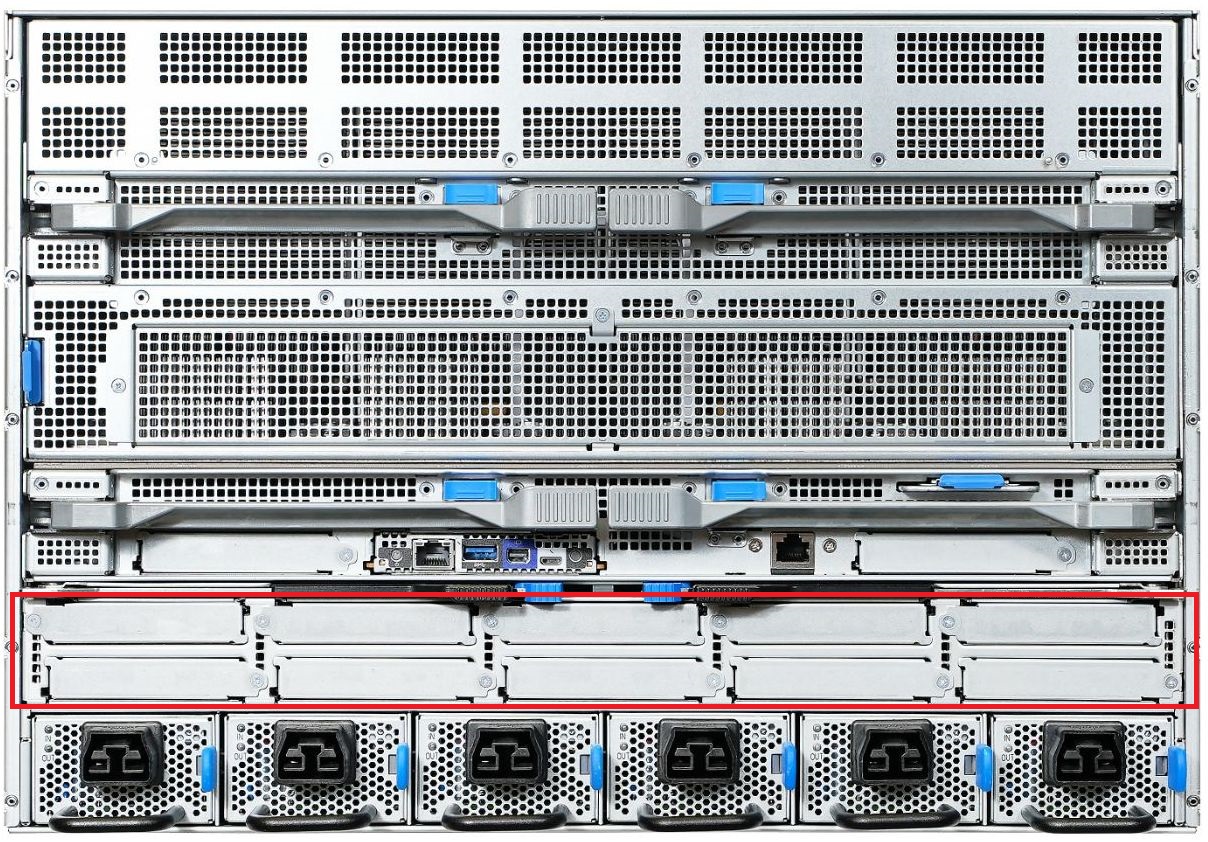

而在硬碟儲存方面,Dell XE9680機箱前側可安裝8臺2.5吋外形NVMe固態硬碟,搭配他們特有的BOSS開機儲存模組NVMe BOSS-N1,內建2張M.2外形NVMe固態硬碟,雲達D74H-7U機箱前側可安裝18臺2.5吋NVMe固態硬碟,號稱可支援Nvidia GPUDirect Storage的應用,主機板可安裝2張M.2外形固態硬碟。

在PCIe 5.0介面卡擴充能力方面,Dell XE9680在機箱前側可安裝10張全高半長的介面卡,雲達D74H-7U可支援到12張網路卡——機箱背部10張OCP NIC 3.0 TSFF外形的網路介面卡,內部2張OCP NIC 3.0 SFF外形的網路介面卡。

值得注意的是,根據雲達在技術規格文件的標示,這10張網路卡是用於Nvidia GPUDirect RDMA,一般而言,此項技術可提供點對點傳輸的資料路徑,供GPU記憶體與Nvidia網路卡裝置之間直接存取,而這也暗示D74H-7U搭配的網路卡,有可能是Nvidia在2021年發表、2022年初供貨的ConnectX-7系列,而這產品也是目前唯一我們知道提供OCP NIC 3.0 TSFF外形的網路介面卡。

就機箱、風扇與電源供應器而言,Dell XE9680為6U尺寸,機箱中段與背部分別配置6臺與10臺風扇,電源供應器為6臺2800瓦(5+1備援);雲達D74H-7U為7U尺寸,機箱前端配置8臺風扇,電源供應器為6臺4000瓦(3+3備援)。

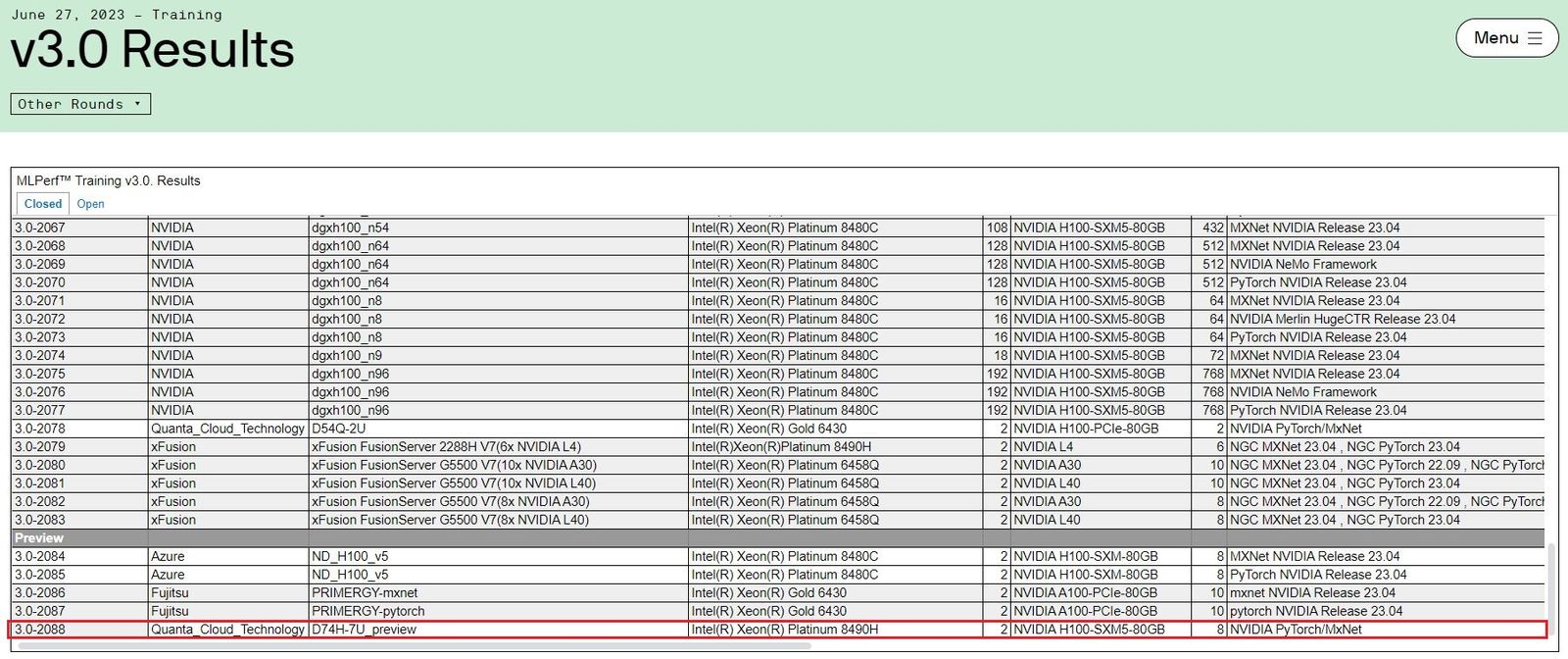

在運算效能方面,6月底MLCommons公布MLPerf Training v3.0效能測試結果,雲達D74H-7U也是榜上有名。對於同樣採用Nvidia HGX H100 8-GPU的這些伺服器機型而言,各自的AI性能表現在伯仲之間,D74H-7U在語音辨識處理時間最短,只需16.607分,醫療影像分割、物體偵測(大量處理)排名第三,分別需要12.102分與19.52分。

關於提報AI訓練測試的系統組態上,這款機型當時採用2顆英特爾Xeon Platinum 8490H(60核心)、1TB記憶體(16支64 GB)、2臺7.68 GB的NVMe固態硬碟與1張500 GB的M2外形NVMe固態硬碟,以及ConnectX-6 25Gb/s規格的網路卡。

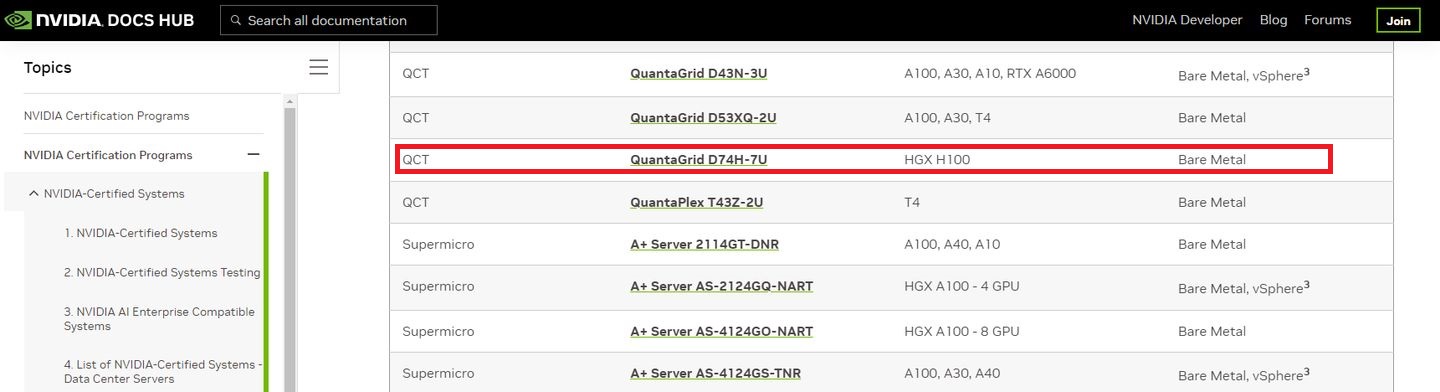

在產品符合Nvidia認證要求方面,根據9月公布的NVIDIA-Certified Systems Documentation文件,雲達QuantaGrid D74H-7U也名列其中,可用於Nvidia AI Enterprise軟體平臺的裸機安裝。

產品資訊

雲達QuantaGrid D74H-7U

●原廠:雲達科技

●建議售價:廠商未提供

●機箱尺寸:7U

●處理器:2顆,第四代Xeon Scalable系列(最高搭配60核心機型)

●記憶體:32個DDR5-4800插槽,最大可擴充至8 TB

●儲存配置:18臺2.5吋NVMe固態硬碟+2臺M.2固態硬碟

●搭配GPU:Nvidia HGX H100 8-GPU

●I/O擴充介面:12個PCIe 5.0 x16介面卡(10個OCP 3.0 TSFF、2個OCP 3.0 SFF)

●電源供應器:6臺4000瓦(3+3備援)

●系統風扇:8臺

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02