資料來源:AIxCC,iThome整理,2025年10月

用AI挖掘漏洞今年邁入新里程,相關重要發展,可追溯至2023年,美國白宮宣布舉行AI網路挑戰賽(AIxCC),當時共有42支隊伍報名參賽,目標是設計AI驅動的網路推理系統(Cyber Reasoning System,CRS),發展可自動發現與修補漏洞的解決方案。

這項賽事歷經兩年的比拚,今年8月,美國國防高等研究計畫署(DARPA)公布最終成績,並揭示決賽帶來的重大成果,自動修補能力更是成為最新關注焦點。

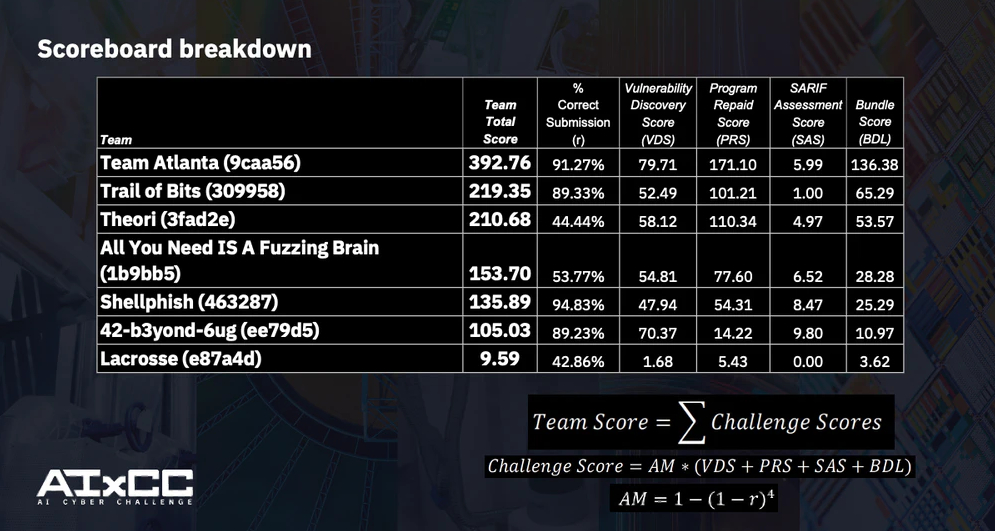

AIxCC競賽最終成績揭曉,第一名隊伍為Team Atlanta

基本上,在2025年決賽挑戰專案中,主要聚焦C與Java的程式語言漏洞計分,主辦方總共設計了70個刻意設計的合成漏洞(synthetic vulnerabilities),讓7支決賽團隊設計的CRS系統,來自動發現漏洞並提出修補方案。

第一名是在決賽中獲得393分的「Team Atlanta」,其成員來自美國喬治亞理工學院、三星研究院、韓國科學技術院(KAIST),以及浦項科技大學(POSTECH)。

他們的CRS系統可發現43個合成漏洞,並成功修補31個。不僅如此,還額外發現了6個零時差漏洞,其中3個存在於C語言,3個存在於Java語言。

第二名是獲得219分的「Trail of Bits」,是來自紐約的小型企業團隊,成績不俗,設計的CRS系統能發現28個合成漏洞,成功修補19個漏洞。

第三名是獲得211分的「Theori」,由美國與南韓的AI研究者與資安專業人士組成,他們的CRS系統發現34個合成漏洞,並成功修補20個漏洞,而且另外找到一個Java的零時差漏洞。

不只上述3隊表現出色,就連排名第6的「42-b3yond-6ug」,表現也很搶眼,該隊伍雖然只獲得105分,但其打造的CRS系統能發現41個漏洞,並成功修補3個,甚至還額外發現了9個零時差漏洞,其中2個在C語言,7個在Java語言。

AIxCC決賽7強的CRS系統已全部開源釋出!

AIxCC挑戰賽的落幕並非終點,DARPA要求所有決賽隊伍都要在賽後開源其成果,這將讓全球乃至臺灣的資安研究社群與產業,都能在此基礎上更深入研究、驗證與創新,加速AI驅動防禦技術的應用落地與發展。

AIxCC決賽新轉變,更看重發展AI自動生成修補的能力

關注AIxCC參賽隊伍的名次之餘,從上述決賽的得分,我們發現決賽的關鍵不僅在於找出漏洞,更在於能否有效修補。因為,主辦方DARPA明顯將「高品質修補」列為評分核心,其權重甚至高於漏洞發現。

以冠軍隊伍Team Atlanta為例,能從眾多參賽隊伍中脫穎而出,除了找出43個漏洞,更成功修補其中31個,最終累積393分。相較之下,第6名隊伍雖然同樣發現超過40個漏洞,但成功修補的只有3個,得分為105分。換言之,我們可以發現修補效率的落差,成為決定這次勝負的關鍵。

事實上,AIxCC的設計初衷,也正是促使AI系統不只自動發現漏洞,還要能提供不破壞功能的修補方案。而在確認AI自動發現漏洞的可行性後,決賽計分權重也做出改變,聚焦品質與可靠性。

今年的決賽有哪些重要改變?簡單而言,決賽內容可分成full-scan與delta-scan兩種形式,而根據第二名Trail of Bits團隊的分享,決賽期間共有48回挑戰,涵蓋23個開源儲存庫。

至於決賽總分的計算,據DARPA指出,主要是由「準確率加權係數」乘以各項表現指標而得,包括「漏洞發現分數」、「程式修補分數」、「SARIF評估分數」與「關聯度分數」。

我們認為當中最重要的變化是,每個成功修補的得分權重,是成功漏洞發現的3倍。換言之,1次正確修補可抵3次漏洞發現。而且這兩項分數計算皆納入時間係數,完成得越快,得分權重也越高,等於也有鼓勵快速修補的意味。

同時,這次還加入SARIF評估與關聯度的分數,前者反映AI對漏洞報告的理解與判斷能力,後者衡量能否正確關聯漏洞與修補的能力。再加上準確率加權機制,也就是系統提交越少的錯誤結果或重複結果,整體得分將會越高。

綜上所述,這些計分機制均突顯出,AIxCC不只強調找出漏洞,更強調修補漏洞,並重視速度、精準度與穩定性。

「高品質修補,是這場競賽一項重要成就。」AIxCC專案經理Andrew Carney在公布決賽結果時特別提及此事,他並觀察到,各隊CRS系統在挖掘漏洞的過程,其實也促進了修補程式的開發。

言下之意是:CRS系統在分析漏洞時,其推理過程不僅有助於識別弱點,也能深入理解漏洞的成因與修補邏輯,從而生成更貼近實際問題、品質更高的修補方案。

綜合來看,隨著AIxCC競賽的推進,也顯示當今應對漏洞策略的變化:從利用AI發現漏洞,推進到同時重視修補品質與實用性。

修補速度、成本效益的展現,同樣成為決賽比拼的一大亮點

值得一提的是,DARPA還公布決賽的一些亮點,例如,這7支決賽團隊的CRS系統,總共分析超過5,400萬行程式碼;每支隊伍都識別出一個零時差漏洞。

不過,根據最終成績資料,僅有5支隊伍發現真實的零時差漏洞。我們推測,DARPA此處所指的「識別」,應是指7支決賽隊伍的系統皆識別出含真實漏洞的程式碼區段,但僅有5支隊伍提交出可驗證的漏洞報告。

在修補成果方面,DARPA指出,各隊提交修補的平均時間為45分鐘,而且有1支隊伍的成功修補是長度超過300行,也有4支隊伍生成只需一行程式碼更改的成功修補。

在成本效益上,DARPA特別強調,有隊伍在處理每個競賽任務的平均花費僅約152美元,展現自動化漏洞發現與修補帶來顯著的成本效益。

而且,為了突顯這項價值的差異有多大,DARPA特別以傳統漏洞獎勵計畫(Bug Bounty)作為對比,指出後者往往需支付數十萬美元不等的獎金成本,以彰顯CRS系統的可貴之處。

儘管這樣的比較是否完全等價,外界可能有不同看法,但我們認為,單就考量成本這個因素而言,就是提醒大家:不僅要在技術上追求AI的準確度與修補品質,也要考量實務應用的成本效益與可持續性,才能讓解決方案能夠大規模落地應用。

若進一步檢視決賽規則,我們可以發現DARPA在成本方面的限制與規範。

例如,為了確保公平競爭,以及反映AI系統在現實企業環境下的運作條件,DARPA針對所有決賽隊伍提供兩大類預算資源,包括:Azure訂閱預算,以及LLM使用預算。

以Azure訂閱預算而言,微軟是技術合作夥伴,由主辦方DARPA統一提供這項雲端資源,給予每支決賽隊伍10萬美元的開發預算,可用於部署、訓練與測試CRS系統;到了決賽,主辦方另外提供專用的環境與獨立預算,挑戰期間如超出Azure預算上限,之後的提交將不計入得分。

以LLM訂閱預算而言,這方面來源,主要由Anthropic、Google、OpenAI各贊助35萬美元的運用額度,由主辦方統一發放API金鑰,供各隊使用Claude、Gemini、GPT等模型。而在決賽中,每隊LLM使用配額是5萬美元,若是超出,該隊後續提交成果也不列入得分。

換言之,這項預算制度不僅確保了競賽的公平,並期盼參賽隊伍在可控成本內,驗證AI自動推理系統的實際效能與可擴展性。

整體而言,為了解決潛在漏洞問題,過去模糊測試(Fuzzing)技術已經帶來幫助,最近幾年,隨著LLM與生成式AI技術迅速發展,我們更需運用AI技術,找出連Fuzzing也難以發現的深層漏洞。

回顧AIxCC半決賽到決賽的結果,我們很高興可以看到,合成漏洞發現率已經顯著提升,從37%到77%,這證明了AI的巨大潛力。然而,這份成果也提醒我們,未來仍有巨大的空間等待我們去開拓和突破。

同時,全球產業亦相當重視修補過程中的「速度」、「成本」與「品質」,這些關鍵要素的進展,將讓AI自動發現漏洞更具備實務價值,一旦做到比人工方式更快、更便宜,而且更準確可靠,才真正能為世界帶來改變,這正是接下來我們要持續努力的方向。

從CGC到AIxCC,自動化防禦邁向新世代

早在AIxCC挑戰賽出現的10年前,美國國防高等研究計畫署(DARPA)曾在2014年宣布舉辦「Cyber Grand Challenge(CGC)」,這是全球第一個以全自動資安防禦系統為目標的競賽,目的在於推動機器在無人干預的情況下,能夠分析推理漏洞與制定修補。

當時CGC競賽被視為一次大膽的實驗:主辦方設定理論上可行、但實際上極具挑戰性的問題──設想電腦是否能在沒有人類介入下,主動找出軟體弱點並進行防禦。2016年決賽就是全自動、電腦對電腦的CTF奪旗賽,讓參賽系統自動攻防、修補漏洞,展現了自動化防禦的雛形。

不過,與今日相比,當時CGC挑戰賽的參賽團隊,運用技術主要聚焦採用符號執行(Symbolic Execution),以及模糊測試(Fuzzing)等作為核心。

而在2023年啟動的AI網路挑戰賽(AIxCC),是在既有技術發展上,並將重點轉向於引入LLM、生成式AI,期望這項賽事能探索利用這些最新技術,進而發現更深層的漏洞並生成修補方案。

甚至到了2025年決賽進行期間,還有AI代理(Agent)的全新應用出爐,而這樣的演進也呼應參賽隊伍的CRS系統,逐步朝向具備自主分析能力的自主代理(autonomous agents)方向發展。

熱門新聞

2026-03-06

2026-03-11

2026-03-06

2026-03-10