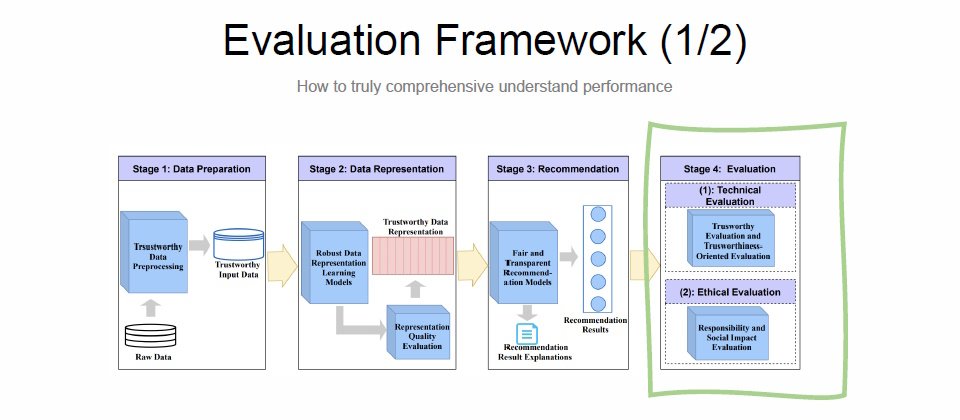

Line臺灣打造一套可信任框架,來確保AI系統穩健、公平且可解釋,其購物推薦系統也是在該框架下展開,主要瞄準資料準備、資料表徵、推薦生成和效能評估4大階段。(圖片來源/Line)

一套AI系統不只要能解決商業問題,還要能獲得業務團隊信任且合規。因此,Line臺灣打造一套可信任評估框架,來讓自家模型更強健且可解釋,就算是不懂技術的業務團隊,也能解讀模型。Line購物有套精密的機器學習(ML)推薦系統Brickmaster,就在這個框架下展開。

可信任含3大元素,鎖定4大推薦流程

這個「可信任」,包含了3項重要元素。Line臺灣電商資料科學家陳峻廷指出,首先是穩健性(Robustness),當購物平臺的商品,帶有誇大推銷說詞時,推薦系統要能夠偵測、剔除這些商品;又或是能辨別、找出有價值的評論,來推薦商品。

再來是公平性(Fairness),重點要移除偏差(Bias)。舉例來說,若使用者不小心點擊沒興趣的Line官方帳號內容,這樣的資料,就不能輸入推薦模型,以免推薦錯誤商品給使用者。因此,開發團隊從資料處理下手,移除這類偏差,確保推薦系統的推薦不受干擾。

第三個元素是透明性/可解釋性,指的是不論業務團隊還是利害關係人,都能了解ML模型資訊,甚至是特徵、推薦系統如何運作等。「這個元素對資料科學家和機器學習工程師來說很重要,」陳峻廷解釋,透明性/可解釋性能幫助團隊採用更好的微調方法,來降低部署模型的信任風險。

陳峻廷指出,這個可信任框架會落實到推薦系統的4個運作階段中,包括資料準備、資料表徵(Representation)、推薦內容生成,到效能評估階段。

實務解析可信任框架

首先,在資料準備階段,為確保訓練模型的資料乾淨且有效,Line團隊設置可信任資料前處理方法,來過濾原始資料,比如偵測異常資料、移除異常值等。

過濾後的資料,就成為可信任的輸入資料,進入第二階段資料表徵處理。由於Line購物推薦系統採雙塔模型,也就是兩套類神經網路,各自處理使用者特徵和商品特徵,再計算兩者嵌入向量的相似度,來從千萬級商品庫中,選出用戶感興趣的推薦商品清單。為確保使用者向量和商品向量的可信任程度,Line設置一套向量品質檢測機制,來檢查模型產生的向量是否達標。

下一階段,用模型產生推薦內容時,Line也設置了公平和透明機制,來確保模型推薦的內容,不會偏重某一族群或商品,並同步產出推薦結果解釋,來落實模型透明性。

最後則是評估,也是陳峻廷認為最重要的環節。在Line臺灣,可信任評估分為2大方向,一是技術面評估,由電商團隊負責,另一是倫理面評估,如責任和社會影響性評估,則由其他團隊負責。

從技術來看,Line還將可信任評估,細分為離線和線上兩種作法。其中,當推薦系統產生新場景時,會先啟動離線評估,來衡量是否合規,通過後再進行線上評估,沒問題才能部署上架。只要其中一類評估沒有合規,就退回檢查模型或特徵工程處理。

陳峻廷點出,正因為這些評估機制,ML工程師和資料科學家在演算法的設計階段,會多想一步,盡可能滿足公平透明、可解釋要求,在源頭先做好可信任工作。

離線評估是實戰前的演練

在兩種評估作法上,離線評估屬於事前的演練。

這個離線評估,主要檢視3類對象,包括模型、商業表現和推薦系統整體健康度。模型部分是根據模型性質,如基於準確度或排名,來設置檢驗指標,像是精確度、召回率、NDCG等,來檢測模型能力。

商業表現部分則檢視ML演算法,能否反映商業價值,如此才能說服業務團隊接受推薦系統。因此,要評估的面向有留客、新客推薦、收益,各自又有其指標,如點擊率(CTR)、客戶體驗的淨推薦值(NPS)、訂單轉換率(CVR)和商品交易總額(GMV)等。

這類商業指標很多,但通常,「我們會設定可快速驗證的指標,如CTR,來確認推薦系統是否可行,」來快速衡量ML系統是否滿足商業問題。

至於推薦系統整體健康度,則要檢視推薦系統能否長期運作。因此,檢視指標有推薦內容涵蓋範圍和多樣性,前者是指,推薦商品與全站商品的比重,比如是否只偏重熱門商品;多樣性則是指,推薦內容是否夠多元、而非偏重單一類商品,如只推薦咖啡。

實戰測驗:線上評估

「離線評估若是打怪練等,線上評估就是實戰實打,是最重要且直接的方式,測試推薦系統是否正確。」陳峻廷進一步解釋,線上評估像是一場AB測試,包含8個步驟,第一步是設置目標,該目標要明確易懂,比如新演算法是否比上一代好。接著是設置指標,找出合適的驗證指標,如點擊率、留客率、訂單轉換率等,正式採用前,還要進行AA測試,來驗證指標上線後的衡量效度。訂妥指標後,接著要決定實驗單位,比如以使用者ID當作最小實驗單位。

下一步是預估採樣大小,可透過數據分析指標α、Power、Variance等來設定採樣大小。陳峻廷提醒,這個階段要留意最小成功指標,比如新演算法的點擊率最少要比舊方法高出2%,才能算成功。

採樣預估完成後,進入隨機分組階段,將流量隨機分配到實驗組和對照組,各50%,來觀察新舊方法表現。陳峻廷表示,這個階段要注意兩組的獨立性,否則會評估失效。

最後還有幾個步驟,包括估算時間、展開活動和結果測試。以上這8個步驟就是Line推薦模型所用的線上評估方法。

如何解決線上評估的實務挑戰

發展這套線上評估的過程中,Line團隊曾遇過不少實務挑戰。陳峻廷舉例,實驗結果差異性不顯著就是一大挑戰,有兩種可能原因,一是新方法確實不好,二是有差異但不夠顯著,可透過擴大資料集規模來觀察,或是降低指標變異數,比如替換相似但變異數較小的指標,或是進行傾向分數配對(PSM)分析。

另一個實務問題是樣本比率偏差(SRM),也就是AB測試時,若後端或API出現問題,導致組別數字差異越來越大,進而出現辛普森悖論,即分組數據和整體數據呈現相反趨勢,造成實驗失效。

還有一項挑戰是新奇效應(Novelty effect),較常發生在業務場景,比如一個新的使用者介面,剛推出時成功吸引到使用者目光,一直點擊使用,但長期下來,效果趨於平緩,甚至不如剛上線時。這情況也可能相反,比如新功能上線初期可能不受喜愛,但用戶群忠實度高、最終還是會使用,長期下來,商業指標會是上升。

LLM也能用來解釋模型

近年風生水起的大型語言模型(LLM),Line也積極用這項技術,來強化購物推薦系統的可信任程度。

第一個LLM應用場景是特徵工程,工程師對LLM下提示,要求執行字符化(Tokenization)工作。陳峻廷指出,這個作法很有效,可幫助Line更好地萃取商品規格等關鍵資訊、加速後續向量生成,甚至比原本的BERT模型方法還要好。為了驗證這些向量的品質,他們採取探測(Probing)方式,從推薦系統的雙塔模型,設計探針來取得使用者向量和商品向量,再以RankMe等指標來評估向量品質。

另一個使用LLM的地方是雙塔模型的解釋,比如將使用者特徵和商品特徵分別輸入LLM,再進行分數和解釋設定,就能得出結果,以此來驗證推薦系統。這就是Line以LLM強化可解釋性的作法。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-09