Nvidia

Nvidia在本周舉行的Nvidia GTC開發者大會上,發表了新一代的GPU架構Blackwell,基於該架構的B100與B200兩款GPU,結合兩個B200及一個Nvidia Grace CPU打造而成的超級晶片GB200 Grace Blackwell Superchip,以及以GB200為核心的GB200 NVL72資料中心機架系統,同時宣稱此一機架系統將可提供兆級數量參數的大型語言模型(LLM)訓練及即時推論。

GB200 NVL72為支援多節點與液冷的機架系統,專為密集運算任務所設計,它結合了36個GB200,等同於採用72個B200 GPU與36個Grace CPU,晶片間以第5代的NVLink互連,並導入Nvidia的BlueField-3資料處理單元,可於超大規模的AI雲端中實現網路加速、組合儲存、零信任安全,以及彈性的GPU運算能力。

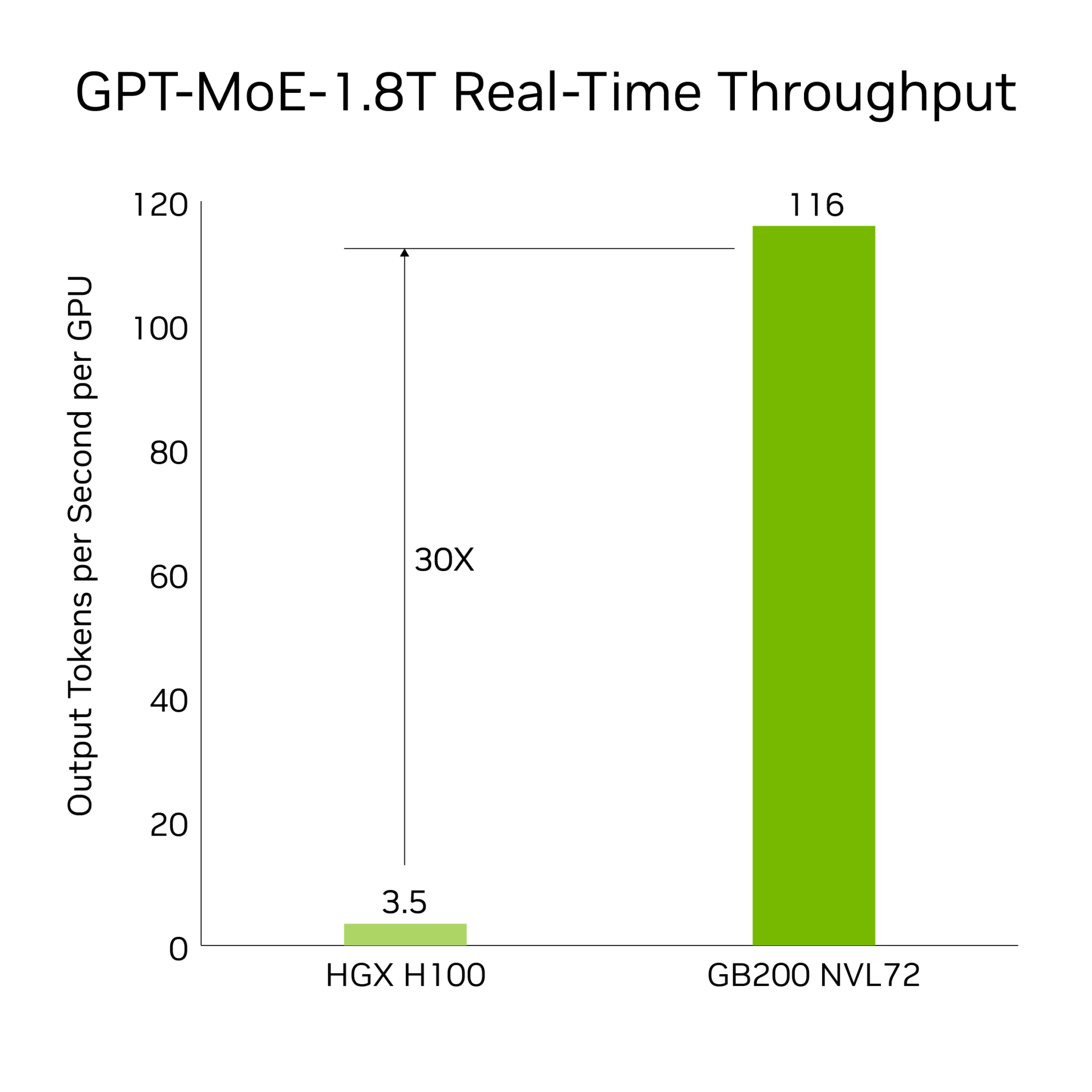

相較於基於前一代Hopper架構、數量相同的H100 GPU,GB200 NVL72在LLM訓練效能上快了4倍;推論任務上的效能提高了30倍;由於整合了新的解壓縮引擎,加速了綁定記憶體的核心操作,使得它在查詢基準測試上比英特爾CPU Sapphire Rapids快了18倍,也比H100 GPU快了6倍。

圖片來源/Nvidia

Nvidia解釋,在單一NVLink網域上連接了72個GB200,減少了於傳統網路上擴展的通訊負擔,因而可以針對具備1.8兆個參數的專家混合大型語言模型進行即時推論,且訓練這類模型的速度也增快了4倍。

此外,GB200 NVL72利用銅製電纜盒密集封裝與連接GPU以簡化操作,並採用液體冷卻設計,使其成本與電力使用減少了25倍。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-03