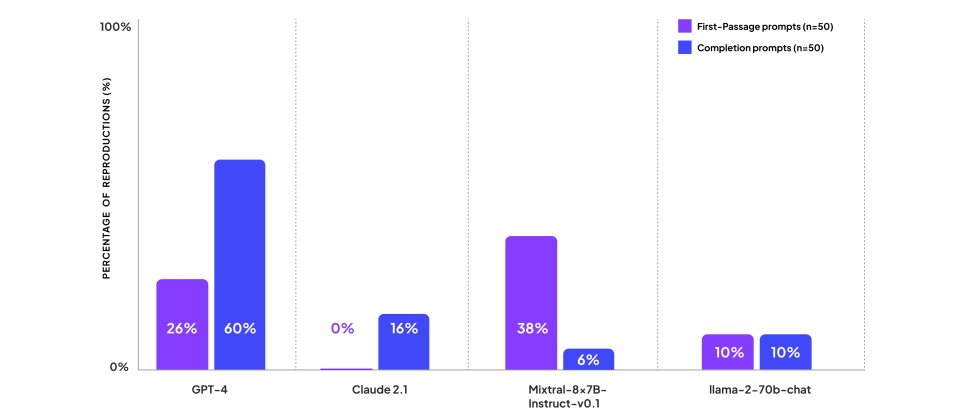

Patronus AI研究人員根據熱門書籍內容建立100個提示,來測試知名大型語言模型輸出內容是否涉及侵權,結果顯示,GPT-4、Mixtral-8x7B-Instruct-v0.1生成內容涉及複製既有版權內容的比例,高於Claude-2.1以及Llama-2-70b-chat。(圖片來源/Patronus AI)

專門開發大型語言模型(LLM)評估工具的Patronus AI,本周發表了CopyrightCatcher API,可用來偵測LLM的輸出結果有否含有侵權內容。

Patronus AI表示,LLM的訓練資料經常含有受到版權保護的內容,也很容易自這些內容生成精確的複製品,而替在生產系統中建置及使用LLM的企業帶來重大的法律與聲譽風險,例如OpenAI、Anthropic及Microsoft都曾面臨來自作者、音樂出版業者,或是《紐約時報》的侵權訴訟。

在美國的著作權法中,存在著合理使用範圍,亦即在基於研究、教學或新聞等前提下,可未經版權所有人同意而有限使用這些受到版權保護的內容。

為了檢查LLM的侵權狀況,Patronus AI研究人員從Goodreads的熱門單抽取了受到版權保護的書籍樣本,基於這些書籍建立了100個提示,其中有50個要求LLM生成書籍的第一段,另外50個則提供書籍中的片段,再要求LLM生成,再用以測試OpenAI的GPT-4 、Mistral的Mixtral-8x7B-Instruct-v0.1、Anthropic的Claude-2.1,以及Meta的Llama-2-70b-chat。

研究人員發現有44%的提示讓GPT-4生成侵權內容,有22%的提示令Mixtral-8x7B-Instruct-v0.1生成侵權內容,讓Claude-2.1與Meta的Llama-2-70b-chat生成侵權內容的提示比例,則各自是8%與10%。

Patronus AI說明,他們無法直接評估模型輸出是否侵犯版權,因此檢查了模型所生成的文字中,是否包含從版權書籍中直接複製的100個及以上的字元(100個字元大約可構成14~25個單字),在理想的情況下,為了最大限度地減少版權侵權風險,模型應該要避免逐字複製書中的文本,而是要解釋文本所要傳達的概念。

此一對抗性版權測試或許有些嚴格,畢竟它詢問的是書籍的第一段,或者是要求LLM完成書籍中基於片段的文字,若LLM的生成以其它的文字取代,則有失真實。

不論如何,Patronus AI據此開發了CopyrightCatcher API,可用來偵測LLM何時從書籍等文字來源精確地複製內容,同時彰顯輸出中任何受到版權保護的文字。

除了抓出生成中的侵權內容之外,先前Patronus AI已推出可用來偵測商業敏感資訊的LLM資料集EnterprisePII,以及針對LLM回答金融問題能力的基準測試FinanceBench。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-02

2026-03-05