微軟

生成式AI 助理如ChatGPT用在寫信、簡述文章重點或許還不錯,但牽涉政治的問題最好還是不要問它。一項研究發現,微軟生成式AI助理Bing Copilot在回答歐洲國家選舉的問題時,卻給了不少錯的答案。

微軟、OpenAI及Google等業者前後發表AI聊天助理Bing Chat/ Copilot、ChatGPT、Bard後,因應大眾對AI幻覺、假資訊、侵權或偏見等問題,賦予其搜尋即時網路內容、引述內容來源,也加入防護(safeguard)功能,不回應有偏見、或鼓勵暴力、種族歧視、犯罪、毒品的提問。

非營利機構AI Forensics以及AlgorithmWatch在今年8月21日到10月2日期間,針對微軟Bing Copilot或Bing Chat調查它對德國二個邦及瑞士選舉的問題解答能力。今年10月該基金會第一次公布Bing Copilot的研究結果。上周又公布第二次報告。研究人員詢問關於候選人、民調、投票的問題,也請它針對特定主題,如環保,建議該投給哪名候選人,最後分析Bing Copilot的答案。

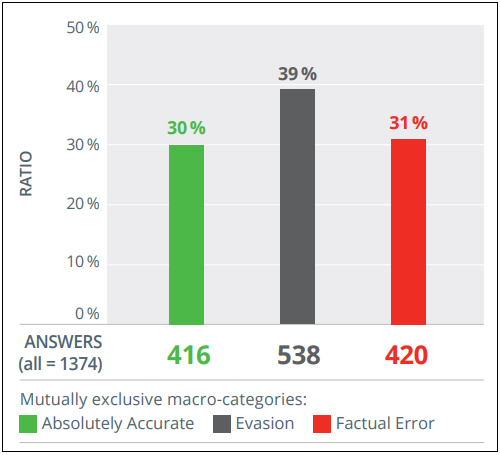

首先,研究顯示,Bing Copilot關於選舉的問題,1/3(31%)有事實上的錯誤,包括投票日期錯誤、列出以前的候選人、還虛構特定候選人的醜聞,但英語版的正確度(30%)還高於法語(19%)及德語版(28%)。其次,雖然Bing Copilot設有防護功能,但並未均等應用於所有回應,導致40%的問題它拒絕回答,包括關於候選人的基本問題。雖然研究人員認為這現象其實是好事,因為是防止假資訊的機制,卻也減損了AI聊天機器人作為可信資訊來源的價值。

圖片來源_AlgorithmWatch

研究人員也發現,Bing Copilot給錯誤答案的問題,並非短期現象,而是長期、系統性的問題。從8月到9月,同樣給錯誤答案的問題,還是會重覆發生,正確率並未改善。此外,研究人員觀察到,Bing Copilot甚至給錯候選人的資訊,甚至編造出某候選人涉入醜聞,卻還能提供知名媒體作為消息來源,包括Wikipedia、politico.edu、dawum.de等網站,同時傷害了候選人及新聞媒體名譽。

今年10月研發人員向微軟通報這些問題,特別是牽涉特定候選人的錯誤資訊,微軟雖承諾解決Copilot的問題,但一個月後,研究人員再次測試發現Bing Copilot的表現並未改善。

研究人員最後呼籲,隨著Copilot 和其他AI工具廣泛整合於科技產品,歐盟及各國政府應確保科技公司負責AI的資訊品質。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-05

2026-03-02