iThome

一年了。

引發各行業日以繼夜創新的ChatGPT,剛滿周年。這一年來,我們看見許多變革,全球掀起了生成式AI的浪潮,這股浪潮也吹進臺灣。在臺灣,大型語言模型(LLM)不只走進各行各業,也開始出現自行打造的繁中版LLM,如聯發科的BLOOM-zh、台智雲的福爾摩沙基礎模型和FFM-Llama 2、臺大陳縕儂師生團隊的Taiwan-LLM,政府更出資逾2億元推動國科會TAIDE計畫,來打造臺版LLM,要供企業和公部門使用。這些成果,代表臺灣在過去一年從0到1發展LLM的軌跡。

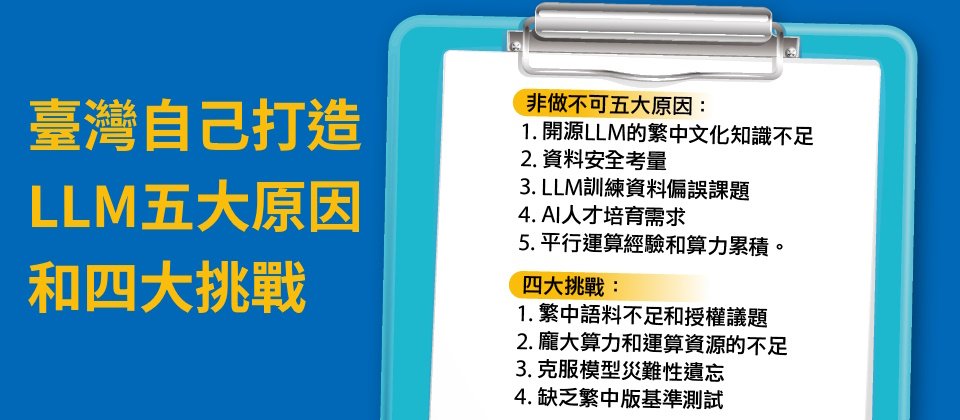

為何臺灣必須有自己的LLM模型?國科會TAIDE計畫負責人李育杰指出,有五大理由。

「文化知識」是第一個原因。由於現有開源LLM所用的中文訓練資料,幾乎以簡中為主,繁中資料占比非常低,比如BLOOM的簡中訓練資料占16.2%、繁中只占0.05%,導致模型學習到的中文知識和回答用語,多以簡中為主。

不只如「土豆」和「馬鈴薯」等生活用語差別,專業術語也有不同。李育杰舉例:「線性代數中,矩陣的行與列,在中國稱為列與行,和臺灣用語相反。」若未事先定義,就會造成誤解。就算以大量簡中資料轉換為繁中資料,用來訓練模型,很可能給出不符國情的回答,例如答錯了「國慶日日期」,正是先前中研院明清研究專用CKIP模型所引發的通用性爭議。這些例子,再次突顯臺灣打造繁中LLM的必要性。

另一個非做不可的原因則是「資料安全」。李育杰說明,使用公開LLM服務,就會有機密洩漏風險。所以,行政院8月底才提出生成式AI參考指引,規範公部門對相關服務的使用。而TAIDE計畫,就是要打造出安全、合規的模型,來供本地使用者落地使用。

再來是「資料偏誤(Data Bias)」因素。這些大型模型的訓練資料多來自公開網路資料,資料分布不均,科技巨頭訓練的LLM多以英文為主,容易產出偏誤答案。最後兩個非做不可的原因是人才培育,以及算力算法經驗累積的考量。臺灣LLM技術人才不多,自己發展LLM,可以由少數專家帶頭,來培養人才具備相關LLM技能,也能趁機累積超級電腦的平行運算經驗,像是TAIDE計畫團隊就與國網中心實作出了專門支援大模型訓練的平行運算工具,未來可供其他團隊參考。

但是,全球生成式AI的馬拉松競賽,才剛鳴槍開跑,未來臺灣想要與各國競爭,讓AI成為臺灣的競爭國力之一,從過去一年的臺灣LLM發展經驗中,可以看到還有許多挑戰有待克服。

繁中語料不足是首要課題

臺灣目前打造LLM的作法,並非從無到有開發一套模型,而是以開源LLM為基礎,透過繁中資料集進行連續預訓練、微調和人工回饋強化學習(RLHF)等步驟,優化出懂臺灣文化和用語的LLM。這是全球AI圈常見的LLM建置方法。

不過,要發展繁中LLM,首先面臨的挑戰是繁中語料不足。這從主流開源模型的訓練資料占比就可看出,例如1,760億參數的BLOOM,繁體中文資料才占0.05%,比例非常低。而且,臺灣目前發展的繁中版LLM,所使用的訓練資料量為數十億至300億個Token,與一般訓練資料量為模型參數的20倍相比,還有進步空間。

繁中語料不足,正是國科會TAIDE計畫面臨且想解決的挑戰。TAIDE的目標是打造符合臺灣文化和用語習慣的LLM,團隊收集了新聞、政府公開資訊和研究資訊、繁中維基百科與學術論文等10種資料,來作為TAIDE模型訓練資料集。同時,他們正與新聞媒體、出版社等機構一一取得授權,要將這些內容,製作為高品質的繁中語料集,並開源釋出來,推動臺灣LLM發展,甚至是整體AI發展。

面對訓練資料量不足,除了爬蟲網路公開資料、仰賴政府開源資料集,還有其他解法嗎?深耕自然語言處理(NLP)數十年的中研院資訊所研究員古倫維認為,已開源的簡中資料量龐大,並非完全不能用,而是要謹慎篩選,剔除不符合臺灣文化的爭議內容、保留共通知識,轉為繁中後可用來擴充訓練資料集。

運算成本是另一挑戰

另一方面,打造LLM還有一大課題要面對:運算成本。以TAIDE計畫為例,光是以70億參數版本的Llama 2為基礎,以繁中資料進行連續預訓練,就得使用超級電腦臺灣杉2號、耗費好幾周才完工。以台智雲經驗來說,他們以千億參數的BLOOM為基礎,使用了1.5TB、包含繁中在內的46種人類語言和13種程式語言訓練資料,也是花費好幾個月,才以臺灣杉2號訓練完成。

這其中,還得靠平行運算技術。比如,台智雲自行摸索3種平行化方法,如資料平行化、工作流程平行化和張量平行化,從中找出最佳切割組合,來讓每張GPU發揮最佳效能,提高訓練效率。他們也因此實現最高調度840片GPU、同時進行平行化運算,完成福爾摩沙大模型的預訓練。而國網中心團隊在協助TAIDE計畫初期,也建置了張量平行化工具,優化超級電腦主機內和主機間的資料傳輸效率,來加速訓練過程。

不過,對一般企業而言,從預訓練階段開始打造繁中LLM,並不符合成本效益。常見的作法是從微調下手,也就是準備少量資料集,來針對特定任務優化模型。比如專門提供AI對話平臺服務的叡揚資訊,就準備了800萬個Token資料來微調LLM,來嘗試發展內部員工專用的Chatbot。

但,微調也分為全參數微調和參數高效能微調(PEFT)兩種,前者是對模型的所有參數來微調,成效較好,也最耗費運算資源。後者則是微調部分參數,通常為模型5%的參數量,來試圖達到全參數微調效果,其運算成本較低,但成效未必理想。對資源有限的一般企業來說,幾乎只能採取PEFT方法,來增強模型表現。

得克服模型災難性遺忘,更需建立繁中測試基準

除了算力,打造LLM基礎模型還有技術問題要注意,其一是災難性遺忘,也就是模型學習新資訊時,忘記已經習得的知識。

常見的解方有訓練資料分布多元化,比如台智雲在打造福爾摩沙大模型和繁中優化的模型FFM-Llama 2時,將訓練資料平均分配,確保每一批訓練資料都涵蓋不同領域的資料,並混合一部分前批的訓練資料,來讓模型均衡學習。

這個概念,就像是學生每周學習不同學科,如數學、語文、歷史、地理,而非第一個月只學數學、第二個月只學歷史,如此考試時,一定會忘記先前學習過的知識。台智雲後來測試模型,驗證了這種方法,可有效降低災難性遺忘,還能保有模型既有的優點。

不只如此,在臺灣發展繁中LLM的這一年中,還有不少專家意識到,臺灣缺乏繁中的基準測試(Benchmark)。古倫維指出,LLM完成預訓練後,通常需要基準測試,來衡量模型的學習成效。比如常見的200種任務測試,其中就有用來衡量自然語言處理能力的GLUE、SuperGLUE等主流基準測試,來評估模型的閱讀理解、翻譯、情感分析等能力。但這些基準測試,並非為繁中模型設計。

她認為,應該要建置專屬基準測試,才能衡量模型的繁中任務處理能力。這也是叡揚資訊創新研發中心副總經理林縣城提出的看法,透過有效的繁中基準測試,才有利於後續應用。

此外,古倫維還點出另一個臺灣發展LLM可思考的課題,也就是應用生態系。因為,LLM要發揮效益、成為好用工具,不單只是模型本身夠好,還需要充足的平臺資源和API生態,比如微調工具,來協助使用者客製化,或是API能串接多種App、與不同系統溝通。

這一年來,臺灣LLM發展順利跨出從0到1的第一步,雖遭遇發展中必經的挑戰,如缺乏繁中語料、運算成本高、需建置繁中基準測試等配套措施,卻也因此開始發展解決對策,像是由國家建置高品質繁中資料集,預計開源釋出來推動臺灣AI發展。

國網中心也因TAIDE計畫而升級算力,繼10月新添72片H100 GPU後,明年還要擴增16PFLOPS的效能算力,更開始規畫建置下一代AI超級電腦。國網中心還擬訂未來計畫,要鼓勵企業與新創提案、使用大算力做好題目,將以非常優惠的價格,甚至免費,來讓提案出眾的企業和新創,使用上百PFLOPS的AI超級電腦算力。

臺灣自己打造LLM五大原因和四大挑戰

非做不可五大原因:

1. 開源LLM的繁中文化知識不足

2. 資料安全考量

3. LLM訓練資料偏誤課題

4. AI人才培育需求

5. 平行運算經驗和算力累積。

四大挑戰:

1. 繁中語料不足和授權議題

2. 龐大算力和運算資源的不足

3. 克服模型災難性遺忘

4. 缺乏繁中版基準測試

資料來源:iThome整理,2023年12月

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-06

2026-03-06