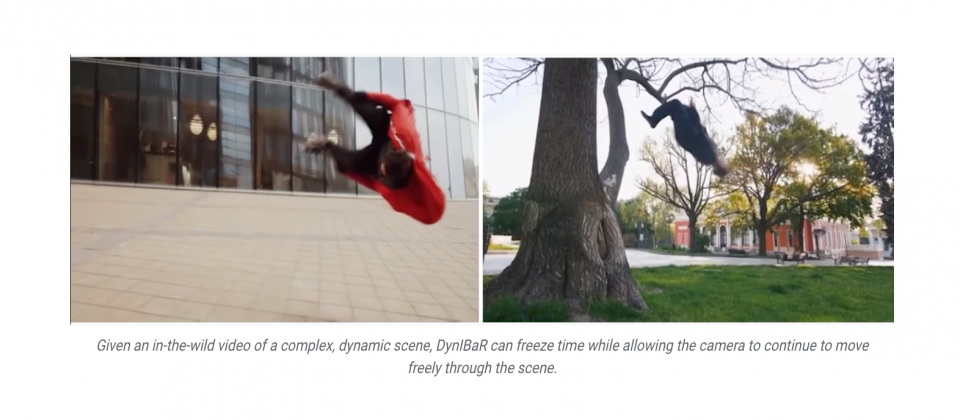

Google開發了一種新的動態影像渲染方法DynIBaR(Neural Dynamic Image-Based Rendering),只要使用單一影片,就可以生成複雜且動態的場景,並以真實自由攝影機視點渲染出新畫面,實現諸如子彈時間、攝影防手震、慢動作甚至是散景(Bokeh)等特效。

由於NeRF(Neural Radiance Fields)技術的發展,開發者能夠重建和渲染靜態3D場景,但是原始的NeRF技術,卻無法處理移動中的場景,3D空間加上時間的4D維度場景重建,無法使用標準影像合成方法。而研究人員也開始琢磨相關的解法,透過動態NeRF方法來處理動態場景影像合成,但這些方法仍然存在局限性,很難從長時間、不受控制的攝影機路徑,還有複雜的物體運動影片中,產生出高品質的新合成圖。

由於這些方法都是把動態複雜的場景,儲存到一個單一的資料結構中,並使用多層感知器(Multilayer Perceptron,MLP)神經網路進行處理,但Google解釋,當影片的長度和場景複雜度上升,神經網路便需要更多的資源處理,這在實際運用上並不可行,導致最終產生的圖像通常模糊且不準確。

而Google新開發的DynIBaR方法不同,也就能避免舊方法所產生的問題。DynIBaR不需要把影片中所有場景內容儲存進一個龐大的多層感知器,而是直接使用輸入影片影格的像素資料來渲染新畫面,也就是説,DynIBaR並不會從頭開始影像創建工作,而是利用已有的像素資料來生成新畫面,像是當用戶想要以一個新視角觀看場景,DynIBaR便會找到跟新角度最像的影片影格,使用該影格中的像素資料運算。

DynIBaR參考原本用於處理靜態場景的IBR(Image-Based Rendering)演算法,並將其擴展用於動態影像。DynIBaR能夠渲染出從不同角度看到的動態場景,在處理動態場景時,DynIBaR會考慮場景中的動作,Google提到,DynIBaR的特色在於只儲存動作資訊,不需要像舊方法一樣儲存整個場景的外觀和幾何資訊,DynIBaR會直接使用輸入的影片影格,找出渲染新畫面所需要的所有資訊。

不過,DynIBaR渲染出來的畫面也不代表就是完美的,仍會存在一些錯誤和不準確的地方,像是顏色失真或是細節丟失等,因此還需要經過調整與最佳化,例如Google使用了跨時渲染技術,能夠利用單一時間點的場景資訊渲染不同時間點的圖像,確保不同時間點的場景資訊一致。同時,透過把場景分成動態和靜態兩部分,分別用不同的方法表示,以更準確地渲染場景,提高渲染的準確性。

DynIBaR的應用很多元,能夠被用於攝影防手震上,相比現有2D和動態NeRF方法,DynIBaR可以生成更加平滑、少瑕疵的結果。同時,DynIBaR也能夠被用於空間和時間影片合成,產生平滑的3D電影效果,生成平滑的5倍慢動作影片。DynIBaR還可用於添加視覺模糊效果,即便是所有焦點都非常清晰的影片,也能動態改變景深生成高品質模糊背景,凸顯場景中的動態和靜態內容。

DynIBaR的重要貢獻在於研究人員提出新的動態影像渲染方法,解決傳統技術在處理動態場景時的限制,並利用原始影片影格生成高品質畫面,Google表示,該技術能夠被用於行動裝置上,提供終端使用者新的影片編輯效果。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-06

2026-03-05

2026-03-02