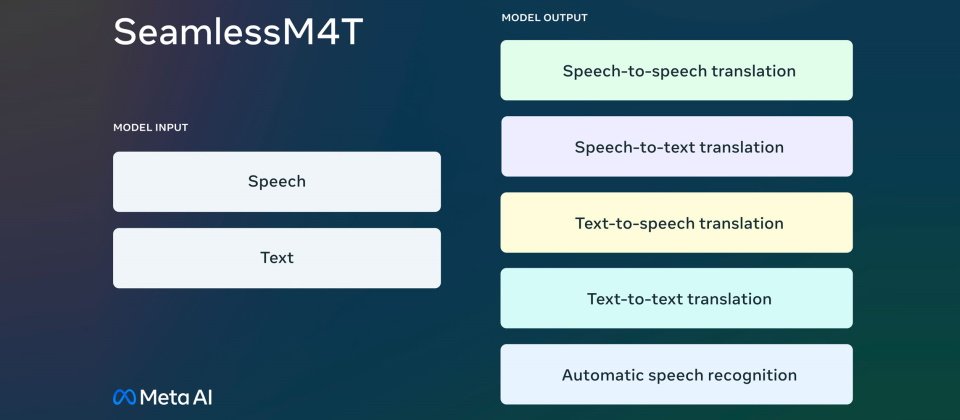

Meta昨(22)日宣布,釋出首個多語多模AI翻譯模型SeamlessM4T,支援將近100種語言之間的文字和語音翻譯。

Meta指出,現有語音到語音,以及語音聽寫(speech-to-text)的AI翻譯工具僅能處理很少量的主流語言,以致於在不同任務上,用戶得使用多個不同的翻譯工具。SeamlessM4T目的在提供涵括多種語言翻譯的單一工具,以單一系統做法減少錯誤率及延遲、提升翻譯效率及品質,協助不同語言用戶更有效溝通。

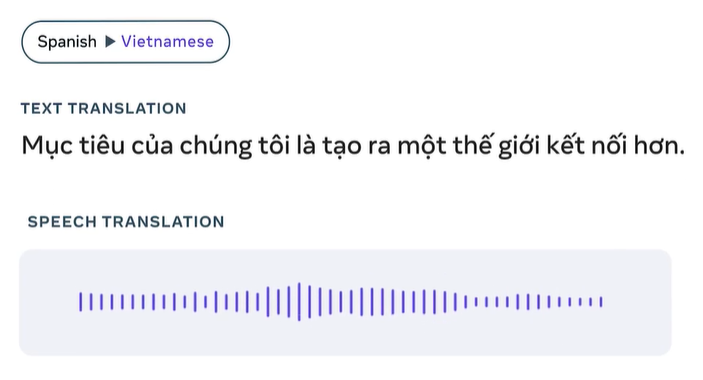

Meta宣稱,SeamlessM4T可支援近100種語言的語音辨識、語音聽寫翻譯(speech-to-text)、以及文字到文字翻譯。而在不同模式切換的翻譯任務中,語音到語音翻譯輸入/輸出端,可支援近100種/36種語言(包括英語)。文字到語音翻譯輸入/輸出端,則支援近100種/35種語言(包括英語)。

SeamlessM4T是Meta打造單一翻譯工具的計畫下的最新成果。2020年,Meta釋出能支援100種語言的AI模型M2M-100,去年又釋出文字到文字機器翻譯模型NLLB(No Language Left Behind)200,能支援200種語言。NLLB 200之後被Wikipedia列為翻譯工具供應商之一。之後,Meta展示通用語音翻譯計畫(Universal Speech Translator)支援閩南語和英文直接口譯的能力,今年春天則公布大量多語語音(Massively Multilingual Speech,MMS)AI模型,可提供1,100多種語言的語音辨識及語音合成。

SeamlessM4T集結了之前計畫的技術元素,運用多種語音資料訓練,將多語言、多模翻譯能力整合至單一模型中。就技術而言,Meta小組重新設計其序列建模工具fairseq,增加建模及資料載入API,並使用能支援語音辨識、聽寫、語音合成、文字對文字的多任務UnitY模型架構為基礎模型,並使用自監督語音編碼器w2v-BERT 2.0進行語音資料預處理,並使用NLLB模型的文字編碼器。在語音合成方面,則運用UnitY模型的語音生成元件T2U(text-to-unit)及HiFi-GAN unit vocoder,產出翻譯後的語音。

為訓練SeamlessM4T,需要大量語音及文字資料。最後專案小組使用了44.3萬小時的語音/文字對,以及2.9萬小時的語音/語音對,支援36種語言,統稱為SeamlessAlign。Meta聲稱,從數量及涵括的語言來看,這組資料集都是當今之冠。

Meta也公開SeamlessM4T模型論文及相關資源,讓研究人員及開發人員也能開發自有語言翻譯應用。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02