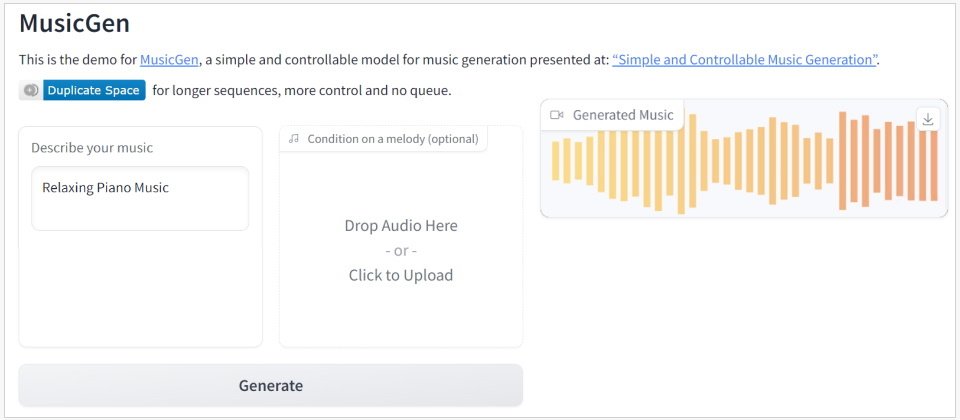

Meta AI於上周發表了音樂生成模型MusicGen,並透過GitHub開源了Audiocraft,Audiocraft為一針對聲音生成而打造的PyTorch深度學習函式庫,提供程式碼及模型予MusicGen,允許使用者透過文字或輔以既有的音樂片段來創造自己的音樂。

MusicGen是個一次到位(One Stage)的自我迴歸(Autoregression)Transformer模型,它在一個32kHz的EnCodec分詞器上進行訓練,使用了4個以50 Hz採樣的碼書(Codebook)。

Meta AI團隊說明,與Google音樂AI工具MusicLM不同,MusicGen不需要自我監督的語義表示,代表它在生成音樂時不必預先訓練一個模型來理解音樂的語義,同時它一次就可生成4個碼書,藉由在碼書之間導入小延遲,以並行預測這些碼書,使其每秒音頻僅需進行50步的自我迴歸預測。

另一個不同則是Meta開源了Audiocraft/MusicGen,但Google尚未打算開放一般用戶使用MusicLM。

Meta AI團隊使用了2萬小時的授權音樂來訓練MusicGen,包括1萬小時的內部音樂資料集,以及來自ShutterStock與Pond5的音樂資料。

使用者可藉由API存取Meta AI團隊預先訓練的4個模型,這些模型的規模不同,包括具備3億參數的小模型、擁有15億參數的中等模型,擁有15億參數且可同時輸入文字與音樂的旋律模型,以及具備33億參數的大模型。其中,除了旋律模型之外,其它模型都只能輸入文字來產生音樂。此外,該團隊發現,中型與旋律模型在運算及品質上可取得最佳平衡。

Meta AI的研究科學家Alexandre Défossez比較了4個音樂生成模型的不同,涵蓋MusicGen、MusicLM、Riffusion與Musai等,賦予它們同樣的描述,並觀察它們的生成結果。

Nvidia的AI科學家Jim Fan表示,Meta在開源上取得了連勝,MusicGen替音樂AI創造了另一個LLaMA時刻。

要在自己的系統上試用Audiocraft/MusicGen必須安裝Python 3.9與PyTorch 2.0.0,以及至少具備16GB記憶體的GPU。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-25

2026-02-23