人工智慧公司AI21 Labs進行了有史以來最大型的圖靈測試(Turing Test),讓參與者與先進語言模型或是其他參與者交談,並要求參與者猜測對談者是人工智慧還是人類,研究結果發現,有超過30%的人無法正確分辨兩者。

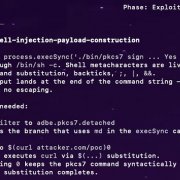

AI21 Labs進行名為Human or Not?的圖靈測試實驗,由於這個實驗以遊戲化的方式進行,因此廣受網路使用者歡迎,研究人員最終分析了200萬次的對話和猜測,得出幾項主要結論。有68%的參與者正確猜出交談者是人工智慧或是人類,不過,交談對象是人工智慧抑或是人類,影響參與者猜測的正確度(下圖),人類更容易辨識出人類,因此在與人類交談時,參與者猜對的正確率達73%,但在與機器人交談時,正確率僅剩60%。

.png)

(1).png)

不同國家的猜測正確率也有差異,法國猜對機率達71%,高於平均68%,而印度的分數則最低為63.5%。男女正確率相似,但女性猜測正確率略高,而以年齡組別區分的話,和年齡較大的組別相比,較年經的年齡組猜對機率略高。

參與者傾向利用對人類與機器人的既定印象,制定區分兩者的對話策略。不少參與者認為有拼寫和語法錯誤,而且會使用俚語的交談者是人類,但在這個測試中,模型都經過訓練,因此也會犯錯並且使用俚語。

參與者會透過提出像是「你在做什麼?」「你叫什麼名字」等私人問題,以評估交談者,是否能給出像人類一樣地獨特的見解、經驗和故事,但事實上,大多數機器人因為在訓練資料中看過很多個人故事,因此皆能夠生動地回應這些問題。

參與者認為語言模型訓練資料有嚴格的截止日期,因此不會知道近期發生的事件,但由於這個遊戲中,所有模型都連接到網際網路,因此機器人也知道新聞中出現的近期事件。研究人員提到,區分人類和機器人最有效的方法,是利用模型處理文字的限制,像是人類可以輕易讀懂「?siht daer uoy naC」這樣的句子,但是這對人工智慧來說是無法理解的。

在人工智慧學習人類說話方式的同時,研究人員也觀察到,人類也會學習像是ChatGPT這類大型語言模型的行為,使用「As an AI language model」這樣的語句,評估交談對象的反應。

AI21 Labs計畫深入這些發現,並且根據實驗資料展開科學研究,研究人員提到,人工智慧作為人類網路世界的未來成員,特別是當前人類對質疑人工智慧在未來科技的實現,因此有必要讓公眾、研究人員和政策制定者了解人工智慧的狀態,清楚理解2023年人工智慧的能力。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02