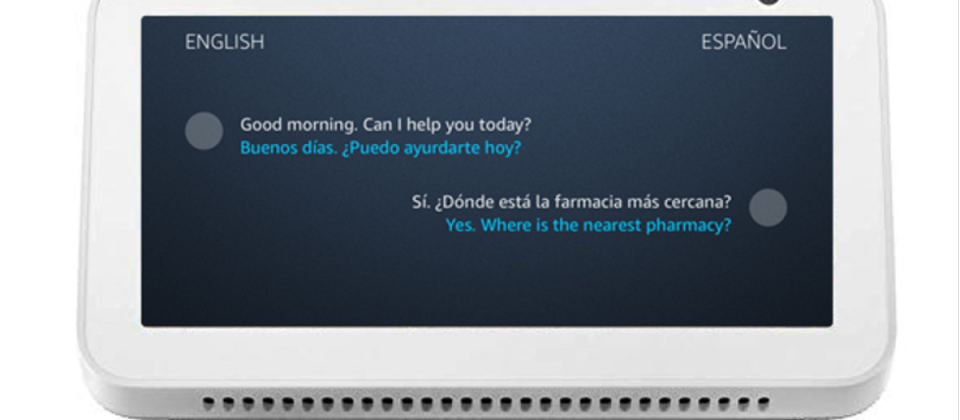

Amazon現在於語音助理Alexa上推出即時翻譯功能,讓Alexa能夠充當口譯員的角色,幫助使用兩種不同語言的使用者,進行溝通與交流。使用者可以要求Alexa啟動兩種語言的翻譯功能,用戶使用任一語言所說的句子,Alexa能夠自動辨識,並且翻譯成另外一方的語言。

即時翻譯功能利用了數種現有Amazon系統,包括Alexa自動語音辨識(ASR)系統、Amazon翻譯以及Alexa文字轉語音系統。在翻譯階段,Alexa會同時執行兩個ASR模型,以及一個用來判斷語言的獨立模型,輸入的語音會同時傳給兩個ASR模型,但依據語言判斷模型的分類結果,最後只會有一個ASR模型的輸出,會發送至翻譯引擎。

Amazon提到,為了要讓翻譯請求的等待時間,維持在使用者可以接受的情況,必須要平行執行多個模型,因為如果要等到語言辨識模型回傳結果,則翻譯語音將會有很大的延遲。當語言辨識系統選擇了一種語言後,關聯的ASR輸出,便會被送往Amazon翻譯進行處理,最終的翻譯結果會被送回Alexa,並以文字轉語音系統播放。

Amazon所使用的ASR模型,同時包含了聲音模型(Acoustic Model)以及語言模型,聲音模型會將音訊轉成音位(Phoneme),這是人類語言中,能夠區別意義的最小聲音單位,而語言模型則是對特定單詞的機率進行編碼,用來輔助ASR系統對相同音位序列,做出翻譯選擇。而語言模型又包含了兩種類型的模型,分別是傳統語言模型和神經語言模型,比起之前Alexa所使用的ASR模型,即時翻譯所使用的語言模型,可以處理更多話題的對話性語音。

目前Amazon還在改進即時翻譯功能,嘗試使用半監督式學習,來提升翻譯的品質,而且為了提高翻譯的流暢性,以及口語輸入的強健性,Amazon也正在研究將對話性語音資料,應用到神經機器翻譯引擎,並產生包括語境的翻譯結果,像是語調或是非正式的翻譯,對口語或是慣用語將有更全面的支援。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-06

2026-03-09