DeepQ

重點新聞(0424~0430)

臺北慈濟醫院 VR模擬 武漢肺炎

臺北慈濟聯手急重症模擬醫學會,不只用VR模擬肺炎照護還可開發AI虛擬教師

受武漢肺炎(COVID-19)疫情影響,許多國家照護能量告急。為在低風險條件下,提高武漢肺炎患者照護力,臺北慈濟聯手臺灣急重症模擬醫學會,利用SimX COVID-19 VR臨床照護訓練應用,打造COVID-19 VR醫學模擬訓練中心,讓醫學生學習篩檢、隔離到臨床照護等作業。

這套臨床照護VR應用,在世界頂尖的梅約醫學中心、史丹佛大學和美國空軍都採用,這次由HTC醫療健康事業部DeepQ引進臺灣。臺北慈濟醫院急診部主任楊久滕指出,過去醫事人員只能透過影片和書本,來想像武漢肺炎病人情況和應對照護流程,但透過VR,可在虛擬篩檢站和隔離病房內,學習和訓練正確的照護流程,且能即時與臨床教師討論。 DeepQ也指出,未來累積大量的學生學習數據後,也可用來開發AI虛擬教師,協助學生學習。(詳全文)

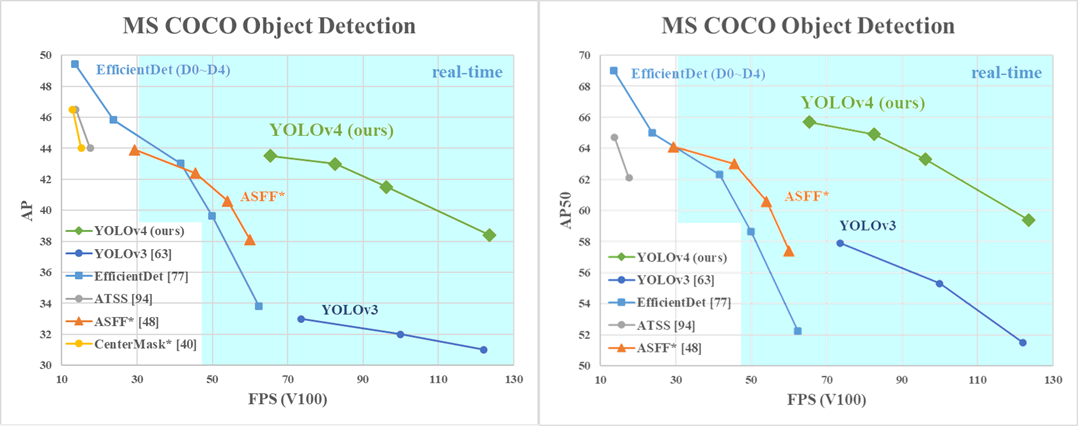

YOLO v4 電腦視覺 物件偵測

物件偵測類神經網路YOLO v4來了!新版更快又更準

即時物件偵測模型YOLO自2016年問世以來,就深受開發者喜愛,可產出快速、準確的辨識結果。雖然今年初,YOLO之父Joseph Redmon宣布退出電腦視覺界,社群擔心YOLO就此停擺,好在日前YOLO在GitHub上釋出最新版模型YOLO v4。

比起前一代,v4版可讓使用者擁有旗艦版GPU(1080 Ti或2080 Ti)般的算力,來訓練一個快又精準的模型,此外,新版也驗證了物件偵測訓練的優化方法,如Bag-of-Freebies和Bag-of-Specials。最後,新版也改善了時下熱門的訓練方法,包括CBN、PAN等,讓單一GPU訓練更有效率。經測試,新版在COCO資料集上達43.5%AP值(平均精確值),在Tesla V100上的即時運算速度可達每秒65幀,比目前最好的模型更快、更精準。(詳全文)

吳恩達 社交距離 行人辨識

社交距離怎麼抓?吳恩達揭露新方法

受到武漢肺炎(COVID-19)疫情影響,各國紛紛祭出社交距離規範,要來降低感染風險。為此,吳恩達團隊也以科技防疫,開發一套AI工具,可從監視錄影中,即時估算人與人之間的距離。

這套工具可分為三步驟,首先是校正(Calibration),也就是將任意角度拍攝的監視器畫面,轉換為由上而下的鳥瞰圖,系統藉這個方法,來測量畫面與現實世界的距離比例。再來是偵測,團隊用開源的Faster R-CNN行人偵測模型,來自動將監視器畫面中的行人,以邊界框標註。最後,則是根據這些邊界框,在鳥瞰圖中測量行人的x、y軸座標,來計算人與人之間的水平距離。對於未保持距離的行人,系統會在這些人間畫一條紅色水平線,來凸顯問題。(詳全文)

動物森友會 視訊會議 AI學術會議

另類視訊會議!研究員將於動物森友會另闢島嶼,來舉辦AI學術研討會

任天堂線上遊戲動物森友會因疫情大受歡迎,近日矽谷一家AI新創Artie的自然語言研究總監Josh Eisenberg宣布,要在遊戲中另闢全新島嶼,來進行AI學術研討會(ACAI),即日起開始徵件AI論文摘要,至6月12日止,會議將於7月23日舉辦。

Josh Eisenberg指出,因疫情關係,許多實體會議都改為線上,但卻少了互動和交流。為此,他想利用線上遊戲角色扮演的情境,來增加互動。主辦方接受各種AI主題論文,但特別歡迎與敘述運算模型、語音辨識、電腦視覺、對話式AI、電玩AI等相關的主題。

之後,成功入選這場AI學術研討會的論文作者,可以自己的角色進入動物森友會,來與參與者互動、解說,要是沒有動物森友會帳號,主辦方也將幫忙創辦。在研討會中,每個議程為15分鐘,其中5分鐘為現場問答。與此同時,主辦方也會透過Zoom,來即時分享主講者的演講和簡報。(詳全文)

翻譯服務 性別偏差 機器學習

降低性別偏差!Google更新翻譯服務

Google近日更新翻譯服務,使用新方法來解決翻譯上的性別偏差。這個新方法目前用於英文到西班牙文的翻譯,未來將擴充至更多語言。過去,Google為一些語言提供性別翻譯功能,但隨著提供性別翻譯服務的語言增加,舊方法出現擴展和低召回率問題。

為此,Google採用重寫方法,來改善性別翻譯的品質。也就是先產生初始翻譯,再審查翻譯,當翻譯具有性別用語,則重寫成目標性別翻譯,最後評估精確度。此外,Google也重新產生資料集,來建置新的重寫器。(詳全文)

Cloud 3D照片 深度學習 圖片修復

3D照片新技術能適應輸入圖片複雜度,產生更自然的3D合成圖片

維吉尼亞理工學院開發一套圖像修復模型,可將單個RGB-D圖像,轉換為3D照片。有別於傳統需要多張照片和特殊硬體的技術,研究團隊利用一套CNN演算法,來解決圖片處理的不同問題,其中,新方法不預先固定圖像層數,而是能適應輸入圖片的局部深度資訊複雜度,產生不同數量的圖層。

因此,只要一張RGB-D圖片,團隊的模型就能產出3D照片。之後,團隊也用模型來評估野外拍照的能力,透過雙鏡頭iPhone X拍下的彩圖和深度圖,發現模型能產生比臉書方法更少的偽影。不過,團隊方法在欄杆等複雜場景仍會失誤。(詳全文)

Google 智慧醫療 影像判讀

Google:人為和環境因素會影響醫療影像判讀AI準確度

Google日前公布一項臨床研究,以2017年發表的糖尿病視網膜病變判讀AI和泰國11家眼科診所為對象,發現AI要實用於醫療,還有漫漫長路要走。

這套視網膜病變判讀AI,可利用深度學習從眼底鏡中,判斷視網膜病變程度,準確率達90%。2018年底,Google與泰國合作,將該雲端AI應用於當地眼科。研究員發現,診所環境大幅影響影像品質,比如模糊或太暗,會讓AI視為「不可分級」而拒絕。即使接受,也可能誤判。而11家診所中只有2家有夠暗的攝影場地,Google坦承,將根據這些問題,來加強訓練AI系統。(詳全文)

史丹佛大學 穿戴裝置 疾病預防

科技防疫再一樁!Fitbit聯手史丹佛,要開發早期預警的穿戴裝置AI

Fitbit聯手史丹佛醫學院,要搭配智慧型手錶和其他穿戴式裝置,來開發一套AI模型,偵測COVID-19等病毒感染的早期症狀。首先,團隊利用穿戴裝置蒐集志願者心率、體溫等生理資訊,來訓練一系列演算法,辨識人體免疫系統啟動時的變化,如體溫升高、發燒等。

研究團隊將使用5種品牌的穿戴裝置,包括智慧手錶、智慧戒指等,並訓練5種演算法。這項研究的負責人史丹佛醫學院基因學教授Michael Snyder指出,智慧型手錶等穿戴裝置一天至少可進行25萬次量測,是有效的監測工具。如果演算法經驗證有效,將可即早偵測病毒感染、遏止傳播。(詳全文)

圖片來源/DeepQ、YOLO、Landing.ai、Josh Eisenberg、Google、史丹佛大學

AI趨勢近期新聞

1. PyTorch更新1.5版本釋出開源模型伺服器TorchServe

2. Nvidia與倫敦國王學院合作開源醫療影像用AI框架MONAI

3. 南韓科技龍頭Naver釋出Clova AI最新預訓練模型StarGAN v2和資料集

4. Amazon發表更強大的分散式注意力網路ResNeST

資料來源:iThome整理,2020年4月

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-04

2026-03-02

.JPG)