以GPU加速技術見長的Nvidia,在10月下半舉行的世界行動通訊大會期間,進一步說明邊緣運算平臺EGX發展策略,當中將以GPU單板電腦與伺服器為基礎,運用軟體定義的方式支援人工智慧、物聯網與5G應用,同時也宣布與紅帽、微軟、愛立信等廠商合作,攜手打造從邊緣到雲的創新技術架構。(攝影/李宗翰)

身為GPU供應商之一的Nvidia,致力於影像處理與遊戲體驗的強化,在企業IT領域,他們也陸續支援桌面虛擬化、人工智慧、物聯網、高效能運算(HPC)、雲端服務的應用技術,到了今年,他們更是積極布局電信產業與邊緣運算(Edge Computing)的發展策略,並接連釋出相關消息。

以GPU運算設備與伺服器,結合軟體堆疊架構,建構邊緣運算平臺

舉例來說,在1月底,他們在臺召開Nvidia AI電信產業應用媒體說明會,預告他們藉由GPU與人工智慧技術,協助電信業從既有的4G寬頻行動網路跨越到5G,能夠在業務轉型的過程當中,運用虛擬化網路功能服務(VNF)、軟體定義網路(SDN)的技術,支援多種網路應用,像是一般消費者的網際網路連線、產業應用系統、多媒體與娛樂,以及自動化設備。

到了5月底舉行的臺北國際電腦展,Nvidia突然宣布推出名為EGX的邊緣運算加速運算平臺,當中的硬體部分,囊括了多種GPU整合運算設備,像是Jetson Nano單板電腦、Drive AGX Pegasus車用電腦、採用Nvidia T4推論加速卡的伺服器,而在搭配的軟體環境上,他們推出堆疊架構Edge Stack,包含GPU驅動程式、CUDA-X程式庫、CUDA的Kubernetes外掛程式、CUDA的容器執行元件(container runtime),以及多種容器化AI框架與應用程式(Nvidia容器映像登錄服務NGC)。

為了進一步突顯Nvidia邊緣運算策略的前瞻性,他們參加了10月底舉行的世界行動通訊大會─洛杉磯站(MWC Los Angeles),將EGX定調為邊緣超級運算平臺(Edge Supercomputing Platform),並且基於EGX伺服器、EGX軟體堆疊架構、CUDA-X系列應用軟體加速程式庫的組合,現場展示多種結合人工智慧與物聯網的應用場景,同時也正式宣布投入5G vRAN(虛擬無線電接取網路)的發展。

EGX平臺的架構全貌

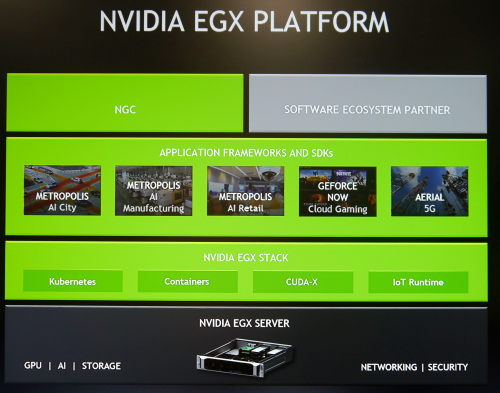

Nvidia在今年MWC Los Angeles大會期間,揭露了EGX平臺的全貌,當中可區分為4個層級:底層的硬體設備是EGX伺服器,上層的軟體依序是EGX Stack、應用程式框架與軟體開發套件、Nvidia提供的容器映像與其他獨立軟體開發商的產品。攝影/李宗翰

該公司創辦人暨執行長黃仁勳表示,他們已經與多家硬體伺服器業者、系統軟體廠商,以及零售、製造等產業,展開密切合作,合力打造專攻邊緣運算的超級電腦平臺EGX。同時,他也宣布與紅帽、微軟、愛立信(Ericsson)等廠商,企圖透過軟體定義的高效能運算技術,積極支援5G網路服務的管理,以及新興AI服務的擴展。

在邊緣運算架構下,提供超級電腦等級效能與豐富的軟體支援

EGX平臺的4種運算設備

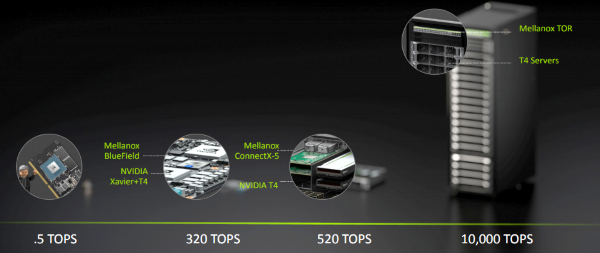

在邊緣運算的硬體設備應用上,Nvidia定義了4種不同運算能力的電腦與伺服器,從體型最小的Jetson Nano單板電腦、Drive AGX Pegasus車用電腦、採用Nvidia T4推論加速卡的伺服器,以及多臺搭配Nvidia T4的伺服器群組。攝影/李宗翰

在物聯網、人工智慧的應用浪潮之下,生活中的許多物品都開始歷經連網化、智慧化的革命,像是機器人、自動駕駛車,逐漸開始普及,黃仁勳認為,我們正處於圖形處理、高效能運算、人工智慧應用的交叉路口,而在深層神經網路技術興起之後,掀起了一連串的人工智慧進化。而在多樣的使用情境中,即便是位於網路邊緣的各種裝置,仍需要就近搭配強大的運算能力來進行處理,而非只能仰賴距離遙遠的企業資料中心或是公有雲服務,於是,這類位於邊緣的高效能運算裝置應運而生。

而Nvidia在今年中推出的EGX平臺,已經先擘畫了運算量由小至大的產品搭配藍圖,對應的效能範圍分別是0.5 TOPS、320 TOPS、520 TOPS、1萬TOPS,已經可以涵蓋到超級電腦的運算等級,或許是這個原因,Nvidia在此次MWC Los Angels大會,對於這樣的架構,給出了新的名稱「EGX Edge Supercomputing Platform」。

根據Nvidia目前最新的規畫,這套邊緣超級電腦平臺的硬體,主要有兩項配備,那就是內建Tensor Core的Nvidia GPU加速卡(T4、Tesla V100),以及具備200GbE連線能力的Mellanox Smart NIC網路卡(ConnectX-6 Dx、BlueField-2),能讓伺服器具備強大的AI運算能力,以及支援NVMe/TCP與RDMA的網路連線方式,同時,也能夠充分應用於雲端原生環境與AI軟體堆疊。

軟體的部份,則由EGX Stack作為底層平臺,當中包含了容器、Kubernetes、網路、儲存、資安、雲端物聯網(Cloud IoT)等技術。而在EGX Stack的上層,可支援CUDA-X系列的程式庫;在更上一層的位置,則是能夠支援光線追蹤、多媒體處理、擴增實境/虛擬實境、人工智慧等應用。

與軟體、雲、電信平臺業者展開合作

EGX平臺的廠商生態系

由Nvidia主導的EGX平臺,串連了不同類型的IT廠商,在底層的部份,眾多伺服器供應商是主力,也有大型雲端服務業者與系統軟體商。攝影/李宗翰

為了跨入5G領域,Nvidia在此次MWC Los Angeles大會上,除了進一步闡釋他們的EGX平臺策略,以及響應的多家伺服器業者,還特別與幾家分屬不同領域的廠商宣布合作。

紅帽

首先宣布進一步合作的對象是紅帽,希望能夠為GPU與AI運算的需求,建構電信等級的雲端原生軟體堆疊架構。

根據Nvidia官方新聞稿與部落格所揭露的最新消息,雙方將會擴大合作,為電信產業提供高效能、軟體定義化的5G無線基礎架構,而且執行在紅帽發展已久的容器服務平臺OpenShift Container Platform,讓業者可以在這之上,自動執行應用程式的部署、規模擴展與管理,以便他們能夠在軟體定義的行動通訊邊緣設備上,來調度指揮與管理5G無線接取網路(RAN)的使用。

為了讓5G業者能夠更順利轉移到雲端原生基礎架構的環境,並且充分因應邊緣設備上的AI應用需求,Nvidia也特別推出了一套專用的軟體開發套件,名為Aerial,能讓電信業者建立完全虛擬化的5G RAN網路,在達到高度可程式化、延展性與能源使用效率的目的之餘,也能協助這些公司提供新的AI服務,跨入智慧城市、智慧工廠、擴增實境/虛擬實境,以及雲端遊戲。

Aerial之所以能夠為電信基礎架構提供更高的運作效能,有幾個關鍵。首先,是可善用Mellanox網路卡直接存取GPU記憶體(GPUDirect),而能透過低延遲的資料路徑傳輸5G封包;其次是提供支援GPU加速的5G實體層訊號處理引擎,系統能夠將所有需要處理的資料放置在GPU高效能記憶體當中。

而這樣的軟體處理機制,都是在Kubernetes的基礎架構之上執行,有了與紅帽的合作,業者就能在該公司提供的企業級Kubernetes容器服務平臺,運用Aerial來進行虛擬化5G RAN環境的管理與自動化作業,同時,也能啟用容器化的網路功能與各式邊緣運算服務,並且依照工作負載的規模變化,來進行隨需部署與管理。

關於邊緣運算應用領域的合作,在Nvidia今年5月底首度提出EGX平臺之際,就已經先宣布與紅帽結盟的消息,雙方合作的主要面向是企業級的應用,由Nvidia發展的Edge Stack軟體堆疊架構,將會整合到紅帽的OpenShift,並且進行最佳化調校。

當時Nvidia表示,該公司旗下全系列AI運算技術,將會整合紅帽OpenShift、Edge Stack,以及Mellanox的SmartNIC與網路交換器,以及Cisco的運算、網路、儲存與資安技術,讓大型企業以安全、快速的方式,部署企業級AI基礎架構,並以「On-Prem AI Cloud-in-a-Box」來稱呼這套解決方案。

微軟

在人工智慧整合邊緣運算的應用上,Nvidia此次活動第二個宣布合作的對象是微軟,旗下雲端服務Azure將與Nvidia EGX平臺緊密整合,推動從邊緣到雲(edge-to-cloud)的人工智慧運算。

舉例來說,微軟Azure IoT Edge、Azure Machine Learning等雲端服務,以及最新推出的Azure Data Box Edge整合應用設備(當中採用Nvidia T4),都能以最佳化的方式,支援執行在EGX平臺的Nvidia Metropolis這套影像分析應用程式框架。相對地,市面上許多通過Nvidia認證的GPU伺服器,在執行Azure IoT Edge與Azure Machine Learning的執行,也能提供最佳化支援。

愛立信

若要推動5G網路的GPU加速應用,與相關的平臺業者合作勢在必行,Nvidia在MWC Los Angeles大會這類電信業特別關注的活動,宣布與愛立信技術合作,讓電信業者建立高效能、高效率與完整的虛擬化5G網路,而能提升訊號處理速度,並且促進新型人工智慧與物聯網服務的推出。

基於這樣的協同合作,可結合愛立信對於RAN網路領域的專業,以及Nvidia擅長的GPU加速平臺、人工智慧與超級電腦技術,雙方希望能在建構虛擬化無線接取網路解決方案的過程中,克服成本、規模、能源效率的挑戰,為其找到商業化的可行作法,提供建置彈性,同時,也期盼能夠協助有志推動擴增實境、虛擬實境與遊戲等新型業務的業者,縮短相關服務上市時間。

以軟體定義擴大GPU應用層面,橫跨邊緣、雲與產業

在過往Nvidia的發展上,絕大多數人僅注意到他們推出的GPU加速技術,若論及提供的軟體服務內容,似乎只是硬體產品的附庸,例如,作業系統驅動程式、系統輔助操作工具,很少人知道他們提供的開發者工具與軟體開發套件,並不僅止於影像內容的設計,這幾年以來,已經延伸到平行運算處理、高效能運算、深度學習與人工智慧,物聯網,以及不同產業專屬的應用。

在企業IT領域,早先我們對於Nvidia的印象,主要是他們與伺服器虛擬化平臺廠商,持續保持合作,像是Citrix、VMware、微軟、Nutanix、Red Hat,這幾年以來,Nvidia積極支援機器學習的開放原始碼軟體,透過NGC容器映像登錄服務,免費提供GPU最佳化的軟體容器,隨後又以此延伸到高效能運算。

此外,對於容器架構與Kubernetes平臺的支援,Nvidia也陸續提供。例如,在前幾年推出的AI整合應用設備DGX-1、DGX-2當中,實際導入他們整合的軟體堆疊架構DGX Software Stack,裡面搭配的就是Docker容器引擎,以及Nvidia Container Runtime for Docker執行元件,讓系統上層得以使用容器化軟體映像,快速建置各種深度學習應用。而關於Kubernetes的支援,也從去年10月起,Nvidia與軟體系統平臺供應商紅帽加強合作,確保企業級Linux作業系統與容器服務平臺,皆能以最佳化的組態支援Nvidia的GPU與AI技術。

在產業應用上,Nvidia支援的範圍也不斷擴大,從影像處理相關的繪圖設計,以及電影、動畫、遊戲,延伸到其他領域。例如,2017年3月,針對智慧城市的視訊監控應用,提供AI影像分析平臺Metropolis;2018年3月,他們宣布推出Isaac SDK的開發工具包,希望能促進自主機器人(Autonomous Machines)的發展與部署;同年9月,Nvidia針對醫療照護場景推出Clara平臺,主打醫療影像的應用,後續也延伸到基因體學(Genomics)的研究。

到了今年,Nvidia憑藉著過去的努力,再加上當前IT趨勢也走向橫跨邊緣運算到雲端服務的架構,他們也抓緊這樣的時機,讓邊緣運算平臺EGX一步步浮上檯面──先是在5月底的臺北國際電腦展期間,宣布符合這個應用概念的單板電腦與伺服器,以及合作的軟硬體廠商;到了10月的MWC Los Angeles大會,可能沒人料到,Nvidia會在這裡闡述更完整的邊緣運算策略,以及他們的5G應用支援,然而,更出乎意外的部份,更在於他們已初步集其大成,並且宣布以軟體定義的邊緣與雲端技術、拉攏更多廠商合作,以及公布實際應用案例,來解釋EGX平臺何以適用於幾個眾所關注的熱門場域,像是5G虛擬化網路功能、智慧城市、延伸實境。

值得注意的是,「軟體定義」一詞,向來是伺服器虛擬化與超融合基礎架構廠商最常強調的概念,如今卻成為EGX平臺能夠發展起來的最佳註腳,無怪乎Nvidia創辦人暨執行長黃仁勳在MWC Los Angeles大會的演講當中,屢屢提及「軟體定義」對他們的啟發。

他也特別以蘋果智慧型手機iPhone成功的典範,說明軟體定義的成效。如同許多人所認知的,iPhone之所以成功,正是因為它充分應用了這個概念,而Nvidia也期盼以iPhone為師,在這一波萬物智能化革命(Smart Everything)的浪潮下,讓EGX這套邊緣運算平臺能夠在市場上大放異彩!

【雲端原生】EGX能否承載所有應用的重大關鍵:軟體堆疊

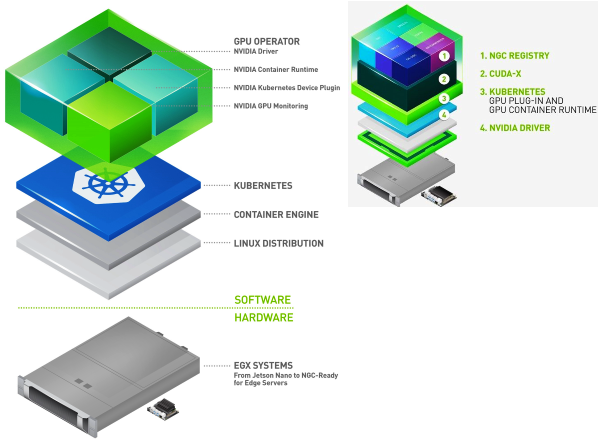

【EGX Stack的演進】右圖是Nvidia在上半年發表EGX加速運算平臺時,所展示的軟體堆疊Edge Stack,至於左圖的架構,則是他們在MWC Los Angeles大會宣布的EGX平臺邊緣超級運算平臺,所提出的軟體堆疊EGX Stack,最大的差別在於引進了GPU Operator的機制,而將原本居於較底層位置執行的Nvidia驅動程式、Container Runtime等元件,提升到Kubernetes之上執行。攝影/李宗翰

由Nvidia提出的邊緣運算平臺EGX,若要普遍應用各種領域,軟體層面能否提供豐富而完整的支援,將是關鍵。而在他們第一波揭露的EGX平臺策略當中,搭配的軟體堆疊稱為Edge Stack,而根據Nvidia最近發布的新消息,這個環節改名為EGX Stack。

若從組成架構來比較,Nvidia對於EGX Stack的整體樣貌,有了更詳細的描繪,而且調整部分軟體元件執行位置。

舉例來說,Edge Stack著重在軟體層的區隔,分成4個部分:Nvidia驅動程式、Kubernetes、CUDA-X系列程式庫、NGC容器映像登錄服務,至於硬體伺服器,並沒有具體描述;而EGX Stack則是分為軟體與硬體,前者的配置也和Edge Stack不同,分為Linux版本、容器引擎、Kubernetes、GPU Operator。

從組成方式來看,Edge Stack的架構,類似Nvidia另一套提供DGX系列整合設備的軟體堆疊DGX Software Stack,從底層到上層,同樣是作業系統、驅動程式、容器引擎/Kubernetes、應用軟體的配置。但到了EGX Stack,則是作業系統、容器引擎/Kubernetes,原本的驅動程式、Container Runtime,以及Kubernetes裝置外掛程式、GPU監控,都整合到GPU Operator,而且是執行在Kubernetes平臺上,而不像Edge Stack執行在Kubernetes平臺之中或之下。

GPU Operator的發展脈絡

其實,關於Nvidia與紅帽近期的密切合作,可追溯至2018年10月,當時宣布了4項消息,其中,有一項是關於OpenShift容器服務平臺,此時正式支援Nvidia DGX-1,Kubernetes社群也開發出裝置外掛(Device plug-ins)的功能,支援硬體加速器的應用,為OpenShift能夠使用GPU提供了執行基礎;最後,由於OpenShift支援GPU加速,因此,也能夠在這套容器服務平臺上,部署NGC雲端服務所提供的軟體容器映像,快速建置多種整合GPU最佳化組態的機器學習框架,像是TensorFlow、Caffe2、PyTorch、MXNe,因此,用戶可以在DGX-1當中執行的OpenShift叢集環境,運用NGC提供的容器映像來設立人工智慧、高效能運算的應用系統。

在今年5月初舉行的Red Hat Summit大會上,紅帽接續宣布更多Nvidia運算平臺通過RHEL的硬體認證,像是Nvidia另一款更高階的AI整合應用設備DGX-2,以及由眾多伺服器廠商搭配Nvidia T4而成的系統,並且預告雙方將會發展出一套共通參考架構,讓OpenShift也能善用Kubernetes的Operator簡化維運機制,自動執行GPU相關的日常管理作業流程,而這個方法稱為GPU Operator。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02