圖片來源:

OpenAI

OpenAI發表一篇論文,呼籲長期的AI系統安全研究,需要社會科學家一同合作,來確保AI演算法在真實人類參與互動的情況下,能夠如人類預期進行,OpenAI指出,與人類密切合作的AI系統,需要解決人類心理上的不確定性,包含推斷、情緒和偏見,OpenAI也預計要聘請社會科學家來一同研究AI的安全性。

AI系統的安全性主要是能夠確保AI系統與人類的價值觀一致,也就是系統能夠可靠地完成人類的指令,而OpenAI則是期望利用詢問人們的意圖,再透過這些資料來訓練機器學習模型,並利用這些學習模型來優化AI系統,不過,人類的回答可能會不太可靠,由於人類有限的知識和推理能力,且還有認知偏差和道德信仰都會導致回答不一致,OpenAI嘗試過用迭代放大( amplification )和討論的方式來找出人類價值觀背後的推理過程,但是還是無法得知真實情況下,人類會如何表現,現在的機器學習演算法還不足以解決這個問題。

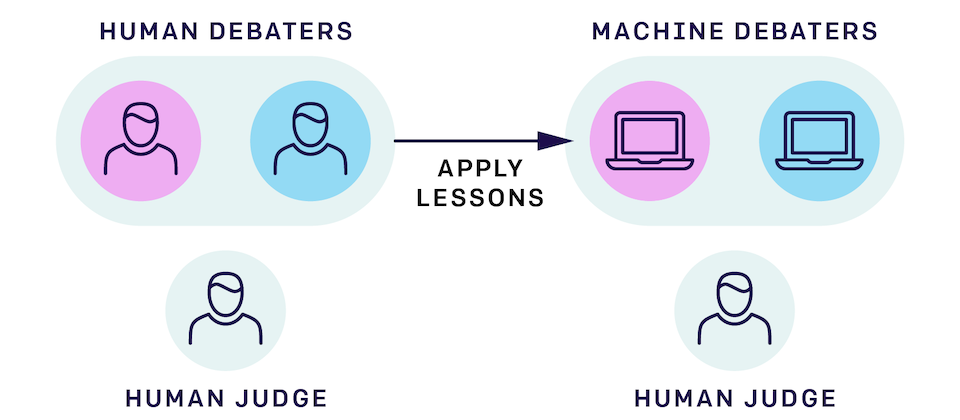

為了避免機器學習的限制,OpenAI採用由人類組成的討論實驗,而不是用機器學習程式代理人,人類針對問題進行討論後,OpenAI再將人類討論中學習到的知識,轉移到機器學習模型中,人類在討論的實驗中,需要利用既有的知識,有效地建立人類是如何思考的過程,也因此,在這個過程中,需要擁有理解人類認知、行為和道德觀相關經驗的社會科學家協助,仔細地設計嚴謹的討論實驗設置,OpenAI認為,社會科學家和機器學習專家密切合作將會讓人類更理解人類與AI系統合作的一面。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

Advertisement