研究發現,人工智慧不只學了人類好的部分,也學了種族與性別歧視等壞的部分,IBM實驗室現在開源了AI Fairness 360(AIF360)工具包,用來減輕人工智慧的學習偏差。

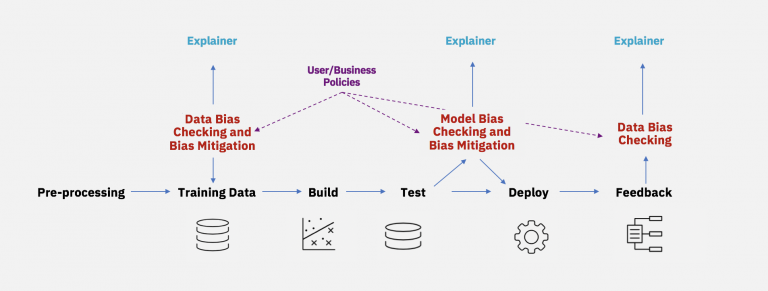

機器學習逐漸可以代替人們做出高風險的決策,IBM提到,雖然機器學習的本質就是一種統計歧視(Statistical Discrimination)的形式,但是當部分擁有特權的群體處於系統優勢的時候,歧視會變得令人反感。機器學習的訓練資料,無論是採樣不足或是過度採樣,甚至標籤存在偏差,最終都會造成不良的模型。

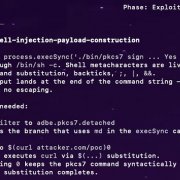

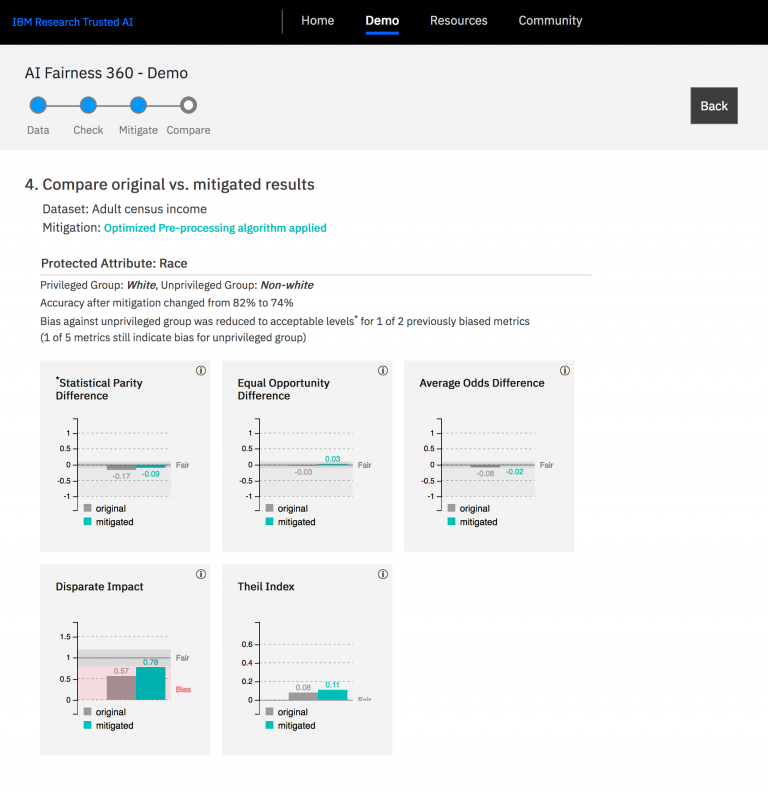

IBM著手修正人工智慧可能存在的偏差問題,現在對外開源AIF360專案,這是一個Python軟體套件,由廣泛的演算法平等研究社群開發,內含有9種不同的演算法,開發者能以類似Scikit-learn函式庫的範式,呼叫使用這些演算法。AIF360不僅僅是提供人工智慧模型的偏差指標,更是提供減輕偏差的方法,並專注於可用性與軟體工程改良上。

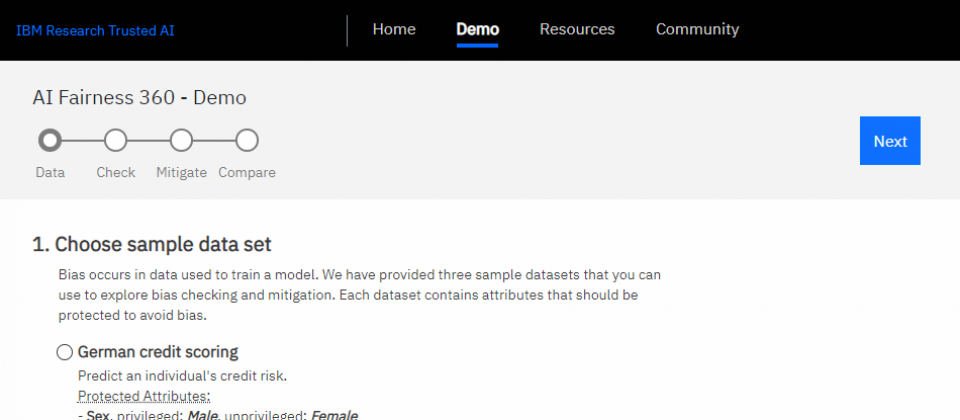

AIF360內建3個範例,領域包括信用評分、預測醫療支出以及以性別分類臉部圖片。IBM表示,雖然他們過去已經在健康保險領域上,與許多客戶合作多年,針對特定人群量身訂做保險方案,但是就從未加入演算法評等研究。而這個結果離真正公平的結果是有一段差距的。

AIF360能以互動式的體驗,引導使用者了解套件的概念以及功能,開發者可能會在一開始對於不同案例使用的指標或是演算法產生困惑,AIF360則會提供參考資料作為引導。IBM期望,透過這個開源專案可以凝聚相關研究人員,並把研究成果轉換成各產業可以使用的解決方案。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02