Nicholas Carlini

就在Alexa、Google Assistant與Siri等數位語音助理正在積極搶佔市場之際,加州柏克萊大學的兩名研究人員Nicholas Carlini與David Wagner發表一研究報告,利用語音對抗樣本(Audio Adversarial Examples)攻擊語音轉文字(speech-to-text)神經網路,只要稍微修改聲音的波形,就能在幾乎不被察覺的狀態下嵌入惡意命令。

Carlini在2016年就曾針對日益興起的語音介面發表隱藏語音命令(Hidden Voice Commands)研究報告,使用人耳聽不見,但語音辨識系統卻能接收的音頻來執行惡意命令。

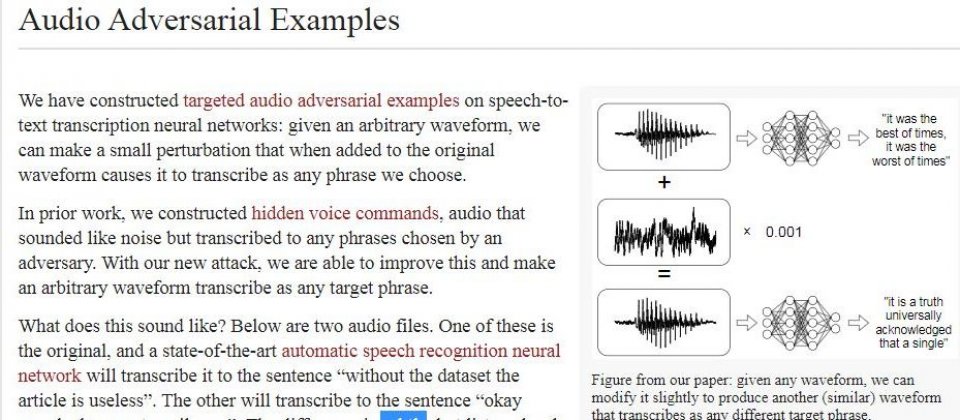

然而,當時研究人員所隱藏的惡意語音命令仍有噪音的感覺,新研究則大幅改善此一缺點,只要些微變更聲音的波形,即可嵌入任何的命令,兩個由人耳聽起來有99.9%相似度的句子,在藉由語音辨識系統解析之後卻是完全不同的語音命令。

研究者提供的示範音頻:兩段聲音在人耳中聽不出太大的差別,例另一段經過變造的聲音卻可讓語音辨識系統分析出別的含意,例如要求語音助理造訪惡意網站。

Carlini與Wagner所打造的攻擊行動不只適用於語音,也能在音樂中嵌入惡意語音命令。想像其可能的攻擊場景,在聆聽網路音樂時,若同時開啟了Echo、Google Home或HomePod,即有機會被駭客植入語音命令;或是在iPhone與Android手機中,讓Siri與Google Now/Google Assistant造訪惡意網站。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-04

2026-03-03

2026-03-02