找出並去除資料中的冗餘

重複資料刪除是一種從資料底層中釜底抽薪的儲存擴充新做法。從檔案的層級看資料,檔案名稱和內容均相同,才能算是重複。用區塊的方式分析資料,將有許多機會找出相同的排列方式,例如具備跨多個檔案比對的能力,並且能從更精細的層級縮減,並非只是檔案壓縮。

重複資料刪除技術的特性

重複資料刪除技術分析資料的方式,由於考慮到資料量的龐大,在實務上通常都是把資料以區塊或區段為單位,並透過Hash函數(或類似函數)的演算,讓系統來執行資料分析與比對的工作。

重複資料刪除技術的類型

依處理流程、運作架構以及對原始資料進行分段方式的不同,重複資料刪除技術有以下幾種不同的區分:從架構上來看,重複資料刪除技術可分在來源端或在目標端執行刪除演算;線上即時處理,或是寫入磁碟後再行處理等。

重複資料刪除產品類型

目前的De-Dupe產品由於架構與技術上的差異,在應用環境、銷售方式與針對客戶群方面也有所不同。依產品類型可分備份軟體、VTL與儲存伺服器等三大類。

重複資料刪除技術能節省多少空間?

所有重複資料刪除技術的供應商,都宣稱他們產品能達到極高的資料刪減比率,保守的講法為20:1~50:1,較聳動的講法則甚至有300:1、500:1等驚人的數字。因此在透過實際測試驗證各產品的資料刪減比率前,有必要先釐清資料刪減比率的涵義。

-------------------------------------------------------------------------------------

五款De-Dupe產品實測

我們這次一共測試了五款應用了De-Dupe技術的產品,分別為Data Domain DD410、EMC Avamar、Falconstor SIR、NetApp A-SIS與Symantec Pure Disk。>>>測試方式

|

Data Domain DD410 DD410是Data Domain儲存伺服器系列中的入門產品,具備儲存容量最佳化技術,可透過拆解與比對資料內容,大幅縮減資料儲存所需媒體容量,使DD410可達到50TB以上容量的儲存效率。 |

|

EMC Avamar EMC Avamar是針對遠端辦公室備份環境,內建重複資料刪除技術的備份軟體,透過前端代理程式的處理,可刪除備份資料中的冗餘,大幅降低備份資料傳輸佔用的網路頻寬。 |

|

FalconStor VTL All in One VTL All in One是一種內含重複資料刪除功能的虛擬磁帶櫃應用伺服器,可將內建硬碟的空間模擬成磁帶設備,供備份軟體作為備份儲存的目的端。 |

|

NetApp A-SIS 先進單實例儲存A-SIS新增的區塊級重複資料刪除功能。使用者可透過手動或排程自動啟動A-SIS,為指定Volume去除冗餘資料,提高空間利用效率。 |

|

Symantec PureDisk 6.2 NetBuckup PureDisk適用於遠端備份環境,內建重複資料刪除功能,可大幅降低資料傳輸所需佔用的頻寬。系統可支援當前多數主流作業平臺,還能支援Exchange與SQL Server等應用程式。 |

不景氣的時代,一個殘酷的現實是:無論企業營運狀況如何,數位資料的持續增加已是無可避免的趨勢,為了傳遞並保存這些資料,企業耗費在儲存媒體與網路頻寬上的資源越來越高。雖然儲存媒體與網路頻寬的成本日益降低,但無限制的購買硬體顯然不是合理的解決辦法。

面對這種趨勢,除了從應用端設法抑制不必要資料的產生外,另一做法就是從儲存端下手,透過虛擬方式讓一份實體資料代表邏輯上好幾份重複的資料,如此便可以刪除不必要留存的重複資料,但又不會影響資料的可用性。這也形同於讓每一單位實體儲存空間,具備原來好幾單位實體空間的儲存效果,使儲存設備超越實體限制,發揮出數倍以上的儲存效率,這就是所謂重複資料刪除(Data de-duplication,簡稱De-Dupe)技術所要達到的目的。

距iThome上一次的重複資料刪除技術專題(247期)已過了一年多的時間,在這段時間內,有更多的廠商投入了這個領域,而從今年年中開始,亦有多款產品在臺灣現身。為檢視目前這類產品的操作性以及資料縮減效果,我們這次針對臺灣市場上幾種應用了重複資料刪除的儲存產品進行了實際測試。在進入測試之前,我們先複習一下重複資料刪除技術的基礎知識。

找出並去除資料中的冗餘

顧名思義,重複資料刪除技術就是找出「重複」的資料並加以刪除,但問題在於何謂「重複」的資料?

從檔案(File)的層級來看,資料有文字文件、資料庫、壓縮與非壓縮圖形、以及影音多媒體等各式各樣不同的類型與格式,只有檔案名稱與內容均完全相同的資料,才會被當作是「重複」,兩份資料即使只有極少數的差異,如把某個Word檔修改一個字並另存新檔,在檔案系統看來就是兩個完全不同的檔案,必須占用兩份獨立的空間。

但從區塊(Block)或更低階的資料底層來看,任何類型資料都是由0與1兩個值的排列所組成,只是結構會因資料類型而有所差異,譬如圖形格式的資料排列會較為離散與不規則。

由於一個8位元的位元組(Bytes)可有256種可能的取值,3個位元組就有1,600多萬種可能的取值,而一個區塊(Block)則由4KB或更大的位元組所組成。這也意味著:若能從資料底層分析比對,即使是兩份就檔案層級看來是完全不同的資料,從區塊或位元組的層級,也有相當高的機率能找出相同的1010101排列。

從資料的不同檢視層級出發,各有不同的非破壞性資料容量縮減技術。

文件特徵等級的壓縮

最傳統的技術是針對單一檔案的壓縮,透過特定演算法比對檔案內的位元組,重複的元素將會被刪除,只留下一個指針,如存在多年的ZIP即是利用一份檔案中「短語重複」以及「單位元組重複」進行壓縮。

缺點是對某些經過壓縮編碼的資料如圖形、影音等幾乎沒有效果,而且壓縮演算的重複樣本比對範圍固定在一個小範圍(如8KB),比對過這個小範圍後,用於儲存重複樣本的索引就會被清空,由於比對樣本數量狹小,容易忽略較大範圍的重複,而且也只能對單一檔案進行比對,無法跨不同檔案比對內容(除非先使用其他應用程式把兩個檔案展開、合併後,再壓縮)。

因此即使是兩個完全相同或是僅有一個差異字元的檔案,也只能分別壓縮成兩個壓縮檔,不能合併成一個節省空間,即使我們把這兩個檔案合併壓縮成一個壓縮檔,實際上還是等於兩個檔案的分別壓縮。

檔案等級的單實例儲存

第二種資料容量刪減技術是所謂的單實例儲存(single instance storage,SIS),SIS的特性是具有跨檔案比對的能力。為降低資源的消耗,SIS並非實際去比對檔案的每個位元組,而是對每一檔案以特定演算法求取一個特徵值,在新檔案寫入前,系統會先求出該檔案的特徵值。再與已存在於指定磁碟區中的所有檔案特徵值做比對,若特徵值相同,則代表檔案重複,重複的檔案的只會留下一個指向已有資料的索引連結而不實際儲存,只有新的檔案才會儲存下來。由於SIS比對用的特徵值索引是含蓋整個指定磁碟區的,因此重複資料比對也涵蓋了相同的範圍。

SIS特別適合用於有許多相同附加檔案的電子郵件,企業內部經常會發送或收到許多收件/發信者不同,但附加檔案均完全相同的郵件檔案,此時透過SIS就能刪除掉許多重複的附加檔案,大幅節省空間,如EMC Centera的CAS(固定內容儲存)技術就是典型的SIS,而微軟在Windows Storage Server 2003 R2中也新增了SIS功能,使用者啟用SIS後,資料會存放到指定儲存區的「SIS Common Store」資料夾,這個資料夾預設的屬性為系統檔、唯讀及隱藏,此後若有檔案要寫入磁碟,系統都會先比對,只有內容不重複的新檔案才會存入系統內,否則只會留下一個連結。

但SIS的問題是比對的精細度只到「檔案」層級,而不比對更低的層級,兩個檔案若是只有少數幾個區塊不同(即使只有一個字元不同),在SIS下還是會被看作是兩個完全不同的檔案,分別占用兩個獨立的空間。

區塊層級的重複資料刪除

最徹底的資料容量縮減技術是區塊層級的重複資料刪除(De-dupe),重複資料刪除是在區塊層級上運作,兼有傳統壓縮技術與SIS的特點,也就是說,De-dupe除了能像傳統壓縮技術般能深入檔案底層,比對單一檔案內的重複外,也有像SIS般的「跨檔案」比對能力。某些廠商也把De-Dupe的壓縮稱為「全域壓縮(Global Compression)」,以別於只能針對單一檔案的傳統壓縮技術。不過De-Dupe所取的區塊,名稱同於作業系統I/O存取的單位,意義卻不盡相同,因此某些廠商又稱為區段(Segment)。

De-Dupe可以區塊為單位分析整個磁碟區的資料底層結構,找出資料是由哪幾種資料排列結構組成,接下來對每一種結構都只留下一份,並刪除掉結構相同的重複部份,只留下索引指明刪除前的結構。透過索引就能讓一份唯一的資料代表很多份重複的資料,儲存空間內只要留下不重複的資料與索引即可。

對磁碟區資料分段演算並得到特徵值後,所有新資料的寫入也都會經由演算法的處理,並得出特徵值,因此系統就可比對硬碟中已有資料的特徵值與新寫入資料的特徵值,若發現特徵值相同,則系統就會知道硬碟上已有一個相同的副本,這筆新資料即為「重複」,那麼新資料將只會存入一個指向已有副本位址的指標,而不實際寫入硬碟,不會占用空間。只有特徵值不同的資料才會被寫入,因此磁碟空間的耗用量可得到相當大的節省。

換句話說,原來的資料經重複資料刪除技術後,被化為許多個唯一(unique)、不重複的資料區塊,以及記錄原始資料結構與指向的索引。而這些切割、演算與寫入程序是不對外透通的,就外部的作業系統與應用程式看來,資料的存取仍與平時相同,當使用者要讀取那些被判定為重複的資料時,系統就會透過之前建立的索引把資料取出,「多個唯一、不重複的資料區塊」加上「紀錄原始資料結構與指向的索引」,對作業系統與應用程式看來是等同於原始的完整資料,只要反向運作就能得回原來型態的資料。

所以重複資料刪除技術也能算是一種虛擬化技術,實體的資料儲存與前端看到的資料邏輯結構是脫鉤的,從作業系統或備份軟體來,資料還是維持跟原來一模一樣的邏輯結構,但實際上在硬碟內只剩少數基本元素與索引表而已。

不同的資料容量縮減技術比較 |

|||

| 類別 | 傳統壓縮 | 單實例儲存 | 重複資料刪除 |

| 重複資料比對層級 | 位元組 | 檔案 | 區塊 |

| 重複資料比對範圍 | 單一檔案中的特定大小位元組 | 整個指定磁碟區 | 整個指定磁碟區 |

| 優點 | 對單一檔案的容量刪減效果最好 | 可跨檔案比對 | 可跨檔案比對,也能比對不同檔案底層的重複部份 |

| 缺點 | 壓縮效果只及於單一檔案。對已編碼檔案無效,對完全相同的兩份檔案仍會重複儲存 | 不能比對兩份檔案底層的重複部份。只有極小幅修改的不同檔案仍會重複儲存 | 較消耗處理資源 |

| 典型資料刪檢比例 | 2:1~5:1 | 3:1~5:1 | 5:1~20:1或更更高 |

重複資料刪除技術的特性

重複資料刪除技術的關鍵就在於如何分析資料,從而判斷資料是否重複。考慮到資料量的龐大,顯然不可能每個位元組的去逐一掃描整個磁碟區,然後再交叉比對每個位元的資料是否相同,因此實務上通常都是把資料以區塊或區段為單位,並透過Hash函數(或類似函數)的演算,讓系統來執行資料分析與比對的工作。

Hash特徵值演算

Hash函數的特性,是可以把不同長度的資料經運算後得出相同長度的值,這個值稱為原始資料的「特徵值」或「指紋」,只要是原始結構相同的資料,得出的Hash值必然是相同的;反過來說,只要是Hash值相同的資料,我們也可判斷原始資料的結構也是相同的。

過去Hash一般是被用在資安領域,用於驗證資料的可靠性與完整性,防止敏感資料遭到竄改。而在重複資料刪除技術上,則是透過Hash得出的特徵值來判斷資料是否重複。先把整個磁碟區切割為一個個的區段,並對每個區段分別求出Hash特徵值,只要特徵值相同的資料,就能視為是「重複」。

資料分段方式與大小

Hash特徵值的比對是重複資料刪除技術的基礎,不同廠商使用的演算法細節上的差異固然會影響到產品的「重複資料刪除」效果,但資料分段或切割的方式,對資料刪除率也有很大的影響。

目前產品在切割資料、分段計算特徵值的做法有兩類,一類是以固定大小的區塊為單位來切割,如NetApp的A-SIS是以4KB的區塊為切割單位,Falconstor的SIR則是固定的16KB。另一類則是以可調大小的區塊作為分段單位,如Data Domain的COS是將資料以Byte為單位為分解成4~16KB的區段(平均8KB),而EMC的Avamar則可在1~64KB間調整,再分別進行特徵值計算。

資料分割的片段大小與是否可調整對De-dupe效果有很大的影響。同樣大小的資料若切成較小的片段,意味著系統需要產生並存放更多的特徵值以及索引,將會延緩備份的時間;但若切成較小的片段,則系統也能對資料內容進行更精細的比對,通常可以得到更高的壓縮比率。至於在分段可調與不可調方面,可調式分段的產品,系統會嘗試以多種分段大小來切割資料,以得到更好的資料冗餘判斷結果,更能適應不同的資料型態,而不可調的產品就只能以固定大小的分段來進行演算。

|

重複資料刪除技術的應用 |

| 多數重複資料刪除技術都會影響系統存取效能,因此不適於對性能要求較高的線上即時儲存環境,但對近線儲存、郵件、資料歸檔等應用來說,就能充分發揮其節省容量的好處,而又不會暴露出減損存取效能的缺點。目前主要的應用範圍有以下四方面:

近線儲存與VTL 目前絕大多數的重複資料刪除技術產品都是針對這個應用領域,如Quantum、Data Domain與Sepaton等都是將產品結合二級儲存或VTL銷售。 遠端備份儲存 郵件歸檔與固定內容儲存 |

重複資料刪除技術的類型

依處理流程、運作架構以及對原始資料進行分段方式的不同,重複資料刪除技術有以下幾種不同的區分:

從架構上來看,重複資料刪除技術可分在來源端(Source)或在目標端(Target)執行刪除演算;線上即時處理(in-line),或是寫入磁碟後再行處理(post-processing)等;以及碰到重複資料時,是保留新資料還是保留舊資料等幾類。

來源端/目標端執行刪除演算

典型的備份、複製等儲存應用,是將資料由前端伺服器透過網路搬移到後端的儲存設備上,因此來源端就是產生原始資料的前端應用伺服器,或備份伺服器;而目標端則是指資料最終儲存的設備,如VTL或磁碟陣列等。

不管是在來源端還是在目標端執行資料刪除演算,同樣都會有縮減資料占用空間的效果,但在前端執行資料刪除演算,當資料送上網路前就已經先做過刪減運算了,因此有節省網路頻寬的優點,不過刪減演算也會佔用道前端主機的運算資源;至於在目標端執行刪除演算的優缺點則恰好相反,雖不能節省網路頻寬,但也不會因此耗用前端主機的資源。

線上即時處理/寫入後再行處理

線上即時處理指的是資料在執行備份、複製或寫入磁碟動作時,同步執行資料刪除演算。也就是說,在資料正在一邊複製準備經由網路送到後端,或是後端儲存設備經由網路收到前端資料,準備寫到磁碟的時,De-Dupe系統同時會進行資料內容比對與刪除演算動作。寫入後再行處理,則是指資料在寫入磁碟後,再以指令啟動,或自訂排程啟動De-Dupe系統對存在磁碟上的資料進行刪除演算。

線上即時處理與寫入後再行處理的優缺點剛好相反。由於資料比對與刪除演算相當耗費處理器資源,因此若採用線上即時處理架構,顯然將會拖累系統效能,影響到備份速度。但相對的,由於資料在寫入磁碟前就已經執行過刪減演算,故占用的空間較小;相較下,寫入後再行處理雖然不會影響到系統效能,我們可選擇離峰時間再啟動De-Dupe,但資料在寫入磁碟時還是維持未經刪除的原始形態,還是會占用和前端一樣大的空間,直到啟動De-Dupe後才有縮減效果,因此對寫入後再處理的De-dupe產品,用戶必須準備較大的「暫存」儲存空間。

文字保留新資料還是舊資料

De-Dupe技術會刪除掉重複的資料,但刪除方式有兩種:一為保留舊資料,當新資料被判定為與舊資料重複時,系統會把新資料刪除,並建立一個指向舊資料的索引;二為保留新資料,當新資料判定為與舊資料重複,則刪除舊資料,並把索引指向新資料的位置。

對以上幾種架構,還可以有三種不同的組合,包括「來源端+線上即時處理」,如EMC的Avamar、Symantec Pure Disk;「目標端+寫入後再處理」,如Falconstor的SIR、NetApp的A-SIS、Sepaton Deltastor等;「目標端+線上即時處理」。,如DataDomain的DD400/500系列、Quantum Dxi系列等(注意不會有「來源端+寫入後再處理」這種邏輯上不可能的組合!)。

至於是保留新資料還是舊資料差別不是很大,保留新資料方式耗用的資源或許會稍大一些,必須執行寫入新資料、刪除舊資料與更新索引表的動作,但較利於還原新增資料,考慮到備份資料通常是在剛備份的48小時內最有可能需要還原,因此這個優點或許在某些情況下有用。而保留舊資料的架構,優點是不須執行新資料的寫入動作。

目前的De-Dupe產品中只有Sepaton的Deltastor是採用保留新資料的方式,其餘產品則均採保留舊資料,刪除新寫入的重複資料。

重複資料刪除技術架構比較 |

||||||

| 區分 | 執行De-Dupe的端點 | De-Dupe處理順序 | 重複資料參考指標 | |||

| 類型 | 來源端 | 目標端 | 線上即時處理 | 寫入後處理 | 保留新資料 | 保留舊資料 |

| 優點 | 節省網路頻寬 | 不占用前端主機資源 | 較節省儲存空間 | 不會拖累備份或複製速度 | 利於還原新增資料 | 占用處理器與I/O資源較少 |

| 缺點 | 較耗費前端主機資源 | 無法節省網路頻寬 | 會拖累備份或複製傳輸速度 | 需較大的暫存儲存空間 | 占用較多處理器與I/O資源 | 較不利於還原新增資料 |

重複資料刪除產品類型

目前的De-Dupe產品由於架構與技術上的差異,在應用環境、銷售方式與針對客戶群方面也有所不同。依產品類型可分備份軟體、VTL與儲存伺服器等三大類。

備份軟體類型

將De-Dupe技術整合為備份軟體的產品,目前有EMC的Avamar與Symantec Pure Disk。這類產品本身就是一套完整的備份軟體,在安裝有De-dupe主系統的備份伺服器控制下,藉由安裝在前端主機上的代理程式執行De-Dupe演算,再把資料透過網路送到De-dupe備份伺服器指定的儲存區。

由於前端主機的資料再送上網路前就已經過De-dupe,因此這類產品的優點是可以大幅節省網路頻寬,特別適合將遠端分支辦公室資料送回資料中心的備份應用。缺點是必須在前端主機上安裝代理程式,無可避免的會面臨到代理程式與前端主機的作業系統、應用程式間的相容性問題,同時代理程式的De-Dupe運算,也會耗用主機資源。

VTL與儲存伺服器類型

整合在VTL中的De-Dupe技術有Falconstor的SIR、Quantum Dxi與Sepaton Deltastor等,如Falconstor是將其SIR技術整合在VTL All-in-one系列中,而SEPATON則是把Deltastor與其S2100-ES2、S2100-DS2系列VTL整合,而Quantum的Dxi系列VTL亦整合了源自Rocksoft的De-Dupe技術。

這類產品的應用相當簡單,也就是一套附有De-dupe功能的VTL伺服器而已,主要訴求在於可節省備份資料佔用的容量。

由於VTL只在後端負責接受備份軟體送進來的資料,並執行De-dupe演算,因此不用管De-Dupe與前端伺服器的相容問題,只要不管三七二十一對所有備份軟體送進來的資料做處理即可,至於相容問題則交由備份軟體傷腦筋,只要備份軟體相容的前端系統,VTL就能處理。但缺點就是因為VTL是模擬成磁帶格式,因此也必須依賴備份軟體的驅動才能運作,此外由於是在後端才做De-Dupe處理,因此無法節省頻寬。

至於儲存伺服器類型De-Dupe產品,應用上與VTL十分類似,同樣也必須依賴備份軟體驅動才能運作,唯一差別是資料不是以模擬磁帶的方式寫入。備份軟體會把含有De-Dupe功能的儲存伺服器當成一般的磁碟陣列使用,典型產品如Data Domain的DD400/500系列,以及ExaGrid的Disk-base Backup System。

線上儲存與網路閘道器

除前述三類產品外,目前還有兩種較特別、難以分類的De-Dupe產品。一種是NetApp的A-SIS,A-SIS是整合在NetApp的Data ONTAP與WAFL作業系統中,任何更新到Data ONTAP 7.2.2版的FAS或Nearstor系列儲存系統都具備A-SIS功能,A-SIS屬於寫入後再處理類型的De-Dupe,但隨著FAS/NearStore在儲存架構中所處的位置不同,可分別構成來源端或目標端類的De-Dupe,而且A-SIS可處理整個線上使用的Volume,且處理後的資料是可即時讀寫的,不像其他類型產品都必須利用備份軟體將資料還原後,才能讀寫資料。

另一種產品是Riverbed用在Steelhead網路閘道器上的De-Dupe技術,Steelhead網路閘道器的用途在於提供廣域資料服務(WDN),Steelhead上的RiOS具備De-Dupe功能,可以處理任何通過閘道器的資料流,因此送到WAN上的資料都是經過De-Dupe刪減的,能大幅縮減利用WAN網路傳輸資料時的頻寬需求。文⊙張明德重複資料刪除技術能節省多少空間?

重複資料刪減比率(De-Dupe Ratio)是重複資料刪除技術的最重要的一項指標,所有重複資料刪除技術的供應商,都宣稱他們產品能達到極高的資料刪減比率,保守的講法為20:1~50:1,較聳動的講法則甚至有300:1、500:1等驚人的數字。因此在透過實際測試驗證各產品的資料刪減比率前,有必要先釐清資料刪減比率的涵義。

重複資料刪減比率的涵義

以傳統壓縮技術來說,所謂的壓縮比(Compression Ratio)指的是一個檔案的原始容量,和執行壓縮後的容量之比。但這純粹是從「容量」的角度來看,對重複資料刪除技術(De-Dupe)來說,更重要的是要考慮「時間」因素。

從邏輯來看,De-Dupe產品的效果也能採用與傳統壓縮技術相同的標準來衡量,也就是拿原始資料容量,與將資料送給De-Dupe產品處理後、磁碟實際存入的資料量作比較,這也是一種基於容量的算法。

但傳統壓縮技術只會比對單一檔案內的重複,檔案壓縮完就壓縮完了,和時間無關。但對De-Dupe來說,除了要比對單一檔案外,還要與後續寫入的新檔案做比對,因此計算重複資料刪減比率時,必須把時間因素考慮進來。而考慮到時間因素後,前端的原始資料是以哪種方式被送到後端的De-Dupe系統,對De-Dupe產品的重複資料刪減比率的影響非常大。

由於現有De-Dupe產品幾乎都是定位為備份裝置,因此把資料由前端伺服器送到De-Dupe系統的動作,也就是一種備份程序。所以De-Dupe的效果,也就和備份策略的類型密不可分。

所以如果我們想問:某De-Dupe產品的資料刪減效果如何前,先要仔細考量的是你對資料刪減的衡量標準為何?或是說,是把De-Dupe產品的容量縮減結果,去和哪一種備份策略相比。

基於時間的資料刪減比率算法

由於企業資料多半不會有太大異動,每日新增或修改的資料量通常只相當於總資料量的一小部分,從累計的觀點來看,每天的資料中就包含了非常多的「重複」,只有少數資料是真正的「新」資料,所以只要能排除那沒些有異動的資料,就能得到很高的容量節省效果。

所以De-Dupe產品的資料刪減比率,就和「是否要把沒有異動的資料放到分母」,而會有很大差距。一般來說可以有兩種計算基準:

以每日執行全備份做比較基準

這種算法是假設企業每天都對資料作全備份為基準,所有De-Dupe產品所宣稱的50:1或300;1的空間節省效果,都是用這種基準得出來的。由於企業每天資料的新增或異動不到總資料量的10%,平均甚至只有3~5%的新增或異動資料。換句話說,如果「每天都做全備份」,那每天的備份中就有95%以上是沒有異動的重複資料。

假設總資料量是1,000GB,每日異動量是3%,那每天作1,000GB的全備份時,重複的未異動資料就有970MB, De-Dupe產品只要能去掉這重複的970MB,實際只需要存入30MB的新資料即可,所以資料刪減比率就是33:1。以這種每日全備份的方式進行30天,總備份資料量是30,000GB,但每日備份中都有97%是未異動的重複,所以除了第1天系統需要實際存入原始的1,000GB資料外,後續只要存入900MB的新資料即可,資料刪除比率就是30,000:1,900,即15.7:1,而這個比例還會隨時間不斷的增加。

這種計算方式的盲點在於,即使De-Dupe產品不對資料作任何特殊的演算處理,只要能區分哪些是沒有異動的資料,就能毫不費力地得到數十倍的容量刪減效果。如果De-Dupe產品在這個基礎上再透過區塊級分析比對,進一步刪除冗餘資料,那得到的資料刪減比率就更驚人了!

因此這種計算方式有過於放大De-Dupe效果的疑慮,這種數值,顯然都是在「每日備份的資料絕大多數都與前一天重複」的效應「加持」下,給放大或「虛胖」不少,不能充分呈現出De-Dupe產品的區塊級分析比對能力。而且「每天均全備份」並非企業環境中唯一採用的備份方式。如果僅僅只是要區分出異動資料,那接下來討論的增量備份,其實也能提供相同的效果。

以全備份+增量備份做為比較基準

固然多數De-Dupe產品都訴求在取代「每日全備份」這種操作策略上,因此拿每日全備份來比較是合理的;但De-Dupe最終的目的是在降低備份窗口、節省備份傳輸頻寬與儲存媒體消耗量,因此還是有必要與其他同樣以降低備份窗口、節省頻寬為目的的備份方式做比較。

傳統上,為了解決每日執行全備份所帶來的備份窗口過長、占用儲存容量過高的問題,因此有差異(Differential)與增量(Incremental)備份兩種做法出現。差異與增量備份都會排除兩次備份間未異動的檔案,只備份新增或異動的檔案,兩者差別在於判定異動的時間點不同,差異備份判斷資料異動的起點是從上一次全備份,而增量備份則是從上一次任何一種備份起算。其中增量備份對降低備份窗口的效果又較差異備份為佳,因此更常被使用。

就增量備份來說,又可分為檔案級(file-base)與區塊級(block-base)兩種,不同在於偵測異動的單位是檔案或區塊。檔案級增量備份是檢查檔案保存位元(Archive bit)來判斷檔案是否異動,一個檔案如果只修改過一個字,保存位元就會被清空,因此不論這個檔案大小,檔案級增量備份還是會把整個檔案再備份一次,所以空間節省的效率還是不夠高。相較下區塊級增量備份則能偵測到區塊層級的異動,只會傳輸異動過的區塊,無論是頻寬占用還是空間消耗都更小。

通常的作法是一開始先做一次全備份,接下來再作增量備份。由於未異動的資料都已事先被排除了,所以增量備份所需傳送與寫入的資料量可大為減少。當然這作法也有副作用,由於每份增量備份之間都存在著相依性,在還原時,必須把多份增量備份依順序逐一接續還原,程序複雜且相當耗時,更糟的是若有其中一份增量備份損壞,在該次增量備份之後的備份也都會失效。

即使如此,這種「全備份+增量備份」的備份窗口與儲存容量節省的效果仍是存在的,若以此做為De-Dupe的比較基準,顯然計算出來的刪減比率就要比以每天全備份為基準時低了許多。De-Dupe必須硬碰硬地去分析並刪減那些新增或異動的檔案,才能有容量節省效果,而不能僅僅是透過去除未異動的檔案來拉高資料刪除比率,因此這種算法更能顯示出De-Dupe的區塊級資料刪除能力。

更重要的是,增量備份是所有備份軟體均內建的功能,不用額外花錢買,如果De-Dupe不能提供明顯高出增量備份的效益,顯然難以讓用戶接受。

基於容量的資料刪減比率算法

基於時間的資料刪減比例算法,只在備份環境下有效,若是在某些非備份的環境中,如檔案歸檔、或不經常存取的非結構性資料,前述計算方式就不適用。在這種環境下,磁碟區先天就不容易收到前後相互重複的資料,但資料底層中仍包含許多冗餘的部份,可以透過De-Dupe技術去除。此時的容量節省表示方式可改用百分比來計算,如原始大小為500GB的資料經處理後成為300GB,則容量節省率為40%。要注意的是,在多數情況下,基於容量的資料刪減比例算法得出的結果,和以「全備份+增量備份」為比較基準時相同,兩種算法都排除了前後重複送進來的相同資料。五款De-Dupe產品實測

我們這次一共測試了五款應用了De-Dupe技術的產品,分別為Data Domain DD410、EMC Avamar、Falconstor SIR、NetApp A-SIS與Symantec Pure Disk。其中DD410為一臺應用伺服器、NetApp A-SIS則是內建於FAS3040儲存系統,SIR為內建於Falconstor VTL All-in-one應用伺服器,EMC Avamar與Symantec Pure Disk均為軟體,主系統均安裝在1臺Linux伺服器上,並於前端Windows Server 2003伺服器上安裝代理程式。

從測試結果,我們可得出幾個結論:

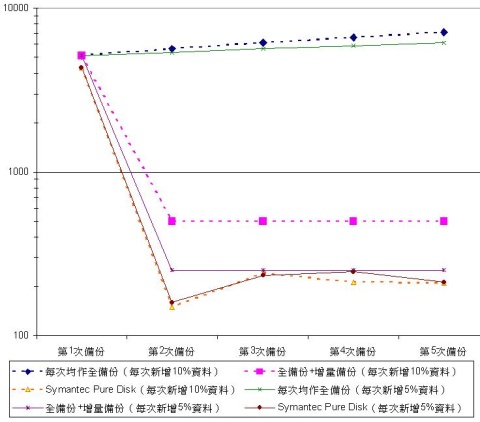

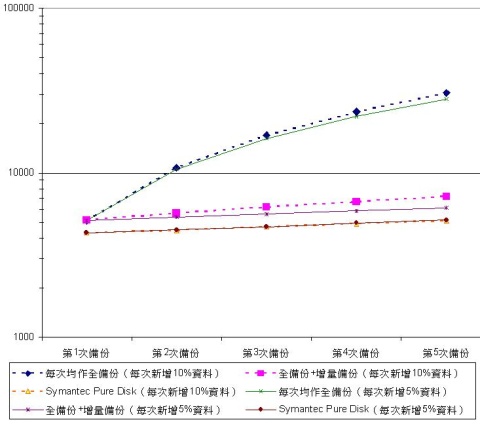

以每次全備份為比較基準時,各產品均能達到15:1或更高的資料刪減率。

在以全備份為比較基準時,各次備份間本來就含有90~95%的未異動資料,只要把這些未異動資料挑出、刪除,De-Dupe系統即使不作任何區塊級分析比對動作,也能達到15:1或更高的資料刪減率。

以每次全備份為比較基礎時,資料新增/異動量越低,則資料刪減率越高。

這個結論也是很理所當然的,資料的新增/異動量越低,也代表著每次全備份時,資料內含的重複/未異動部份也越多。因此在10%資料新增率的測試A中,各產品的資料刪減率大致都能達到15:1以上,但是在5%資料新增率的測試B中,資料刪減率就達到25:1甚至30:1。

以全備份+增量備份為比較基準時,各產品達到的資料刪減率均十分有限。

在與全備份+增量備份做比較時,由於各次備份中90~95%的未異動資料都已事先被排除在外,因此De-Dupe就不能從單單把未異動資料挑出刪除而得到很高的資料刪減比率,這時候只能去硬碰硬地透過區塊級分析比對來刪減資料。但我們測試中使用的新增資料都是與已有資料完全不同的新資料,可以看出除PureDisk還有2~3:1的刪減率外,其餘各產品都不到1.5:1,數值比以每次全備份為比較基礎時低了許多。

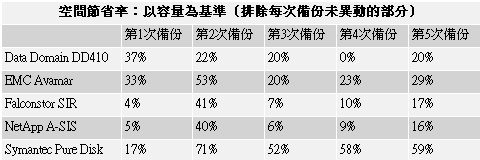

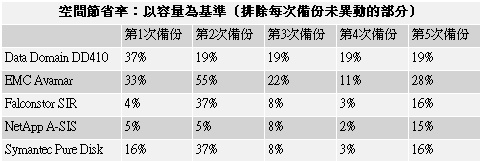

以容量為基礎計算時,各產品的空間節省率差異很大。

當我們以容量為基準計算空間節省率時,由於是基於儲存系統「不會」像執行備份般,每次都會收到已有資料重複的資料,所以計算時必須排除每次備份未異動的部份,由此得到的空間節省率,對不同產品來說差異很大。如DD410、Avamar、PureDisk在這種計算方式下都還是有20%~40%或更高的空間節省率,而其他產品則平均只有10%不到的空間節省率。

可調切割區段的產品表現優於固定分割區段的產品。

由測試A、B可看出Data Domain DD410、EMC Avamar與Symantec PureDisk的表現較為突出,其中DD410與Avamar的表現好或許可歸因於這兩款產品都是採用可自動調整資料分析切割區域,如DD410會嘗試以4~16KB的分段去分析資料,Avamar也能自動以1~64KB的不同分段去切割並分析資料,理論上更能適應不同的資料型態,其餘3款產品都是採用固定的分段方式。

不過也有例外,PureDisk雖然是固定式分段,預設為128KB,雖然能夠手動調整,但設定後系統還是會以設定的值固定去切割檔案,然而即使如此,PureDisk的表現並不遜於DD410或Avamar。

De-Dupe的長處在於針對異動資料,而非完全新增的不同資料。

由測試C可以看出,De-Dupe的真正長處在於針對異動資料,而非是測試A與測試B那種完全新增不同資料的環境。

在許多政府機關或民間企業中,常常會有許多共通格式的表單或文件,各單位都是透過填寫這些共通格式的表單來作業,因此各單位產生的檔案雖然名稱不同,但基本格式均相同,各單位只是在表單上填入內容而已,因此不同單位產生的這類檔案,可能有50%甚至70~80%的內容都是相同的。

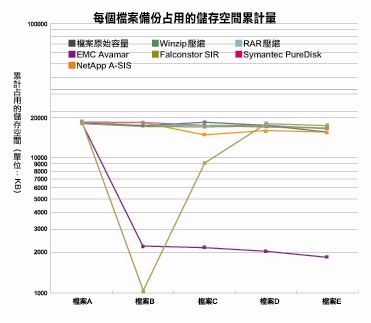

然而對傳統備份或壓縮技術來說,由於不能進行跨檔案的區塊分析,即使每份檔案都含有90%的相同部份,但都還是必須佔去一份空間。如測試C的檔案A到檔案E等五份檔案,雖然每份檔案的90%部份都是相同的,但還是要占用五倍的空間,即使使用RAR或Winzip壓縮也節省不了多少空間。

而對De-Dupe就沒有這種問題,以Avamar來說,除了第一次儲存時仍需存入接近100%原始資料的檔案外,在後續儲存中都能透過區塊級分析判斷出檔案B~檔案E都含有許多與檔案A重複的部分,因此第二次到第五次都只存入相當於原資料量10%的新資料而已,De-Dupe的效益極為顯著。

但其他產品的表現就與Avamar有一段差距,或許是由於樣本檔案是一個貼有JPEG圖形的Word檔,內容的離散較大,而A-SIS、SIR、PureDisk都受限於固定分割區段架構,不像Avamar能透過自動調節分區大小來適應資料型態。至於另一款採用可調分割區段的產品DD410,則因其系統檢視容量的粒度太粗,只能以0.1GB為單位查看系統容量狀況,因此無法執行每個檔案只有18MB的測試C。

讓增量備份概念消失的De-Dupe

「兼有全備份與增量備份兩者之長,而無兩者之短」是De-Dupe最明顯的好處。每日均執行全備份的優點是還原時間快,但缺點是備份時間長,且耗用的儲存空間大。而全備份+增量備份的優點在於備份窗口小,耗用的儲存容量小,但缺點則是還原程序麻煩,且多份增量備份間有相依性,一份損壞就會危及整份資料的完整性。

過去為了解決這修問題,某些廠商曾提出過所謂「合成備份」的技術,可在背景自動結合多份增量備份成為一份全備份,試圖解決「每日全備份」與「全備份+增量備份」間的兩難問題,但因操作程序複雜,在背景執行的合成無法完全保證資料完好度等原因,實務上很少人使用這種合成備份。

而在De-Dupe技術出現後,「每日全備份」與「全備份+增量備份」間的兩難就不在存在了。從測試A與測試B可以看出,如果光是比備份窗口的縮減或是占用儲存容量的節省,De-Dupe對「全備份+增量備份」的優勢有限,但De-Dupe等於每天都是在作全備份,在還原上的效率就要比「全備份+增量備份」好的多。

而與「每日全備份」相較,De-Dupe在還原方面的效率是相同的,但在備份窗口、佔用傳輸頻寬與儲存空間消耗方面的表現就好了太多,可有數十倍以上的效益。

因此企業在導入De-Dupe產品後,增量備份的觀念就可以消失了,可以每天都作全備份而無備份時間過長、占用頻寬過高,以及耗用儲存媒體空間過大的疑慮。而對資料型態是以「異動」居多而非「新增」的環境,De-Dupe產品的效能還會更高。文⊙張明德Data Domain DD410

DD410是Data Domain儲存伺服器系列中的入門產品,具備儲存容量最佳化技術(COS,Capacity Optimized Storage),可透過拆解與比對資料內容,大幅縮減資料儲存所需媒體容量,使DD410約1TB原生容量達到相當於15TB甚至50TB以上容量的儲存效率。另外還提供遠端複製(Remote Replication)與虛擬磁帶櫃(VTL)等選購功能。

DD410是Data Domain儲存伺服器系列中的入門產品,具備儲存容量最佳化技術(COS,Capacity Optimized Storage),可透過拆解與比對資料內容,大幅縮減資料儲存所需媒體容量,使DD410約1TB原生容量達到相當於15TB甚至50TB以上容量的儲存效率。另外還提供遠端複製(Remote Replication)與虛擬磁帶櫃(VTL)等選購功能。

產品具備2個GbE網路埠,並支援RAID 6,可容忍2臺硬碟同時故障,資料仍不致損毀。支援命令列與網頁介面兩種管理模式。

建置簡便的備份儲存伺服器

Data Domain的DD400系列儲存伺服器是定位在近線儲存,專門針對作為二線儲存的備份媒體使用而設計。適用於「磁碟到磁碟(D2D)」環境中的後端儲存,或是在「磁碟到磁碟再到磁帶(D2D2T)」充任中介緩衝儲存。因此DD400系列只能在備份軟體控制下運作,不支援線上存取服務,除非透過備份軟體將資料還原到其他儲存媒體上,否則一般作業系統也無法檢視DD400內儲存的資料(除非透過備份軟體)。

不過這種依賴備份軟體才能運作的架構,好處是對應用程式的相容問題可以轉嫁給備份軟體去應付,只要備份軟體能支援,DD400也能支援,換句話說,DD410只要負責處理備份軟體送進來的資料即可,而無須去管資料在前端的實際型態為何。

依原廠提供的支援清單顯示,幾乎目前所有主流的備份軟體都能支援DD400系列,安裝時只要將設備接上網路,然後到備份軟體中將DD410設為備份的目的端即可,接下來一切刪除重複資料的處理作業,都由DD410中的Data Domain作業系統(DD OS)以COS技術自動執行自行執行,使用者完全無須介入。

DD400系列另提供VTL選購程式,可模擬成一臺StorageTek L180磁帶櫃,搭配Data Domain VTL套件內的FC HBA卡接上FC SAN作業。

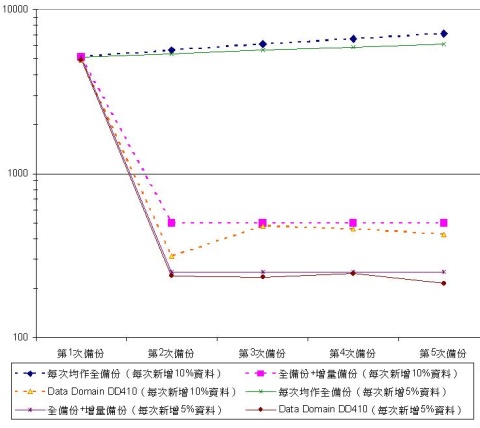

資料刪減效果出色

在我們這次測試中,DD410是在資料刪減率方面表現最好的產品之ㄧ,以每次均執行全備份為基準,備份5次後,資料刪減率可達17:1(10%資料新增)或30:1(5%資料新增)以上。

不過在資料刪減運作上,DD410只能依照預設值來執行,不能依環境需要調節。而在Data Domain新一代的DD500系列上,則提供有4種等級的資料刪減等級,用戶可以需要選擇最大效能或最大壓縮率,以適應實際情況。文⊙張明德

|

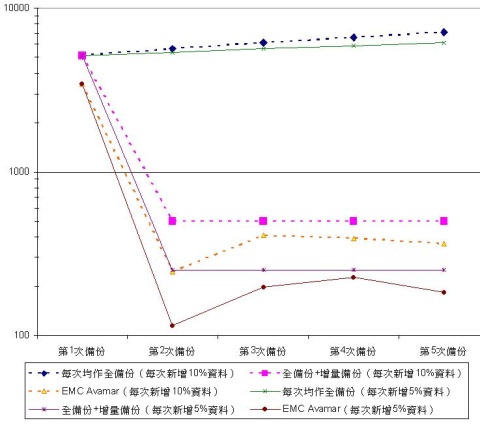

每次備份需要占用的容量 |

測試總評:由表可以明顯看出資料新增量越少,意味著重複部份越多,故5%新增量時的刪減效果要好於10%新增量。 |

|

備份累計消耗的總容量 |

測試總評:DD410可以極大的抑制備份資料量的增長,即使是沒有先前樣本可供比對的第一次測試,都能有接近40%的容量節省。 |

| Data Domain DD410 |

||||

| Data Domain

(02)2578-6879 晉泰科技/麟瑞科技代理 |

||||

| 型號 | DD410 | DD430 | DD460 | DD460G |

| 原生容量 | 160GB×8 | 400GB×8 | 400GB×5 | 外接 |

| 選購功能 | 遠端複製、VTL | |||

| 支援備份軟體 | Bakbone NetVault、CA ARCserve、CommVault、EMC Networker、HP Data Protector、IBM TSM、Symantec Net Backup、Symantec Backup Exec等 | |||

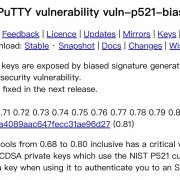

EMC Avamar

EMC Avamar是一套針對遠端辦公室備份環境,內建重複資料刪除技術的備份軟體,透過前端代理程式的處理,可刪除備份資料中的冗餘,大幅降低備份資料傳輸佔用的網路頻寬,並節省儲存媒體的消耗量。

EMC Avamar是一套針對遠端辦公室備份環境,內建重複資料刪除技術的備份軟體,透過前端代理程式的處理,可刪除備份資料中的冗餘,大幅降低備份資料傳輸佔用的網路頻寬,並節省儲存媒體的消耗量。

系統支援非常廣泛,代理程式可支援Windows、Linux、Solaris、HP-UX、AIX等主要Unix平臺,Mac OS X以及VMware等作業環境,另外也能支援DB2、Exchange、SQL Server、Oracle等應用程式。可適應大多數的企業IT環境。

集中式備份管理

Avamar源自Avamar被EMC併購前的Axion,是一套很典型的集中控管式備份軟體,採用「用戶端—伺服器端」的架構。Avamar伺服器端的主程式必須安裝在IA32平臺的Red Hat Enterprise Linux AS/ES 3.0上,而用戶端代理程式的支援就非常廣。安裝完成後,可由管理者從Avamar伺服器上,啟動裝有代理程式的前端系統,執行備份作業,將指定的資料經網路送到Avamar伺服器控制的儲存設備上。除了由伺服器端發起備份外,也能由前端系統的使用者自行啟動備份。管理者還能從其他電腦透過瀏覽器登入Avamar伺服器,執行各項作業。

由於Avamar本質上是一套備份軟體,除了重複資料刪除這個功能外,其餘功能均與一般軟體類似,如作業狀態監控介面、報表、儲存區管理功能等,操作算是相當簡便。為簡化建置與維護的問題,EMC銷售時可提供預載了Avamar的應用伺服器,原廠本身也驗証過IBM、HP、Dell等廠商數款市售伺服器的硬體相容性。

優異的資料刪除效率

冗餘資料的刪減是Avamar的最大特色,透過區塊級的比對能有效剔除資料底層中的重複部份。由於比對動作是由代理程式執行,因此送到網路上的資料已經是經過De-Dupe,故能大幅縮減對傳輸頻寬的需求;而且代理程式不僅只是比對前端主機上的資料,還能將前端資料的特徵值,比對已儲存在伺服器上的現有資料的特徵值,因此比對範圍是整個Avamar的儲存區域,這也就是所謂的「全域壓縮」。

Avamar在測試中展現了令人印象深刻的資料刪減能力,是這次測試表現最好的產品之一,這或許與其具備可調式資料分段方式有關,系統分析檔案是可自動以1~64KB的「窗口」對資料進行分段比對,以適應不同的資料類型。文⊙張明德

|

每次備份需要占用的容量 |

測試總評:在資料新增量越低的環境下,重複也越多,因此De-Dupe的效果也越顯著。 |

|

備份累計消耗的總容量 |

測試總評:由測試結果可以明顯看出,Avamar可以極大的抑制備份資料量的增長。 |

| EMC Avamar |

|

| EMC

0800-521-547 taiwan.emc.com |

|

| Avamar主程式安裝平臺 | Red Hat Enterprise Linux AS/ES 3.0 |

| 用戶端代理程式支援平臺 | Windows NT/2000/XP/Server 2003、Linux、Solaris 7/8/9/10、HP-UX、AIX、Mac OS X 10.4、VMawre/ESX |

| 應用程式支援 | DB2 8.2、Exchange 5.5/2000/2003、Oracle 9i/10g、SQL Server 7.0/2000、NDMP |

| 其他 | 支援Microsoft Cluster Service |

FalconStor VTL All in One

VTL All in One(VTL AiO)是FalconStor推出的一種內含重複資料刪除功能的虛擬磁帶櫃(Virtual Tape Library)應用伺服器,可將內建硬碟的空間模擬成磁帶設備,供備份軟體作為備份儲存的目的端。透過內建Single Instance Repository(SIR)提供的區塊級分析比對,可刪除備份資料中的冗餘,降低磁碟空間的消耗。

VTL All in One(VTL AiO)是FalconStor推出的一種內含重複資料刪除功能的虛擬磁帶櫃(Virtual Tape Library)應用伺服器,可將內建硬碟的空間模擬成磁帶設備,供備份軟體作為備份儲存的目的端。透過內建Single Instance Repository(SIR)提供的區塊級分析比對,可刪除備份資料中的冗餘,降低磁碟空間的消耗。

安裝操作簡易

VTL AiO可視為在FalconStor的VTL系統上,新增SIR重複資料刪除功能的進階改款產品。

操作可分為VTL與SIR兩部份,VTL部分的操作設定方式均與FalconStor先前的VTL產品相同,在控制臺畫面中選擇欲模擬的磁帶櫃形式、磁帶機類型、數量、磁帶櫃所含磁帶槽數目,以及磁帶類型、數目,完成設定後,前端主機的作業系統與備份軟體就能抓到新增的磁帶設備,接下來的備份作業就能把VTL AiO當作一般的磁帶設備使用。

而在SIR方面的設定就更簡單了。SIR是一種寫入後再處理的De-Dupe技術,使用者只要在控制臺的VTL系統項目中把SIR項目打勾即完成了設定。

另外還能設定資料寫入VTL後到開始執行SIR的延遲時間(預設最小為1分鐘,即資料寫入1分鐘後才會開始進行De-Dupe演算),以及寫入多少資料後才開始SIR的比對作業(預設為1MB)。系統還附有遠端複製功能,可把資料複製到遠端的另一臺VTL AiO上,由於傳輸的資料都已經過SIR的處理,因此只需要很小的頻寬即可執行。

架構彈性大、支援性廣泛

以資料刪減效率來說,VTL AiO在我們這次測試的產品中不算很突出,但與其它類型的產品相較,VTL AiO有架構彈性大、支援性廣泛的特色。

藉由VTL的特性,VTL AiO是以磁帶設備的身分透過備份軟體的驅動來作業,因此與前端主機的平臺類型無關,只要備份軟體能支援,VTL AiO就能支援,VTL AiO只需負責處理備份軟體送進來的資料,而不用管這些資料是從前端哪一種平臺送過來的。不像某些採用備份軟體形式的De-Dupe產品,都必須在前端主機安裝代理程式,從而帶來相容性的問題。

VTL AiO產品線的涵蓋範圍亦相當廣泛,除了我們這次測試含有12臺硬碟的VTL AiO-215外,還有內建6臺、24臺硬碟的AiO-205與AiO-225,能滿足不同環境對備份的需要。如果用戶的要求更高,FalconStor還提供了資料中心級的產品版本,可支援N+1叢集架構,提供更高的可靠性。文⊙張明德

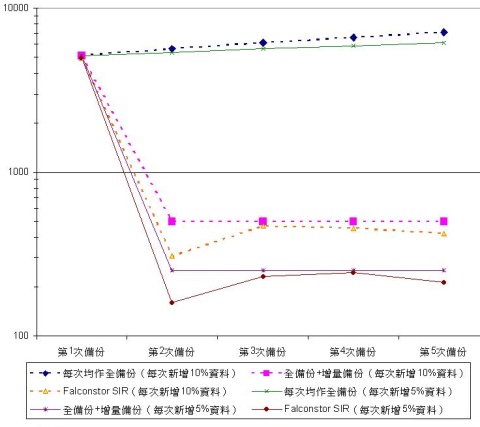

|

每次備份需要占用的容量 |

測試總評:VTL AiO的SIR功能資料刪減效果,與其它產品相較下算是比較中規中矩,不算十分突出,但在個別幾次測試中(如測試B的第二次備份)有領先的表現。 |

|

備份累計消耗的總容量 |

測試總評:與其他產品相同,SIR在資料新增量5%的資料刪減表現也是比10%新增量時好,新增量越低,則兩次備份間的資料重複比例越高。 |

| FalconStor VTL All in One |

|||

| 飛康國際

(02)8866-2285 |

|||

| 型號 | VTL AiO-205 | VTL AiO-215 | VTL AiO-225 |

| 原生容量 | 750GB×6 | 750GB×12 | 750GB×24 |

| 支援介面 | 4Gb FC、iSCSI | ||

NetApp A-SIS

每次備份需要占用的容量 備份累計消耗的總容量 NetApp A-SIS (02)8751-0088 Symantec PureDisk 6.2 每次備份需要占用的容量 備份累計消耗的總容量 Symantec PureDisk 6.2 (02)8761-5800 備份測試A:每次新增10%資料 先進單實例儲存(Advanced-Single Instance Storage,A-SIS是NetApp為其FAS線上儲存系統與NearStore近線儲存系統,新增的區塊級重複資料刪除功能。使用者可透過手動或排程自動啟動A-SIS,為指定Volume去除冗餘資料,提高空間利用效率。

先進單實例儲存(Advanced-Single Instance Storage,A-SIS是NetApp為其FAS線上儲存系統與NearStore近線儲存系統,新增的區塊級重複資料刪除功能。使用者可透過手動或排程自動啟動A-SIS,為指定Volume去除冗餘資料,提高空間利用效率。

內建於Data ONTAP

A-SIS可在任何執行Data ONTAP 7.2.2版以後的NetApp FAS系列,或NearStore系列儲存設備上運作,功能本身為免費提供,使用者只要有nearstore_option授權,即可開啟A-SIS的授權,如果是Nearstore R200,由於本身就有nearstore_option,能直接啟動A-SIS。

A-SIS屬於一種寫入後再處理的De-Dupe技術,使用者可隨時以sis start

執行A-SIS後,再利用df –s

A-SIS執行時是以4KB大小的區塊分析資料,並利用特定演算法為每個區塊的資料求取特徵值,並與已有資料的特徵值做比對,以判定資料是否為冗餘。

不用還原可直接即時讀寫

A-SIS是NetApp整個資料保護機制的一環,除了可刪除特定儲存備本身的資料冗餘外,將資料透過SnapMirror傳送到遠端時,也能降低傳輸所需佔用的頻寬。

單以資料刪除效果來看,NetApp A-SIS在本次測試中的表現並不突出。但A-SIS的De-Dupe效果雖然不像其他產品那樣亮眼,但亦有一項獨步業界的技術,即A-SIS處理的資料是可即時讀寫的,在執行刪除重複資料過程中,仍然可以對任何檔案進行讀寫動作。

其他所有De-Dupe產品所處理過的資料,都必須先執行還原動作後,才能進行存取,相較下A-SIS具有更高的資料使用彈性。

因此比起單純的De-Dupe,A-SIS更重要的是可以應用在即時存取的線上儲存設備上,不像其他產品都僅局限在備份等近線儲存應用。文⊙張明德

測試總評:單以資料刪除效果來看,NetApp A-SIS在本次測試中的表現並不很突出,不過A-SIS的資料是可即時讀寫的,不像其他產品都必須先執行還原後,才能存取資料。

測試總評:新增5%資料下的容量節省效果,要略高於新增10%所得的結果,De-Dupe的抑制容量增長效果,會隨著資料新增量的降低而提高。

Network Appliance

支援A-SIS的NetApp硬體設備

FAS3020/3040/3050/3070/6030/6070

FAS2020/2050

Nearstore R200

Data ONTAP版本

7.2.2以後

啟動A-SIS所需授權

nearstore_option license(除R200外所有產品均需此授權)a_sis license

NetBuckup PureDisk是一套適用於遠端備份環境的備份軟體,內建重複資料刪除功能,可大幅降低資料傳輸所需佔用的頻寬。系統可支援當前多數主流作業平臺,包括Windows 2000 Server/XP/Server 2003、Redhat/SUSE Linux、Solaris 8/9/10、HP-UX與AIX等,還能支援Exchange與SQL Server等應用程式。

NetBuckup PureDisk是一套適用於遠端備份環境的備份軟體,內建重複資料刪除功能,可大幅降低資料傳輸所需佔用的頻寬。系統可支援當前多數主流作業平臺,包括Windows 2000 Server/XP/Server 2003、Redhat/SUSE Linux、Solaris 8/9/10、HP-UX與AIX等,還能支援Exchange與SQL Server等應用程式。

NetBackup家族新成員

PureDisk雖然冠著NetBackup的名稱,但實際上是一套可獨立執行的備份軟體。就架構而言,PureDisk與EMC的Avamar非常近似,同樣都屬於內含重複資料刪除功能的「用戶端—伺服器端」架構的備份軟體。透過安裝在前端主機上的代理程式進行De-Dupe處理,可刪除備份資料中的冗餘,大幅降低備份資料傳輸占用的網路頻寬,並節省儲存媒體的消耗量。

PureDisk的伺服器端主程式,也和Avamar一樣是安裝在Linux平臺上,不過Symantec選擇的是SUSE Linux Enterprise Server 10(Avamar則是Redhat);自6.1版以後也限定主程式必須安裝在x64平臺的伺服器,包括AMD64或Intel EM64T。相形下,用戶端系統的代理程式支援就寬廣得多,幾乎所有主流作業系統都能支援。

操作簡易,設定彈性大

PureDisk的操作十分簡易,由於管理介面是以Web為基礎,因此用戶可從遠端辦公室或其他任何地點,透過瀏覽器登入PureDisk的中央伺服器,發起備份或還原作業。另外還能提供多種備份作業進階設定,包括256位元加密、傳輸頻寬上限設定,以及執行De-Dupe時的資料分段大小等,操作彈性相當大。

而就介面來說,PureDisk的風格與NetBackup或Symantec其他備份軟體均不相同,不過操作方式大同小異,透過選單內的樹狀圖點選欲備份的資料夾或檔案就能完成設定,內建的報表功能比較陽春,但可搭配Veritas Backup Reporter軟體,以補內建報表功能的不足。

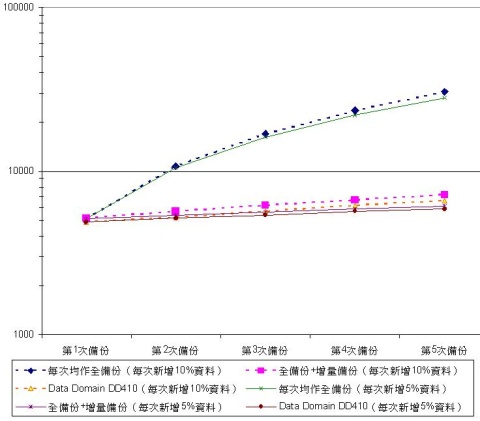

極佳的資料刪減效率表現

單從資料刪減效率來看,PureDisk可說是本次測試中表現最好的產品之ㄧ。在測試A中除第一次備份外,後續備份所達到的資料刪減效果領先其餘所有產品,最高甚至接近40:1的資料刪減率,或是70%的容量節省率。

不過或許是測試時使用的128KB資料分段預設值不太洽當,以致PureDisk在測試C中未能展現出應有的冗餘資料刪減效果,對測試C使用的含有圖形的DOC樣本檔案來說,128KB的分段值或許太大了些,不過適當的分段大小為何,還要需進一步的參數調教測試,才能確認。文⊙張明德

測試總評:一般來說,資料新增量越小,代表每次備份的重複部分也越多,De-Dupe的刪減率應該也越好,但PureDisk的結果卻與此相反,在10%新增率下的效果反而略佳。

測試總評:PureDisk是本次測試中資料刪除效果最佳的產品之ㄧ,在測試A中的表現尤其出色,除第一次備份外,後續都有50%以上的空間節省率。

賽門鐵克

PureDisk主程式安裝平臺

SUSE Linux Enterprise Server 10

用戶端代理程式支援平臺

Windows 2000/XP/Server 2003、Linux、Solaris 8/9/10、HP-UX、AIX、、VMawre/ESX

應用程式支援

Exchange 2003/2005、SQL Server 2000/2005

其他

支援256位元加密

測試A目的為驗證De-Dupe產品在10%資料新增率下的資料刪減效果。基底為5GB,每次新增10%資料,新增資料均為與已有資料完全不同的新資料。基底的5GB檔案集共含3506個檔案,文件類檔案(含DOC、PDF、XLS與TXT格式)占總容量60%,圖形類檔案(含JPEG與BMP格式)占總容量40%。4份新增檔案集大小均為500MB,各含620個、718個、265個與375個檔案,文件類與圖形類各占總容量60與40%。

測試時樣本檔案位於前端伺服器上,透過備份軟體依序備份到後端De-Dupe系統指定區域。另以「每次均全備份」與「全備份+增量備份」作為對照。

DD410與Avamar在沒有先前樣本可參考的第一次備份中,就能節省近40%容量,De-Dupe效果非常明顯。不過PureDisk雖在第一次備份只節省17%的容量,但在後續幾次備份中,每次都有50%以上的空間節省率,表現相當突出。另外可以注意到A-SIS與SIR的測試結果非常接近,在圖上幾乎完全重合了。

備份測試B:每次新增5%資料

兩次備份間異動或新增的檔案量越少,則代表重複的部份也越多,理論上De-Dupe的效果也越好,因此我們以每次新增5%資料的測試B,來與每次新增10%的測試A對照,驗證不同資料新增率下的De-Dupe效果。

測試B基底為與測試A相同的5GB樣本檔案集,另含4份250MB新增檔案集,文件類與圖形類各占總容量的60與40%,其中第一份含518個檔案,第二份含685個檔案,第三份含225個檔案,第四份含330個檔案。測試程序與測試A相同,並以「每次均全備份」與「全備份+增量備份」作為對照。

由測試結果可看出,測試B的整體趨勢與測試A相近,但由於資料新增量只有測試A的一半,因此測試B每次備份時所含的重複部份也更多,多數產品所達到的刪減率也更高,如第五次備份時的資料刪減率,就從測試A的平均17:1提高到30:1(以每次均執行全備份為基準計算),唯一例外是PureDisk,在測試B下的刪減率反而稍低於測試A。

備份測試C:連續備份5個僅分別異動10%內容的檔案

依De-Dupe的全域區塊級比對原理,兩份檔案若含有極大的相同部分,De-Dupe理應可判斷出不同檔案中的重複區塊,並加以刪除。為驗證此點,我們準備了5份以同一份檔案為基礎,修改10%內容再另存而成的word檔,容量分別為18.4、18.09、17.59、17.79與16.82MB,並依序備份到De-Dupe儲存區。

Avamar的測試充分展現了De-Dupe的特性,除第一次需備份與原始檔案一樣大的資料外,後續4次都能判斷出新、舊檔案間的重複,只備份少許異動而已。SIR則較不穩定,五次備份中只有兩次能成功刪除檔案中的冗餘。另外還可注意到,傳統壓縮技術對內容幾乎相同的多個檔案,起不了作用。

熱門新聞

2024-04-17

2024-04-17

2024-04-18

2024-04-15

2024-04-15

2024-04-15