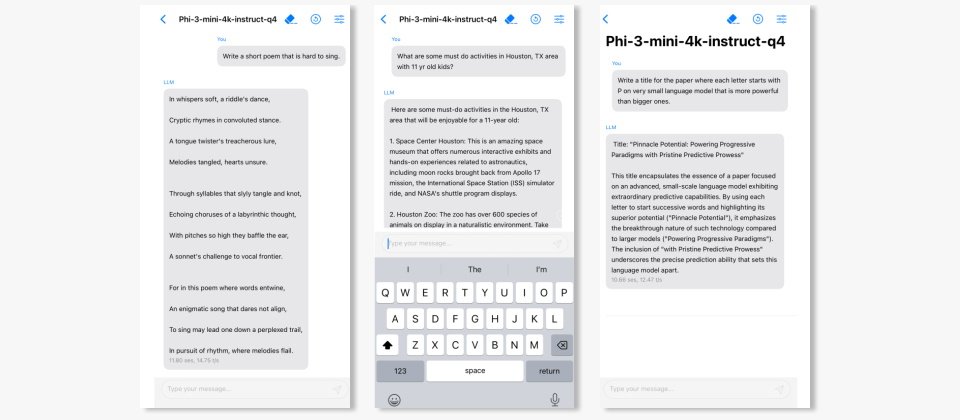

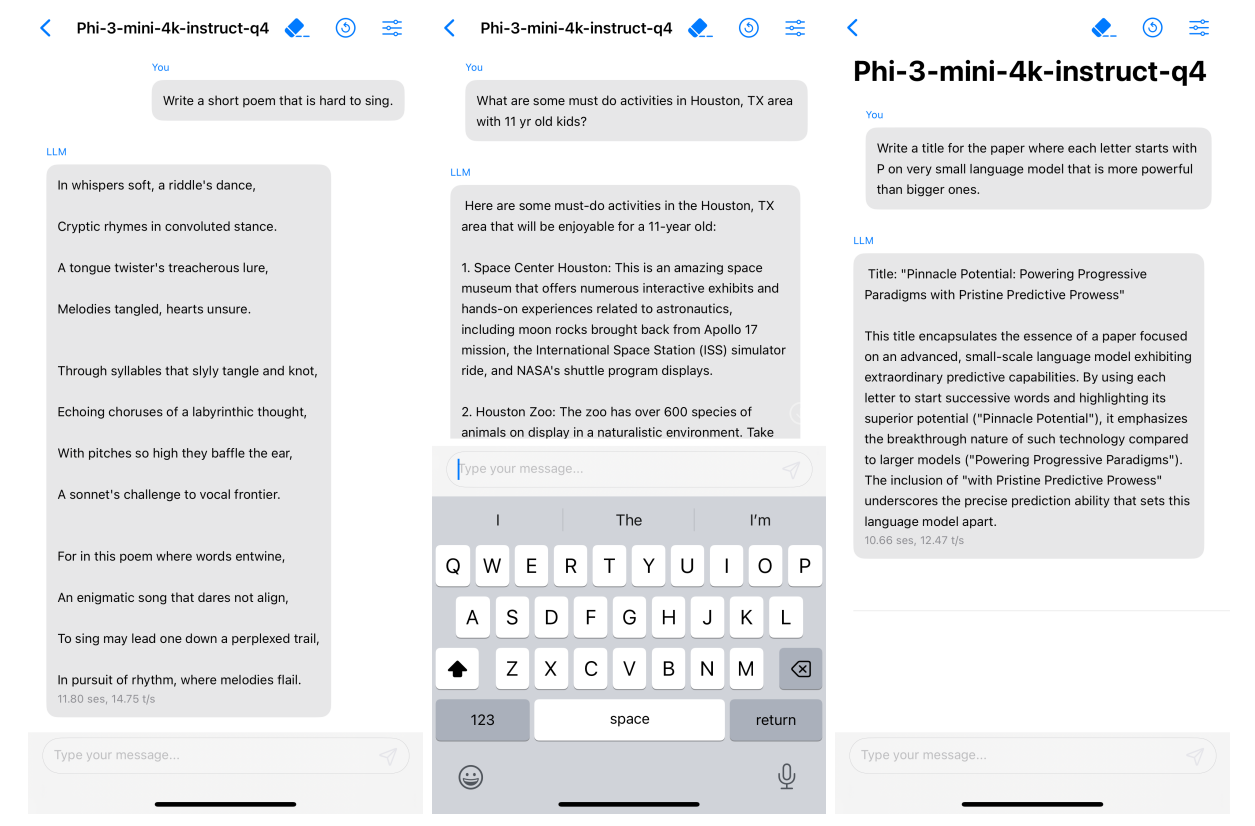

Phi-3-mini具有輕巧、容易使用、跨平臺等特色,可在多種硬體平臺如CPU、GPU、FPGA甚至行動裝置上執行。(圖片來源/微軟)

微軟昨(23)日公布並開源小型語言模型(small language model,SLM)Phi-3系列,強調在語言理解、推理、數學及寫程式等能力上,比更多參數的模型如GPT-3.5 Turbo、Mistral還強大。

微軟分別在去年6月及12月公布參數僅13億的Phi-1及27億的Phi-2輕量型語言模型。此類模型是為執行較簡單任務設計,使用較簡單,資源較有限的組織也能輕易微調以滿足特定用途。

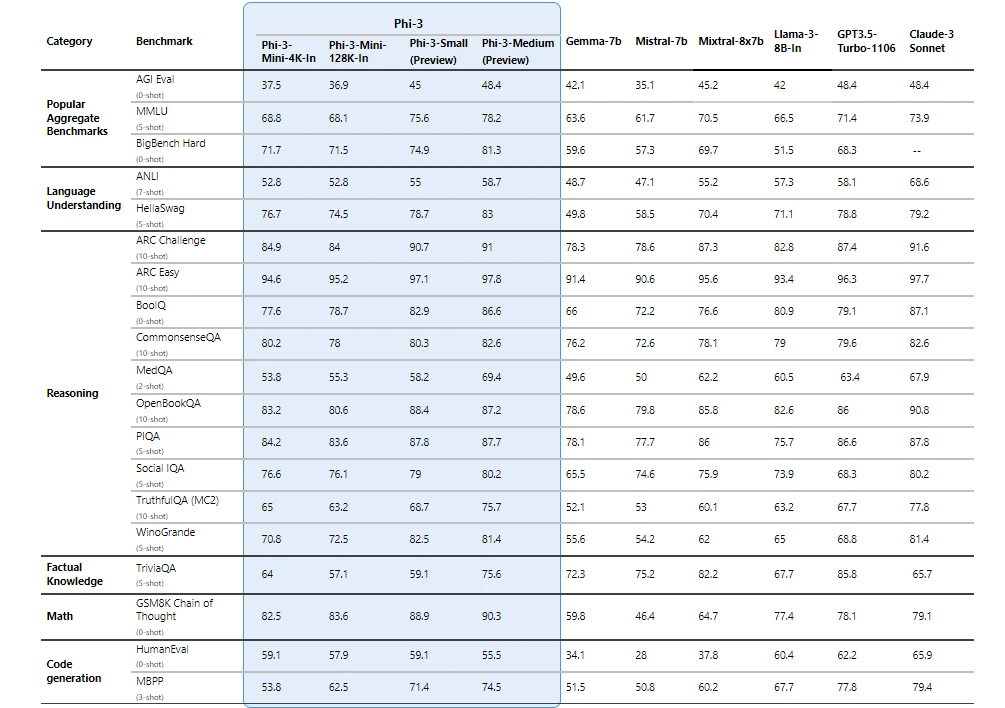

最新的Phi-3包含三款模型,分別是Phi-3-mini(3.8B)、Phi-3-small(7B)、及Phi-3-medium(14B)。今天Phi-3-mini已透過Azure AI Studio模型庫、Hugging Face、輕量框架Ollama公開。再幾個星期Phi-3-small及Phi-3-medium也會在Azure AI模型庫及其他網站公開。微軟強調,Phi-3家族雖然參數量相較少,但效能卻大於參數較多的模型。根據微軟提供的數據,Phi-3-mini在多語言理解、推理、數學及寫程式等標竿測試上,超過Google Gemma-7B與Mistral-7B,而Phi-3-small及Phi-3-medium甚至超過Mixtral 8x7B、Claude-3 Sonnet與GPT-3.5 Turbo。

圖片來源/微軟

除了使用簡單、適合特定AI任務外,微軟並強調Phi-3可用於運算效能有限或離線環境,這允許資源有限的組織將之部署在成本較低的裝置以及頻寬受限的環境下,確保回應速度。

其中今天公布的Phi-3-mini具有特別輕巧、容易使用、跨平臺等特色。僅38億參數的規模使Phi-3-mini可執行於本地裝置,如筆電上,它還經過微軟推論框架ONNX Runtime優化並支援Windows DirectML,可在多種硬體平臺如CPU、GPU、FPGA甚至行動裝置上執行。Phi-3-mini也已為Nvidia GPU優化,還可作為Nvidia NIM微服務以標準API執行,可部署在任何地方。

圖片來源/微軟

另一方面,mini版Phi-3分提供二種脈絡空間(context-length)版本,分別為4K及128K token。微軟表示Phi-3-mini也是同等級模型中首個能支援到128K token的SLM。更大的脈絡賦予Phi-3-mini強大的文本輸入與理解能力,使其適合進行分析任務。

已經有企業導入Phi-3。例如印度農業集團ITC以微軟Copilot範本開發AI助理以協助當地農民,並在本地部署Phi-3。

AI PC是微軟推動本地端執行AI的計畫之一。微軟可望在下個月產品及技術大會上公布新款自家AI PC,即Surface平板及筆電,以及其他Windows 11的AI技術。

熱門新聞

2024-05-03

2024-05-03

2024-05-03

2024-05-03

2024-05-03