Opera

Opera宣布一項新功能,讓用戶可將大型語言模型(Large Language Model,LLM)下載到本機端執行或測試,不需再連上伺服器端。

大多數情況下,使用LLM必須將資料送到伺服器。本機端LLM則讓用戶可以直接在機器上處理提示,不須資料離開電腦。

在AI功能新增(Feature Drop)方案中,Opera實驗支援將近50系列、共150款本機端LLM,允許用戶透過自家瀏覽器下載。該公司表示這也是首個以內建功能支援並管理LLM的主要瀏覽器。

Opera支援本地端執行的模型,涵括Meta的Llama、Vicuna、Google的Gemma from Google及Mistral AI的Mixtral等。

新功能目前以測試版形式發布給Opera One開發人員。Opera One是這家瀏覽器業者去年6月推出的AI瀏覽器,整合原生AI技術的瀏覽器,目前整合該公司自己的AI助理Aria Chat。

今天起,開發人員可以下載Opera One開發人員版測試在本機上使用所支援的LLM及Opera實驗性AI功能。Opera希望藉這波測試探索可能的應用場景,像是瀏覽器是否可根據用戶和AI助理的對話紀錄提供服務,又能保留用戶裝置上所有資料。

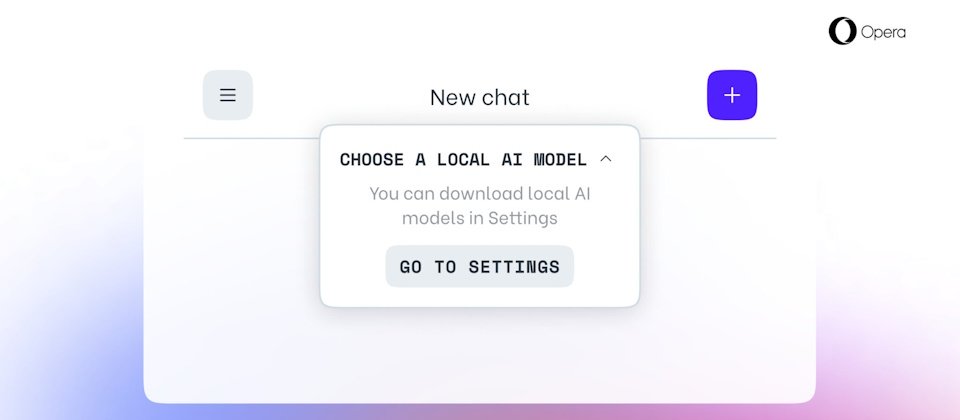

欲試用者,需先升級到最新版Opera。之後,由側邊工具欄上開啟Aria Chat,在聊天介面上方點選「選擇本機模式」的下拉式選單後,從「進入設定」選擇欲下載的模型。完成下載後按左上方的選單,啟動新對話。接著再次從「選擇本機模式」中選擇剛下載的模型,就能讓AI助理套用新模型,用於應答。

Opera提醒,下載LLM需要本機有2GB到10GB的儲存空間,而且視用戶機器硬體規格而定,在本機上執行LLM的效能會比伺服器端版本來得慢很多。此外,本機端LLM不會使用Opera的Aria,直到用戶以Aria啟動新對話,或是直接換成Aria。Opera也提醒不要安裝在營運用的機器上。

熱門新聞

2024-04-29

2024-04-29

2024-04-28

2024-04-29

2024-04-26

2024-04-26

2024-04-27