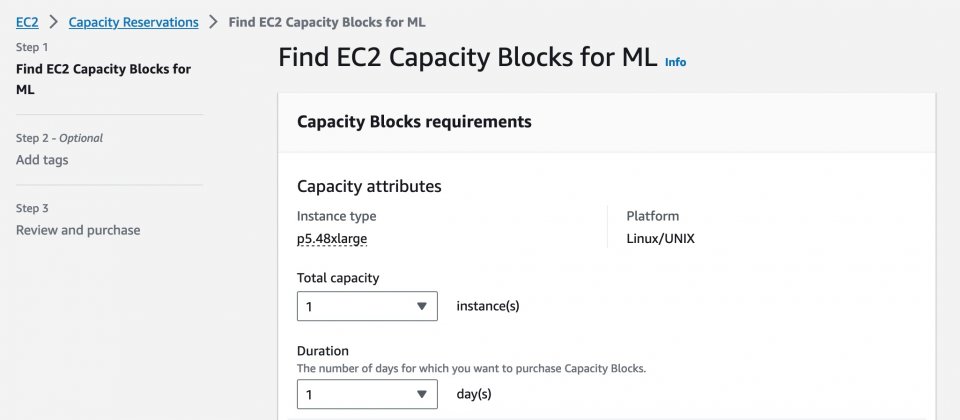

有鑒於目前GPU資源的稀缺性,AWS新推出Amazon EC2容量區塊(Capacity Blocks)功能,這是一項適用於機器學習模型開發的EC2使用模型,用戶可以在EC2 UltraCluster特殊叢集中預留需要的Nvidia GPU資源,藉由指定叢集大小、開始時間和持續時間,便能夠以可預測的方式存取GPU資源。

全世界掀起一陣人工智慧應用熱潮,不少組織開始開發機器學習模型,而AWS提到,企業對在機器學習模型的GPU容量需求,已經超過全產業的供應量,使得GPU成為稀缺資源。而這對於需要大量GPU資源,用以訓練基礎模型和大型語言模型的用戶來說,是一項需要解決的問題。

面對這樣的問題,企業可能會需要長期購買大量的GPU容量,確保在需要的時刻,有足夠GPU運算資源可以使用,但是這可能造成資源浪費,導致在未使用時出現GPU資源閒置。因此AWS現在推出EC2容量區塊模式,來解決GPU資源搶奪的問題,這是一種安排GPU執行個體的新方法,用戶可以在指定時間內保留所需要的執行個體數量。

用戶可以提前8周指定日期,存取預留的EC2容量區塊並啟動P5執行個體,持續時間可為1到14天,叢集大小為1到64個執行個體,並且只需要支付所需要的GPU時間費用。而當EC2容量區塊持續時間結束後,任何執行中的執行個體都會被終止。

這項新功能在用戶需要容量保證,以訓練和微調機器學習模型、執行實驗,或是計畫性地增加機器學習應用程式需求時特別有用。用戶可以從AWS控制臺、命令列介面和開發工具包預留可用的容量區塊,目前可以先在AWS美東地區,預留搭載Nvidia H100 Tensor Core GPU的EC2 P5執行個體,官方計畫之後也會在其他地區推出該項功能。

熱門新聞

2024-04-29

2024-04-29

2024-04-28

2024-04-29

2024-04-26

2024-04-26

2024-04-27