AWS現在正式推出在AWS re:Invent 2021大會上所發表的Amazon EC2 Trn1執行個體,Trn1採用AWS針對機器學習模型訓練所開發的客製化晶片Trainium,是AWS Inferentia推理晶片的第二代機器學習晶片,可高效能執行深度學習訓練工作負載。

Trn1執行個體適用於自然語言處理、圖像辨識這類需要大規模分散式訓練的複雜深度學習應用程式,與之前專用於機器學習訓練和高效能運算的P4d執行個體相比,Trn1執行個體在BF16資料類型提供1.4倍的teraFLOPS,而TF32資料類型則有5倍teraFLOPS,節點間網路頻寬上升至4倍,使Trn1可以部署於EC2 UltraCluster中,作為超級電腦高速訓練複雜的深度學習模型。

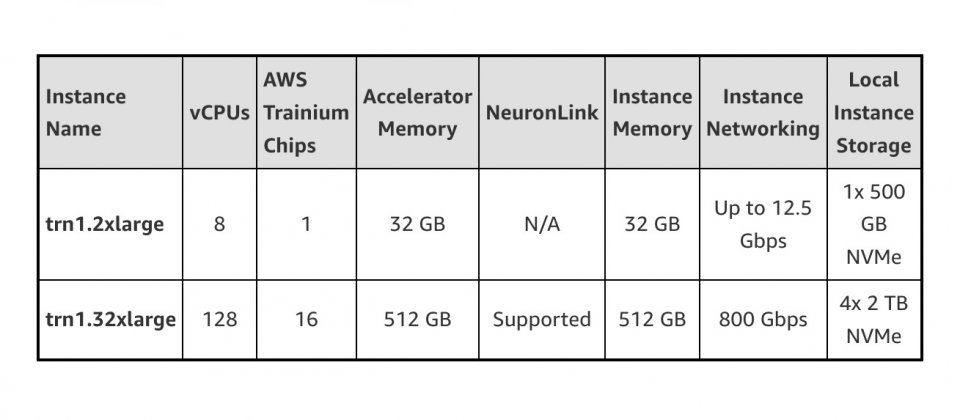

Trn1執行個體目前有兩種大小,可配置高達16個AWS Trainium晶片和128個vCPU,擁有高效能網路和儲存,支援資料和模型平行化分散式訓練政策。該執行個體擁有高達512 GB的高頻寬記憶體,TF32/FP16/BF16達3.4 petaFLOPS運算能力,且因為晶片間都以超高速NeuronLink互相連接,在跨多個Trainium晶片的工作負載可避免通訊成為效能瓶頸。

AWS提到,Trn1執行個體是第一個搭載第二代800 Gbps Elastic Fabric Adapter(EFA)網路頻寬的EC2執行個體,支援高吞吐量網路通訊。與前一代相比,第二代EFA擁有更低的延遲和高達2倍的網路頻寬。Trn1執行個體還具有8 TB本地NVMe SSD儲存,供模型高速存取超大型資料集。

針對大規模模型訓練,Trn1執行個體能夠整合Amazon FSx部署於EC2 UltraClusters中,而EC2 UltraClusters是以非阻塞PB級網路互連的超大規模叢集,使用戶藉由存取超級電腦,將原本需要數月的大型複雜模型訓練工作,縮短至數周甚至數月。

由於Trainium和Inferentia共用相同的工具包,因此對已經使用過Inferentia的用戶,也能熟悉地開始使用Trainium,在模型訓練上,Neuron SDK提供編譯器、框架擴充、Runtime函式庫和開發者工具,除了AOT編譯之外,Neuron SDK還支援JIT編譯以加快模型編譯,並支援Eager除錯模式供用戶逐步執行。

官方提到,要在Trainium上編譯和運作模型,用戶只需要更改腳本中數行程式碼就好,不需要調整模型本身或是轉換資料類型。用戶目前可以先在AWS美東北維吉尼亞,和美西奧勒岡地區啟用Trn1執行個體,與其他執行個體相同,也能以按需執行個體、預留執行個體、先占式執行個體,或以Savings Plan節省使用成本。

熱門新聞

2024-04-29

2024-04-29

2024-04-28

2024-04-29

2024-04-26

2024-04-26

2024-04-27