iThome

伺服器虛擬化與固態儲存裝置的發展,從兩個面向同時推動了高速儲存匯流排的需求。

伺服器虛擬化讓一臺實體主機,同時承載了過去由多臺實體主機負擔的任務,這也帶來了更高的運算能力與I/O頻寬的需求。

更高的運算能力需求,可透過速度更快的新一代處理器與更大容量的記憶體來滿足,但連接處理器與儲存設備間的匯流排傳輸效能若未同步提升,則儲存匯流排便會形成整體效能上的瓶頸。

在另一方面,透過以DRAM或Flash式記憶體作為儲存單元基礎,固態儲存裝置在I/O處理能力與傳輸速率方面的性能表現,都遠遠超過傳統機械式磁碟。

但在實際應用中,儲存裝置只是影響整個系統儲存效能的一個環節,當磁碟部份透過引進固態儲存裝置而大幅提高效能後,若系統其餘環節如傳輸通道、控制器等沒有跟著一起提升,整個系統的速度也將會受較慢的環節所拖累,無法發揮固態儲存裝置應有的性能。

儲存傳輸通道瓶頸已現

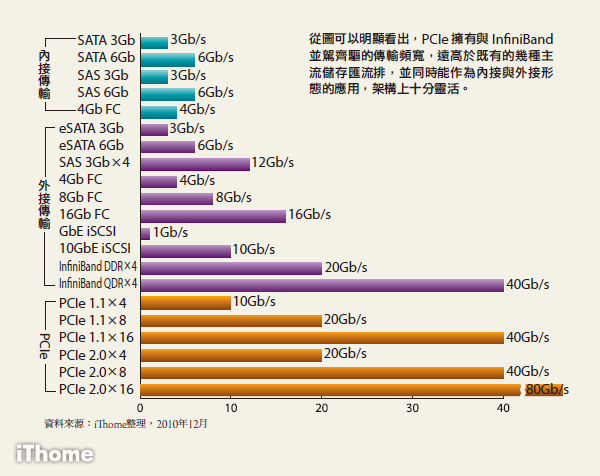

儲存傳輸通道可分內接與外接兩種應用類型,內接應用是指作為從磁碟裝置到控制器╱處理器之間的傳輸介面,目前最常見的是SAS與SATA兩種規格,其他還有光纖通道(Fibre Channel,FC)以及老舊的IDE與SCSI等規格。

外接應用則是指作為從外接儲存設備控制器到伺服器主機之間的傳輸介面,又分為直接連接儲存(Direct-Attached Storage,DAS)與儲存區域網路(Storage Area Network,SAN)等類型,屬於DAS類型的傳輸通道規格有SAS、eSATA與舊的SCSI等,屬於SAN類型的規格則有FC、iSCSI等。

前述傳輸通道規格中,除了老舊的SCSI、IDE與內接類型的FC已停止發展外,其餘規格目前仍持續不斷的更新中。以內接類型來說,SAS已發展了兩代(SAS 1.0與SAS 2.0),SATA則有4代(SATA 1.0/1.5/2.0/3.0)。在外接類型方面,兩種主要SAN傳輸協定FC與iSCSI也分別發展了數個世代,如FC已陸續推出1/2/4/8Gb等4種規格,最新的第5代16Gb規格也即將實用化,而以乙太網路為基礎的iSCSI,亦先後發展了1Gb與10Gb兩個世代。

單就傳輸通道自身來看,這樣的更新速度並不能說慢,在短短6、7年內,內接傳輸通道的頻寬就增加了至少4倍,外接傳輸通道的頻寬也增加了2~10倍。但伺服器虛擬化與固態儲存的發展,卻讓儲存傳輸通道的進步顯得黯然失色。

伺服器虛擬化需要更高I/O效能

伺服器虛擬化的目的,是希望透過虛擬主機分別獨立承擔不同工作,來提高實體主機資源使用率。從另一方面來看,實體主機每承擔1個任務,便需耗用一定的處理器效能與I/O頻寬,當透過虛擬化使其虛擬為2臺虛擬主機分別承擔2個任務時,若欲維持原有服務等級,則需要耗用的處理器效能與I/O頻寬也會跟著加倍。

換言之,要讓實體主機承載更多虛擬主機,便需提供更多的運算與I/O資源。但顯然的,伺服器運算效能的提高,遠比I/O頻寬的增加更為容易。

依照摩爾定律,處理器效能每18個月就能增加一倍,I/O頻寬的提升速度卻遠低於此。如SAS介面從3Gb/s進化到6Gb/s就花了5~6年,從SATA 3Gb/s到SATA 6Gb/s也花了5年多。

再來看外接介面,FC規格亦是以每3~4年發表新一代規格的速度更新,也就是說要每4年左右才有頻寬提高一倍的新規格可用。而在承載iSCSI協定的乙太網路方面,雖然是以每次提高10倍頻寬的速度更新,且10GbE規範發布時間也只與GbE相隔3、4年,但過了6、7年後,10GbE仍不能取代GbE的地位。

換言之,儲存匯流排的進步速度,要遠低於處理器效能的進步速度,儲存I/O往往跟不上處理器性能的提升,以致成為效能瓶頸所在。因此在伺服器虛擬化應用中,經常出現的問題便是在處理器效能尚未被充分運用之前,儲存I/O頻寬早已先一步被壓榨殆盡。若無法克服儲存傳輸頻寬問題,將會限制伺服器虛擬化的進一步應用。

既有傳輸介面無法滿足固態儲存應用

在以前機械式硬碟當道的時代,受限於機械結構,硬碟存取速度的進步十分緩慢,儲存匯流排面臨的效能壓力相對也較為和緩。然而當固態儲存技術興起後,磁碟存取速度有了成百上千倍的急遽提升,頓時也凸顯了儲存匯流排傳輸頻寬不足的問題。

以內接通道來說,新的SAS 2.0與SATA 3.0頻寬均可達6GT/s,單一通道能提供600MB/s資料傳輸率;在外接通道方面,目前速度最快的FC與iSCSI通道傳輸規格,每個通道分別擁有8Gb/s與10Gb/s頻寬,有效資料傳輸速率分別為800MB/s與1GB/s。

但當前一些以速度為訴求的企業級固態硬碟產品,已可達到單一模組即擁有1~1.5GB/s以上的持續存取速率,透過多模組還能將性能進一步提升到4~6GB/s之譜,次一級的產品速度亦能達到500~700MB/s,即使是主打消費端的低階固態硬碟,傳輸速率也有200MB/s左右的能力。這樣的傳輸性能,明顯已遠遠超出前述主要儲存通道規格的吞吐能力上限。

這意味著,只要1、2臺高性能固態硬碟組成的系統,就會填滿目前主要儲存傳輸通道所能提供的頻寬,若要使用固態硬碟組成規模較大的陣列,現存的幾種傳輸通道規格根本無法滿足頻寬需求。

理論上,我們可以透過匯集多條通道的方式來取得更大的傳輸頻寬,如匯集2條8Gb FC或10Gb乙太網路,便能提供1.6GB/s或2GB/s的傳輸頻寬。然而即使採用這種方式,要應付不斷成長的效能需求仍相當吃力,而且還有布線複雜性與成本增加的副作用—將多條8Gb FC或10GbE線路匯集為單一通道,該通道的平均成本之高將相當驚人。

利用InfiniBand突破傳輸瓶頸

為提供比主流儲存通道更大的頻寬,有些廠商曾引進了InfiniBand規格作為儲存傳輸介面。

InfiniBand問世已超過10年。既可作為內接通道,用於伺服器內部、作為CPU與儲存裝置間的連接介面;亦可作為外接通道,用於伺服器與伺服器之間、或伺服器與儲存設備間的連接介面。

以InfiniBand最基本的SDR模式而言,每個通道均以2.5Gb/s速度運行,有效資料傳輸速率為500MB/s,4個鏈接(4×)的速率即有10Gb/s,12個鏈接(12×)的速率則能達到30Gb/s。除了SDR以外,InfiniBand還有DDR、QDR等作業模式,速度分別為SDR的2倍與4倍,故12×的QDR模式可提供高達120Gb/s的傳輸速率。

就規格上來看,除了仍在初期發展階段的40Gb與100Gb乙太網路外,InfiniBand可說是當前速度最快的匯流排規格。

理論上,InfiniBand可直接內建在伺服器主機板上,利用其高頻寬讓CPU與儲存裝置之間的I/O匯流排,擺脫PCI、PCI-X等相對低速通道對伺服器I/O造成的效能限制。但受限於成本,實務上InfiniBand仍是透過介面卡的形式來為伺服器提供連接埠,因此目前InfiniBand在應用上主要是作為一種外接匯流排,在伺服器端的實際傳輸能力,亦會受介面卡使用的PCIe匯流排限制。

目前InfiniBand的相關產品包括HCA卡(主機通道配接卡)、交換器與導向器,主要供應商包括Voltaire、Mellnaox與QLogic等。目前較常見的規格是4×DDR或4×QDR,運作速度為20Gb/s與40Gb/s。

InfiniBand HCA卡大都採用PCIe 2.0 ×8或×16規格介面,可為伺服器提供1或2個InfiniBand連接埠。InfiniBand交換器則能提供至少36個InfiniBand埠(以Voltaire與QLogic產品為例),導向器能支援的InfiniBand埠,則多達162、324、或648個(以Voltaire產品為例)。

顯然的,若以InfiniBand作為儲存傳輸通道,將可提供遠高於既有儲存匯流排的傳輸吞吐性能,一條4×DDR或4×QDR的速度就超過8Gb FC或10Gb乙太網路2到4倍以上。某些廠商如Mellanox也曾倡導InfiniBand的儲存應用解決方案,包括以InfiniBand取代FC的InfiniBand SAN等。

就單位傳輸速度成本而言,InfiniBand事實上還比FC更便宜,以伺服器端來說,單埠InfiniBand HCA卡的價格大約在600~800美元之間,雙埠HCA卡則在800~1,000美元左右,與4Gb或8Gb FC HBA卡相去不遠,InfiniBand HCA卡的單埠速度卻快了數倍,故每GB/s單位傳輸頻寬所需的價格反而更低。

雖然在伺服器端導入InfiniBand HCA卡沒有太大困難,然而在儲存設備端,直接支援InfiniBand規格的儲存產品卻相當稀少,只有Texas Memory Systems、LSI、Datadirect Nteworks、Cirrascale、Violin Memory等非主流的儲存廠商,可提供原生的InfiniBand介面SAN或檔案儲存系統,選擇相對少了許多,價格亦相當高。加上交換器等設備的費用,原生InfiniBand儲存環境的建置成本要比FC高出不少。

從InfiniBand到PCIe

InfiniBand曾一度被視為FC介面的有力競爭者,但經過多年發展,InfiniBand的儲存應用仍未能打開局面,僅在高效能運算領域較為成功(作為叢集伺服器之間、以及伺服器與儲存設備間的連接),未能成功進入企業應用。

儘管InfiniBand未獲企業普遍應用,但企業對於更高頻寬儲存匯流排的需求仍然存在,如一些希望透過導入固態硬碟藉以提高I/O效能的用戶,以及一些從事影音後製或串流服務的用戶,都需要更大的儲存傳輸頻寬,但透過匯集多條8G FC或10GbE成為單一大頻寬通道所帶來的高成本,又讓人難以接受。

面對這樣的情況,一些廠商選擇了以PCIe匯流排作為突破口。利用PCIe作為儲存傳輸通道有幾項優勢:

大頻寬

相對於既有的幾種儲存通道,PCIe最大賣點就是大頻寬。最常見的PCIe 1.1就有2.5GT/s傳輸率,單通道資料傳輸率為250MB/s,4個鏈接(×4)就能提供高達10Gb/s的頻寬與1GB/s資料傳輸率,×8與×16規格的傳輸頻寬更達到20Gb/s與40Gb/s。

PCIe 2.0規格則將傳輸率進一步提升到5GT/s,單通道資料傳輸率達500MB/s,較PCIe 1.1提高一倍,×4、×8與×16規格的PCIe 2.0頻寬亦分別增加到20Gb/s、40Gb/s與80Gb/s。

所以只要採用×4或×8的PCIe匯流排作為儲存傳輸介面,就能獲得比既有任何儲存傳輸通道規格更大的頻寬,即使只是基本的PCIe 1.1 ×4規格,其10Gb/s的頻寬,作為內接應用時比6Gb/s的SAS 2.0或SATA 3.0高出66%,作為外接應用時,亦能提供與10Gb乙太網路等同的理論頻寬。若改用更高的×8規格或PCIe 2.0,還能提供直追InfiniBand的傳輸效能。

儘管其他傳輸通道規格也仍持續不斷在更新升級,如下一代的SAS與SATA預期可有12Gb頻寬,FC也已有新的16Gb規格,40Gb與100Gb的乙太網路亦正在發展中,但這些新規格離實際上市與普及到第一線應用仍有很長的距離,且效能也未能超過PCIe。

相對的,PCIe是現在就立即可用的,除了已有的PCIe 1.1與PCIe 2.0外,新一代的PCIe 3.0預定在今年年底完成制定,可將傳輸率提高到8GT/s,可用的資料頻寬比PCIe 2.0又提高了一倍,進一步拉大了與其他傳輸規格之間的差距。

基礎架構普及

PCIe第二項優勢是普及,由於PCIe已成為當前x86與x64架構的基本匯流排之一,所有主機板的晶片組都能支援PCIe,並提供至少1組×16與1或2組×8規格的PCIe插槽。

作為內接應用時,只要PCIe介面的儲存裝置安插在PCIe插槽上,並搭配適當的驅動程式即可運作;作為外接應用時,也只需要透過廠商提供的轉接介面卡,就能將PCIe轉為外接介面使用(類似e-SATA外接埠的模式)。使用者需要投入的配套設備成本相對少了許多。

相比於其他儲存傳輸通道規格,PCIe的普及性優勢非常明顯,以內部I/O匯流排來說,只有SATA的普及度可與PCIe相比,而更勝於SAS——只有伺服器級主機板才會提供內建的SAS介面,未內建者必須透過安裝額外的介面卡才能支援SAS介面。

與FC或乙太網路等外部傳輸匯流排規格相比,也只有1Gb乙太網路擁有類似PCIe或SATA的普及性——幾乎所有主機板都內建了GbE晶片與GbE埠。但GbE所能提供的頻寬遠低於PCIe,而速度更快的10GbE卻又缺乏普及性,必須安插昂貴的10GbE網路卡才能取得10GbE連接能力。

可同時作為內外部儲存I/O應用

如前所述,既有的儲存傳輸通道規格在應用上有三種類型:一為作為內部I/O通道,二為作為DAS類型的外接傳輸通道,三為SAN類型的外接網路傳輸通道。許多規格都可以同時支援數種應用類型。

如SATA既可作為內接、用於主機內部從磁碟到CPU間的連接介面,亦有e-SATA規格可將SATA轉為外接介面,提供一種DAS形態應用的傳輸通道。

SAS的應用涵蓋範圍還比SATA更廣,不僅可作為主機內部從磁碟到CPU間的連接介面,也能作為DAS形態的外接傳輸通道,用於取代舊的SCSI規格。更特別的是還能作SAN傳輸通道使用,LSI公司已推出了SAS交換器,可用於連接多臺SAS介面儲存裝置與主機,並支援分區(Zoning)功能,從而構成一種簡單的SAN環境。

至於FC與乙太網路,則主要是作為外部外接傳輸通道使用(FC也作為從I/O處理器到磁碟之間的內部I/O匯流排應用類型,但這只用於光纖磁碟儲存裝置,而沒有用在一般的伺服器主機上)。

而PCIe的應用涵蓋面向則與SAS相似,可用於主機內部的儲存I/O,如許多廠商推出的PCIe SSD卡,就是透過PCIe介面直接與伺服器處理器連接;亦可作為外部儲存傳輸介面使用,已有少數廠商推出利用PCIe的外接儲存解決方案,透過專屬PCIe介面卡可將PCIe轉為外接網路介面,並提供DAS與SAN兩種類型的應用。

當然將PCIe應用於儲存設備的傳輸介面,亦存在幾項缺點:

搶占數量有限的PCIe插槽

無論是內接式或外接式的PCIe儲存應用,都需要占用伺服器主機板的PCIe插槽,1片PCIe SSD卡會占用1個槽,某些支援多卡式架構的PCIe SSD產品還會占用到2個槽,而外接用的PCIe網路卡同樣也需要占用1個槽。

然而多數伺服器能提供的PCIe插槽數量都是有限的,被PCIe儲存應用占去PCIe插槽後,其餘設備所能使用的插槽數量便減少了,以致影響到其他同樣需要PCIe插槽的介面卡使用,如顯示卡或10GbE網路卡等。

外接式應用缺乏統一標準

目前PCIe外接應用仍處於早期發展接段,除了透過×4或×8的PCIe介面轉為外接這點不變外,其餘包括主機端的介面卡、連接埠,到纜線、交換器、管理軟體在內的各環節仍缺乏統一標準,各廠商產品之間不具備相容性,用戶選擇相當少。

PCIe儲存設備發展概況

利用PCIe作為儲存傳輸通道的儲存解決方案,問世已有2~3年時間,無論內接式或外接式應用,都有廠商能提供相關產品。

內接儲存應用

最普遍的PCIe內接式儲存應用是SSD卡,利用PCIe的高頻寬,可讓SSD擺脫SATA或SAS介面的制肘,從而得到驚人的性能表現。

一般最常見採用SATA 2.0介面的SSD產品,讀取與寫入速度最快大約可分別達到250MB/s與100~200MB/s左右,而採用較新的SAS 6Gb/s介面的SSD,讀取與寫入速度則能達到350MB/s與300MB/s的水準。

但採用PCIe介面的SSD卡,入門級產品就可擁有500MB/s與300MB/s的讀寫速率,中階產品的讀取與寫入速度則達到700MB/s與500MB/s的水準,高階產品甚至有1~1.5GB/s以上的讀取/寫入速度。某些產品還能透過多介面卡平行處理架構,從而得到2~3GB/s以上的驚人資料吞吐量,最高性能的產品可達到5~6GB/s之譜。

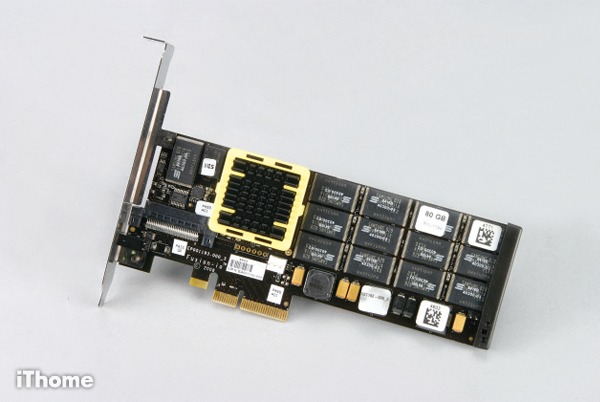

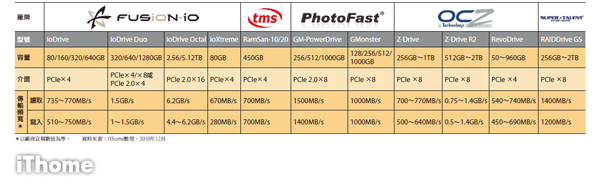

目前多數PCIe SSD卡大都採用PCIe 1.1的×4或×8規格,部份產品則採用PCIe 2.0的×4、×8甚至×16規格。主要的PCIe SSD供應商則有Fusion-io、Texas Memory Systems、Photofast、OCZ與SuperTalent等。我們將這些廠商的主要產品整理成表。

外接儲存應用

如前所述,PCIe傳輸通道的外接儲存應用有DAS與SAN兩種類型,DAS類型是以一對一連接的方式,直接透過PCIe纜線連接伺服器主機與外接磁碟陣列,通常必須在伺服器主機上安裝廠商提供的PCIe配接卡。

SAN類型則是透過PCIe交換器或閘道器介接主機與外接磁碟陣列,可達到資源共享與統一管理的效果。

目前PCIe外接儲存應用仍在起步階段,供應商仍不多,主要有國內的世仰科技(Accusys),以及NextIO、Violin與Virtensys等外商。由於各廠商的產品型態差異頗大,我們另外在獨立的邊欄中加以介紹。

仍待規範化的PCIe儲存

儘管以PCIe匯流排為基礎的儲存設備近來有了很大的發展,投入廠商漸增,使用者的選擇也增加了許多。但就像許多新型介面剛發展的初期情況,PCIe儲存設備目前存在著缺乏共通性的問題。

以內接應用的PCIe SSD卡來說,當使用者將SSD卡安裝到伺服器上後,還須依作業系統類型安裝適用的驅動程式,才能加以啟用,不同廠商各有自身的驅動程式,安裝便利性明顯不如一般的SAS/SATA硬碟。

而就外接式的PCIe設備來說,除了底層採用PCIe匯流排這點相同以外,個別廠商的產品各不相容,因此使用者只能以「整套解決方案」的方式引進,無法像購買FC或iSCSI設備一樣,視情況混合搭配不同廠商產品,便利性與選擇彈性都相當低。

顯然的,這種不相容的問題,勢必會限制PCIe儲存的進一步發展。而相容性問題的解決,仍有待相關標準制訂單位的協調,如制定作業系統共通的PCIe SSD驅動程式規範,以及統一的PCIe外接介面規格等,如此才能讓PCIe儲存走出目前的專屬產品規格階段,成為可被企業廣泛應用的儲存規格。

21種既有主要儲存匯流排頻寬比較

PCIe SSD實測:Fusion-io ioDrive 80

為體驗PCIe儲存設備的效果,我們這次分別借測了一款PCIe內接應用與一款PCIe外接應用儲存產品。針對內接應用,我們借測的是Fusion-io的ioDrive 80 PCIe SSD卡。

ioDrive是Fusion-io的入門級PCIe SSD卡,有80、160、320與640GB等4種容量,80與160GB容量採用SLC顆粒,320與640GB則採用MLC顆粒,介面卡規格均為PCIe×4,驅動程式可支援Windows與Linux。

我們測試的是80GB的款式,將SSD卡插入PCIe插槽,然後開機、安裝驅動程式後,作業系統就能對ioDrive 80進行初始化與格式化,格式化後的實際可用容量大約為40GB,整個安裝程序相當簡單。

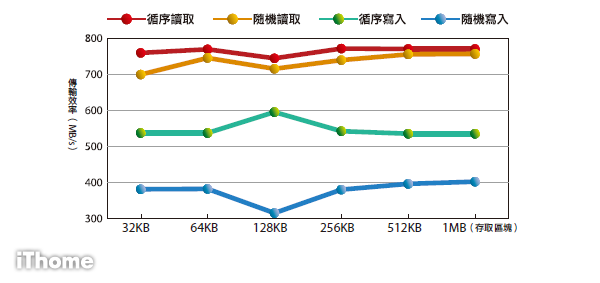

我們測試了ioDrive 80的I/O處理效能與資料傳輸率,從測試結果可發現,SSD的效能十分穩定,無論循序或隨機存取都能保有相近的性能,不像傳統機械式硬碟有隨機存取效能大幅衰落的情形。在512bytes隨機存取測試中的讀取與寫入I/O處理能力分別達到13萬與9萬,比我們用來作為對照的7200轉SATA硬碟快了250倍以上。

而在資料傳輸率方面,藉由PCI-e介面的高頻寬,一片ioDrive 80就可達到循序讀寫每秒770/530MB、隨機讀寫每秒740/380MB以上的速度。對照採用傳統硬碟的磁碟陣列,一套3U或4U磁碟陣列(含16到24臺硬碟)在循序存取時要達到與ioDrive 80相當的500~700MB/s傳輸率並不難,但在隨機存取時的傳輸率就會掉到只剩幾十MB/s的程度,隨機存取傳輸率只有ioDrive 80的1/10到1/20以下。

測試平臺:華碩RS700-E6,Intel Xeon E5620 2.4GHz×2,24GB RAM,Windows Server 2008

測試工具:iometer 2007.30

產品資訊:原廠●Fusion-io 代理●立捷速能 電話●(02)2768-1027

Fusion-io ioDrive 80 測試結果

11款主要PCIe SSD產品概覽

PCIe外接儲存產品概覽

目前PCIe外接儲存設備供應商主要有世仰科技(Accusys)、NextIO、Violin Memory與Virtensys等幾家,其中世仰與NextIO都能提供包括儲存裝置與交換設備在內的DAS與SAN解決方案,Violin Memory僅提供直接連接用的DAS解決方案,Virtensys則是提供一種I/O虛擬化的閘道設備。

世仰科技

世仰的PCIe儲存產品分為ExaRAID與ExaSAN等兩大系列,前兩款是DAS架構,後者則為SAN架構。

ExaRAID系列包括一系列採用4U/24Bay、3U/16Bay、2U/12Bay機箱的磁碟陣列,其中4U與3U款式,都有單控制卡與雙控制器卡等兩種架構,可支援SATA硬碟,套件中還有搭配主機端使用的單埠PCIe×4與雙埠PCIe×8介面卡,較舊的機型為PCIe 1.1規格,最新的ExaRAID則能支援PCIe 2.0。

ExaSAN則是ExaRAID的延伸,除了ExaRAID磁碟陣列與PCIe主機端介面卡外,另外還包括ExaSAN G1與ExaSAN G2兩種交換器,其中G1用於連接磁碟陣列,G2用於連接主機端,然後G1與G2再彼此互連。透過G1、G2交換器與SAN管理軟體,即可建立一個簡單的PCIe SAN環境。

最新一代的ExaSAN已能支援PCIe 2.0規格,進一步提高了可用頻寬。

NextIO

NextIO的PCIe產品,分為vSTOR S100系列儲存伺服器與ExpressConnect系列I/O交換設備。

vSTOR S100是以PCIe SSD卡為基礎組成的DAS架構外接儲存系統,一共有10款型號,在3U的機箱內可安插多片PCIe SSD卡(由Fusion-io與Texas Memory Systems提供),可提供900GB到7TB的儲存容量,每組機箱擁有1~5組連接主機用的PCIe×8埠,只要在主機端安裝配套的PCIe介面卡,就可連接存取vSTOR S100。

ExpressConnect系列則是基於NextIO所謂vConnect PCIe I/O虛擬化技術的交換器,含有連接前端主機用的PCIe埠,交換器機箱內則有多個PCIe插槽,可安裝不同類型連接技術的介面卡,如乙太網路、FC、InfiniBand等。前端主機可透過PCIe纜線連接ExpressConnect交換器,然後再透過交換器介接其他I/O介面的儲存設備。

藉由vConnect I/O虛擬化技術,伺服器主機不再需要安裝多種不同連接技術的介面卡,只要安裝1張PCIe介面卡並接上ExpressConnect交換器,透過交換器的介接就可存取FC、iSCSI等不同介面的儲存裝置,並能利用交換器的管理功能,靈活的調整前後端不同伺服器與儲存設備間的映射關係。

Violin Memory

Violin Memory是專注於固態儲存設備的廠商,可提供採用PCIe介面的DAS架構儲存陣列,或是採用4G/8G FC或10Gb iSCSI介面的SAN架構儲存陣列。

針對我們這次著重的PCIe介面,Violin Memory有Violin 3200與Violin 3140兩款產品。

Violin 3200可在3U機箱內安裝容量1TB~10.5TB的固態儲存模組,每組機箱可提供1或2組PCIe×4或 1組PCIe×8介面;Violin 3140同樣採用3U機箱,但最大容量可達到40TB,同樣含用於連接主機的2組PCIe×4或 1組PCIe×8介面。這兩款產品也都有支援FC或SAN架構的款式。

Virtensys

Virtensys的PCIe應用產品是VIO-4000系列I/O虛擬化交換器,這系列產品在概念上與NextIO的ExpressConnect交換器十分類似,交換器本身含有用於連接前端主機的PCIe 2.0×4介面,以及連接後端儲存設備用的iSCSI/乙太網路埠與FC埠。利用VIO-4000交換器的介接,前端主機只需要安裝1張PCIe卡,就能存取後端不同介面規格的儲存設備,從而解決主機端擴充插槽數量不足的困擾,並簡化多種不同規格設備並存的連接管理複雜性問題。

熱門新聞

2025-12-12

2025-12-16

2025-12-17

2025-12-15

2025-12-15

2025-12-16