放眼商用與企業級GPU的軟硬體技術發展,Nvidia堪稱是投入時間最久、持續經營程度最理想,應用層面最廣泛且深入的IT廠商,從專業繪圖處理的領域,一路拓展到GPU虛擬化、資料科學與AI軟體的支援,可運用GPU的環境,也從辦公室的工作站、資料中心的伺服器,如今也延伸到雲端服務、邊緣運算裝置。

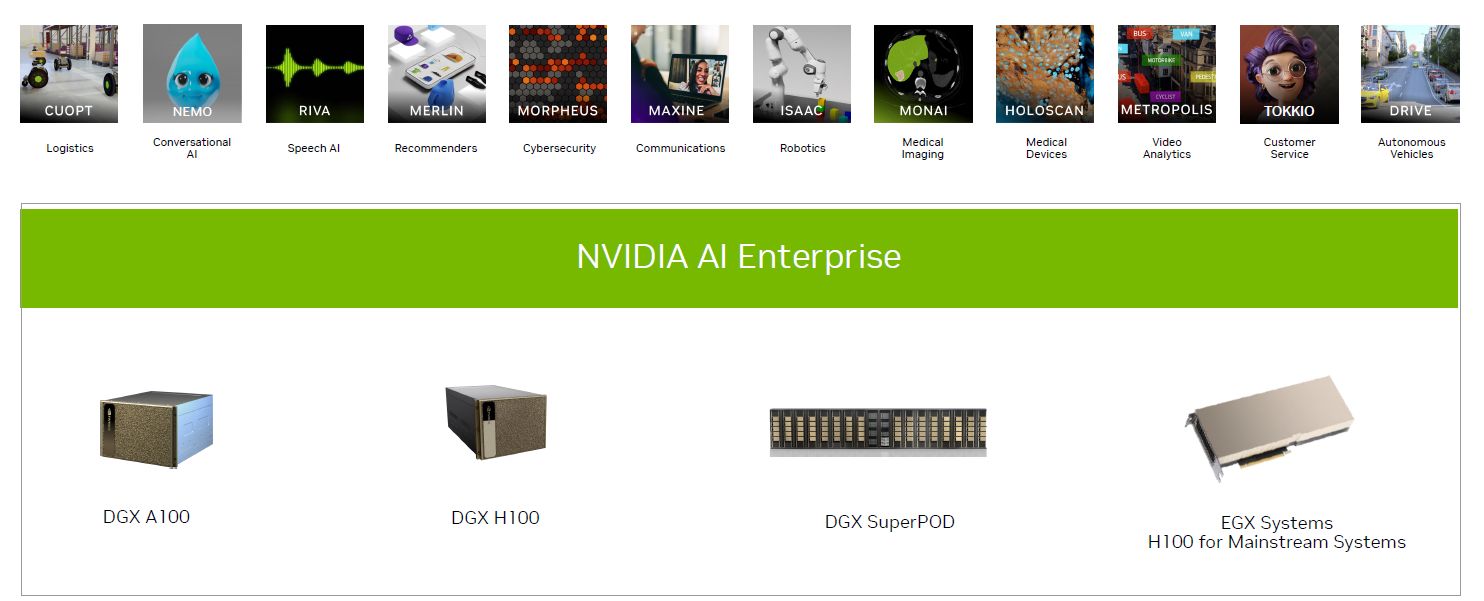

基於這樣的長期布局,以及建構企業級AI軟硬體廠商生態系的需求,Nvidia近年來持續推動相關的整合解決方案,DGX系統就是典型的例子,從AI整合應用伺服器,已陸續衍生出工作站DGX Station、整櫃式套件DGX POD與DGX SuperPOD。

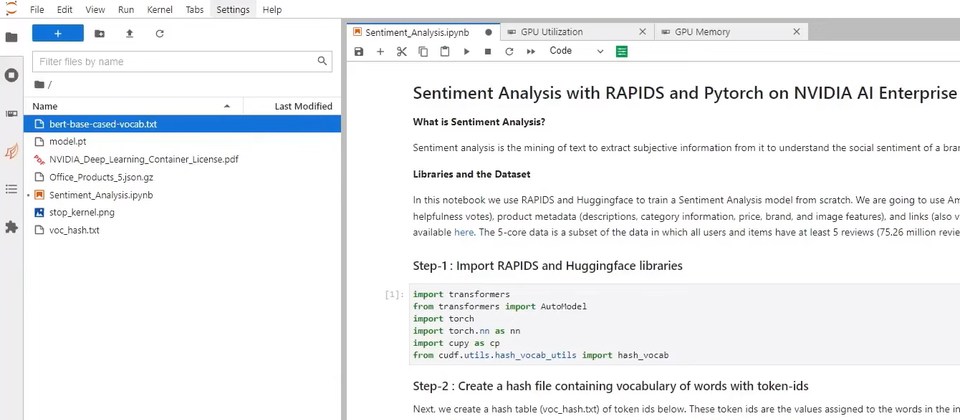

除此之外,他們在去年3月與VMware共同發表一款整合軟體平臺套餐,名為Nvidia AI Enterprise,當中包含多種企業級AI工具與框架軟體,它們均為經由Nvidia進行驗證、調校與支援的軟體,並搭配企業級伺服器虛擬化平臺VMware vSphere的最新版本7.0 Update 2。

同年8月,Nvidia AI Enterprise正式推出,Dell、技嘉、HPE、Supermicro等多家伺服器廠商也響應Nvidia的號召,提供通過NVIDIA-Certified認證的伺服器系統設備,可用於執行VMware的虛擬化平臺與Nvidia的AI軟體套餐,提供最佳化的AI工作負載執行。

持續擴充與更新支援的GPU硬體、GPU系統軟體環境,以及深度學習與資料科學軟體套件

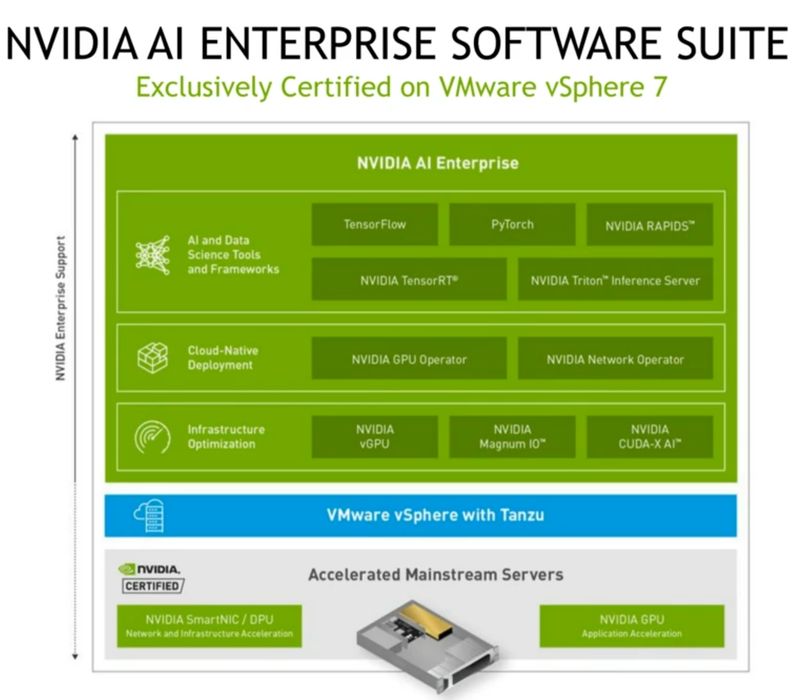

從Nvidia AI Enterprise的文件網站來看,這款軟體平臺正式發布1.0版的時間是2021年11月,截至目前已有1年半,這段期間總共經歷了5次改版,最新版本是今年8月推出的2.2版。

在每次發行的新版中,Nvidia主要的改善是增加支援的GPU、伺服器虛擬化軟體(Hypervisor)、虛擬機器的作業系統、伺服器裸機的作業系統,而在自家的系統與應用軟體套件搭配上,諸如GPU Operator、vGPU software、Deep Learning Frameworks、RAPIDS,也經常會換成當時推出的最新版本,維持整體軟體支援的一致性。

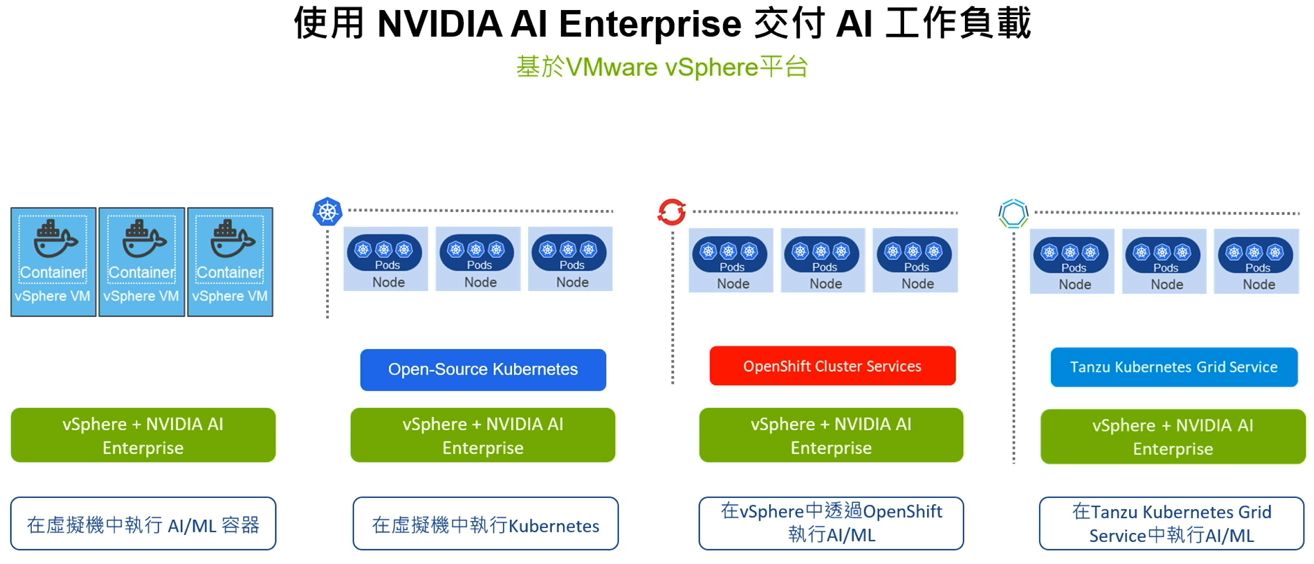

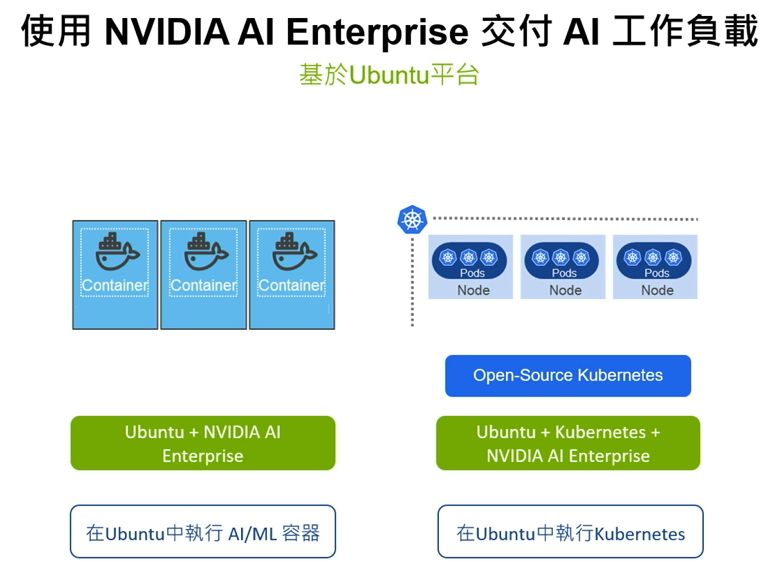

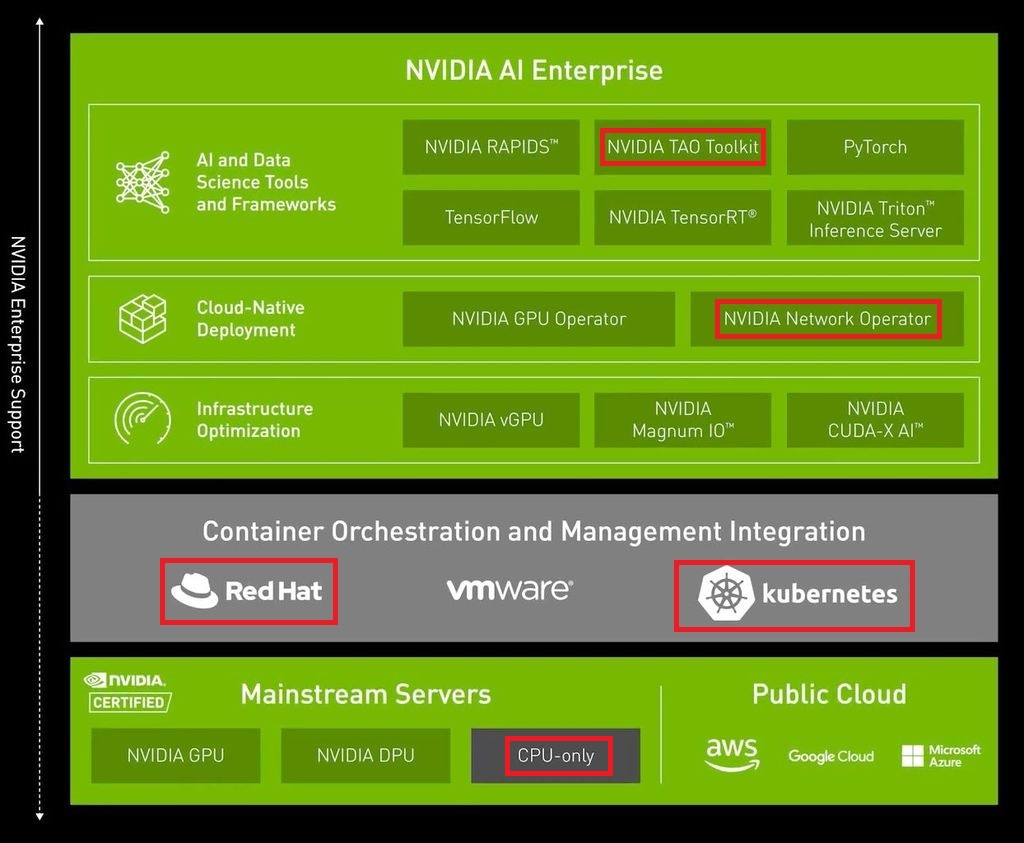

以Nvidia AI Enterprise各版本對於系統平臺支援的狀況而言,腳步也相當快速。例如,今年初登場的1.1版,已涵蓋VMware vSphere with Tanzu、vSphere 7.0 Update 3、Red Hat Enterprise Linux 8.4;6月發行的2.0版,可搭配紅帽OpenShift 4.9以後的版本,內建Nvidia GPU Operator、Nvidia Network Operator等軟體元件;7月發表的2.1版,則能使用Ubuntu 22.04 LTS、Red Hat Enterprise Linux 9.0。

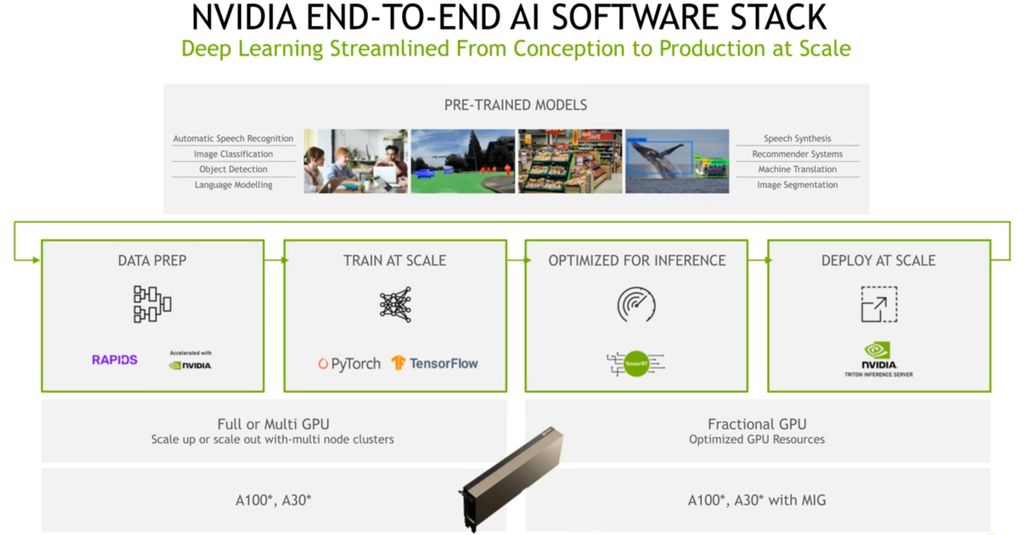

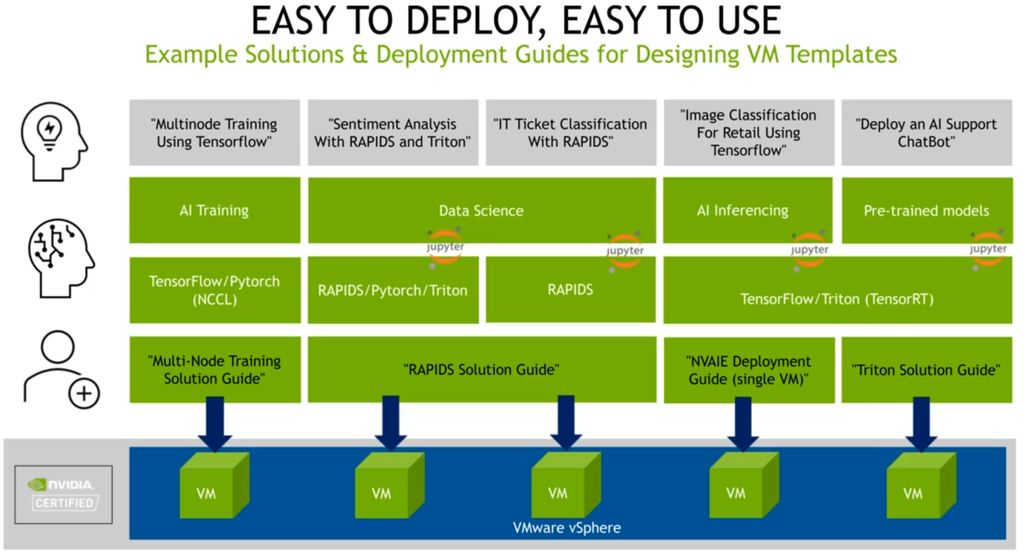

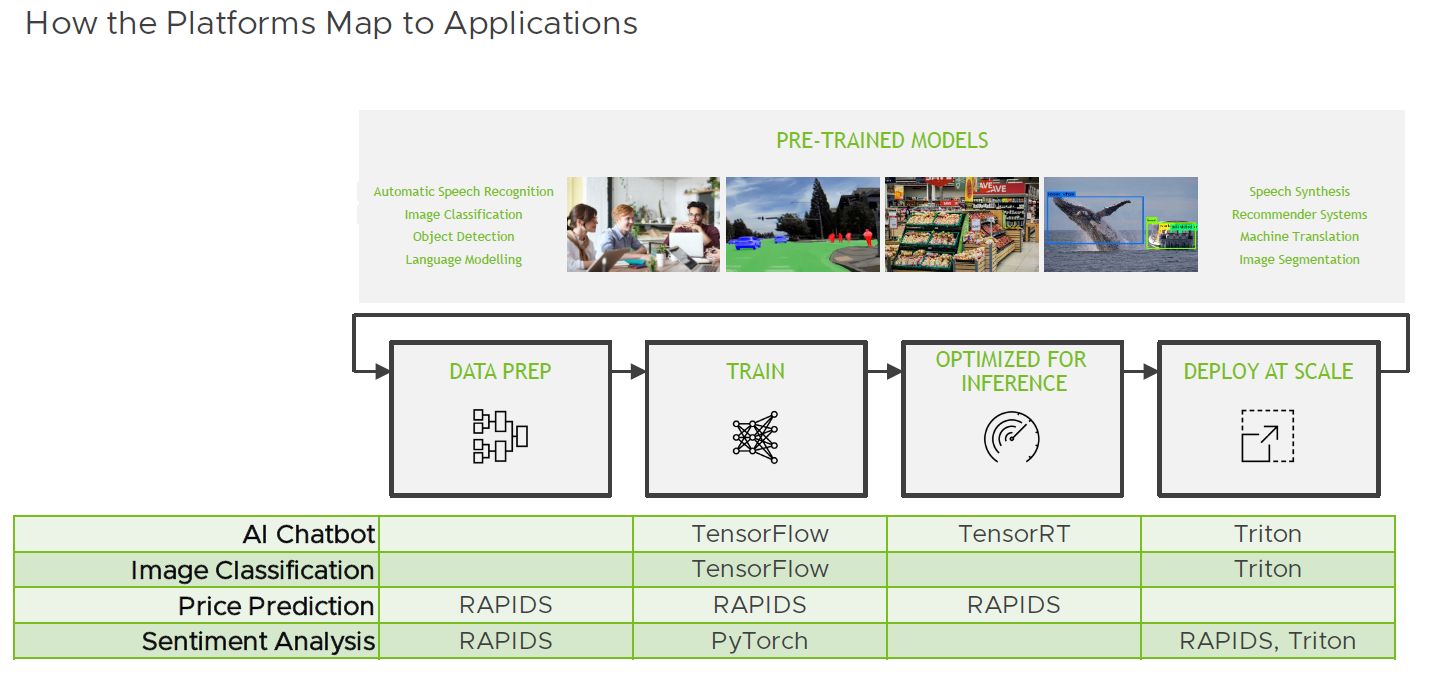

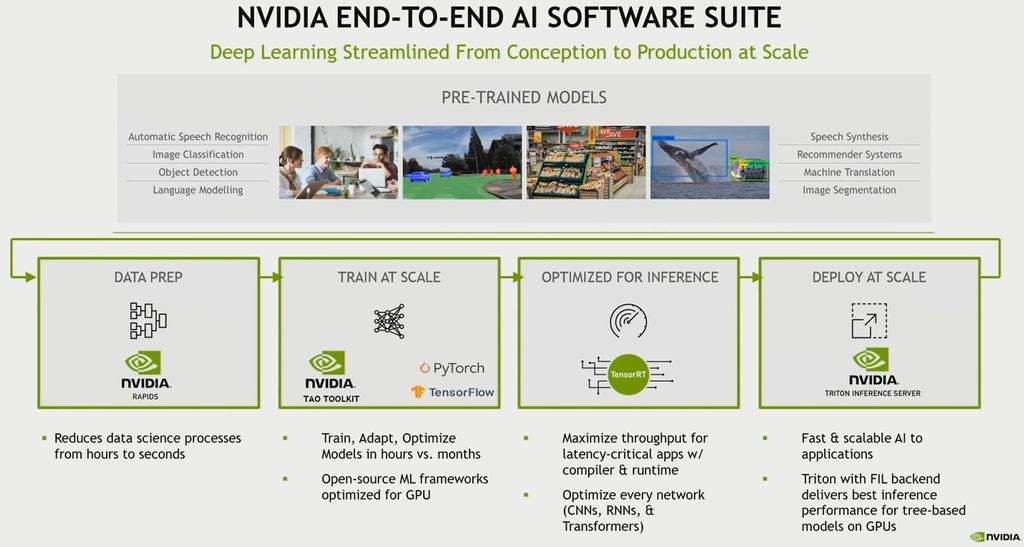

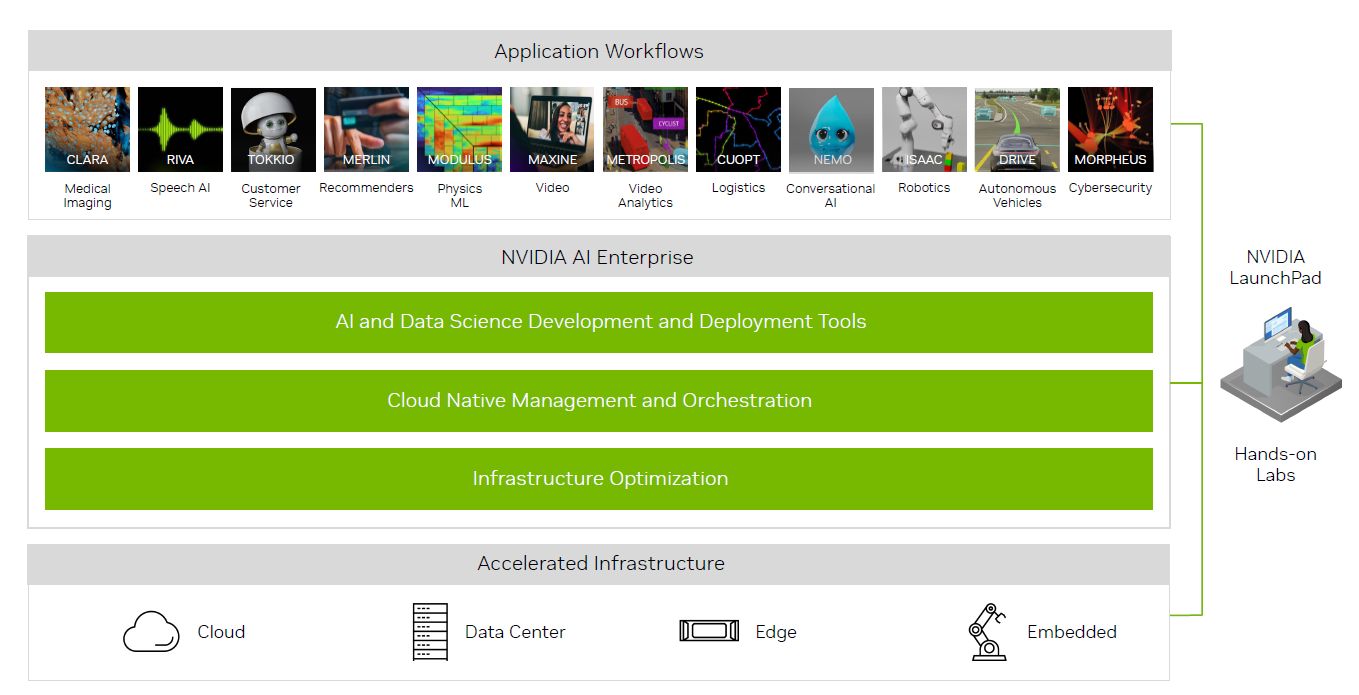

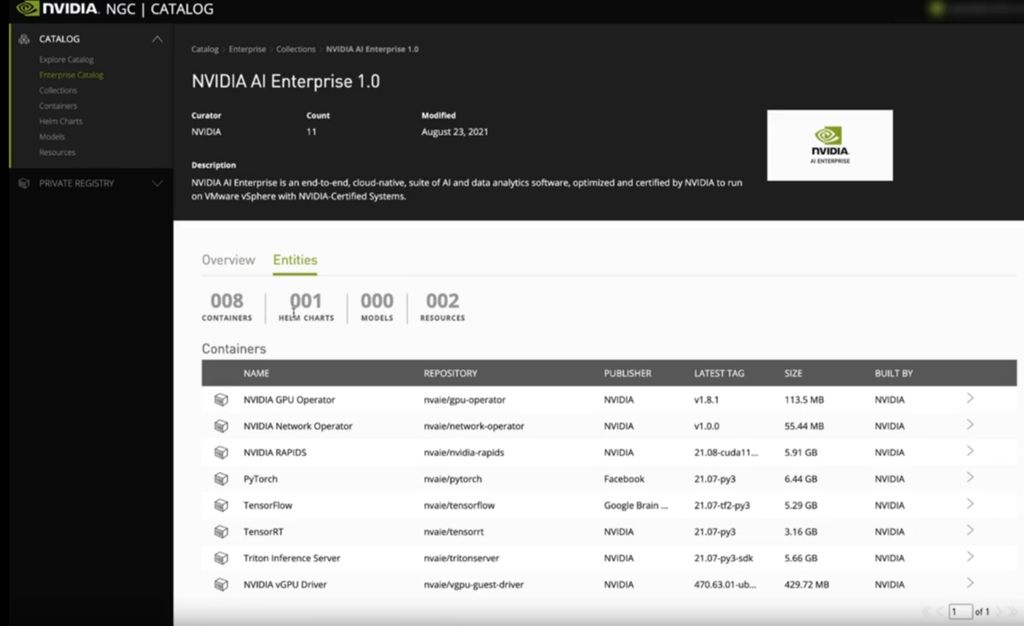

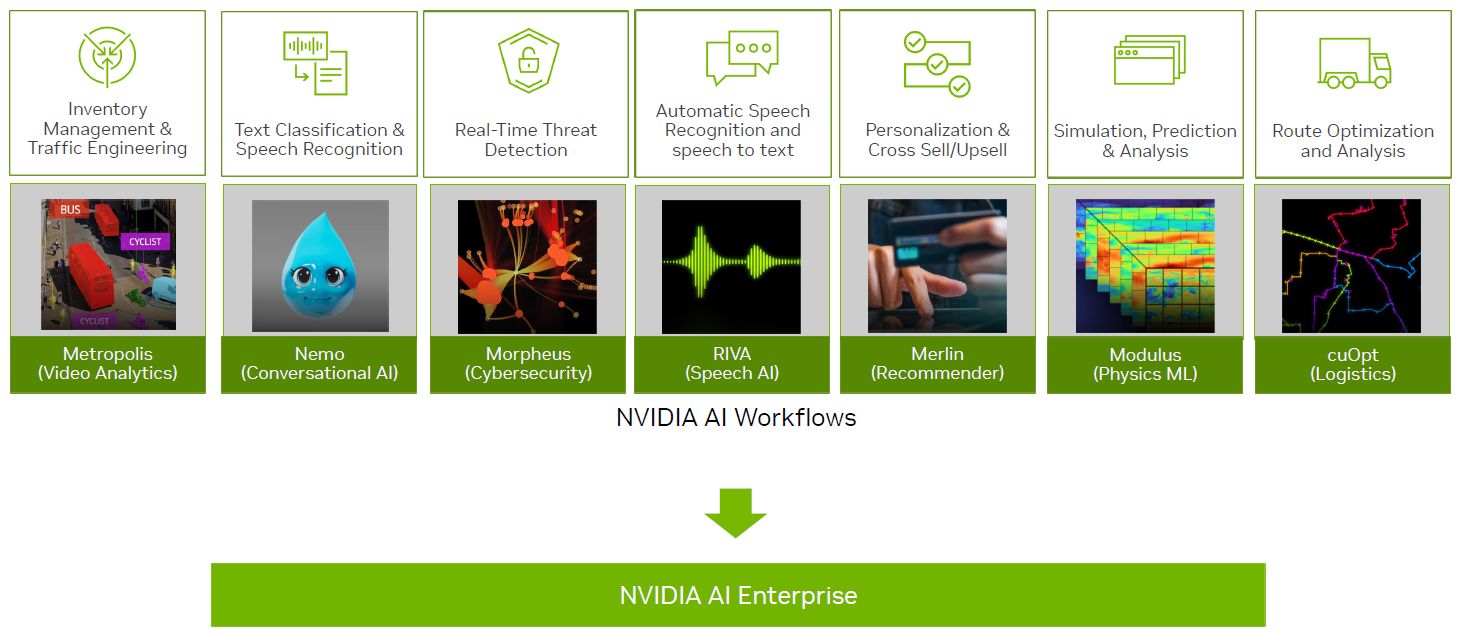

關於AI軟體支援方面,Nvidia AI Enterprise 1.0支援開放原始碼的TensorFlow、PyTorch,以及Nvidia主導的Triton Inference Server、TensorRT、RAPIDS;2.0開始支援TAO Toolkit,以及基於CPU架構運作的深度學習框架與資料科學軟體容器,可用於一般未搭配GPU的伺服器。

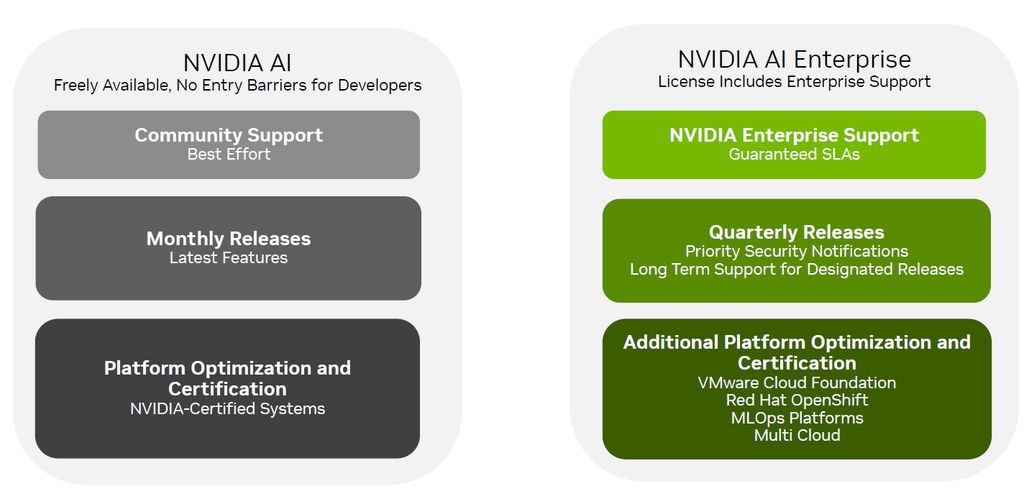

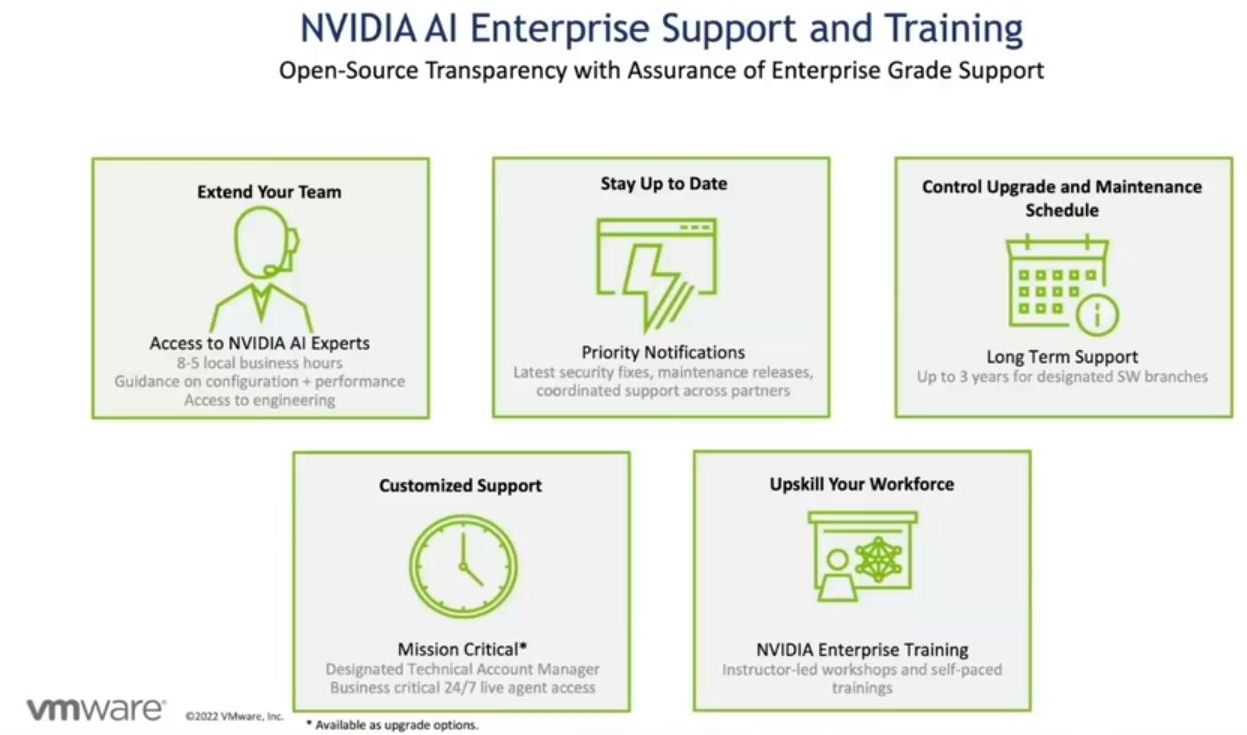

公開付費與授權模式,提供企業級支援服務

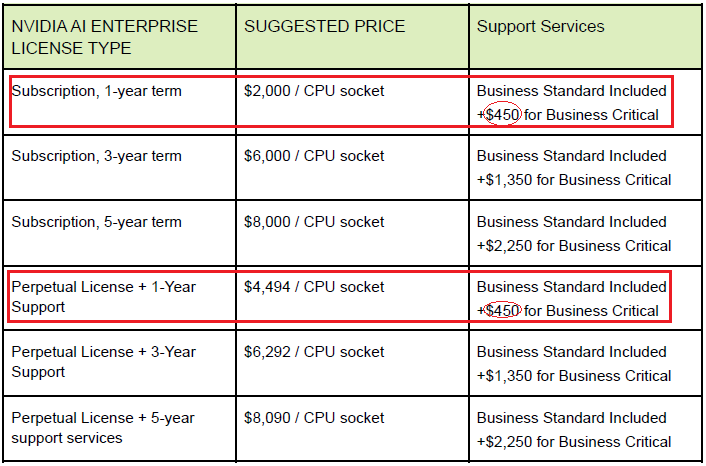

關於費用與授權的計算,Nvidia也在2021年8月公布相關的消息。基本上,分成兩種計價方式,一種是訂閱制,每個CPU插槽的訂閱授權年費為 2千美元,包含1週5天、1天9小時的商用標準支援服務;另一種則是永久授權,費用為3,595美元,需要額外購買支援服務(根據2022年3月的Nvidia套裝、收費與授權指南,每個CPU插槽的永久授權加上1年支援服務為4,494美元)。

用戶還可以加購關鍵商用支援服務,獲得1週7天、1天24小時的技術協助。以訂閱1年、單顆處理器為例,需再支付450美元,若是永久授權,每個CPU插槽加上1年支援服務,同樣支付450美元。

由VMware與Nvidia共同合作促成,推動新一代AI混合雲架構

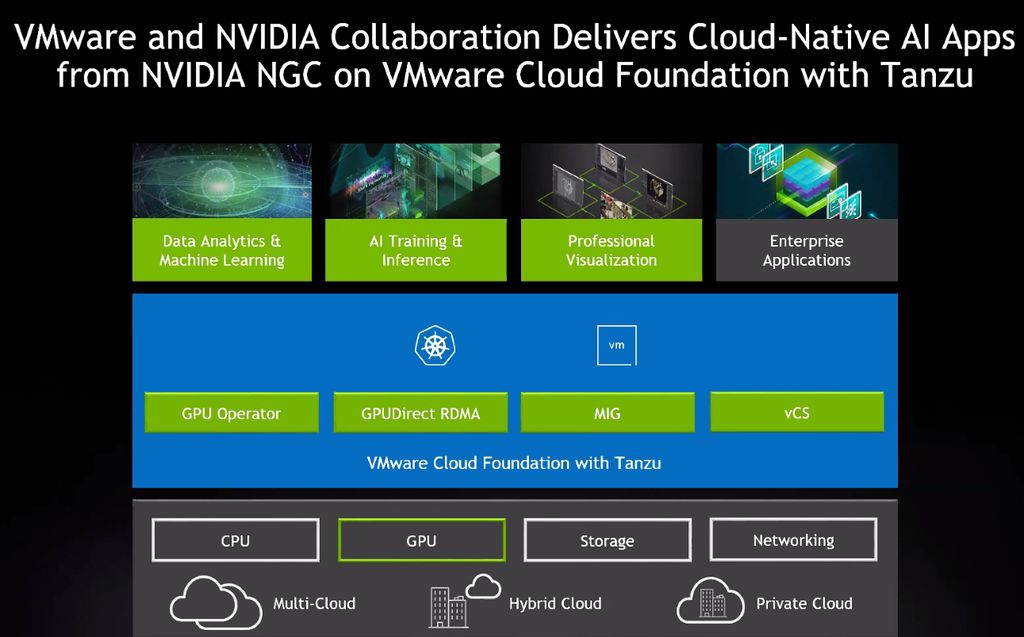

關於Nvidia AI Enterprise這項解決方案的發展,源自2020年9月VMware舉行VMworld全球用戶大會期間,兩家公司宣布進一步合作,希望能夠提供一套囊括各種應用環節的企業級AI平臺,以及將Nvidia資料處理器(DPU)用於資料中心、雲端服務、邊緣運算的新架構,支援既有與新一代應用系統的執行。

以企業級AI平臺而言,雙方期盼能夠將Nvidia NGC雲端容器軟體映像儲存庫服務,提供的各種AI軟體,整合到VMware的三大系統平臺:VMware vSphere、VMware Cloud Foundation、VMware Tanzu,協助推動企業更快採用AI,使他們延伸既有IT基礎架構,可以透過單一維運套件來管理所有的應用系統,在資料所在位置附近,部署可充分因應AI軟體執行需求的環境。

而在DPU的支援上,兩家公司也宣布推出名為Project Monterey的計畫,期盼能夠提供一套基於SmartNIC技術的架構,以便在混合雲環境使用,而箇中關鍵包含Nvidia BlueField-2 DPU,以及VMware Cloud Foundation,透過兩者的結合,不僅能產生新型基礎架構,因應AI、機器學習、高吞吐量、聚焦於資料處理等專屬應用系統的執行需求,也可以將資料中心關鍵服務從CPU卸載至DPU處理,而得以涵蓋所有的企業IT系統工作負載,擴充應用程式加速執行能力,並且提供額外的安全防護層。

預告2.3版將支援H100 GPU與DGX系列系統,並且整合更多類型應用框架

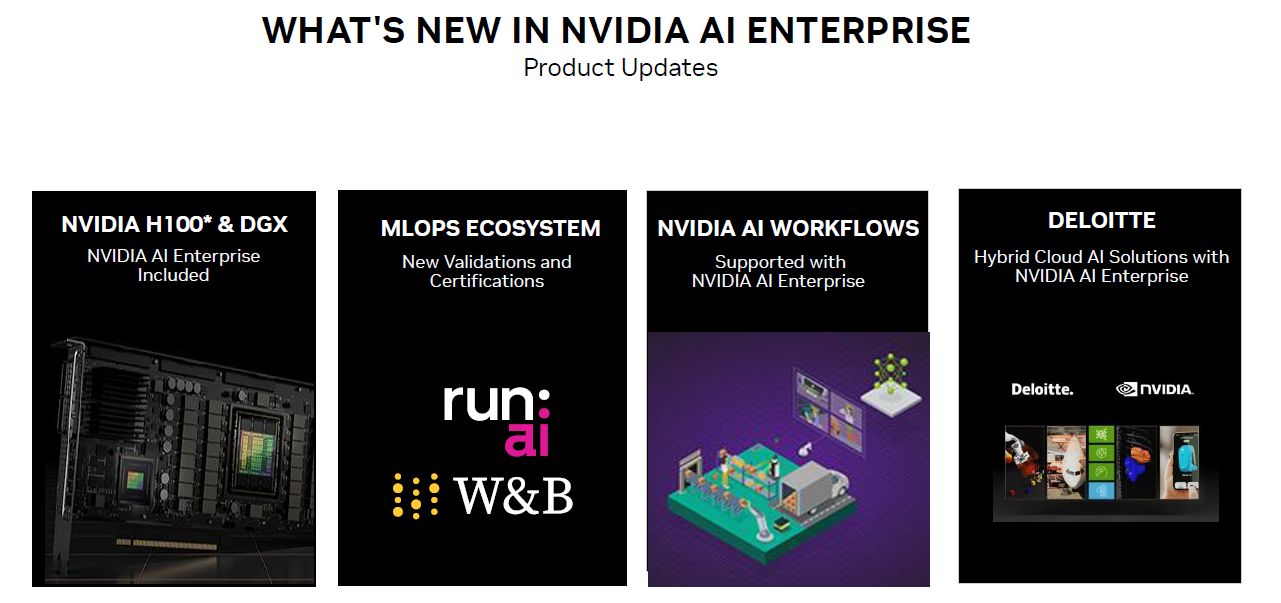

在9月舉行的GTC秋季大會期間,Nvidia在一場介紹Nvidia AI Enterprise的最新發展時,提到下一版(2.3版)即將登場的新功能與近期廠商合作。

首先是今年上半推出的資料中心GPU產品H100、搭配H100的EGX伺服器,以及AI整合應用設備DGX系統,將能支援Nvidia AI Enterprise使用(DGX將會內建Nvidia AI Enterprise);

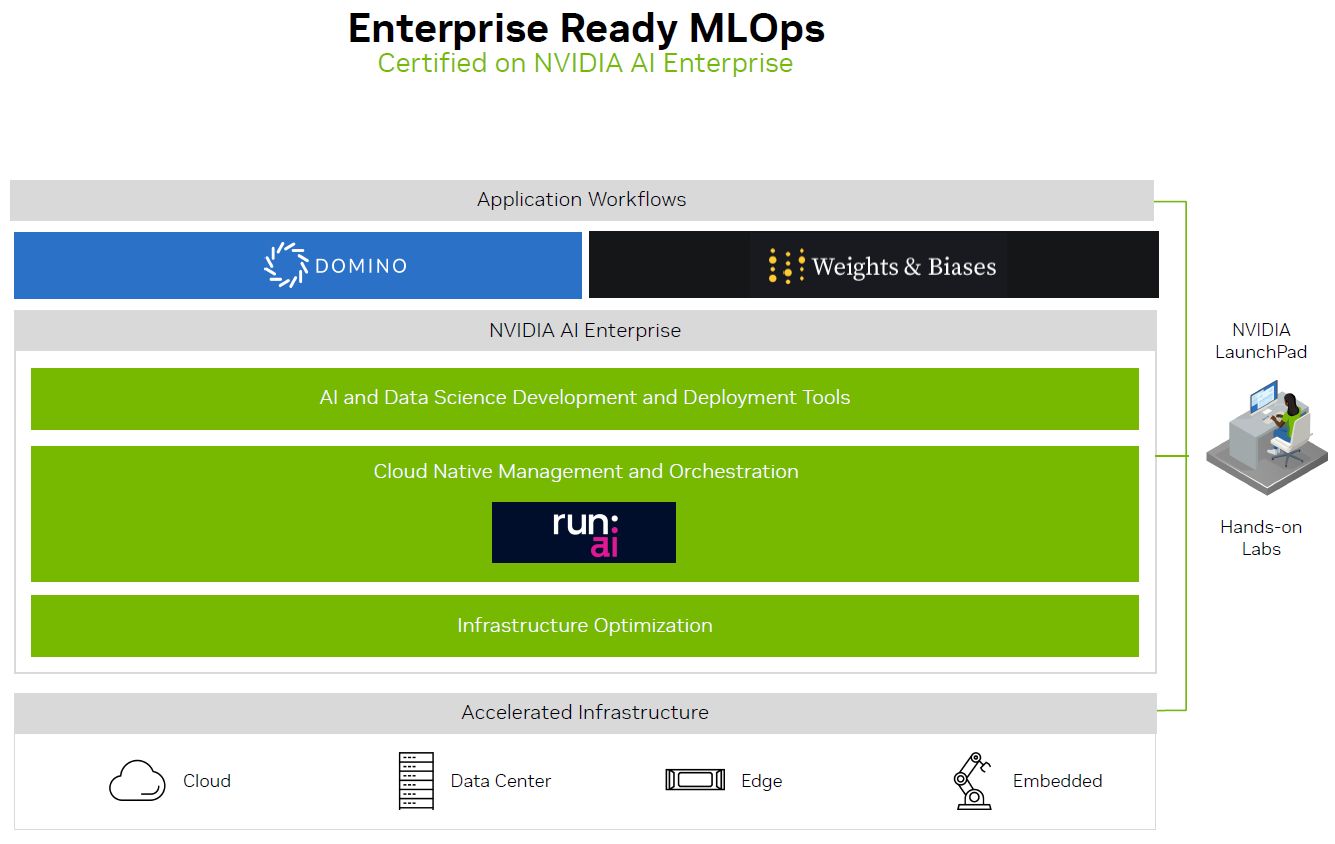

第二是他們宣布新的MLOps合作夥伴整合關係,一家是AI工作負載的運算調度技術應用廠商Run:ai,一家是機器學習開發工具平臺廠商Weights & Biases,Nvidia AI Enterprise已通過這兩家廠商的認證;

第三是可延伸支援更多類型AI應用工作流程,像是Riva、Morpheus、Merlin,協助企業更快建置AI模型;

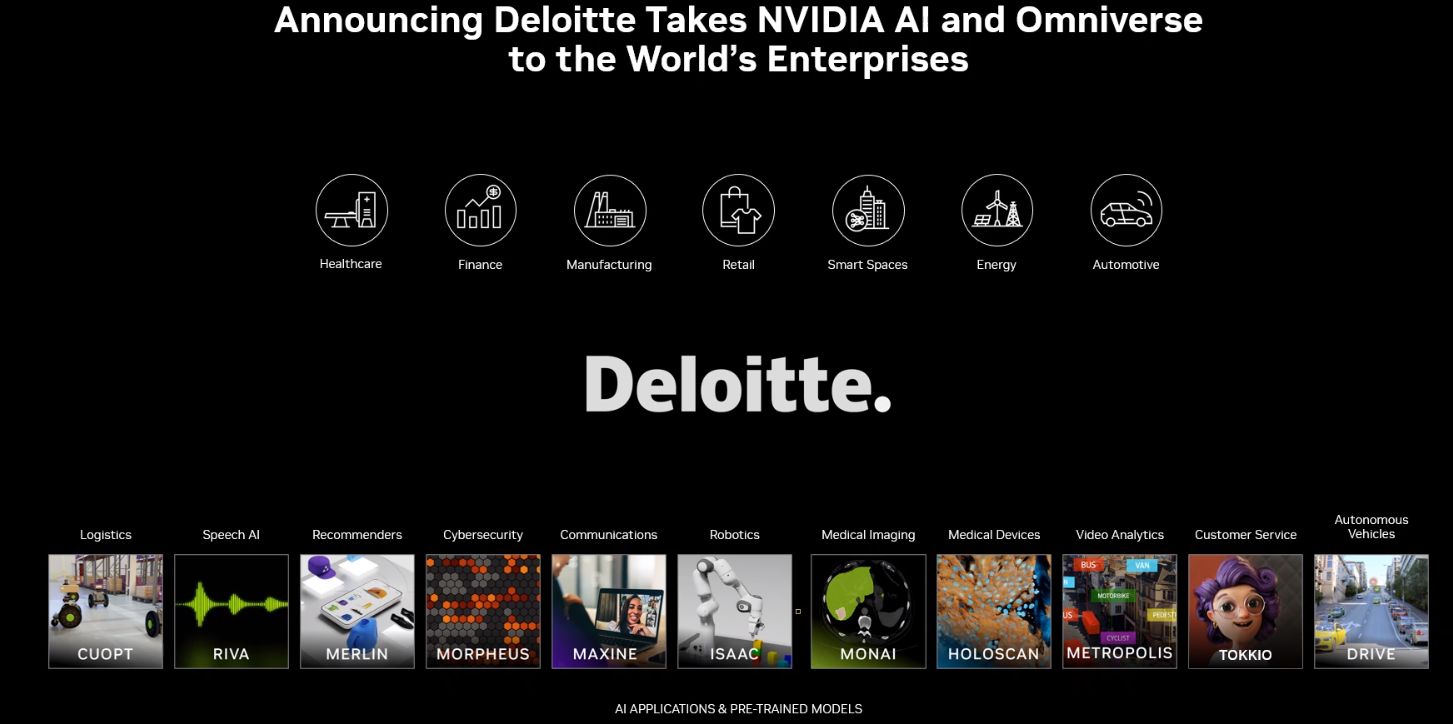

第四是與Deloitte宣布擴大策略合作,協助全球企業運用Nvidia AI Enterprise,以便快速開發、建置、部署混合雲解決方案。

產品資訊

Nvidia AI Enterprise 2.2

●原廠:Nvidia

●建議售價:每顆處理器1年訂閱授權為2,000美元,含商用標準支援服務

●支援伺服器虛擬化平臺:VMware vSphere 7.0 Update 3

●支援虛擬機器作業系統:Ubuntu 20.04 LTS/22.04 LTS、Red Hat Enterprise Linux 8.4/9.0、Red Hat OpenShift 4.9以後版本

●虛擬機器組態:16顆vCPU、64 GB記憶體、500 GB虛擬硬碟空間、VMXNet3 NIC虛擬網卡

●軟體組成:基礎架構最佳化軟體(Nvidia vGPU software、Nvidia CUDA Toolkit、Nvidia Magnum IO軟體堆疊)、雲端原生部署軟體(Nvidia GPU Operator、Nvidia Network Operator)、AI與資料科學框架軟體(TensorFlow、PyTorch、Nvidia Triton Inference Server、Nvidia TensorRT、RAPIDS)

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2024-04-24

2023-12-03

2024-04-25

2024-04-22

2024-04-22

2024-04-22

2024-04-22