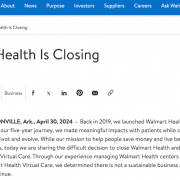

玉山在內部推出通用型GenAI平臺GENIE,這個平臺本身是一支API,當使用者在GENIE的介面輸入資料後,資料會通過GENIE連接至微軟提供的Azure OpenAI服務,再通過GENIE回傳模型生成的結果給使用者。(圖片來源/玉山金控)

玉山金控不只是臺灣金融業率先擁抱生成式AI的領先者,更不到2年,就打造一個GenAI平臺,可透過API方式,整合到不同的應用場景和內部系統中,讓生成式AI更容易落地到多種工作流程中。目前,玉山內部啟用了11項生成式AI應用服務,還有1項正在開發中。他們能夠快速將生成式AI落地的關鍵就是,今年初正式啟用的通用型GenAI平臺GENIE。

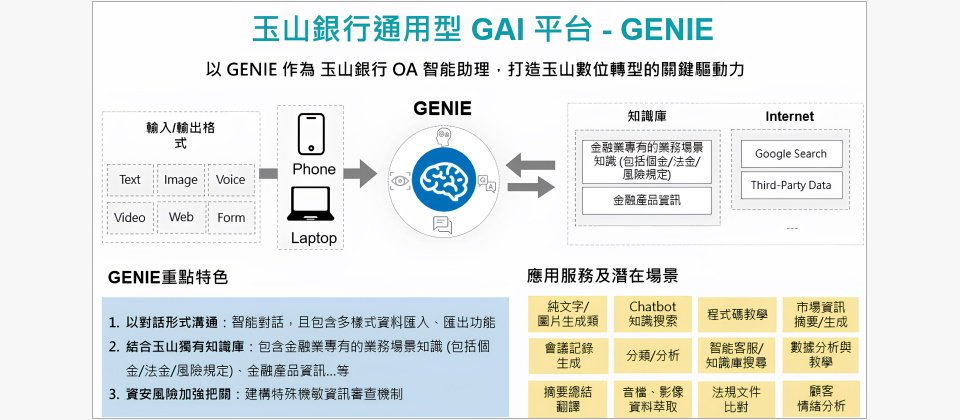

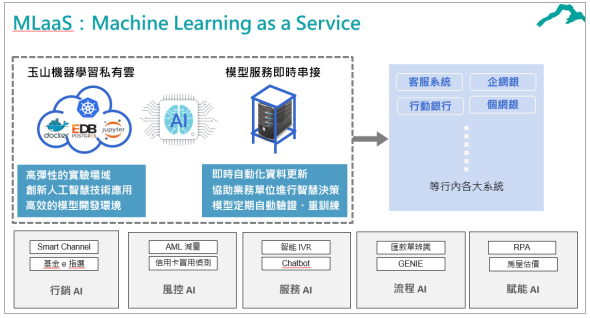

五年前,玉山就自建一套機器學習即服務平臺MLaaS,幾年下來,平臺提供和維運了AI五大類服務,包括行銷AI、風控AI、服務AI、流程AI以及賦能AI,GENIE平臺就是流程AI類的其中一隻API。這個平臺有兩大特色:API化服務和檢索增強生成(RAG)技術。一方面,GENIE是一隻獨立的API,可以整合到多種延伸應用服務,內部系統可以透過API串接來使用GENIE的功能。另一方面,玉山自建豐富的金融知識庫,藉RAG技術,來提升LLM模型回應金融領域問題的精準度。

除了API串接形式,GENIE平臺還提供一個前端介面,可以直接提供使用者自己操作來使用,類似ChatGPT介面風格,支援多種資料匯入和匯出的格式,包括文字、圖片、聲音,和檔案等格式資料。當使用者輸入資料,資料會通過GENIE連接至微軟Azure OpenAI服務,再通過GENIE回傳結果給使用者。

由於GENIE平臺需要將資料傳送到外部服務,因此,玉山除了使用供應商提供的護欄服務,過濾使用者輸入資料和模型生成回應,他們也額外開發機敏資料掃瞄機制,採用等價交換的方式,例如將身分證字號換成隨機號碼,避免機敏資料外洩。

不同於以往應對資安風險採用的遮罩技術,玉山選擇採用等價交換,是為了確保LLM模型能正常運作。玉山銀行智能金融處資深副總工程師林鉦育解釋,遮罩技術是將機敏資訊遮蔽,防止重要資料外洩,但是,LLM模型需要根據上下文資訊進行判斷,若只提供遮蔽後的片段文本資訊,可能削弱模型的理解能力,進而影響模型正常提供服務。反之,等價交換的方式不僅能保護敏感資訊,也可以減少對模型判斷力的影響。

早在2023年上半年,玉山就已經確立好GENIE平臺架構,同時開發介面,建立資料外洩機制。不過,他們並沒有立即投入開發應用服務,而是先大規模的蒐集潛在應用場景。

玉山從2018年開始打造MLaaS平臺,以MLaaS為核心發展出行銷AI、風控AI、服務AI、流程AI、賦能AI五大領域AI服務,全行運作超過百支AI服務。其中,GENIE平臺被設計為一支API,歸類於流程AI領域。(圖片來源/玉山金控)

建立行內知識庫前,以「工人智慧」逐一檢視百萬筆輸入資料

2023年下半年,玉山向行員釋出GENIE平臺測試版,供行員查詢、試用各項服務。起初,GENIE平臺僅純粹介接LLM模型服務,並未額外設置知識庫提升回應精準度。目的是為了蒐集足夠的查詢需求,再根據使用者的需求開發進階應用服務,建立全行知識庫。

為了提升業務單位使用新技術的意願,在測試階段初期,玉山團隊也舉辦工作坊和教育訓練,教導行員使用生成式AI工具,同時促進行員發想更多使用場景,「我們有點像工人智慧,逐筆看大家的輸入紀錄。」玉山銀行智能金融處主任工程師徐銘霞回憶,當時收到超過百萬筆輸入紀錄,團隊逐漸摸索出使用者關注的問題和潛在應用場景,協助後續導入知識庫和開發進階應用服務時,能更有效決策優先開發順序。

因應金融業務資訊快速變動,以RAG作為GENIE技術核心

經過初期測試階段後,玉山接著建立包括金融產品資訊,以及涵蓋個金、法金和風險規定等業務場景知識的知識庫,透過GENIE連接至LLM模型服務,供模型檢索資料,生成更精準的回應。玉山團隊在微調(Fine-tuning)和RAG技術兩者之間,選擇RAG作為發展生成式AI的關鍵技術核心。為什麼?

首先,金融產品知識更新頻率快,十幾張信用卡資訊可能在一個月內就發生變動,微調模型不僅耗時,跟不上產品資訊變動,還須要投入大量成本。再來,若資料量過少或品質太低,微調模型表現也不好。反之,採用RAG能夠讓模型檢索最新資訊,有助於快速應變資料異動,甚至做到即時更新。

在發展RAG時,玉山選擇在建立知識庫的階段投入最多技術能量。

林鉦育解釋,RAG技術的運作有三個關鍵步驟,建立知識庫、檢索到監控輸出內容。建立知識庫的過程中,先透過嵌入技術將大量文字轉為向量,以供模型檢索之用。其次,在檢索時,將LLM模型視為邏輯引擎,讓LLM模型根據使用者提出的問題來檢索文件,找出最符合答案,最後是再透過閘道(Gateway)來進行監控,作為輸出前的防線,來控管LLM模型生成的答案,篩選過後才能提供給使用者。

這三個步驟當中,玉山花最多力氣在第一個步驟,「東西給的對,後面就八九不離十。」林鉦育說,玉山發展RAG的策略是,在建立知識庫時,盡可能切出準確的向量距離,來提升資料檢索的精準度,如此一來,也能盡量降低模型回應錯誤率。

使用LLM模型容易會有遭模型綁定的問題,因為不同LLM模型產生的向量有異,相似度判斷結果也可能有所差異,一但更換所用的LLM模型,就得重新生成所有文件的向量。因此,除了使用嵌入技術,玉山團隊也考慮採用術語庫(term base)來進行資料檢索,例如,關鍵字搜索,或使用TF-IDF或BM25等特定演算法。這個方式雖然傳統,卻能解決依賴單一模型的問題,不需要額外生成向量,只要有明確詞彙就能進行檢索。

GENIE整合流量管控和財務管理機制,下一步是走向混合雲架構

而在去年下半年的測試期間,玉山團隊除了觀察使用者需求,也將流量管控和財務管理機制納入平臺,紀錄各單位使用頻率和流量。他們沿用玉山既有的API流量管控機制架構,改成管控LLM使用流量,以及計算服務使用花費。

玉山團隊的作法,是在平臺連接供應商服務的流程中設置流量管控機制,針對玉山全部系統進行管控,如此一來,團隊可以觀察不同單位使用情況,以及不同模型的長處和應用情況,協助開發團隊日後應對不同使用者需求,甚至在未來將生成式AI推向服務時,開發團隊也能根據不同服務需求選用適當的LLM模型。

實際觀察LLM使用流量後,挑戰還在後頭。「一旦跟業務嵌入後,就會有旺季淡季的議題。」林鉦育坦言,業務單位的高低峰使用量增加不少流量管控的難度。因此,為了提升平臺的彈性,玉山團隊正在計畫將雲端納入GENIE平臺的調度環境,採用容器和K8s,運用K8s平臺的自動擴充機制,根據當下流量即時調度運算資源,協助進行流量管控。

近期金管會鬆綁上雲規範,開放金融機構能將非涉及重大消金業務的系統遷至公雲,玉山團隊也開始籌劃讓GENIE平臺的架構能上公雲,把平臺轉為混合雲架構。預計最快年中就會推出新一代的通用型GenAI平臺。

傳統AI和生成式AI的開發維運模式不一樣

2018年,玉山定調全力發展AI,五年的耕耘讓玉山內部累積不少AI開發維運經驗,但是,導入生成式AI仍和過往發展AI不太一樣,也讓玉山面臨不少挑戰。玉山銀行智能金融處主任工程師徐銘霞解釋,過往玉山大多使用自己建立的模型,但自從LLM模型服務上線後,企業開始需要向外部流通資料,「那資料外洩的議題要怎麼樣做處理?我們跟雲端廠商要怎麼合作?」這些考驗,需要額外設立規範或建立機制才能解決。

除了資料外洩和雲端廠商合作議題,控管雲端服務花費也是一門學問。徐銘霞解釋,過去團隊在計算開銷時,僅需要計算硬體設備或擴充VM等既有且已知的價格,「可是未來用到雲端服務,它的價格就會依照雲端業者提供。」等同是使用完服務,才能得知具體花費,無法提前交出預算。因此,玉山團隊在開發生成式AI應用時,也需要額外設置卡控機制,控制服務開銷。

另外,發展生成式AI應用和過往發展AI模型應用場景也有所差異。徐銘霞指出,LLM模型類似一個7歲小孩,擁有許多知識,可以發展許多通用型的場景,和過往使用單一模型、發展特定場景的開發模式不同,因此,如何篩選適當導入生成式AI的場景,就是一項考驗。

熱門新聞

2024-05-06

2024-05-06

2024-05-06

2024-05-06

2024-05-06

2024-05-03