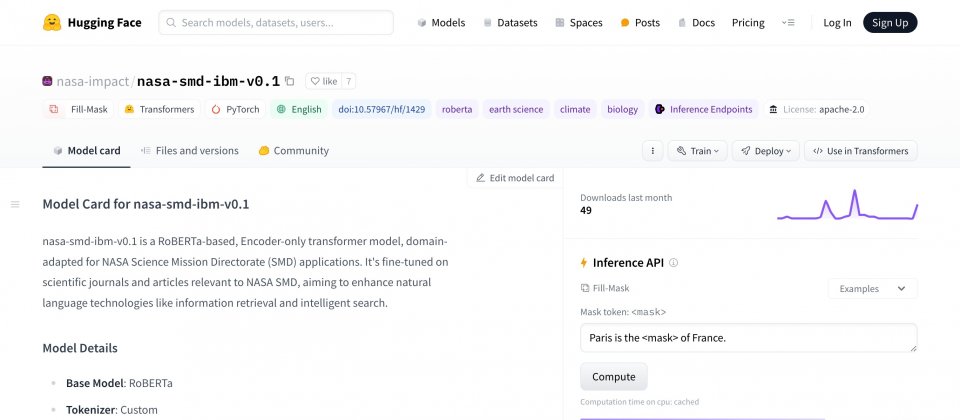

IBM與NASA合作創建Transformer架構大型語言模型,針對科學文獻進行訓練,提高包括分類、實體擷取、問答和資訊檢索等各種科學自然語言理解任務的效能。目前相關模型已經在Hugging Face上開源,供科學與學術社群使用。

研究人員解釋,大型語言模型的能力來自於對語言的統計理解。這些模型接受遮罩語言模型任務訓練,藉由重構已被遮蔽單字的句子來進行學習。研究人員藉由隨機遮蔽句子中的單詞,要求模型預測被遮蔽的單字,而這有助於模型理解單詞之間的關係,以及這些單詞如何共同決定句子的意思。

在這個過程,標記器(Tokenizer)是一個重要的工具,可以將單字分解成模型可以理解的單位,對於模型學習大量詞彙非常重要。IBM表示,使用維基百科或是BooksCorpus等資料訓練標記器,通常對通用文字標記器很有效,但在科學領域,需要能夠處理像是Phosphatidylcholine這種專業術語的標記器。

科學領域的文本經常包含特殊術語和複合詞,一般標記器難以正確處理這些詞,因此訓練針對專門領域的標記器,對於提高模型在特定領域的表現非常重要。研究人員使用來自天文物理學、地球科學與太陽圈物理學(Heliophysics)等多個專業領域的資料集的600億個Token來訓練模型。

科學文獻用的標記器與通用標記器有很大的不同,科學文獻用的標記器要能夠辨識Axes和Polycrystalline這類科學術語,IBM-NASA新開發的模型,其所處理的5萬個Token中,有一半都是Hugging Face其他開源的RoBERTa模型未曾出現的。

在用於評估模型處理生物醫學任務表現的基準測試BLURB,IBM-NASA模型的分數也較其他開源的RoBERTa模型高出5%。另外,該模型在內部科學問答的基準測試的F1分數提高了2.4%,在地球科學實體辨識的內部測試上,也改進了5.5%。

這個IBM-NASA編碼器模型可針對許多非生成式語言任務微調,並且透過檢索增強生成(RAG)技術生成資訊豐富的嵌入,用於文件檢索任務上。研究人員利用編碼器模型建立檢索器模型,以產生資訊豐富的嵌入,映射文字對(Pairs of Text)之間的相似性,使得檢索模型學習根據問題,找出最相關的文件或是資訊。

而研究人員用來訓練檢索模型的文字對有2.68億筆,包括標題、摘要以及問題和答案,使其能夠良好地處理NASA所準備的問題測試集,與經過類似微調的RoBERTa模型相比,檢索模型效能提升了6.5%,與另一種開源嵌入模型BGE-base相比,效能也上升5%。

IBM與NASA的研究人員透過專門的訓練資料、自訂標記器和特別的訓練方法,強化科學文獻用的大型語言模型。現在編碼器模型和檢索器模型都已經在Hugging Face上開源,IBM也與NASA進一步合作,將這些模型用於強化科學搜尋引擎。

熱門新聞

2023-12-03

2024-04-24

2024-04-25

2024-04-26

2024-04-22

2024-04-22

2024-04-22