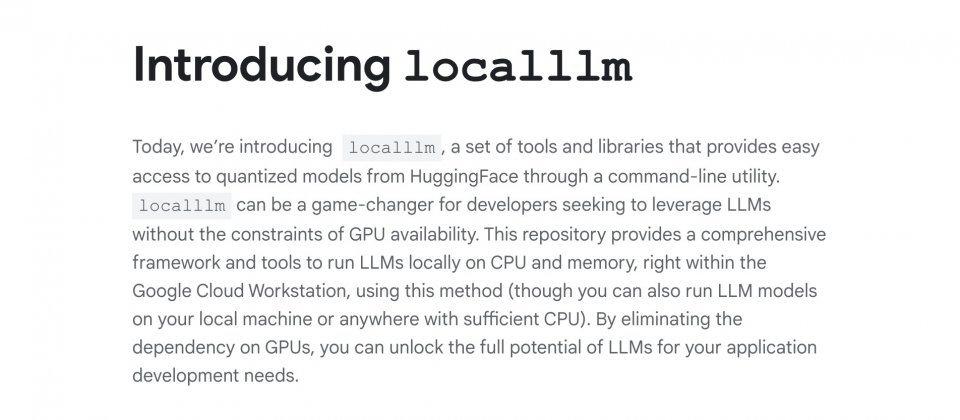

Google推出了一組稱為localllm的工具和函式庫,透過與Google雲端全託管開發環境Cloud Workstations的整合,讓開發者可以使用本機端CPU和記憶體執行大型語言模型,藉以消除人工智慧應用程式開發對GPU運算資源的需求。

開發使用大型語言模型的應用程式面臨許多挑戰,例如GPU資源稀缺便會對開發造成阻礙,而Google推出了新興解決方案,透過讓開發者在Cloud Workstations中運用本地CPU和記憶體,就足以執行大型語言模型。

該新方法是藉由結合量化模型、Cloud Workstations和localllm工具達成。所謂的量化模型,是指經過最佳化,可以在有限運算資源本地裝置執行的人工智慧模型,這些模型的記憶體使用和處理能力更加高效,因此能夠在智慧型手機、筆記型電腦和各種邊緣裝置上運作。由於量化模型經過最佳化,會使用較低精度的資料類型進行計算,相較於使用標準的32位元浮點數,能以相同的運算資源進行更快速的處理。

量化技術也有助於減少人工智慧對記憶體的需求,透過降低表示模型權重和啟動(Activation)的位元數,減少整體模型大小,進而適應儲存容量有限的裝置。由於量化模型在精度和模型尺寸更小,因此可以更快地執行運算,實現更快的推理速度。

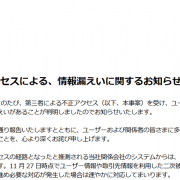

Google釋出的localllm,讓開發者可以透過命令列工具,存取HuggingFace中的量化模型,在不受GPU可用性限制的情況下運用大型語言模型。Google提到,localllm儲存庫提供了完整的框架和工具,讓開發者在Cloud Workstation上直接於本地執行大型語言模型,甚至是在任何具有足夠CPU資源的機器上執行大型語言模型。

因此開發者可以將大型語言模型整合到應用程式開發工作流程中,而不影響效能或生產力,而且透過localllm,開發者可以直接在Google雲端生態系中使用大型語言模型,這種整合簡化了開發流程,降低開發對遠端伺服器和外部服務的依賴程度。由於大幅降低對GPU運算資源的需求,也就最佳化資源利用率,進而降低了開發成本。

在本地端的CPU和記憶體上執行大型語言模型,也就代表開發者可以更完全地掌握敏感資料,localllm讓開發者降低資料傳輸還有第三方存取相關的風險,進而強化資料的安全性與隱私性。

熱門新聞

2023-12-03

2024-04-24

2024-04-25

2024-04-22

2024-04-22

2024-04-22

2024-04-26