OpenAI最新人工智慧可解釋性研究,運用GPT-4大型語言模型,自動生成大型語言模型神經元的行為解釋,並對這些解釋進行評分,以評估解釋的品質。

之所以要對人工智慧進行可解釋性研究,主要原因是要讓用戶和開發者更理解人工智慧的運作原理,並且了解人工智慧做出決策的方法,進而提高對人工智慧系統的信任度。另外,透過研究人工智慧模型的行為,也更能理解模型偏差與錯誤,因而有辦法提升模型效能,甚至進一步改善人類與人工智慧間的協作。

可解釋性研究的重點之一,是了解各個元件的功能,在深度學習中,神經元(Neurons)和注意力頭(Attention Heads)是兩個重要元件,分別在神經網路與自注意力機制中發揮作用。在過去,研究人員必須要手動檢查神經元,來確認這些神經元所代表的資料特徵,但是這過程非常複雜繁瑣,很難擴及到擁有數百億參數的神經網路。

因此OpenAI現在提出一種自動化方法,使用GPT-4能夠生成並且評分其他語言模型神經元的行為。該研究的價值在於透過自動化方法,才足以跟上人工智慧發展的步伐,而隨著未來模型的發展,所產生的解釋,品質也會更好更能發揮作用。

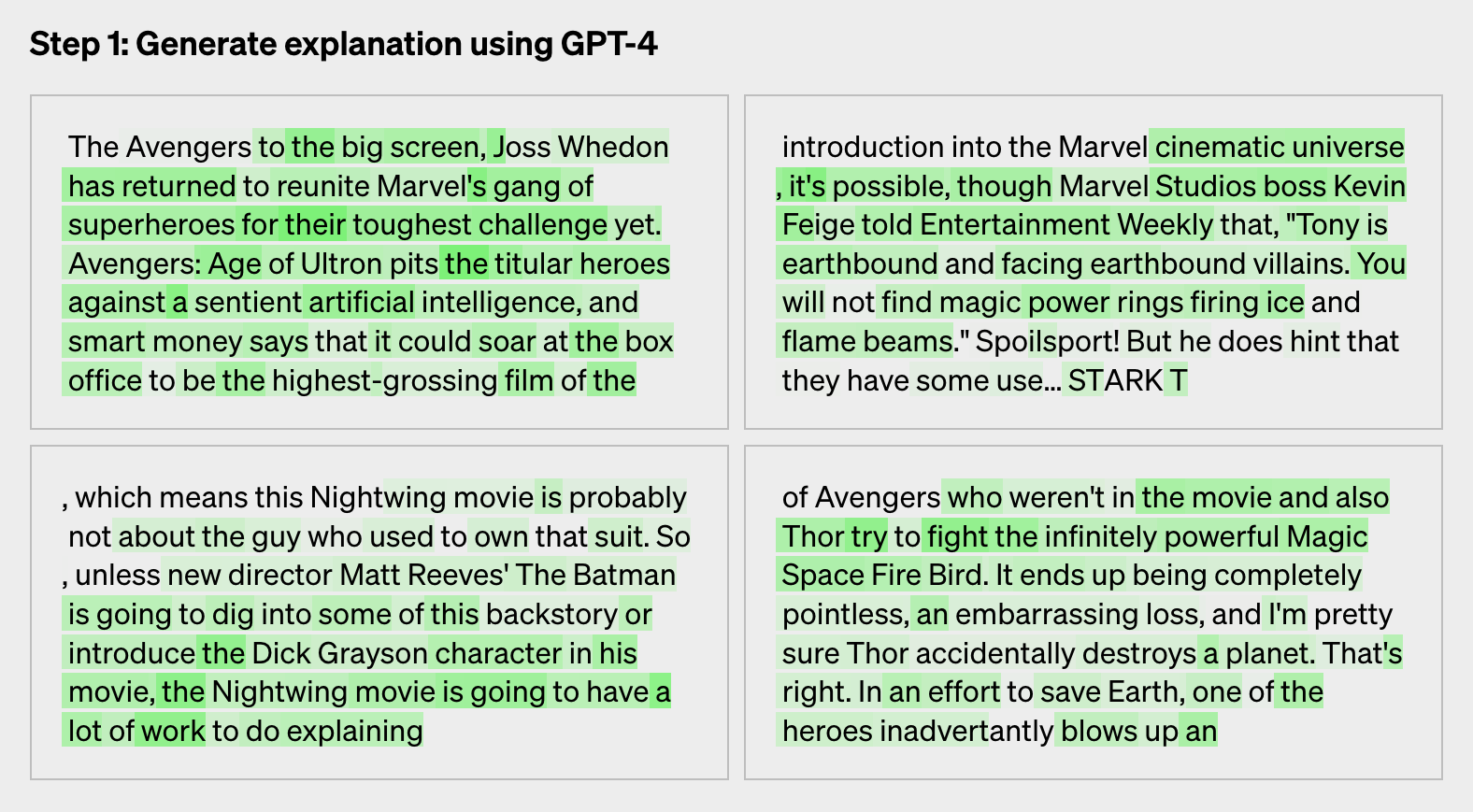

要解釋神經元行為有三個步驟,分別是以GPT-4生成解釋、以GPT-4模擬,最後是比對。第一步驟透過給定一個GPT-2神經元,並向GPT-4展示相關的文字序列和活躍情況,要求GPT-4生成可以解釋神經元行為的自然語言文字。

第二步驟是使用GPT-4模擬神經元的行為,目的是了解解釋中的神經元活躍的原因,如此便能夠觀察解釋與神經元活躍的表現是否一致。最後則是比對模擬和真實情況的差異,對解釋進行評分,以衡量解釋的可靠性和準確性。

這個以GPT-4自動生成並評分神經元行為的方法,目前對於較大的模型效果不佳,研究人員猜測可能是神經網路較後面的網路層更難解釋,雖然目前許多解釋獲得分數都很低,但是OpenAI相信,隨著機器學習技術的提升,解釋能力也能夠再提高,像是利用更大型模型進行解釋,或是更改解釋模型的結構,都有機會進一步提高解釋品質。

OpenAI開源GPT-4所編寫的30萬個GPT-2神經元解釋資料集,以及視覺化工具,還有在OpenAI API上使用公開模型進行解釋和評分的程式碼,OpenAI表示,他們希望其他人工智慧社群也能夠加入研究,發展更好的技術產生高分解釋。

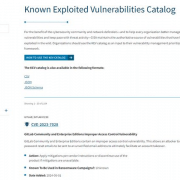

熱門新聞

2024-05-06

2024-05-06

2024-05-06

2024-05-06

2024-05-07

2024-05-07