Meta AI

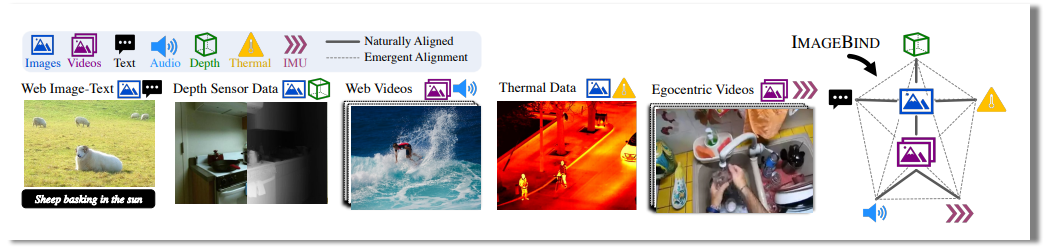

有別於OpenAI與Google的AI研究日益走向封閉,Meta AI依然秉持著開放的態度,於周二(5/9)開源了多模態AI模型ImageBind,而且ImageBind是個整合了6大感知形式的AI系統,囊括了照片/影片、文字、聲音、深度、熱量與慣性測量單元(IMU)。

圖片來源_Meta AI

在傳統的AI系統中,每個模態都會有一個特定的嵌入,ImageBind則建立了不同模態的共同嵌入空間,而且無需針對各模態之間的不同結合進行訓練。Meta表示,此一進展非常重要,因為要蒐集不同模態之間所有可能的配對資料幾乎是不可行的,此外,它也讓機器能夠像人類一樣,全面分析不同類型的資料。

人類多半能夠從少數的例子中學到新的概念,例如就算只是閱讀對動物的文字描述,就得以在現實生活中辨認他們,或是看到一輛陌生車種的照片,即可猜測它的引擎聲,這有部分來自於就算只是看著一張照片,它通常結合了人們所有的感官經驗。在AI領域中,隨著模態數量的增加,缺乏不同的感官資料會限制標準的模態學習,但一個分布不同資料的單一共同嵌入空間,則可讓模型學習不同的模態。

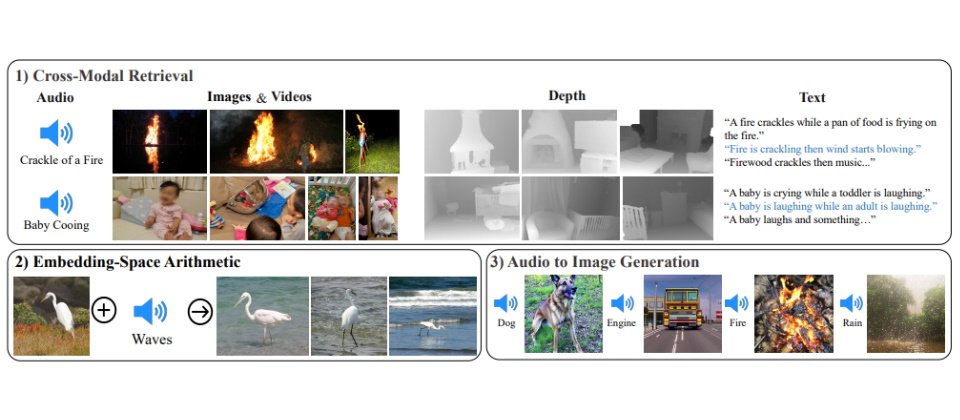

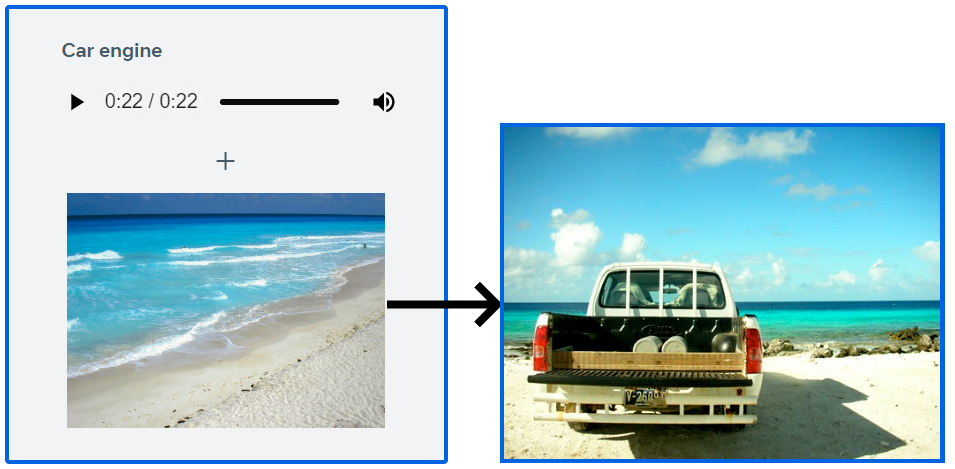

於是,基於共同嵌入空間的ImageBind不僅能夠利用影像來汲取聲音,用聲音來汲取影像,以文字來造就影像與聲音,用聲音及影像來形成影像,也能以聲音來產生影像。例如把海浪的聲音加入海灘的照片中,輸入火車的聲音可以得到相關的影像,輸入狗吠聲再加上海灘照片則可以得到狗望向大海的照片。

圖片來源_Meta AI

Meta AI說明,ImageBind展示的是藉由配對的圖像資料,便足以結合這6種不同的模態,讓模型得以更全面地解讀內容,使不同的模態能夠在沒有觀察到它們同時存在的情況下彼此交流並找到連結。

儘管Meta AI於現階段的研究中僅使用了6種模態,但該團隊相信若導入更多的模型,將會帶來更豐富、更像人類的AI模型,例如觸覺、說話、嗅覺,或是大腦的功能性磁振造影(fMRI)訊號等。

熱門新聞

2024-04-30

2024-05-01

2024-04-29

2024-04-29

2024-04-30

2024-04-30

2024-04-28

2024-04-29