全世界指紋辨識晶片出貨量第二的神盾,投入類比AI晶片的研發,並且將研究成果初步運用在自家指紋辨識晶片中。

圖/取自神盾官網

隨著AI走向邊緣運算,越來越多人投入AI推論晶片的研發,目的要即時分析終端裝置接收到的資訊,來減少資料上雲可能造成的延遲。然而,終端裝置蒐集到類比訊號後,需要透過類比數位轉換器(ADC,Analog-to-Digital Converter),以0與1的形式存成數位資訊,再來執行AI運算,換句話說,若要做到即時的資料分析,更直觀的做法,是在接收到類比資訊的同時就進行運算,不但能省下類比轉數位的時間,也能省下晶片內建ADC元件的成本。

然而,這麼做可能嗎?在臺灣,有一家公司投入類比AI晶片的研發,已經將研究成果初步運用在自家指紋辨識晶片中,正是全世界指紋辨識晶片出貨量第二的神盾。神盾營運長林功藝表示,目前全球在研發類比AI晶片的廠商非常少,IBM是其中一家,在去年4月推出了一款類比AI晶片,運用相變記憶體(Phase-change memory,PCM)來打造記憶體內運算架構,來執行類比資料的AI運算;此外,也有一家美國研發AI晶片的公司Mythic,從去年開始投入類比AI運算晶片的研究,試圖將這款晶片應用在雲端運算中,「神盾採用的技術與Mythic相似,但聚焦在邊緣運算。」

在近期一場活動上,林功藝也揭露類比AI運算的優勢與應用。現在的電腦架構,是70年前定下的范紐曼型架構(Von Neumann architecture),把記憶體跟運算(CPU)分開,中間用匯流排(Bus)傳輸資料。然而,將CPU與記憶體分開的架構,對於運算量動輒幾億次的AI運算中,光是在記憶體與CPU之間搬運資料的過程,就會產生嚴重的功耗;且因資料傳輸頻寬(Memory Bandwidth)的侷限,資料搬運速度往往比不上CPU執行AI平行運算的速度,導致CPU部分乘加器(MAC)閒置,運算資源無法利被完全利用。

林功藝表示,如果用類比資料來做AI運算,是直接在終端分析即時且連續的類比資料,由於不需要轉存成數位資訊到記憶體,也就能省去記憶體與CPU之間資料傳輸的龐大功耗,因此,在類比AI晶片的架構上,需要的電晶體(transistors)數量會少很多。舉例來說,要執行8位元的平行化運算,若用數位資料做乘法運算,需要約3000個電晶體,做加法運算,需要300個電晶體;然而,用類比資料來做乘加運算,總共只需30個電晶體,功耗大約為原先執行數位運算的1%。

「類比跟數位在圖形理論、類神經網路架構、數學基礎一模一樣,唯一不同的是我用類比的方式做乘加器,只要1%的電晶體。」換句話說,在能得到相同AI辨識結果的情況下,類比AI運算消耗的功耗更少,對於現有硬體架構來說是一種很大的突破。

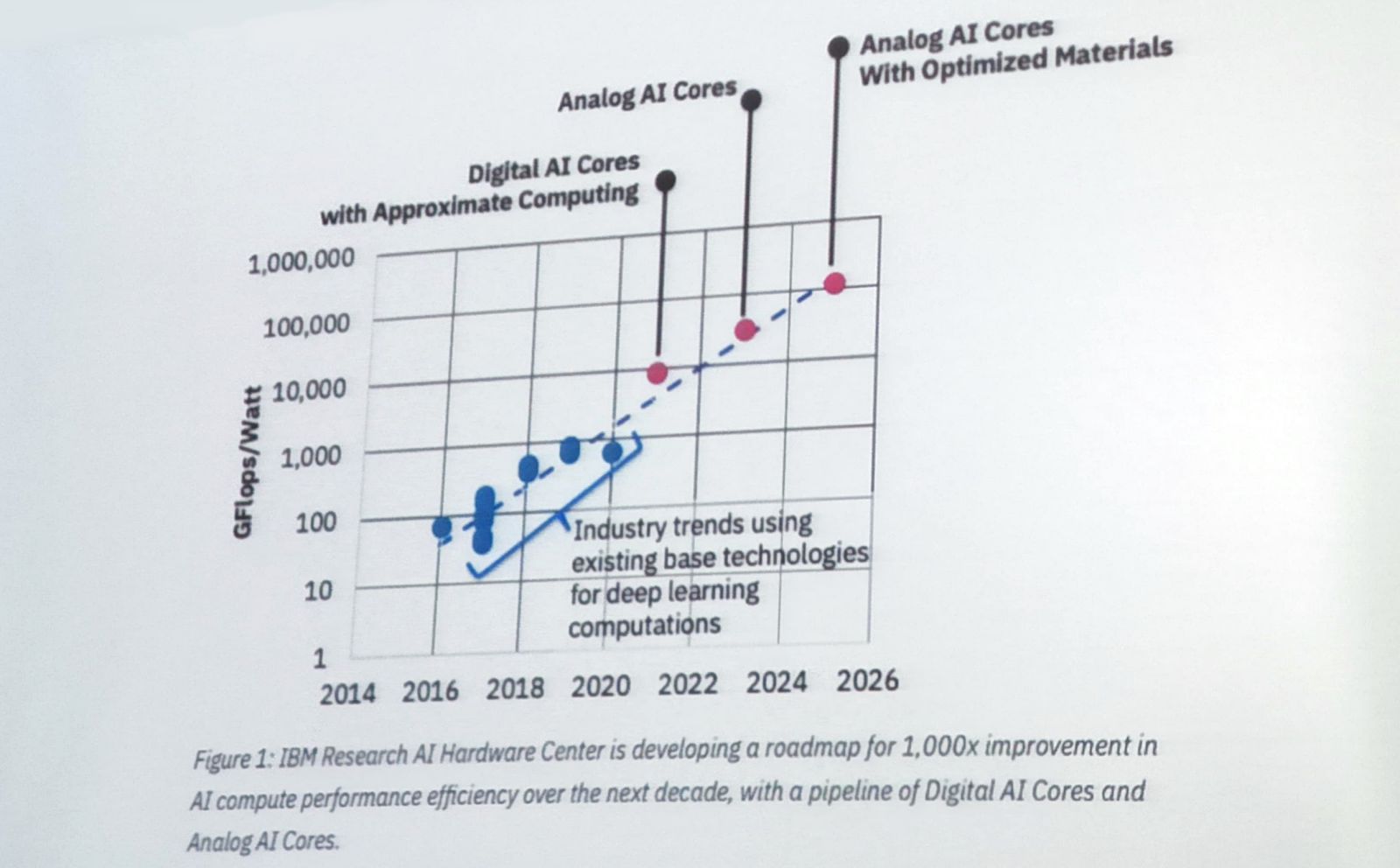

林功藝引述IBM研究院AI硬體中心一份研究,來說明未來幾年執行浮點運算硬體效能(Giga FLOPS/Watt)的侷限,從圖中可以看見,若現有深度運算的技術並無革命性的發展,數位AI運算效能將在2021年達到巔峰,而類比AI運算還能繼續突破運算限制,可能成為未來的發展趨勢。

若現有深度運算的技術並無革命性的發展,數位AI運算效能將在2021年達到巔峰。

應用類型一:結合攝錄影機進行影像辨識,來降低資料儲存、傳輸的記憶體與頻寬

由於儲存到雲端的資料都已經數位化,因此,類比AI晶片更適用於邊緣運算。林功藝也表示,神盾主要是做手機上各式各樣的感應器(Sensor),「我們的好處在於,是站在sensor前端,本質上非常類比的IC設計公司。」也因此,將類比AI晶片與各式終端感應器結合,就是神盾要開發的市場。

林功藝也以攝錄影機結合影像辨識功能,來說明類比運算AI晶片的應用方式。當鏡頭接收到的類比影像後,不同於一般邊緣運算,是把類比轉數位之後再進行影像辨識,運算過程會產生龐大功耗;類比AI運算是在感應器不斷接收到類比資料時,就直接影像辨識並擷取其特徵值,壓縮存成數位資訊再後送雲端,最後,以生成對抗網路(GAN)在雲端重建影像。

比如說,將類比AI晶片與監控攝影機結合,只有在鏡頭偵測到有機車、行人、貓狗經過,或任何風吹草動使畫面轉變時,才會開始擷取特徵值、後送雲端重建資料,換句話說,其他沒有動靜的畫面就無儲存紀錄。如此一來,就能大幅降低資料儲存、傳輸的成本。尤其中國的監控攝影機,直到2019年設置將近2億支,在晚上8小時且無人車行經的場域,還是必須不斷的攝錄影並儲存,更別提往後要傳輸到雲端或搜尋資料,都會花費很多成本去執行。

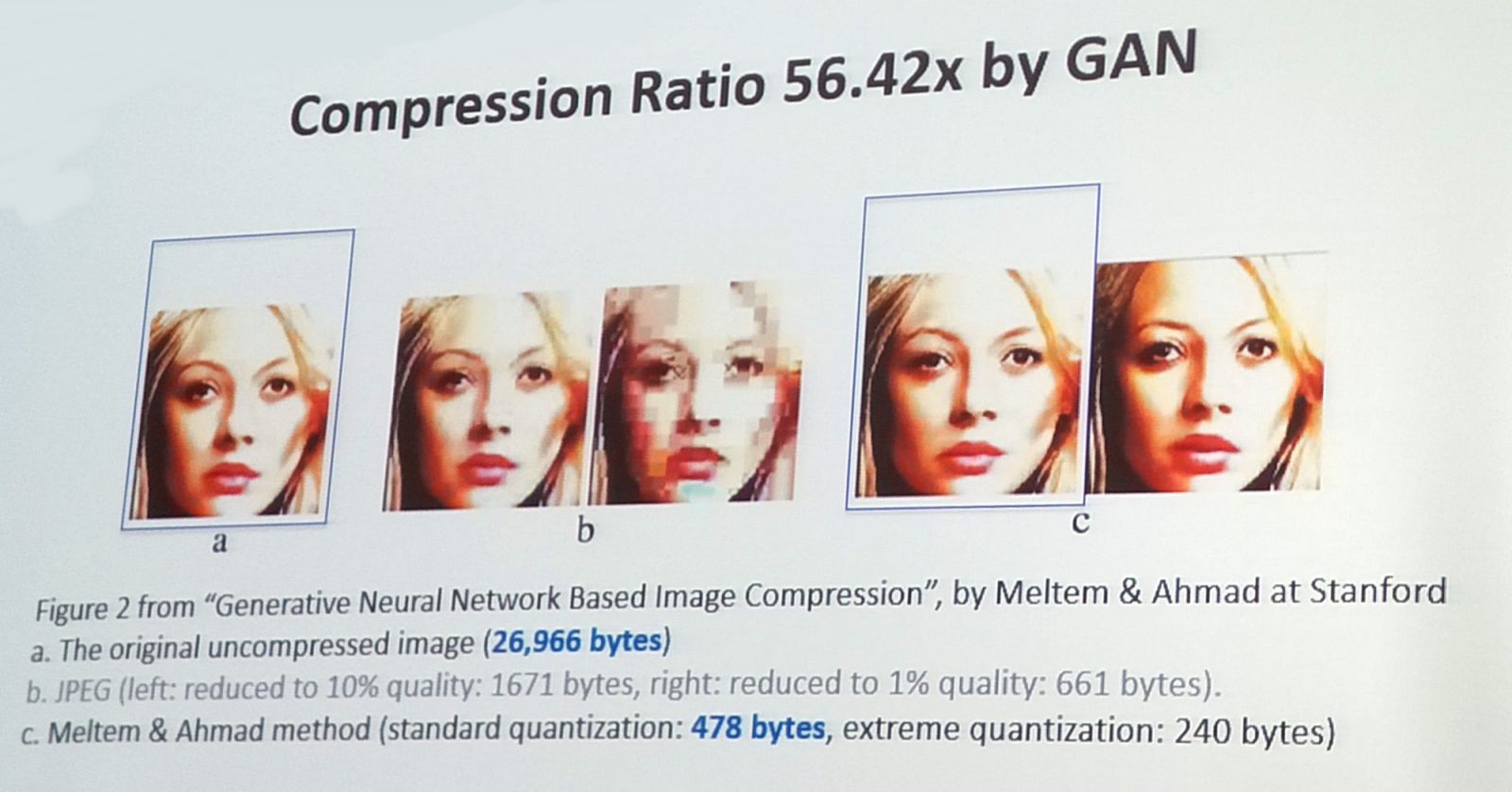

也就是說,用類比運算進行AI分析,不僅可以達到偵測異常畫面來報警的目的,更能減少大量數位資料儲存、傳輸上雲所耗費的頻寬與記憶體空間。根據史丹佛大學Meltem & Ahmad的研究,若一張未壓縮的人臉圖像資料大小有26,966 bytes,儘管壓縮後只剩478 bytes,仍然可以用生成對抗網路還原成幾乎相同的圖像。林功藝以此說明,以壓縮後的影像與特徵值,來重建原始影像的可行性。

史丹佛大學學者Meltem & Ahmad用生成對抗網路,可將478位元的資料還原成足夠清楚的人臉影像。

對此,林功藝也表示,無論用類比或數位資料進行AI分析,擷取特徵值並壓縮影像後,都會有些微失真,但以GAN重建過後,並不會有哪張影像比較精準的問題,因為使用的演算法一樣,而類比運算的優勢,是在於更低的運算功耗與晶片成本。

此外,除了結合監控錄影機,類比AI結合影像辨識的應用還很多。例如,偵測一間教室的人數來決定冷氣溫度,或是人造衛星拍攝的衛星影像,尤其人造衛星數量從1960年代至今已經將近5,000個,一天24小時中,還必需不間斷拍攝高解析度的影像並回傳到地面,每日儲存傳輸的資料量非常龐大,這都是類比AI技術有潛力的市場。

應用類型二:結合自駕車進行影像辨識,來降低有線傳輸造成的判讀延遲

另一個可行的應用,則是自駕車針對路況影像來即時辨識。相較於攝錄影機影像辨識的應用,著重在降低資料儲存、傳輸所佔用的記憶體與頻寬,自駕車的應用,則是要強調能更快速的對路況做出反應,來減少幾百毫秒的延遲。

現今的先進駕駛輔助系統(Advanced Driver Assistance Systems,ADAS),在進行影像辨識的過程,是先透過感應器接收類比資料,並透過ADC轉換為數位訊號,接著由SerDes(序列器)將多路低速並行信號轉換成高速串列信號,通過LVDS高速傳輸後,再透過SerDes(解除序列器)轉換回多路並行訊號,經過數位訊號處理(Digital signal processing)來優化訊號,最後進行影像分析。

然而,對比ADAS以有線傳輸的方式來進行數位AI影像分析,若以邊緣運算來進行影像辨識,以上資料傳輸的過程,都可以用一個內建於感應器的影像辨識晶片來取代,來即時的分析影像資訊並將結果回傳。在邊緣運算中,同樣的,數位AI晶片也能做,但用類比AI晶片,功耗會更低、也更便宜。

第一列,是現今ADAS架構中,將數位資訊回傳至後端運算所需經過的轉換;第二列,則是直接使用內建於感應器中的類比AI晶片執行邊緣運算。

為什麼邊緣運算會更快?除了省去一長串資料傳輸過程所造成的延遲,也因為現今車子串流影像的傳輸限制為30 fps(每秒30影格),在錄影機偵測路況時,至少需要一幀的影像畫面,才能辨識出物體樣態,而物體動作的偵測又更久,尤其是橫向移動的軌跡偵測,究竟該物件是在靠近車子還是遠離車子?最少需要十影格的時間,才足夠自駕車對路況做出判斷。這時,因有線傳輸的限制是每秒30影格,10影格換算之後也就是0.333秒。換句話說,車子需要0.333秒的反應時間,才能決定要減速還是閃避。

以去年3月Uber自駕車撞死橫越馬路的行人車禍為例。當時,一位婦人牽腳踏車橫向穿越馬路,而Uber以55km/hr的速度前進,0.333秒換算之後約為5公尺的距離,也就是說,車子辨識到物體後還會繼續前行5公尺才做出反應,這還不包括中間類比轉數位、以及傳輸的時間,等到車子反應過來,也許已經閃避不及。

若以類比AI晶片結合邊緣運算,使用60、120甚至240fps的攝影機來捕捉畫面,以現在手機的攝影功能就做得到,同樣以10影格來辨識物體移動路徑,能更即時的對路況做出反應,在分秒必爭的駕駛場景中,無疑更有優勢。

應用類型三:結合智慧音箱進行語音辨識,來降低24小時辨識的耗電量

除了影像辨識的應用,林功藝也舉出一個語音辨識的案例,比如現在很流行的語音助理,當用戶喊出「Alexa」、「OK, Google」、「Hey, Siri」等呼叫的起手式,就能啟動語音助理的功能。「但大部分的人都不知道,他整天24小時都再聽你講話,聽到Alexa才開始,平常不聽怎麼醒過來?」

若以數位資訊來語音辨識,辨識前經過的流程,從一句話被麥克風接收,透過ADC轉成數位資訊,接著用DSP優化資訊,最後進行語音辨識,由於每個元件要發揮作用時都需要耗電,換句話說,語音助理必須維持有電的狀況,才能在辨識Alexa的時候即時啟動。這時,用類比運算來做語音辨識,只要消耗一點點的電能,一樣能喚醒語音助理,「他不用有ADC、DSP,類比AI功耗小,耗電量就變很少。」

林功藝表示,神盾的強項是將AI晶片與感測器結合,如溫度計、麥克風、攝影機等,儘管現在除了自家指紋辨識晶片之外,尚未與其他硬體廠商合作推出應用,但近來越來越多車廠有意與神盾合作,未來可能從自駕車或車聯網的應用開始發展。此外,神盾也參與了工研院AI on chip的計畫,自己開發AI類比運算的技術,並由工研院協助研發編譯器(compiler),提供客戶編譯器來訓練AI模型,加速應用的落地。

熱門新聞

2024-05-19

2024-05-20

2024-05-20

2024-05-18

2024-05-20

2024-05-20