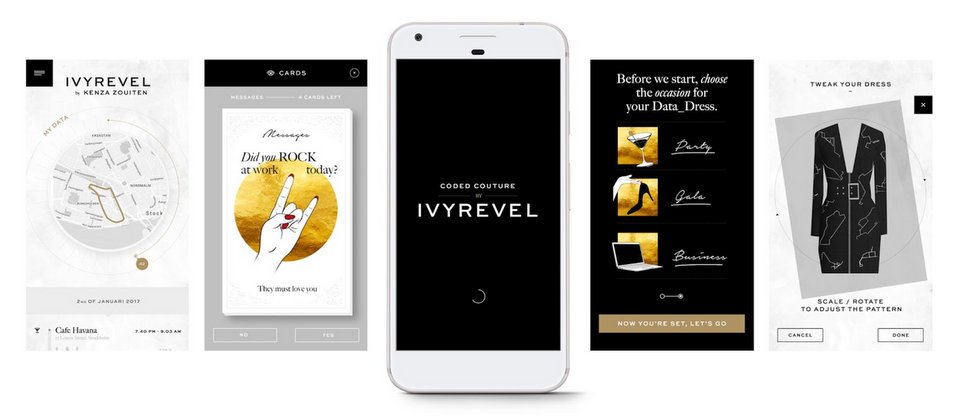

在紐約時裝周,Google探究Android情境感知API(Awareness API)新的整合應用,並於本周一(2/6)宣布,與H&M旗下的數位時尚團隊Ivyrevel及時尚科技實驗室(Fashion Tech Lab)合作打造一款Android行動應用程式Coded Couture,整合時裝與數位科技,透過使用者的情境背景訊號(Context Signal),為用戶量身訂做服裝。

情境感知API由Google於2016年6月正式釋出,提供開發者用來蒐集Android裝置的情境訊號,如時間、位置、地點類型、使用者行為、附近的Beacon、耳機與天氣等資訊,開發者可以更了解Android裝置使用者,並根據這些情境訊號提供相對應的App使用體驗,以增加App的情境感知互動功能,如使用者開始慢跑時,推薦合適的音樂清單。

而Google與H&M聯手研發的Coded Couture,正是情境感知API的延伸應用,這款行動App採用了快照API(Snapshot API),在使用者許可的情況下,被動地蒐集使用者日常活動和生活方式等資料,例如,用戶經常用餐的餐廳、和朋友逛街的地方、經常參與休閒或正式的聚會、天氣等。這些資料就是使用者的情境訊號,並會在用戶活動一周後經由Coded Couture的演算法,來為用戶量身打造數位時裝設計,用戶也可以購買該服裝。

(圖片來源/Google)

根據Google,目前Coded Couture仍在封閉Alpha階段,還在開發中,並正在由選定的全球時裝風格影響人物進行測試,包括了Ivyrevel共同創辦人Kenza Zouiten。

Coded Couture行動App介紹影片:

熱門新聞

2025-12-02

2025-12-01

2025-11-30

2025-12-01

2025-12-01