Spark2.0版本則將進一步提供涵蓋完整階段的程式碼產生器,不僅能移除遞迴式呼叫,減少效能損耗,還能進行跨運算子之間的整合,並藉由Parquet及內建快取(Built-in Cache)來優化I/O效能。

Databricks

大資料技術Spark今年1月才剛釋出1.6版,下一個2.0版本就已經蓄勢待發,預計今年4、5月釋出,近日Spark創辦人、同時也是Databricks技術長的Matei Zaharia,更在2016 Spark Summit上,搶先揭露了Spark 2.0即將帶來的3大主要特色:包括能大幅提升Spark平臺效能的Project Tungsten即將進入第二階段,提供涵蓋完整階段的程式碼產生器,Spark 2.0也將提供可運行在SQL/Dataframe上的結構化串流即時引擎,並統一化Dataset及DataFrame。

其中,持續改善Spark應用程式的記憶體及CPU效能的Project Tungsten,是一項幫助Spark大幅提升核心引擎效能的長期專案,目的是要讓Spark執行效能達到硬體設備的極限,藉由內建原生記憶體管理機制以及Runtime層級的程式碼產生器,來達到接近裸機的效能。

Spark從1.4到1.6版本時,便開始靠 Tungsten來優化Spark的資料處理效能,除了加入二進位的儲存方式,以及基礎的程式碼產生器,也增加了用來描述RDD結構的DataFrame格式,以及新的資料集API(Dataset API),讓Tungsten可被運行在使用者專案中來提升效能表現,也可用於Spark SQL及部分的MLlib上。Spark 1.6新增了基於DataFrame的擴充元件Dataset API,相較於過去的RDD API,Dataset提供更好的記憶體管理效能,及較佳的長時間執行效能。

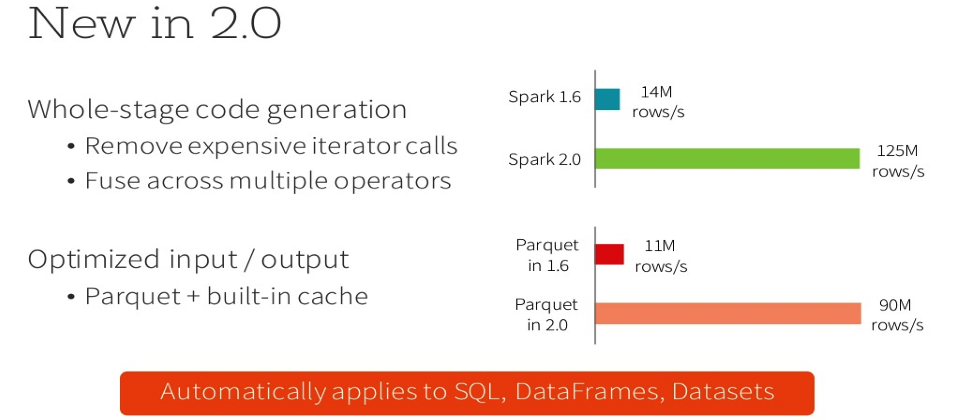

而Spark2.0版本則將進一步提供涵蓋完整階段的程式碼產生器,不僅能移除遞迴式呼叫,減少效能損耗,還能進行跨運算子之間的整合,並藉由Parquet及內建快取(Built-in Cache)來優化I/O效能。

預計Spark2.0的效能將翻9倍,從1.6版時每秒可處理的1,400萬個欄位,暴增到1億2,500萬,其中的Parquet效能,也將從每秒1,100萬提升到每秒9,000萬筆。Databricks表示,Spark技術在2015年有非常顯著的成長,其貢獻者在2015年已經超過1000人,是2014年的2倍,參與各地區定期聚會的會員數量也從1萬多人暴增至6萬多人。而Spark 2.0將是下一個重大更新版本,預計今年4、5月釋出。

熱門新聞

2026-01-12

2026-01-12

2026-01-12

2026-01-12

2026-01-12